Welle-Teilchen-Dualismus

| Teil einer Serie von Artikeln über ⓘ |

| Quantenmechanik |

|---|

|

Der Welle-Teilchen-Dualismus ist das Konzept in der Quantenmechanik, dass jedes Teilchen oder Quantenobjekt entweder als Teilchen oder als Welle beschrieben werden kann. Er drückt die Unfähigkeit der klassischen Begriffe "Teilchen" oder "Welle" aus, das Verhalten von Objekten im Quantenbereich vollständig zu beschreiben. Wie Albert Einstein schrieb:

Es scheint, als ob wir manchmal die eine und manchmal die andere Theorie verwenden müssen, während wir manchmal beide verwenden können. Wir stehen vor einer neuen Art von Schwierigkeit. Wir haben zwei widersprüchliche Bilder von der Realität, die beide für sich genommen die Phänomene des Lichts nicht vollständig erklären, aber zusammen schon. ⓘ

Dank der Arbeiten von Max Planck, Albert Einstein, Louis de Broglie, Arthur Compton, Niels Bohr, Erwin Schrödinger und vielen anderen geht die heutige wissenschaftliche Theorie davon aus, dass alle Teilchen eine Wellennatur aufweisen und umgekehrt. Dieses Phänomen ist nicht nur für Elementarteilchen, sondern auch für zusammengesetzte Teilchen wie Atome und sogar Moleküle nachgewiesen worden. Bei makroskopischen Teilchen können Welleneigenschaften aufgrund ihrer extrem kurzen Wellenlängen normalerweise nicht nachgewiesen werden. ⓘ

Obwohl sich die Anwendung des Welle-Teilchen-Dualismus in der Physik bewährt hat, ist die Bedeutung oder Interpretation nicht zufriedenstellend geklärt worden; siehe Interpretationen der Quantenmechanik. ⓘ

Bohr betrachtete das "Dualitätsparadoxon" als eine grundlegende oder metaphysische Tatsache der Natur. Eine bestimmte Art von Quantenobjekt weist in unterschiedlichen physikalischen Umgebungen manchmal Wellen- und manchmal Teilchencharakter auf. Er betrachtete diese Dualität als einen Aspekt des Konzepts der Komplementarität. Bohr betrachtete den Verzicht auf die Ursache-Wirkungs-Beziehung oder die Komplementarität des Raum-Zeit-Bildes als wesentlich für die quantenmechanische Darstellung. ⓘ

Werner Heisenberg betrachtete die Frage weiter. Er sah die Dualität als für alle Quantenentitäten vorhanden an, aber nicht ganz in der üblichen quantenmechanischen Darstellung, die Bohr in Betracht zog. Er sah sie in der so genannten zweiten Quantisierung, die ein völlig neues Konzept von Feldern erzeugt, die in der gewöhnlichen Raumzeit existieren, wobei die Kausalität weiterhin sichtbar ist. Klassische Feldwerte (z. B. die elektrischen und magnetischen Feldstärken von Maxwell) werden durch eine völlig neue Art von Feldwerten ersetzt, wie sie in der Quantenfeldtheorie betrachtet werden. Im Umkehrschluss lässt sich die gewöhnliche Quantenmechanik als spezielle Folge der Quantenfeldtheorie herleiten. ⓘ

Die Frage, ob Elektronen oder Lichtquanten Teilchen oder Wellen seien, lässt sich nicht beantworten. Sie sind vielmehr Quantenobjekte, die je nach der Art der Messung, die man an ihnen durchführt, unterschiedliche Eigenschaften in Erscheinung treten lassen. Dieses Problem wurde in der Quantenmechanik in der Kopenhagener Deutung (1927) mit dem dort formulierten Komplementaritätsprinzip zunächst dahingehend gelöst, dass die Festlegung der jeweils beobachteten Eigenschaft nicht allein dem Quantenobjekt zuzuordnen sei, sondern ein Phänomen der gesamten Anordnung aus Quantenobjekt und Messapparatur darstelle. Später entstanden eine Reihe weiterer Interpretationen der Quantenmechanik mit alternativen Erklärungsansätzen. ⓘ

In der Alltagswelt taucht der Welle-Teilchen-Dualismus nicht auf, weil die Wellenlänge der Materiewelle bei makroskopischen Körpern um vieles zu klein ist, um Phänomene hervorzurufen, die eindeutig nur mit wellenartigem Verhalten zu erklären sind. Bei sehr kleinen Wellenlängen stimmen Wellenbild und Teilchenbild nämlich trotz der verschiedenen Ansätze in ihren beobachtbaren Konsequenzen überein, wie aus dem Verhältnis von Strahlenoptik und Wellenoptik schon früher bekannt war. Andererseits ist der Welle-Teilchen-Dualismus keineswegs auf die kleinsten Quantenobjekte beschränkt. Er wurde im Experiment auch schon für große Moleküle aus über 800 Atomen nachgewiesen. ⓘ

Die Quantenfeldtheorie versteht sowohl Teilchen als auch Wechselwirkungen als diskrete Anregungen von Feldern. Damit gibt es auf der formalen Ebene keinen Unterschied zwischen diesen beiden Kategorien. Für die Anschauung allerdings bleibt das Problem, dass die zwei gegensätzlichen Bilder hier beide gelten. ⓘ

Geschichte

Klassische Teilchen- und Wellentheorien des Lichts

Demokrit (5. Jh. v. Chr.) argumentierte, dass alle Dinge im Universum, einschließlich des Lichts, aus unteilbaren Teilkomponenten bestehen. Euklid (4.-3. Jh. v. Chr.) gibt Abhandlungen über die Ausbreitung des Lichts, nennt das Prinzip der kürzesten Flugbahn des Lichts, einschließlich der mehrfachen Reflexion an Spiegeln, auch an sphärischen, während Plutarch (1.-2. Jh. n. Chr.) die mehrfache Reflexion an sphärischen Spiegeln beschreibt und die Erzeugung größerer oder kleinerer Bilder, real oder imaginär, einschließlich des Falles der Chiralität der Bilder, diskutiert. Zu Beginn des 11. Jahrhunderts schrieb der arabische Wissenschaftler Ibn al-Haytham das erste umfassende Buch der Optik, in dem er Reflexion, Brechung und die Funktionsweise einer Lochlinse anhand von Lichtstrahlen beschrieb, die vom Emissionspunkt zum Auge wandern. Er behauptete, dass diese Strahlen aus Lichtteilchen bestehen. 1630 machte René Descartes die gegensätzliche Wellenbeschreibung in seiner Abhandlung über das Licht, Die Welt, populär, indem er zeigte, dass das Verhalten des Lichts durch die Modellierung wellenförmiger Störungen in einem universellen Medium, dem leuchtenden Äther, nachgebildet werden kann. Ab 1670 und über drei Jahrzehnte hinweg entwickelte und vertrat Isaac Newton seine Korpuskular-Theorie, in der er argumentierte, dass die vollkommen geraden Reflexionslinien die Teilchennatur des Lichts beweisen, da sich nur Teilchen in solch geraden Linien bewegen können. Er erklärte die Brechung damit, dass Lichtteilchen beim Eintritt in ein dichteres Medium seitlich beschleunigt werden. Etwa zur gleichen Zeit verfeinerten Newtons Zeitgenossen Robert Hooke und Christiaan Huygens und später Augustin-Jean Fresnel die Wellenbetrachtung mathematisch und zeigten, dass die Brechung des Lichts, wenn es sich in verschiedenen Medien unterschiedlich schnell ausbreitet, leicht durch die medienabhängige Ausbreitung von Lichtwellen erklärt werden kann. Das daraus resultierende Huygens-Fresnel-Prinzip war äußerst erfolgreich bei der Beschreibung des Verhaltens von Licht und wurde später durch Thomas Youngs Entdeckung der Welleninterferenz von Licht durch sein Doppelspaltexperiment im Jahr 1801 unterstützt. Die Wellenbetrachtung verdrängte die Strahlen- und Teilchenbetrachtung nicht sofort, begann aber Mitte des 19. Jahrhunderts das wissenschaftliche Denken über Licht zu dominieren, da sie Polarisationsphänomene erklären konnte, die die Alternativen nicht erklären konnten. ⓘ

James Clerk Maxwell entdeckte, dass er seine zuvor entdeckten Maxwell-Gleichungen mit einer leichten Modifikation anwenden konnte, um sich selbst ausbreitende Wellen von oszillierenden elektrischen und magnetischen Feldern zu beschreiben. Schnell wurde klar, dass es sich bei sichtbarem Licht, ultraviolettem Licht und infrarotem Licht um elektromagnetische Wellen mit unterschiedlicher Frequenz handelt. ⓘ

Animation, die den Welle-Teilchen-Dualismus mit einem Doppelspaltexperiment und dem Einfluss eines Beobachters zeigt. Erhöhen Sie die Größe, um die Erklärungen im Video selbst zu sehen. Siehe auch ein Quiz, das auf dieser Animation basiert.

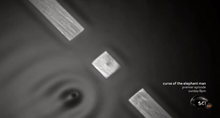

Interferenz eines Quantenteilchens mit sich selbst. ⓘ

Schwarze-Körper-Strahlung und das Plancksche Gesetz

1901 veröffentlichte Max Planck eine Analyse, mit der es gelang, das beobachtete Spektrum des von einem leuchtenden Objekt ausgesandten Lichts zu reproduzieren. Um dies zu erreichen, musste Planck die mathematische Annahme einer gequantelten Energie der Oszillatoren, d. h. der Atome des schwarzen Körpers, die die Strahlung aussenden, machen. Einstein schlug später vor, dass die elektromagnetische Strahlung selbst gequantelt ist, nicht aber die Energie der strahlenden Atome. ⓘ

Die Strahlung des schwarzen Körpers, also die Emission elektromagnetischer Energie aufgrund der Wärme eines Objekts, konnte nicht allein mit klassischen Argumenten erklärt werden. Der Äquipartitionssatz der klassischen Mechanik, die Grundlage aller klassischen thermodynamischen Theorien, besagt, dass die Energie eines Objekts gleichmäßig auf die Schwingungsmoden des Objekts aufgeteilt ist. Aber die Anwendung derselben Überlegungen auf die elektromagnetische Emission eines solchen thermischen Objekts war nicht so erfolgreich. Dass thermische Objekte Licht emittieren, war schon lange bekannt. Da man wusste, dass Licht Wellen des Elektromagnetismus sind, hofften die Physiker, diese Emission mit klassischen Gesetzen beschreiben zu können. Dies wurde als das Problem des schwarzen Körpers bekannt. Da das Äquipartitionstheorem bei der Beschreibung der Schwingungsmoden des thermischen Objekts selbst so gut funktionierte, lag die Annahme nahe, dass es bei der Beschreibung der Strahlungsemission solcher Objekte ebenso gut funktionieren würde. Es ergab sich jedoch schnell ein Problem: Wenn jede Schwingungsform die gleiche Energie erhält, würden die kurzwelligen Schwingungsformen die gesamte Energie verbrauchen. Dies wurde deutlich, als man das Rayleigh-Jeans-Gesetz aufstellte, das zwar die Intensität langwelliger Emissionen korrekt vorhersagte, aber für kurze Wellenlängen eine unendliche Gesamtenergie voraussagte, da die Intensität ins Unendliche divergiert. Dies wurde als Ultraviolett-Katastrophe bekannt. ⓘ

Im Jahr 1900 stellte Max Planck die Hypothese auf, dass die Frequenz des von einem schwarzen Körper ausgestrahlten Lichts von der Frequenz des Oszillators abhängt, der es aussendet, und dass die Energie dieser Oszillatoren linear mit der Frequenz zunimmt (gemäß E = hf, wobei h die Plancksche Konstante und f die Frequenz ist). Dies war kein unvernünftiger Vorschlag, wenn man bedenkt, dass makroskopische Oszillatoren ähnlich funktionieren, wenn man fünf einfache harmonische Oszillatoren mit gleicher Amplitude, aber unterschiedlicher Frequenz untersucht, besitzt der Oszillator mit der höchsten Frequenz die höchste Energie (obwohl diese Beziehung nicht linear ist wie die von Planck). Indem er verlangte, dass hochfrequentes Licht von einem Oszillator gleicher Frequenz ausgesandt werden muss, und weiter verlangte, dass dieser Oszillator eine höhere Energie besitzt als ein Oszillator mit einer geringeren Frequenz, vermied Planck eine Katastrophe, denn eine gleiche Aufteilung der hochfrequenten Oszillatoren führte zu immer weniger Oszillatoren und weniger ausgesandtem Licht. Und wie bei der Maxwell-Boltzmann-Verteilung wurden die niederfrequenten, niederenergetischen Oszillatoren durch den Ansturm des thermischen Rüttelns der höherenergetischen Oszillatoren unterdrückt, was zwangsläufig ihre Energie und Frequenz erhöhte. ⓘ

Der revolutionärste Aspekt von Plancks Behandlung des Schwarzen Körpers besteht darin, dass er von einer ganzzahligen Anzahl von Oszillatoren ausgeht, die sich im thermischen Gleichgewicht mit dem elektromagnetischen Feld befinden. Diese Oszillatoren geben ihre gesamte Energie an das elektromagnetische Feld ab, indem sie ein Lichtquant erzeugen, und zwar so oft, wie sie durch das elektromagnetische Feld angeregt werden, wobei sie ein Lichtquant absorbieren und mit der entsprechenden Frequenz zu schwingen beginnen. Planck hatte absichtlich eine Atomtheorie des schwarzen Körpers geschaffen, aber unbeabsichtigt eine Atomtheorie des Lichts erzeugt, bei der der schwarze Körper niemals Lichtquanten mit einer Energie von weniger als hf bei einer bestimmten Frequenz erzeugt. Als er jedoch feststellte, dass er das elektromagnetische Feld quantisiert hatte, bezeichnete er die Lichtteilchen als eine Einschränkung seiner Annäherung und nicht als eine Eigenschaft der Realität. ⓘ

Photoelektrischer Effekt

Obwohl Planck die ultraviolette Katastrophe mit Hilfe von Atomen und einem gequantelten elektromagnetischen Feld gelöst hatte, waren sich die meisten zeitgenössischen Physiker einig, dass Plancks "Lichtquanten" nur Mängel in seinem Modell darstellten. Eine vollständigere Herleitung der Schwarzkörperstrahlung würde ein vollständig kontinuierliches und "wellenförmiges" elektromagnetisches Feld ohne Quantisierung ergeben. Im Jahr 1905 nutzte Albert Einstein jedoch Plancks Modell des schwarzen Körpers, um seine Lösung für ein anderes herausragendes Problem der damaligen Zeit zu finden: den photoelektrischen Effekt, bei dem Elektronen aus Atomen emittiert werden, wenn sie Energie aus Licht aufnehmen. Seit ihre Existenz acht Jahre zuvor theoretisiert worden war, wurden die Phänomene in Physiklabors auf der ganzen Welt mit dem Elektronenmodell im Hinterkopf untersucht. ⓘ

Im Jahr 1902 entdeckte Philipp Lenard, dass die Energie dieser ausgestoßenen Elektronen nicht von der Intensität des einfallenden Lichts abhängt, sondern von dessen Frequenz. Wenn man also ein Metall mit wenig niederfrequentem Licht bestrahlt, werden ein paar niederenergetische Elektronen herausgeschleudert. Strahlt man nun ein sehr intensives niederfrequentes Licht auf dasselbe Metall, so werden eine ganze Reihe von Elektronen herausgeschleudert, die allerdings die gleiche niedrige Energie besitzen, es sind nur mehr. Je mehr Licht vorhanden ist, desto mehr Elektronen werden herausgeschleudert. Um hingegen hochenergetische Elektronen zu erhalten, muss man das Metall mit hochfrequentem Licht beleuchten. Wie die Schwarzkörperstrahlung widersprach dies einer Theorie, die von einem kontinuierlichen Energietransfer zwischen Strahlung und Materie ausging. Es kann jedoch auch mit einer vollständig klassischen Beschreibung des Lichts erklärt werden, solange die Materie quantenmechanischer Natur ist. ⓘ

Würde man die Planckschen Energiequanten verwenden und verlangen, dass elektromagnetische Strahlung bei einer bestimmten Frequenz nur in ganzzahligen Vielfachen eines Energiequants hf Energie auf Materie übertragen kann, dann ließe sich der photoelektrische Effekt sehr einfach erklären. Niederfrequentes Licht stößt nur niederenergetische Elektronen aus, da jedes Elektron durch die Absorption eines einzigen Photons angeregt wird. Erhöht man die Intensität des niederfrequenten Lichts (d. h. die Anzahl der Photonen), erhöht sich nur die Anzahl der angeregten Elektronen, nicht aber ihre Energie, da die Energie jedes einzelnen Photons niedrig bleibt. Nur wenn man die Frequenz des Lichts und damit die Energie der Photonen erhöht, kann man Elektronen mit höherer Energie ausstoßen. Wenn man also die Plancksche Konstante h verwendet, um die Energie der Photonen auf der Grundlage ihrer Frequenz zu bestimmen, sollte die Energie der ausgestoßenen Elektronen ebenfalls linear mit der Frequenz zunehmen, wobei die Steigung der Linie die Plancksche Konstante ist. Diese Ergebnisse wurden erst 1915 bestätigt, als Robert Andrews Millikan experimentelle Ergebnisse vorlegte, die perfekt mit Einsteins Vorhersagen übereinstimmten. ⓘ

Während die Energie der ausgestoßenen Elektronen die Plancksche Konstante widerspiegelte, wurde die Existenz von Photonen erst mit der Entdeckung des Photonen-Antibündelungseffekts ausdrücklich nachgewiesen. Dieser bezieht sich auf die Beobachtung, dass ein einzelner Emitter (ein Atom, ein Molekül, ein Festkörperstrahler usw.), sobald er ein nachweisbares Lichtsignal ausstrahlt, nicht sofort ein zweites Signal freisetzen kann, bis der Emitter erneut angeregt wurde. Dies führt zu einer statistisch quantifizierbaren Zeitverzögerung zwischen den Lichtemissionen, so dass die Erkennung mehrerer Signale immer unwahrscheinlicher wird, je mehr die Beobachtungszeit unter die Lebensdauer des angeregten Strahlers sinkt. Der Effekt lässt sich in einem Labor für Studenten nachweisen. ⓘ

Dieses Phänomen konnte nur durch Photonen erklärt werden. Einsteins "Lichtquanten" wurden erst 1925 als Photonen bezeichnet, aber schon 1905 waren sie das Paradebeispiel für den Welle-Teilchen-Dualismus. Elektromagnetische Strahlung breitet sich gemäß der linearen Wellengleichung aus, kann aber nur als diskrete Elemente emittiert oder absorbiert werden und wirkt somit gleichzeitig als Welle und Teilchen. ⓘ

Einsteins Erklärung des photoelektrischen Effekts

1905 lieferte Albert Einstein eine Erklärung für den photoelektrischen Effekt, ein Experiment, das mit der Wellentheorie des Lichts nicht erklärt werden konnte. Dazu postulierte er die Existenz von Photonen, Quanten von Lichtenergie mit Teilcheneigenschaften. ⓘ

Beim photoelektrischen Effekt wurde beobachtet, dass die Bestrahlung bestimmter Metalle mit Licht zu einem elektrischen Strom in einem Stromkreis führte. Vermutlich schlug das Licht Elektronen aus dem Metall heraus, so dass Strom floss. Am Beispiel von Kalium wurde jedoch auch beobachtet, dass ein schwaches blaues Licht ausreichte, um einen Strom zu erzeugen, während selbst das stärkste und hellste rote Licht, das mit der damaligen Technologie möglich war, überhaupt keinen Strom verursachte. Nach der klassischen Theorie von Licht und Materie stand die Stärke oder Amplitude einer Lichtwelle im Verhältnis zu ihrer Helligkeit: Ein helles Licht hätte ohne weiteres stark genug sein müssen, um einen großen Strom zu erzeugen. Doch seltsamerweise war dies nicht der Fall. ⓘ

Einstein erklärte dieses Rätsel, indem er postulierte, dass Elektronen Energie aus einem elektromagnetischen Feld nur in diskreten Einheiten (Quanten oder Photonen) aufnehmen können: eine Energiemenge E, die mit der Frequenz f des Lichts in folgender Beziehung steht ⓘ

wobei h die Plancksche Konstante ist (6,626 × 10-34 Js). Nur Photonen mit einer ausreichend hohen Frequenz (oberhalb eines bestimmten Schwellenwerts) können ein Elektron freisetzen. So hatten beispielsweise Photonen von blauem Licht genügend Energie, um ein Elektron aus dem Metall zu lösen, Photonen von rotem Licht jedoch nicht. Ein Lichtphoton oberhalb der Schwellenfrequenz konnte nur ein Elektron freisetzen; je höher die Frequenz eines Photons, desto höher die kinetische Energie des emittierten Elektrons, aber keine Lichtmenge unterhalb der Schwellenfrequenz konnte ein Elektron freisetzen. Um dieses Gesetz zu verletzen, wären Laser mit extrem hoher Intensität erforderlich, die noch nicht erfunden worden waren. Mit solchen Lasern wurden die intensitätsabhängigen Phänomene nun eingehend untersucht. ⓘ

Einstein erhielt 1921 den Nobelpreis für Physik für seine Entdeckung des Gesetzes des photoelektrischen Effekts. ⓘ

Die de Broglie-Hypothese

1924 formulierte Louis-Victor de Broglie die de-Broglie-Hypothese, die besagt, dass alle Materie wellenförmig ist, und setzte Wellenlänge und Impuls in Beziehung:

Dies ist eine Verallgemeinerung der obigen Einsteinschen Gleichung, da der Impuls eines Photons durch p = und die Wellenlänge (in einem Vakuum) durch λ = gegeben ist, wobei c die Lichtgeschwindigkeit im Vakuum ist. ⓘ

De Broglies Formel wurde drei Jahre später durch die Beobachtung der Elektronenbeugung in zwei unabhängigen Experimenten für Elektronen bestätigt. An der Universität von Aberdeen ließ George Paget Thomson einen Elektronenstrahl durch einen dünnen Metallfilm laufen und beobachtete die vorhergesagten Interferenzmuster. In den Bell Labs leiteten Clinton Joseph Davisson und Lester Halbert Germer den Elektronenstrahl durch ein kristallines Gitter in ihrem Experiment, das als Davisson-Germer-Experiment bekannt ist. ⓘ

De Broglie wurde 1929 für seine Hypothese mit dem Nobelpreis für Physik ausgezeichnet. Thomson und Davisson teilten sich 1937 den Nobelpreis für Physik für ihre experimentellen Arbeiten. ⓘ

Heisenbergs Unschärferelation

In seiner Arbeit zur Formulierung der Quantenmechanik postulierte Werner Heisenberg seine Unschärferelation, die besagt:

wobei

- hier für die Standardabweichung steht, ein Maß für die Streuung oder Unsicherheit;

- x und p sind die Position bzw. der lineare Impuls eines Teilchens.

- ist die reduzierte Plancksche Konstante (Plancksche Konstante geteilt durch 2). ⓘ

Heisenberg erklärte dies ursprünglich als eine Folge des Messvorgangs: Die genaue Messung der Position würde den Impuls stören und umgekehrt, und er brachte ein Beispiel (das "Gammastrahlenmikroskop"), das entscheidend von der de Broglie-Hypothese abhing. Heute geht man jedoch davon aus, dass diese Hypothese das Phänomen nur teilweise erklärt, sondern dass die Ungewissheit auch im Teilchen selbst vorhanden ist, noch bevor die Messung durchgeführt wird. ⓘ

Die moderne Erklärung der Unschärferelation, die die von Bohr und Heisenberg erstmals vorgestellte Kopenhagener Deutung erweitert, geht sogar noch stärker von der Wellennatur eines Teilchens aus. Genauso wie es unsinnig ist, über die genaue Position einer Welle auf einem Faden zu diskutieren, haben Teilchen keine perfekt präzisen Positionen; genauso wie es unsinnig ist, über die Wellenlänge einer "Impuls"-Welle zu diskutieren, die sich auf einem Faden ausbreitet, haben Teilchen keine perfekt präzisen Momente, die dem Kehrwert der Wellenlänge entsprechen. Wenn die Position relativ gut definiert ist, ist die Welle pulsartig und hat eine sehr schlecht definierte Wellenlänge und damit einen Impuls. Und umgekehrt, wenn der Impuls und damit die Wellenlänge relativ gut definiert ist, sieht die Welle lang und sinusförmig aus und hat daher eine sehr schlecht definierte Position. ⓘ

de Broglie-Bohm-Theorie

De Broglie selbst hatte ein Pilotwellen-Konstrukt vorgeschlagen, um den beobachteten Welle-Teilchen-Dualismus zu erklären. In dieser Sichtweise hat jedes Teilchen eine wohldefinierte Position und einen Impuls, wird aber von einer aus der Schrödinger-Gleichung abgeleiteten Wellenfunktion geleitet. Die Pilotwellentheorie wurde zunächst abgelehnt, weil sie bei der Anwendung auf Systeme mit mehr als einem Teilchen nichtlokale Effekte erzeugte. Die Nichtlokalität setzte sich jedoch bald als integraler Bestandteil der Quantentheorie durch, und David Bohm erweiterte de Broglies Modell, um sie ausdrücklich einzubeziehen. ⓘ

In der daraus resultierenden Darstellung, die auch als de Broglie-Bohm-Theorie oder Bohmsche Mechanik bezeichnet wird, verschwindet der Welle-Teilchen-Dualismus und erklärt das Wellenverhalten als Streuung mit Wellenerscheinung, da die Bewegung des Teilchens einer Leitgleichung oder einem Quantenpotential unterliegt.

Diese Idee erscheint mir so natürlich und einfach, um das Welle-Teilchen-Dilemma auf so klare und einfache Weise zu lösen, dass es mir ein großes Rätsel ist, dass sie so allgemein ignoriert wurde. - J.S.Bell ⓘ

Die beste Veranschaulichung des Pilotwellenmodells lieferte Couder 2010 mit seinen Experimenten zu "wandelnden Tröpfchen", die das Pilotwellenverhalten in einem makroskopischen mechanischen Analogon demonstrierten. ⓘ

Wellencharakter von großen Objekten

Seit dem Nachweis der wellenartigen Eigenschaften von Photonen und Elektronen wurden ähnliche Experimente mit Neutronen und Protonen durchgeführt. Zu den berühmtesten Experimenten gehören die von Estermann und Otto Stern im Jahr 1929. Die Autoren ähnlicher neuerer Experimente mit Atomen und Molekülen, die im Folgenden beschrieben werden, behaupten, dass sich auch diese größeren Teilchen wie Wellen verhalten. ⓘ

Eine dramatische Reihe von Experimenten, die die Wirkung der Schwerkraft im Zusammenhang mit dem Welle-Teilchen-Dualismus hervorheben, wurde in den 1970er Jahren mit dem Neutronen-Interferometer durchgeführt. Neutronen, einer der Bestandteile des Atomkerns, machen einen Großteil der Masse eines Atomkerns und damit der gewöhnlichen Materie aus. Im Neutroneninterferometer wirken sie als quantenmechanische Wellen, die direkt der Schwerkraft unterliegen. Die Ergebnisse waren zwar nicht überraschend, da bekannt war, dass die Schwerkraft auf alles einwirkt, auch auf Licht (siehe Tests der allgemeinen Relativitätstheorie und das Pound-Rebka-Experiment mit fallenden Photonen), aber die Selbstinterferenz der quantenmechanischen Welle eines massiven Fermions in einem Gravitationsfeld war zuvor noch nie experimentell bestätigt worden. ⓘ

Im Jahr 1999 wurde die Beugung von C60-Fullerenen durch Forscher der Universität Wien gemeldet. Fullerene sind vergleichsweise große und massive Objekte mit einer Atommasse von etwa 720 u. Die de Broglie-Wellenlänge des einfallenden Strahls betrug etwa 2,5 pm, während der Durchmesser des Moleküls etwa 1 nm beträgt, also etwa 400 Mal größer ist. Im Jahr 2012 konnten diese Fernfeldbeugungsexperimente auf Phthalocyanin-Moleküle und ihre schwereren Derivate ausgeweitet werden, die aus 58 bzw. 114 Atomen bestehen. In diesen Experimenten konnte der Aufbau solcher Interferenzmuster in Echtzeit und mit Einzelmolekülempfindlichkeit aufgezeichnet werden. ⓘ

Im Jahr 2003 wies die Wiener Gruppe auch die Wellennatur von Tetraphenylporphyrin nach - einem flachen Biokörper mit einer Ausdehnung von etwa 2 nm und einer Masse von 614 u. Für diese Demonstration verwendeten sie ein Nahfeld-Talbot-Lau-Interferometer. In demselben Interferometer fanden sie auch Interferenzstreifen für C60F48, einen fluorierten Buckyball mit einer Masse von etwa 1600 u, der aus 108 Atomen besteht. Große Moleküle sind bereits so komplex, dass sie einen experimentellen Zugang zu einigen Aspekten der quantenklassischen Schnittstelle, d. h. zu bestimmten Dekohärenzmechanismen, ermöglichen. Im Jahr 2011 konnte die Interferenz von Molekülen mit einem Gewicht von 6910 u in einem Kapitza-Dirac-Talbot-Lau-Interferometer nachgewiesen werden. Im Jahr 2013 wurde die Interferenz von Molekülen jenseits von 10.000 u nachgewiesen. ⓘ

Ob Objekte, die schwerer sind als die Planck-Masse (etwa das Gewicht eines großen Bakteriums), eine de Broglie-Wellenlänge haben, ist theoretisch unklar und experimentell unerreichbar; oberhalb der Planck-Masse wäre die Compton-Wellenlänge eines Teilchens kleiner als die Planck-Länge und sein eigener Schwarzschild-Radius, eine Größenordnung, bei der die derzeitigen physikalischen Theorien möglicherweise zusammenbrechen oder durch allgemeinere Theorien ersetzt werden müssen. ⓘ

Couder, Fort, et al. zeigten, dass makroskopische Öltröpfchen auf einem vibrierenden Flüssigkeitsbad als analoges Modell für den Welle-Teilchen-Dualismus verwendet werden können; ein lokalisiertes Tröpfchen erzeugt ein periodisches Wellenfeld um sich herum. Die resonante Wechselwirkung zwischen dem Tröpfchen und seinem eigenen Wellenfeld zeigt ein Verhalten, das dem von Quantenteilchen entspricht: Interferenz im Doppelspaltexperiment, unvorhersehbares Tunneln (das in komplizierter Weise vom praktisch verborgenen Zustand des Feldes abhängt), Quantisierung auf der Umlaufbahn (das Teilchen muss mit den von ihm erzeugten Feldstörungen eine "Resonanz" finden - nach einer Umlaufbahn muss seine innere Phase zum Ausgangszustand zurückkehren) und Zeeman-Effekt. Andere Einzel- und Doppelspaltexperimente haben gezeigt, dass eher Wand-Tropfen-Wechselwirkungen als Beugung oder Interferenz der Pilotwelle für die beobachteten hydrodynamischen Muster verantwortlich sein können, die sich von den spaltinduzierten Interferenzmustern der Quantenteilchen unterscheiden. ⓘ

Bedeutung

Der Welle-Teilchen-Dualismus ist tief in die Grundlagen der Quantenmechanik eingebettet. Im Formalismus der Theorie ist die gesamte Information über ein Teilchen in seiner Wellenfunktion kodiert, einer komplexwertigen Funktion, die in etwa der Amplitude einer Welle an jedem Punkt im Raum entspricht. Diese Funktion entwickelt sich gemäß der Schrödinger-Gleichung. Für Teilchen mit Masse hat diese Gleichung Lösungen, die der Form der Wellengleichung folgen. Die Ausbreitung solcher Wellen führt zu wellenartigen Phänomenen wie Interferenz und Beugung. Teilchen ohne Masse, wie Photonen, haben keine Lösungen der Schrödingergleichung. Anstelle einer Teilchenwellenfunktion, die Masse im Raum lokalisiert, kann eine Photonenwellenfunktion aus der Einstein-Kinematik konstruiert werden, um Energie in Raumkoordinaten zu lokalisieren. ⓘ

Das teilchenähnliche Verhalten wird am deutlichsten durch Phänomene im Zusammenhang mit der Messung in der Quantenmechanik. Wenn man den Ort des Teilchens misst, wird das Teilchen in einen stärker lokalisierten Zustand gezwungen, wie es die Unschärferelation vorgibt. Betrachtet man diesen Formalismus, so führt die Messung der Wellenfunktion zufällig zu einem Kollaps der Wellenfunktion zu einer scharf gekrümmten Funktion an einem bestimmten Ort. Bei Teilchen mit Masse ist die Wahrscheinlichkeit, das Teilchen an einem bestimmten Ort zu entdecken, gleich der quadrierten Amplitude der Wellenfunktion an diesem Ort. Die Messung liefert eine genau definierte Position und unterliegt der Heisenbergschen Unschärferelation. ⓘ

Mit der Entwicklung der Quantenfeldtheorie verschwand diese Zweideutigkeit. Das Feld erlaubt Lösungen, die der Wellengleichung folgen und als Wellenfunktionen bezeichnet werden. Der Begriff Teilchen wird verwendet, um die irreduziblen Darstellungen der Lorentz-Gruppe zu bezeichnen, die durch das Feld zugelassen werden. Eine Wechselwirkung wie in einem Feynman-Diagramm wird als rechnerisch bequeme Näherung akzeptiert, bei der die ausgehenden Schenkel als Vereinfachungen der Ausbreitung bekannt sind und die inneren Linien für eine gewisse Ordnung in einer Erweiterung der Feldwechselwirkung stehen. Da das Feld nichtlokal und gequantelt ist, werden die Phänomene erklärt, die früher als Paradoxe galten. Innerhalb der Grenzen des Welle-Teilchen-Dualismus liefert die Quantenfeldtheorie die gleichen Ergebnisse. ⓘ

Jedes Teilchen wird in der Quantenmechanik durch eine Wellenfunktion beschrieben. Die Wellenfunktion eines Teilchens ist komplexwertig und somit keine Messgröße. Lediglich ihr Betragsquadrat kann als Aufenthaltswahrscheinlichkeit (genauer: als Volumendichte der Aufenthaltswahrscheinlichkeit) des Teilchens gedeutet und im Experiment bestimmt werden. Die zeitliche Entwicklung der Wellenfunktion des Teilchens und somit die Veränderung seiner Aufenthaltswahrscheinlichkeit wird durch die Schrödingergleichung beschrieben. ⓘ

Veranschaulichung

Es gibt zwei Möglichkeiten, das Welle-Teilchen-Verhalten zu veranschaulichen: durch das Standardmodell und durch die de Broglie-Bohr-Theorie. ⓘ

Im Folgenden wird der Welle-Teilchen-Dualismus im Zusammenhang mit der de Broglie-Hypothese und der Heisenbergschen Unschärferelation anhand der Orts- und Impulsraum-Wellenfunktionen für ein spinloses Teilchen mit Masse in einer Dimension veranschaulicht. Diese Wellenfunktionen sind Fourier-Transformationen von einander. ⓘ

Je stärker die Orts-Raum-Wellenfunktion lokalisiert ist, desto wahrscheinlicher ist es, dass das Teilchen mit den Ortskoordinaten in dieser Region gefunden wird, und entsprechend ist die Impuls-Raum-Wellenfunktion weniger lokalisiert, so dass die möglichen Impulskomponenten, die das Teilchen haben könnte, weiter verbreitet sind. ⓘ

Umgekehrt, je stärker die Impuls-Raum-Wellenfunktion lokalisiert ist, desto wahrscheinlicher ist es, dass das Teilchen mit diesen Werten der Impulskomponenten in dieser Region gefunden wird, und entsprechend ist die Positions-Raum-Wellenfunktion weniger lokalisiert, so dass die Positionskoordinaten, die das Teilchen einnehmen könnte, weiter verbreitet sind. ⓘ

Oben: Wenn die Wellenlänge λ unbekannt ist, sind es auch der Impuls p, der Wellenvektor k und die Energie E (de Broglie-Beziehungen). Da das Teilchen im Positionsraum stärker lokalisiert ist, ist Δx kleiner als für Δpx.

Unten: Wenn λ bekannt ist, sind es auch p, k und E. Da das Teilchen mehr im Impulsraum lokalisiert ist, ist Δp kleiner als für Δx. ⓘ

Alternative Ansichten

Der Welle-Teilchen-Dualismus ist ein ständiges Rätsel in der modernen Physik. Die meisten Physiker akzeptieren den Welle-Teilchen-Dualismus als die beste Erklärung für ein breites Spektrum beobachteter Phänomene; er ist jedoch nicht unumstritten. Auch alternative Ansichten werden hier vorgestellt. Diese Ansichten werden von der Mainstream-Physik nicht allgemein akzeptiert, dienen aber als Grundlage für wertvolle Diskussionen innerhalb der Gemeinschaft. ⓘ

Sowohl-Teilchen-und-Wellen-Ansicht

Das Pilotwellenmodell wurde ursprünglich von Louis de Broglie entwickelt und von David Bohm zur Theorie der verborgenen Variablen weiterentwickelt. Der Ausdruck "verborgene Variable" ist irreführend, da die fragliche Variable die Positionen der Teilchen sind. Anstelle der Dualität schlägt das Modell der Pilotwelle vor, dass sowohl Welle als auch Teilchen vorhanden sind, wobei die Welle das Teilchen auf deterministische Weise steuert. Die fragliche Welle ist die Wellenfunktion, die Schrödingers Gleichung gehorcht. Bohms Formulierung soll klassisch sein, aber sie muss eine eindeutig nicht-klassische Merkmal: eine nichtlokale Kraft ("Quantenpotential"), die auf die Teilchen wirkt. ⓘ

Bohms ursprüngliches Ziel (1952) "war es zu zeigen, dass eine Alternative zur Kopenhagener Deutung zumindest logisch möglich ist. Bald darauf legte er das Projekt beiseite und und nahm es erst wieder auf, als er 1961 Basil Hiley traf, als beide am Birbeck College (University of London) waren. Bohm und Hiley schrieben daraufhin ausführlich über die Theorie, und sie wurde einem breiteren Publikum bekannt. Diese Idee wird von einer bedeutenden Minderheit innerhalb der Physikgemeinschaft vertreten. ⓘ

Das Afshar-Experiment (2007) könnte darauf hindeuten, dass es möglich ist, sowohl die Wellen- als auch die Teilcheneigenschaften von Photonen gleichzeitig zu beobachten. Diese Behauptung wird jedoch von anderen Wissenschaftlern angezweifelt. ⓘ

Nur-Wellen-Ansicht

Carver Mead, ein amerikanischer Wissenschaftler und Professor am Caltech, ist der Ansicht, dass der Dualismus durch eine reine Wellenbetrachtung ersetzt werden kann. In seinem Buch Collective Electrodynamics: Quantum Foundations of Electromagnetism (2000) behauptet Mead, das Verhalten von Elektronen und Photonen ausschließlich anhand von Elektronenwellenfunktionen zu analysieren, und führt das scheinbar teilchenartige Verhalten auf Quantisierungseffekte und Eigenzustände zurück. Laut dem Rezensenten David Haddon:

Mead hat den gordischen Knoten der Quantenkomplementarität durchschlagen. Er behauptet, dass Atome mit ihren Neutronen, Protonen und Elektronen überhaupt keine Teilchen sind, sondern reine Wellen der Materie. Als groben Beweis für die ausschließliche Wellennatur sowohl des Lichts als auch der Materie führt Mead die zwischen 1933 und 1996 erfolgte Entdeckung von zehn Beispielen reiner Wellenphänomene an, darunter der allgegenwärtige Laser von CD-Spielern, die sich selbst ausbreitenden elektrischen Ströme von Supraleitern und das Bose-Einstein-Kondensat von Atomen. ⓘ

Albert Einstein, der bei seiner Suche nach einer einheitlichen Feldtheorie den Welle-Teilchen-Dualismus nicht akzeptierte, schrieb:

Diese Doppelnatur der Strahlung (und der materiellen Teilchen) ... ist von der Quantenmechanik in genialer und erstaunlich erfolgreicher Weise interpretiert worden. Diese Interpretation ... erscheint mir nur als ein vorläufiger Ausweg ... ⓘ

Die Viele-Welten-Interpretation (MWI) wird manchmal als eine reine Wellentheorie dargestellt, auch von ihrem Begründer Hugh Everett, der die MWI als "Welleninterpretation" bezeichnete. ⓘ

Die Drei-Wellen-Hypothese von R. Horodecki setzt das Teilchen mit der Welle in Beziehung. Die Hypothese besagt, dass ein massives Teilchen ein sowohl räumlich als auch zeitlich ausgedehntes Wellenphänomen ist, das einem nichtlinearen Gesetz folgt. ⓘ

Die deterministische Kollaps-Theorie betrachtet Kollaps und Messung als zwei unabhängige physikalische Prozesse. Der Kollaps tritt auf, wenn sich zwei Wellenpakete räumlich überlappen und ein mathematisches Kriterium erfüllen, das von den Parametern beider Wellenpakete abhängt. Es handelt sich um eine Kontraktion auf das Überlappungsvolumen. In einem Messgerät ist eines der beiden Wellenpakete einer der Atomcluster, aus denen das Gerät besteht, und die Wellenpakete kollabieren höchstens auf das Volumen eines solchen Clusters. Dies ahmt die Wirkung eines Punktteilchens nach. ⓘ

Nur-Teilchen-Ansicht

Noch zu Zeiten der alten Quantentheorie wurde eine prä-quantenmechanische Version des Welle-Teilchen-Dualismus von William Duane entwickelt und von anderen wie Alfred Landé weiterentwickelt. Duane erklärte die Beugung von Röntgenstrahlen an einem Kristall ausschließlich mit ihrem Teilchenaspekt. Die Ablenkung der Flugbahn jedes gebeugten Photons wurde als Folge der quantisierten Impulsübertragung durch die räumlich regelmäßige Struktur des beugenden Kristalls erklärt. ⓘ

Weder-Welle-noch-Teilchen-Ansicht

Es wurde argumentiert, dass es niemals exakte Teilchen oder Wellen gibt, sondern nur einen Kompromiss oder ein Zwischending zwischen beiden. Aus diesem Grund prägte Arthur Eddington 1928 den Namen "Wellenteilchen", um die Objekte zu beschreiben, obwohl er heute nicht mehr regelmäßig verwendet wird. Eine Überlegung ist, dass nulldimensionale mathematische Punkte nicht beobachtet werden können. Eine andere ist, dass die formale Darstellung solcher Punkte, die Dirac-Delta-Funktion, unphysikalisch ist, da sie nicht normalisiert werden kann. Parallele Argumente gelten für reine Wellenzustände. Roger Penrose stellt fest:

Solche "Positionszustände" sind idealisierte Wellenfunktionen im umgekehrten Sinne wie die Impulszustände. Während die Impulszustände unendlich verteilt sind, sind die Positionszustände unendlich konzentriert. Beide sind nicht normalisierbar [...]. ⓘ

Verwendet

Obwohl es schwierig ist, den Welle-Teilchen-Dualismus vom Rest der Quantenmechanik abzugrenzen, ist es dennoch möglich, einige Anwendungen dieser Grundidee aufzulisten. ⓘ

- Der Welle-Teilchen-Dualismus wird in der Elektronenmikroskopie ausgenutzt, wo die kleinen Wellenlängen des Elektrons genutzt werden können, um Objekte zu betrachten, die viel kleiner sind als das, was mit sichtbarem Licht sichtbar ist.

- In ähnlicher Weise nutzt die Neutronenbeugung Neutronen mit einer Wellenlänge von etwa 0,1 nm, dem typischen Abstand der Atome in einem Festkörper, um die Struktur von Festkörpern zu bestimmen.

- Fotos sind nun in der Lage, diese doppelte Natur zu zeigen, was zu neuen Möglichkeiten der Untersuchung und Aufzeichnung dieses Verhaltens führen kann. ⓘ

Das Doppelspaltexperiment

Besonders eindrücklich zeigt sich das Verhalten von Quantenobjekten im sogenannten Doppelspaltexperiment. Thomas Young konnte mit diesem Experiment erstmals die Wellennatur des Lichts nachweisen. Die auf Newton zurückgehende Korpuskeltheorie schien damit zunächst widerlegt. ⓘ

Versuchsaufbau

Von einer Quelle gehen „Strahlen“ aus – es kann sich dabei um elektromagnetische Wellen oder Materieteilchen handeln – und treffen auf eine Blende mit zwei sehr feinen, eng beieinander liegenden Schlitzen. Diese Blende wird „Doppelspalt“ genannt. Hinter der Blende befindet sich ein Schirm. Die Strahlen, die durch den Doppelspalt gelangen, treffen auf den Schirm und werden dort in geeigneter Weise registriert. ⓘ

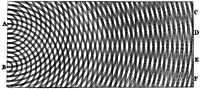

Klassische Wellen

Handelt es sich bei den Strahlen um klassische Wellen, so zeigen sie ein typisches Beugungsmuster, wie es in der nebenstehenden Abbildung 1 zu sehen ist: Je nach Wellenlänge der Strahlung und Geometrie des Doppelspalts erscheinen Bereiche auf dem Schirm streifenförmig hell oder dunkel. Die hellsten Stellen befinden sich dort, wo die beiden vom Doppelspalt ausgehenden Elementarwellen einen Wegunterschied aufweisen, der ein ganzzahliges Vielfaches der Wellenlänge ist, denn dann sind die beiden Wellen „in Phase“ und interferieren konstruktiv. In der Mitte zwischen zwei solchen Stellen sind die beiden Wellen gegenphasig und löschen sich durch destruktive Interferenz gegenseitig aus. ⓘ

Abgesehen von seinem streifenförmigen Aufbau erscheint das Beugungsmuster kontinuierlich. Die Helligkeit an einem Ort kann jeden beliebigen Wert zwischen völliger Dunkelheit und maximaler Beleuchtung annehmen. ⓘ

Klassische Teilchen

Klassische Teilchen (also einzelne Massepunkte) zeigen keine Interferenz (siehe Abbildung 2). Sie gelangen entweder durch den linken oder den rechten Spalt und treffen dann jeweils innerhalb eines klar abgegrenzten Bereichs auf den Schirm. Folglich erscheinen auf dem Schirm genau zwei helle Streifen (je einer für einen der beiden Spalte). Bei genauerer Betrachtung fällt die körnige Struktur der beiden Streifen auf. Jedes Teilchen trifft an genau einer Stelle auf und hinterlässt dort einen hellen Punkt. Es gibt keinen kontinuierlichen Helligkeitsverlauf. Ein Ort ist entweder hell oder dunkel markiert, denn entweder wurde er von einem Teilchen getroffen oder nicht. ⓘ

Quantenobjekte

Die Objekte der Quantenphysik verhalten sich hingegen so, wie es die dritte und vierte Abbildung veranschaulichen: Wie bei den klassischen Wellen zeigt die Intensitätsverteilung auf dem Schirm ein typisches Beugungsmuster. Es muss also Interferenz auftreten. Andererseits ist der Intensitätsverlauf nicht kontinuierlich. Es erscheinen helle Punkte, jedoch in unterschiedlicher Dichte. Jedem Quantenobjekt kann also (zumindest nachträglich) ein bestimmter Ort zugewiesen werden, an dem es auf den Schirm getroffen ist. Es handelt sich daher eindeutig um ein zählbares, punktförmiges Objekt. ⓘ

Diskussion

Die Quantenobjekte zeigen also offensichtlich Eigenschaften beider klassischen Modelle: Sie interferieren miteinander, was typisch für Wellen ist. Andererseits sind sie zählbar und punktförmig, was der Wellennatur gänzlich widerspricht und eher auf eine Teilchennatur hinweist. Es gelingt nicht, eines der beiden Modelle widerspruchsfrei so zu modifizieren, dass es alle Aspekte des Versuchsergebnisses erklären könnte. Beispielsweise kann ein Teilchen nur durch einen der beiden Spalte gehen, jedoch nicht durch beide gleichzeitig. Wenn man abwechselnd einen der beiden Spalte abdeckt, so erhält man die Verteilung von Teilchen, die entweder durch den rechten oder durch den linken Spalt gegangen sind. Dies entspricht näherungsweise der Verteilung aus Abbildung 2, wenn man über die Beugungserscheinungen an den Kanten hinwegsieht, die bei Quantenobjekten immer auftreten. Öffnet man wieder beide Spalte, so erscheint das Beugungsmuster aus Abbildung 3 bzw. 4. Daraus folgt, dass man das Verteilungsmuster der Quantenobjekte auf dem Schirm nicht erklären kann, wenn man davon ausgeht, dass das einzelne Quantenobjekt entweder den Weg durch den einen oder durch den anderen Spalt nimmt. Trotzdem muss es sich um einzelne, unteilbare, punktförmige Teilchen handeln, denn als solche werden sie am Schirm räumlich und zeitlich getrennt voneinander registriert, wie man besonders deutlich in Abb. 4(b) sieht. Die Vorstellung einer räumlich ausgedehnten Welle, die gleichzeitig durch beide Spalte gehen und danach mit sich selbst interferieren kann, ist daher ebenso falsch. ⓘ

Quantenobjekte zeigen also ein Verhalten, das weder mit dem klassischen Wellenbild noch mit dem klassischen Teilchenbild befriedigend erklärt werden kann. ⓘ

Schlüsselexperimente

Zunächst stützte sich der Welle-Teilchen-Dualismus auf Untersuchungen zum Spektrum der Wärmestrahlung (Planck), zum photoelektrischen Effekt und zur statistischen Schwankung der Wärmestrahlung (Einstein) und theoretische Überlegungen zur Möglichkeit der Materiewelle (de Broglie). Er war also eher indirekt entdeckt worden, spielte aber in der Wellenmechanik (Schrödinger) eine zentrale Rolle. Daher war es das Ziel weiterer Experimente, den Welle-Teilchen-Dualismus auf wesentlich direktere Weise zu prüfen. ⓘ

Neuere Experimente

2005 entwickelten Pariser Physiker um Yves Couder mit einem Öltröpfchenexperiment ein makroskopisches System zum Test von de Broglies Ansatz. Öltröpfchen, welche auf den Wellen eines Ölbades surfen, könnten quantenartige Verhaltensweisen zeigen. „Zum Beispiel folgten sie nur bestimmten, »quantisierten« Bahnen, die um das Zentrum der Flüssigkeitsbäder verliefen. Und manchmal sprangen die Tröpfchen zufällig zwischen den Bahnen hin und her, so ähnlich, wie es Elektronen in Atomen tun.“ Neue Experimente von 2015 deuten jedoch darauf hin, dass Couders Demonstration quantenähnlicher Phänomene nicht den strengen Bedingungen des Doppelspaltexperiments standhält. Gleichzeitig bringen diese Experimente auch de Broglies Pilotwellen-Theorie zu Fall. Wenn man nämlich senkrecht zu den Spalten eine Trennwand einfügt, welche die Pilotwelle bzw. die Teilchen, die den einen oder den anderen Spalt passieren werden, schon weit vor dem Durchtritt trennt, verlieren die Teilchen „den Kontakt mit der Pilotwelle auf der anderen Seite der senkrecht zum Schirm angebrachten Barriere. Ohne Kontakt zum Teilchen beziehungsweise Öltropfen geht der Wellenfront jedoch rasch die Puste aus; sie kommt lange vor Erreichen des Spalts zum Erliegen.“ Dadurch kann sich hinter dem Doppelspalt auch kein Interferenzmuster mehr bilden. ⓘ

Quantenmechanik und statistische Physik

Im mikroskopischen Bereich dient der Welle-Teilchen-Dualismus als heuristische Erklärung für einige physikalische Phänomene. So hängt nach de Broglie die Wellenlänge eines Teilchens von seiner Geschwindigkeit und somit auch von seiner Temperatur ab. Bei niedrigen Temperaturen können die De-Broglie-Wellenlängen von Atomen größer werden als der Atomdurchmesser und sich überlappen, wodurch teilweise die Effekte der Suprafluidität von Helium-3 und Helium-4 erklärt werden können. Für eine vollständige und quantitative Behandlung dieser Themen muss jedoch die Quantenmechanik herangezogen werden. ⓘ

Makroskopische Betrachtung

Der Wellencharakter der Teilchen zeigt sich nicht bei makroskopischen Gegenständen, was zwei prinzipielle Ursachen hat:

- Selbst bei langsamer Bewegung haben makroskopische Gegenstände aufgrund ihrer großen Masse eine Wellenlänge, die erheblich kleiner ist als die Abmessungen des Gegenstandes. In diesem Fall kann man nicht mehr den gesamten Gegenstand als ein quantenmechanisches Objekt behandeln, sondern muss seine Bestandteile separat beschreiben.

- In makroskopischen Gegenständen laufen permanent thermodynamisch irreversible Prozesse ab und es werden Photonen (Wärmestrahlung) mit der Umgebung ausgetauscht. Beides führt zur Dekohärenz des Systems, was bedeutet, dass ein anfangs möglicherweise interferenzfähiger Zustand sich sehr schnell in einen nicht interferenzfähigen umwandelt, der sich dann wie ein klassisches Teilchen, also nicht wie eine Welle verhält. ⓘ

Anwendungsbeispiel Röntgenspektroskopie

In der Röntgenspektroskopie macht man sich die Eigenschaften der charakteristischen Röntgenstrahlung zunutze. Das Röntgenspektrum eines Stoffes gibt Aufschluss über den inneren Aufbau seiner Atome und kann daher für die Analytik verwendet werden. Die Messung kann entweder wellenlängen- oder energiedispersiv erfolgen. Bei der energiedispersiven Methode werden direkt die Energien der einzelnen Photonen bestimmt (also in der klassischen Sprechweise eine „Teilcheneigenschaft“), aus denen sich die atomaren Energieniveaus berechnen lassen. Zum selben Zweck kann man aber auch die Wellenlänge der Röntgenstrahlen messen (also eine „Welleneigenschaft“). Beide – Energie und Wellenlänge – sind charakteristische Eigenschaften der Röntgenquanten, die folglich weder klassische Wellen noch klassische Teilchen sein können. ⓘ