Eigenwertproblem

Ein Eigenvektor einer Abbildung ist in der linearen Algebra ein vom Nullvektor verschiedener Vektor, dessen Richtung durch die Abbildung nicht verändert wird. Ein Eigenvektor wird also nur skaliert und man bezeichnet den Skalierungsfaktor als Eigenwert der Abbildung. ⓘ

Eigenwerte charakterisieren wesentliche Eigenschaften linearer Abbildungen, etwa ob ein entsprechendes lineares Gleichungssystem eindeutig lösbar ist oder nicht. In vielen Anwendungen beschreiben Eigenwerte auch physikalische Eigenschaften eines mathematischen Modells. Die Verwendung des Präfixes „Eigen-“ für charakteristische Größen in diesem Sinne lässt sich auf eine Veröffentlichung von David Hilbert aus dem Jahre 1904 zurückführen und wird als Germanismus auch in einigen weiteren Sprachen, darunter dem Englischen, verwendet. ⓘ

Die im Folgenden beschriebene mathematische Problemstellung heißt spezielles Eigenwertproblem und bezieht sich nur auf lineare Abbildungen eines endlichdimensionalen Vektorraums in sich (Endomorphismen), wie sie durch quadratische Matrizen dargestellt werden. ⓘ

Hierbei stellt sich die Frage, unter welchen Bedingungen eine Matrix ähnlich zu einer Diagonalmatrix ist. ⓘ

Formale Definition

Wenn T eine lineare Transformation von einem Vektorraum V über einem Feld F in sich selbst ist und v ein Nicht-Null-Vektor in V ist, dann ist v ein Eigenvektor von T, wenn T(v) ein skalares Vielfaches von v ist.

wobei λ ein Skalar in F ist, bekannt als der Eigenwert, der charakteristische Wert oder die charakteristische Wurzel, die mit v verbunden ist. ⓘ

Es gibt eine direkte Entsprechung zwischen n-mal-n quadratischen Matrizen und linearen Transformationen von einem n-dimensionalen Vektorraum in sich selbst, wenn eine beliebige Basis des Vektorraums gegeben ist. Daher ist es in einem endlich-dimensionalen Vektorraum äquivalent, Eigenwerte und Eigenvektoren entweder mit der Sprache der Matrizen oder mit der Sprache der linearen Transformationen zu definieren. ⓘ

Wenn V endlich-dimensional ist, ist die obige Gleichung äquivalent zu

wobei A die Matrixdarstellung von T und u der Koordinatenvektor von v ist. ⓘ

Überblick

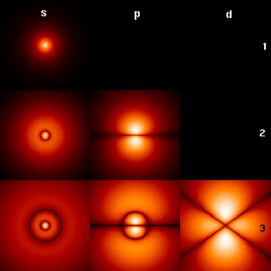

Eigenwerte und Eigenvektoren spielen bei der Analyse von linearen Transformationen eine wichtige Rolle. Die Vorsilbe eigen- wurde vom deutschen Wort eigen (verwandt mit dem englischen Wort own) für "eigen", "charakteristisch", "eigen" übernommen. Ursprünglich zur Untersuchung der Hauptachsen der Rotationsbewegung starrer Körper verwendet, finden Eigenwerte und Eigenvektoren eine Vielzahl von Anwendungen, z. B. in der Stabilitätsanalyse, der Schwingungsanalyse, den Atomorbitalen, der Gesichtserkennung und der Matrixdiagonalisierung. ⓘ

Im Wesentlichen ist ein Eigenvektor v einer linearen Transformation T ein von Null verschiedener Vektor, der bei Anwendung von T seine Richtung nicht ändert. Die Anwendung von T auf den Eigenvektor skaliert den Eigenvektor nur um den skalaren Wert λ, der als Eigenwert bezeichnet wird. Diese Bedingung kann als Gleichung geschrieben werden ⓘ

geschrieben werden, die als Eigenwertgleichung oder Eigengleichung bezeichnet wird. Im Allgemeinen kann λ ein beliebiger Skalarwert sein. Zum Beispiel kann λ negativ sein, in diesem Fall kehrt der Eigenvektor im Rahmen der Skalierung seine Richtung um, oder er kann Null oder komplex sein. ⓘ

Das hier abgebildete Beispiel der Mona Lisa bietet eine einfache Veranschaulichung. Jeder Punkt auf dem Gemälde kann als ein Vektor dargestellt werden, der vom Mittelpunkt des Gemäldes zu diesem Punkt zeigt. Die lineare Transformation in diesem Beispiel wird als Scherabbildung bezeichnet. Die Punkte in der oberen Hälfte werden nach rechts und die Punkte in der unteren Hälfte nach links verschoben, und zwar proportional dazu, wie weit sie von der horizontalen Achse entfernt sind, die durch die Mitte des Bildes verläuft. Die Vektoren, die auf jeden Punkt des Originalbildes zeigen, werden also nach rechts oder links gekippt und durch die Transformation länger oder kürzer gemacht. Die Punkte entlang der horizontalen Achse bewegen sich bei dieser Transformation überhaupt nicht. Daher ist jeder Vektor, der direkt nach rechts oder links zeigt und keine vertikale Komponente aufweist, ein Eigenvektor dieser Transformation, da die Abbildung seine Richtung nicht ändert. Außerdem haben diese Eigenvektoren alle einen Eigenwert von 1, weil die Abbildung auch ihre Länge nicht verändert. ⓘ

Lineare Transformationen können viele verschiedene Formen annehmen und Vektoren in einer Vielzahl von Vektorräumen abbilden, so dass auch die Eigenvektoren viele Formen annehmen können. Die lineare Transformation könnte beispielsweise ein Differentialoperator sein wie sein. In diesem Fall sind die Eigenvektoren Funktionen, die als Eigenfunktionen bezeichnet werden und durch diesen Differentialoperator skaliert werden, z. B. ⓘ

Alternativ kann die lineare Transformation auch die Form einer n mal n-Matrix annehmen, wobei die Eigenvektoren n mal 1-Matrizen sind. Wird die lineare Transformation in Form einer n-mal-n-Matrix A ausgedrückt, so kann die obige Eigenwertgleichung für eine lineare Transformation als Matrixmultiplikation umgeschrieben werden ⓘ

wobei der Eigenvektor v eine n x 1-Matrix ist. Für eine Matrix können Eigenwerte und Eigenvektoren verwendet werden, um die Matrix zu zerlegen, beispielsweise durch Diagonalisierung. ⓘ

Eigenwerte und Eigenvektoren führen zu vielen eng verwandten mathematischen Konzepten, und die Vorsilbe Eigen- wird bei ihrer Benennung großzügig verwendet:

- Die Menge aller Eigenvektoren einer linearen Transformation, die jeweils mit dem entsprechenden Eigenwert gepaart sind, wird als Eigensystem dieser Transformation bezeichnet.

- Die Menge aller Eigenvektoren von T, die demselben Eigenwert entsprechen, wird zusammen mit dem Nullvektor als Eigenraum oder als der charakteristische Raum von T bezeichnet, der mit diesem Eigenwert assoziiert ist.

- Bildet eine Menge von Eigenvektoren von T eine Basis des Bereichs von T, so nennt man diese Basis eine Eigenbasis. ⓘ

Geschichte

Eigenwerte werden häufig im Zusammenhang mit der linearen Algebra oder der Matrixtheorie eingeführt. Historisch gesehen stammen sie jedoch aus dem Studium der quadratischen Formen und Differentialgleichungen. ⓘ

Im 18. Jahrhundert untersuchte Leonhard Euler die Rotationsbewegung eines starren Körpers und entdeckte dabei die Bedeutung der Hauptachsen. Joseph-Louis Lagrange erkannte, dass die Hauptachsen die Eigenvektoren der Trägheitsmatrix sind. ⓘ

Im frühen 19. Jahrhundert erkannte Augustin-Louis Cauchy, wie ihre Arbeit zur Klassifizierung quadratischer Flächen verwendet werden konnte, und verallgemeinerte sie auf beliebige Dimensionen. Cauchy prägte auch den Begriff racine caractéristique (charakteristische Wurzel) für das, was heute als Eigenwert bezeichnet wird; sein Begriff hat in der charakteristischen Gleichung überlebt. ⓘ

Später nutzte Joseph Fourier die Arbeiten von Lagrange und Pierre-Simon Laplace, um die Wärmegleichung in seinem berühmten Buch Théorie analytique de la chaleur (1822) durch Trennung der Variablen zu lösen. Charles-François Sturm entwickelte Fouriers Ideen weiter und machte Cauchy auf sie aufmerksam, der sie mit seinen eigenen Ideen kombinierte und zu der Erkenntnis gelangte, dass reelle symmetrische Matrizen reelle Eigenwerte haben. Dies wurde von Charles Hermite 1855 auf die so genannten hermiteschen Matrizen ausgedehnt. ⓘ

Etwa zur gleichen Zeit bewies Francesco Brioschi, dass die Eigenwerte von orthogonalen Matrizen auf dem Einheitskreis liegen, und Alfred Clebsch fand das entsprechende Ergebnis für schiefsymmetrische Matrizen. Schließlich klärte Karl Weierstraß einen wichtigen Aspekt der von Laplace begonnenen Stabilitätstheorie, indem er erkannte, dass fehlerhafte Matrizen Instabilität verursachen können. ⓘ

In der Zwischenzeit untersuchte Joseph Liouville Eigenwertprobleme, die denen von Sturm ähnlich waren; die Disziplin, die aus ihrer Arbeit hervorging, wird heute Sturm-Liouville-Theorie genannt. Schwarz untersuchte gegen Ende des 19. Jahrhunderts den ersten Eigenwert der Laplace-Gleichung auf allgemeinen Gebieten, während Poincaré einige Jahre später die Poisson-Gleichung studierte. ⓘ

Zu Beginn des 20. Jahrhunderts untersuchte David Hilbert die Eigenwerte von Integraloperatoren, indem er die Operatoren als unendliche Matrizen betrachtete. Er war der erste, der 1904 das deutsche Wort eigen" zur Bezeichnung von Eigenwerten und Eigenvektoren verwendete, wobei er sich möglicherweise auf eine ähnliche Verwendung durch Hermann von Helmholtz berief. Eine Zeit lang war der Standardbegriff im Englischen "proper value" (Eigenwert), aber heute ist der markantere Begriff "eigenvalue" der Standard. ⓘ

Der erste numerische Algorithmus zur Berechnung von Eigenwerten und Eigenvektoren erschien 1929, als Richard von Mises die Potenzmethode veröffentlichte. Eine der heute populärsten Methoden, der QR-Algorithmus, wurde 1961 unabhängig voneinander von John G. F. Francis und Vera Kublanovskaya vorgeschlagen. ⓘ

Eigenwerte und Eigenvektoren von Matrizen

Eigenwerte und Eigenvektoren werden den Studierenden häufig im Rahmen von Kursen zur linearen Algebra vorgestellt, die sich mit Matrizen befassen. Darüber hinaus können lineare Transformationen über einen endlich-dimensionalen Vektorraum durch Matrizen dargestellt werden, was insbesondere bei numerischen und rechnerischen Anwendungen üblich ist. ⓘ

Betrachten wir n-dimensionale Vektoren, die als Liste von n Skalaren gebildet werden, wie z. B. die dreidimensionalen Vektoren

Diese Vektoren werden als skalare Vielfache voneinander oder als parallel oder kollinear bezeichnet, wenn es einen Skalar λ gibt, für den gilt

In diesem Fall ist . ⓘ

Betrachten wir nun die lineare Transformation von n-dimensionalen Vektoren, die durch eine n x n-Matrix A definiert ist,

oder

wobei für jede Zeile

Wenn v und w skalare Vielfache sind, d. h. wenn

-

(1)

dann ist v ein Eigenvektor der linearen Transformation A und der Skalenfaktor λ ist der diesem Eigenvektor entsprechende Eigenwert. Gleichung (1) ist die Eigenwertgleichung für die Matrix A. ⓘ

Gleichung (1) lässt sich äquivalent ausdrücken als

-

(2) ⓘ

wobei I die n-mal-n-Identitätsmatrix und 0 der Nullvektor ist. ⓘ

Eigenwerte und das charakteristische Polynom

Gleichung (2) hat nur dann eine Lösung v ungleich Null, wenn die Determinante der Matrix (A - λI) Null ist. Daher sind die Eigenwerte von A die Werte von λ, die die Gleichung erfüllen

-

(3) ⓘ

Unter Verwendung der Leibnizschen Regel für die Determinante ist die linke Seite von Gleichung (3) eine Polynomfunktion der Variablen λ und der Grad dieses Polynoms ist n, die Ordnung der Matrix A. Seine Koeffizienten hängen von den Einträgen von A ab, mit der Ausnahme, dass sein Term vom Grad n immer (-1)nλn ist. Dieses Polynom wird als charakteristisches Polynom von A bezeichnet. Gleichung (3) wird als charakteristische Gleichung oder säkulare Gleichung von A bezeichnet. ⓘ

Der Fundamentalsatz der Algebra besagt, dass das charakteristische Polynom einer n-mal-n-Matrix A, das ein Polynom vom Grad n ist, in das Produkt von n linearen Termen zerlegt werden kann,

-

(4) ⓘ

wobei jedes λi reell sein kann, im Allgemeinen aber eine komplexe Zahl ist. Die Zahlen λ1, λ2, ..., λn, die nicht alle eindeutige Werte haben müssen, sind Wurzeln des Polynoms und die Eigenwerte von A. ⓘ

Als kurzes Beispiel, das später im Abschnitt über die Beispiele ausführlicher beschrieben wird, betrachten wir die Matrix

Nimmt man die Determinante von (A - λI), so ist das charakteristische Polynom von A

Setzt man das charakteristische Polynom gleich Null, so hat es Wurzeln bei λ=1 und λ=3, den beiden Eigenwerten von A. Die jedem Eigenwert entsprechenden Eigenvektoren lassen sich ermitteln, indem man die Komponenten von v in der folgenden Gleichung auflöst . In diesem Beispiel sind die Eigenvektoren alle von Null verschiedenen skalaren Vielfachen von

Wenn die Einträge der Matrix A alle reelle Zahlen sind, dann sind auch die Koeffizienten des charakteristischen Polynoms reelle Zahlen, aber die Eigenwerte können immer noch Imaginärteile ungleich Null haben. Die Einträge der entsprechenden Eigenvektoren können daher auch Imaginärteile ungleich Null haben. In ähnlicher Weise können die Eigenwerte irrationale Zahlen sein, selbst wenn alle Einträge von A rationale Zahlen sind oder sogar ganzzahlig. Handelt es sich bei den Einträgen von A jedoch um algebraische Zahlen, zu denen auch die rationalen Zahlen gehören, sind die Eigenwerte komplexe algebraische Zahlen. ⓘ

Die nicht reellen Wurzeln eines reellen Polynoms mit reellen Koeffizienten lassen sich in Paaren von komplex Konjugierten zusammenfassen, wobei die beiden Mitglieder jedes Paares imaginäre Teile haben, die sich nur im Vorzeichen unterscheiden, und denselben reellen Teil. Wenn der Grad ungerade ist, dann ist nach dem Zwischenwertsatz mindestens eine der Wurzeln reell. Daher hat jede reelle Matrix mit ungerader Ordnung mindestens einen reellen Eigenwert, während eine reelle Matrix mit gerader Ordnung möglicherweise keine reellen Eigenwerte hat. Die Eigenvektoren, die diesen komplexen Eigenwerten zugeordnet sind, sind ebenfalls komplex und treten auch in komplex konjugierten Paaren auf. ⓘ

Algebraische Mannigfaltigkeit

λi sei ein Eigenwert einer n mal n Matrix A. Die algebraische Vielfachheit μA(λi) des Eigenwerts ist seine Vielfachheit als Wurzel des charakteristischen Polynoms, d. h. die größte ganze Zahl k, so dass (λ - λi)k gleichmäßig durch dieses Polynom geteilt wird. ⓘ

Angenommen, eine Matrix A hat die Dimension n und d ≤ n verschiedene Eigenwerte. Während Gleichung (4) das charakteristische Polynom von A in das Produkt von n linearen Termen zerlegt, wobei sich einige Terme potenziell wiederholen, kann das charakteristische Polynom stattdessen als Produkt von d Termen geschrieben werden, die jeweils einem bestimmten Eigenwert entsprechen und mit der Potenz der algebraischen Vielfachheit erhöht werden,

Wenn d = n ist, dann ist die rechte Seite das Produkt von n linearen Termen und dies entspricht der Gleichung (4). Die Größe der algebraischen Mannigfaltigkeit eines jeden Eigenwerts ist mit der Dimension n wie folgt verknüpft

Wenn μA(λi) = 1 ist, dann heißt es, dass λi ein einfacher Eigenwert ist. Wenn μA(λi) gleich der im nächsten Abschnitt definierten geometrischen Multiplizität von λi, γA(λi), ist, dann heißt es, dass λi ein semisimpler Eigenwert ist. ⓘ

Eigenräume, geometrische Mannigfaltigkeit und die Eigenbasis für Matrizen

Bei einem bestimmten Eigenwert λ der n x n-Matrix A wird die Menge E definiert als alle Vektoren v, die Gleichung (2) erfüllen,

Einerseits ist diese Menge genau der Kern oder Nullraum der Matrix (A - λI). Andererseits ist per Definition jeder von Null verschiedene Vektor, der diese Bedingung erfüllt, ein mit λ assoziierter Eigenvektor von A. Die Menge E ist also die Vereinigung des Nullvektors mit der Menge aller mit λ assoziierten Eigenvektoren von A, und E ist gleich dem Nullraum von (A - λI). E wird als Eigenraum oder charakteristischer Raum von A bezeichnet, der mit λ assoziiert ist. Im Allgemeinen ist λ eine komplexe Zahl und die Eigenvektoren sind komplexe n x 1-Matrizen. Eine Eigenschaft des Nullraums ist, dass er ein linearer Unterraum ist, so dass E ein linearer Unterraum von . ⓘ

Da der Eigenraum E ein linearer Unterraum ist, ist er durch Addition geschlossen. Das heißt, wenn zwei Vektoren u und v zu der Menge E gehören, geschrieben u, v ∈ E, dann ist (u + v) ∈ E oder äquivalent A(u + v) = λ(u + v). Dies kann mit Hilfe der distributiven Eigenschaft der Matrixmultiplikation überprüft werden. Da E ein linearer Unterraum ist, ist er auch bei skalarer Multiplikation geschlossen. Das heißt, wenn v ∈ E und α eine komplexe Zahl ist, ist (αv) ∈ E oder äquivalent A(αv) = λ(αv). Dies kann überprüft werden, indem man feststellt, dass die Multiplikation von komplexen Matrizen mit komplexen Zahlen kommutativ ist. Solange u + v und αv nicht Null sind, sind sie auch Eigenvektoren von A, die mit λ assoziiert sind. ⓘ

Die Dimension des mit λ assoziierten Eigenraumes E bzw. die maximale Anzahl der mit λ assoziierten linear unabhängigen Eigenvektoren wird als geometrische Mannigfaltigkeit des Eigenwertes γA(λ) bezeichnet. Da E auch der Nullraum von (A - λI) ist, ist die geometrische Multiplizität von λ die Dimension des Nullraums von (A - λI), auch Nullstelle von (A - λI) genannt, die mit der Dimension und dem Rang von (A - λI) zusammenhängt als

Aufgrund der Definition von Eigenwerten und Eigenvektoren muss die geometrische Mannigfaltigkeit eines Eigenwerts mindestens eins sein, d. h. jeder Eigenwert hat mindestens einen zugehörigen Eigenvektor. Außerdem kann die geometrische Mannigfaltigkeit eines Eigenwerts seine algebraische Mannigfaltigkeit nicht übersteigen. Außerdem kann die algebraische Mannigfaltigkeit eines Eigenwerts nicht größer als n sein.

Zum Beweis der Ungleichung zu beweisen, betrachten wir, wie die Definition der geometrischen Multiplizität die Existenz von orthonormale Eigenvektoren , so dass . Wir können also eine (unitäre) Matrix finden finden, deren erste Spalten diese Eigenvektoren sind und deren übrige Spalten eine beliebige orthonormale Menge von Vektoren sein können, die orthogonal zu diesen Eigenvektoren von . Dann hat den vollen Rang und ist daher invertierbar, und mit eine Matrix, deren oberer linker Block die Diagonalmatrix ist . Dies impliziert, dass . Mit anderen Worten, ist vergleichbar mit , was impliziert, dass . Aber aus der Definition von wissen wir, dass einen Faktor enthält enthält, was bedeutet, dass die algebraische Mannigfaltigkeit von erfüllen muss . ⓘ

Angenommen, hat verschiedene Eigenwerte wobei die geometrische Mannigfaltigkeit von ist. . Die gesamte geometrische Multiplizität von ,

ist die Dimension der Summe aller Eigenräume der Eigenwerte von \lambda_i, oder äquivalent die maximale Anzahl linear unabhängiger Eigenvektoren von . Wenn , dann

- Die direkte Summe der Eigenräume aller Eigenwerte von Eigenwerte ist der gesamte Vektorraum .

- Eine Basis von kann gebildet werden aus linear unabhängigen Eigenvektoren von gebildet werden; eine solche Basis wird Eigenbasis genannt

- Jeder Vektor in kann als Linearkombination von Eigenvektoren von . ⓘ

Zusätzliche Eigenschaften von Eigenwerten

Sei sei eine beliebige Matrix aus komplexen Zahlen mit den Eigenwerten . Jeder Eigenwert erscheint mal in dieser Liste, wobei ist die algebraische Mannigfaltigkeit des Eigenwerts. Im Folgenden werden die Eigenschaften dieser Matrix und ihrer Eigenwerte beschrieben:

- Die Spur von , definiert als die Summe ihrer Diagonalelemente, ist auch die Summe aller Eigenwerte,

- Die Determinante von ist das Produkt aller ihrer Eigenwerte,

- Die Eigenwerte der ten Potenz von ; d.h. die Eigenwerte von , für jede positive ganze Zahl , sind .

- Die Matrix ist dann und nur dann invertierbar, wenn jeder Eigenwert ungleich Null ist.

- Wenn invertierbar ist, dann sind die Eigenwerte von sind und die geometrische Mannigfaltigkeit jedes Eigenwerts stimmt überein. Da das charakteristische Polynom der Inversen das reziproke Polynom des Originals ist, haben die Eigenwerte außerdem dieselbe algebraische Vielfachheit.

- Wenn ist gleich seiner konjugierten Transponierten gleich ist, oder äquivalent, wenn hermitesch ist, dann ist jeder Eigenwert real. Das Gleiche gilt für jede symmetrische reelle Matrix.

- Wenn ist nicht nur hermitesch, sondern auch positiv-definit, positiv-halbfinit, negativ-definit oder negativ-halbfinit, dann ist jeder Eigenwert positiv, nicht-negativ, negativ oder nicht-positiv.

- Wenn ist unitär, dann hat jeder Eigenwert einen absoluten Wert .

- wenn ist eine Matrix ist und ihre Eigenwerte sind, dann sind die Eigenwerte der Matrix (wobei die Identitätsmatrix ist) sind . Außerdem, wenn sind, sind die Eigenwerte von sind . Allgemeiner ausgedrückt, für ein Polynom die Eigenwerte der Matrix sind . ⓘ

Linke und rechte Eigenvektoren

In vielen Disziplinen werden Vektoren traditionell als Matrizen mit einer einzigen Spalte und nicht als Matrizen mit einer einzigen Zeile dargestellt. Aus diesem Grund bezieht sich das Wort "Eigenvektor" im Zusammenhang mit Matrizen fast immer auf einen rechten Eigenvektor, nämlich einen Spaltenvektor, der die Matrix in der Definitionsgleichung, Gleichung (1),

Das Eigenwert- und Eigenvektorproblem kann auch für Zeilenvektoren definiert werden, die die Matrix linksmultiplizieren . In dieser Formulierung lautet die Definitionsgleichung

wobei ein Skalar ist und ist eine Matrix. Jeder Zeilenvektor der diese Gleichung erfüllt, wird als linker Eigenvektor von und ist sein zugehöriger Eigenwert. Nimmt man die Transponierung dieser Gleichung,

Vergleicht man diese Gleichung mit Gleichung (1), so ergibt sich unmittelbar, dass ein linker Eigenvektor von dasselbe ist wie die Transponierte eines rechten Eigenvektors von ist, mit demselben Eigenwert. Da außerdem das charakteristische Polynom von das gleiche ist wie das charakteristische Polynom von ist, sind die Eigenwerte der linken Eigenvektoren von die gleichen wie die Eigenwerte der rechten Eigenvektoren von . ⓘ

Manchmal bezeichnet man einen so definierten Eigenvektor auch als Rechtseigenvektor und definiert dann entsprechend den Begriff des Linkseigenvektors durch die Gleichung

Linkseigenvektoren finden sich z. B. in der Stochastik bei der Berechnung von stationären Verteilungen von Markow-Ketten mittels einer Übergangsmatrix. ⓘ

Wegen sind die Linkseigenvektoren von gerade die Rechtseigenvektoren der adjungierten Matrix Bei normalen Matrizen fallen Links- und Rechtseigenvektoren zusammen. ⓘ

Allgemeiner kann man auch quadratische Matrizen und und die Gleichung

untersuchen. Dieses verallgemeinerte Eigenwertproblem wird hier jedoch nicht weiter betrachtet. ⓘ

Diagonalisierung und die Eigenwertzerlegung

Nehmen wir an, die Eigenvektoren von A bilden eine Basis, oder anders ausgedrückt, A hat n linear unabhängige Eigenvektoren v1, v2, ..., vn mit den zugehörigen Eigenwerten λ1, λ2, ..., λn. Die Eigenwerte müssen nicht eindeutig sein. Definieren Sie eine quadratische Matrix Q, deren Spalten die n linear unabhängigen Eigenvektoren von A sind,

Da jede Spalte von Q ein Eigenvektor von A ist, skaliert die Rechtsmultiplikation von A mit Q jede Spalte von Q mit ihrem zugehörigen Eigenwert,

In diesem Sinne definieren wir eine Diagonalmatrix Λ, in der jedes Diagonalelement Λii der Eigenwert ist, der der i-ten Spalte von Q zugeordnet ist.

Da die Spalten von Q linear unabhängig sind, ist Q invertierbar. Man multipliziert beide Seiten der Gleichung rechts mit Q-1,

oder indem man stattdessen beide Seiten mit Q-1 links multipliziert,

A kann daher in eine Matrix aus seinen Eigenvektoren, eine Diagonalmatrix mit seinen Eigenwerten entlang der Diagonalen und die Umkehrung der Eigenvektor-Matrix zerlegt werden. Dies wird als Eigenwertzerlegung bezeichnet und ist eine Ähnlichkeitstransformation. Eine solche Matrix A wird als ähnlich der Diagonalmatrix Λ oder diagonalisierbar bezeichnet. Die Matrix Q ist die Basisänderungsmatrix der Ähnlichkeitstransformation. Im Wesentlichen repräsentieren die Matrizen A und Λ dieselbe lineare Transformation, ausgedrückt in zwei verschiedenen Basen. Die Eigenvektoren werden als Basis verwendet, wenn die lineare Transformation als Λ dargestellt wird. ⓘ

Nehmen wir umgekehrt an, eine Matrix A sei diagonalisierbar. Sei P eine nicht-singuläre quadratische Matrix, so dass P-1AP eine diagonale Matrix D ist. Linksmultiplikation beider mit P, AP = PD. Jede Spalte von P muss also ein Eigenvektor von A sein, dessen Eigenwert das entsprechende Diagonalelement von D ist. Da die Spalten von P linear unabhängig sein müssen, damit P invertierbar ist, gibt es n linear unabhängige Eigenvektoren von A. Daraus folgt, dass die Eigenvektoren von A nur dann eine Basis bilden, wenn A diagonalisierbar ist. ⓘ

Eine Matrix, die nicht diagonalisierbar ist, wird als defekt bezeichnet. Für defekte Matrizen verallgemeinert sich der Begriff der Eigenvektoren zu verallgemeinerten Eigenvektoren und die Diagonalmatrix der Eigenwerte verallgemeinert sich zur Jordan-Normalform. Auf einem algebraisch geschlossenen Feld hat jede Matrix A eine Jordan-Normalform und erlaubt daher eine Basis von verallgemeinerten Eigenvektoren und eine Zerlegung in verallgemeinerte Eigenräume. ⓘ

Variierende Charakterisierung

Im hermiteschen Fall können die Eigenwerte durch Variationen charakterisiert werden. Der größte Eigenwert von ist der Maximalwert der quadratischen Form . Ein Wert von der dieses Maximum verwirklicht, ist ein Eigenvektor. ⓘ

Matrix-Beispiele

Beispiel einer zweidimensionalen Matrix

Betrachten Sie die Matrix

Die Abbildung rechts zeigt die Wirkung dieser Transformation auf Punktkoordinaten in der Ebene. Die Eigenvektoren v dieser Transformation erfüllen Gleichung (1), und die Werte von λ, für die die Determinante der Matrix (A - λI) gleich Null ist, sind die Eigenwerte. ⓘ

Man nimmt die Determinante, um das charakteristische Polynom von A zu finden,

Setzt man das charakteristische Polynom gleich Null, so hat es Wurzeln bei λ=1 und λ=3, was die beiden Eigenwerte von A sind. ⓘ

Für λ=1 ergibt sich Gleichung (2),

Jeder Nicht-Null-Vektor mit v1 = -v2 löst diese Gleichung. Daher

Für λ=3 wird Gleichung (2) zu

Jeder von Null verschiedene Vektor mit v1 = v2 löst diese Gleichung. Daher

ist ein Eigenvektor von A, der λ = 3 entspricht, ebenso wie jedes skalare Vielfache dieses Vektors. ⓘ

Die Vektoren vλ=1 und vλ=3 sind also Eigenvektoren von A, die mit den Eigenwerten λ=1 bzw. λ=3 verbunden sind. ⓘ

Beispiel einer dreidimensionalen Matrix

Betrachten Sie die Matrix

Das charakteristische Polynom von A ist

Die Wurzeln des charakteristischen Polynoms sind 2, 1 und 11, also die einzigen drei Eigenwerte von A. Diese Eigenwerte entsprechen den Eigenvektoren , , und oder beliebigen Vielfachen davon, die nicht Null sind. ⓘ

Beispiel einer dreidimensionalen Matrix mit komplexen Eigenwerten

Betrachten wir die zyklische Permutationsmatrix

Diese Matrix verschiebt die Koordinaten des Vektors um eine Position nach oben und verschiebt die erste Koordinate nach unten. Ihr charakteristisches Polynom ist 1 - λ3, dessen Wurzeln sind

wobei ist eine imaginäre Einheit mit . ⓘ

Für den reellen Eigenwert λ1 = 1 ist jeder Vektor mit drei gleichen Einträgen ungleich Null ein Eigenvektor. Zum Beispiel,

Für das konjugiert-komplexe Paar der imaginären Eigenwerte,

Dann

und

Daher sind die beiden anderen Eigenvektoren von A komplex und lauten und mit den Eigenwerten λ2 bzw. λ3. Die beiden komplexen Eigenvektoren erscheinen auch in einem komplex konjugierten Paar,

Beispiel für eine Diagonalmatrix

Matrizen mit Einträgen nur entlang der Hauptdiagonalen werden Diagonalmatrizen genannt. Die Eigenwerte einer Diagonalmatrix sind die Diagonalelemente selbst. Betrachten wir die Matrix

Das charakteristische Polynom von A ist

die die Wurzeln λ1 = 1, λ2 = 2 und λ3 = 3 hat. Diese Wurzeln sind sowohl die Diagonalelemente als auch die Eigenwerte von A. ⓘ

Jedes Diagonalelement entspricht einem Eigenvektor, dessen einzige Komponente, die nicht Null ist, in der gleichen Zeile wie das Diagonalelement liegt. In diesem Beispiel entsprechen die Eigenwerte den Eigenvektoren,

sowie die skalaren Vielfachen dieser Vektoren. ⓘ

Beispiel einer Dreiecksmatrix

Eine Matrix, deren Elemente oberhalb der Hauptdiagonalen alle null sind, wird als untere Dreiecksmatrix bezeichnet, während eine Matrix, deren Elemente unterhalb der Hauptdiagonalen alle null sind, als obere Dreiecksmatrix bezeichnet wird. Wie bei Diagonalmatrizen sind die Eigenwerte von Dreiecksmatrizen die Elemente der Hauptdiagonale. ⓘ

Betrachten wir die untere Dreiecksmatrix,

Das charakteristische Polynom von A ist

die die Wurzeln λ1 = 1, λ2 = 2 und λ3 = 3 hat. Diese Wurzeln sind sowohl die Diagonalelemente als auch die Eigenwerte von A. ⓘ

Diese Eigenwerte entsprechen den Eigenvektoren,

sowie die skalaren Vielfachen dieser Vektoren. ⓘ

Beispiel für eine Matrix mit wiederholten Eigenwerten

Wie im vorherigen Beispiel ist die untere Dreiecksmatrix

hat ein charakteristisches Polynom, das das Produkt seiner Diagonalelemente ist,

Die Wurzeln dieses Polynoms, und damit die Eigenwerte, sind 2 und 3. Die algebraische Vielfachheit jedes Eigenwerts ist 2, d. h. es sind beides Doppelwurzeln. Die Summe der algebraischen Vielfachheiten aller verschiedenen Eigenwerte ist μA = 4 = n, die Ordnung des charakteristischen Polynoms und die Dimension von A. ⓘ

Die geometrische Vielfachheit des Eigenwerts 2 ist dagegen nur 1, weil sein Eigenraum von nur einem Vektor aufgespannt wird aufgespannt und ist daher 1-dimensional. In ähnlicher Weise ist die geometrische Multiplizität des Eigenwerts 3 gleich 1, weil sein Eigenraum von nur einem Vektor aufgespannt wird . Die geometrische Gesamtmultiplizität γA beträgt 2 und ist damit die kleinste, die für eine Matrix mit zwei verschiedenen Eigenwerten möglich ist. Geometrische Multiplizitäten werden in einem späteren Abschnitt definiert. ⓘ

Eigenvektor-Eigenwert-Identität

Für eine hermitesche Matrix kann die quadrierte Norm der j-ten Komponente eines normalisierten Eigenvektors nur mit den Eigenwerten der Matrix und den Eigenwerten der entsprechenden Nebenmatrix berechnet werden,

Eigenwerte und Eigenfunktionen von Differentialoperatoren

Die Definitionen von Eigenwert und Eigenvektoren einer linearen Transformation T bleiben auch dann gültig, wenn der zugrunde liegende Vektorraum ein unendlich-dimensionaler Hilbert- oder Banach-Raum ist. Eine weit verbreitete Klasse von linearen Transformationen, die auf unendlich-dimensionale Räume wirken, sind die Differentialoperatoren auf Funktionsräumen. Sei D ein linearer Differentialoperator auf dem Raum C∞ der unendlich differenzierbaren reellen Funktionen mit einem reellen Argument t. Die Eigenwertgleichung für D ist die Differentialgleichung

Die Funktionen, die diese Gleichung erfüllen, sind Eigenvektoren von D und werden gemeinhin als Eigenfunktionen bezeichnet. ⓘ

Ableitungsoperator-Beispiel

Betrachten wir den Ableitungsoperator mit der Eigenwertgleichung

Diese Differentialgleichung kann durch Multiplikation beider Seiten mit dt/f(t) und Integration gelöst werden. Ihre Lösung, die Exponentialfunktion

ist die Eigenfunktion des Ableitungsoperators. In diesem Fall ist die Eigenfunktion selbst eine Funktion des zugehörigen Eigenwerts. Insbesondere für λ = 0 ist die Eigenfunktion f(t) eine Konstante. ⓘ

Der Hauptartikel über Eigenfunktionen enthält weitere Beispiele. ⓘ

Allgemeine Definition

Das Konzept der Eigenwerte und Eigenvektoren lässt sich natürlich auf beliebige lineare Transformationen auf beliebigen Vektorräumen anwenden. V sei ein beliebiger Vektorraum über einem Skalarfeld K, und T sei eine lineare Transformation, die V auf V abbildet,

Wir sagen, dass ein Vektor v ∈ V ungleich Null ein Eigenvektor von T ist, wenn und nur wenn es einen Skalar λ ∈ K gibt, so dass

-

(5) ⓘ

Diese Gleichung wird als Eigenwertgleichung für T bezeichnet, und der Skalar λ ist der Eigenwert von T, der dem Eigenvektor v entspricht. T(v) ist das Ergebnis der Anwendung der Transformation T auf den Vektor v, während λv das Produkt des Skalars λ mit v ist. ⓘ

Eigenräume, geometrische Mannigfaltigkeit und die Eigenbasis

Betrachten wir für einen Eigenwert λ die Menge

die die Vereinigung des Nullvektors mit der Menge aller mit λ assoziierten Eigenvektoren ist. E wird der mit λ assoziierte Eigenraum von T genannt. ⓘ

Nach der Definition einer linearen Transformation,

für x, y ∈ V und α ∈ K. Wenn also u und v Eigenvektoren von T sind, die mit dem Eigenwert λ verbunden sind, nämlich u, v ∈ E, dann

Sowohl u + v als auch αv sind also entweder Null oder Eigenvektoren von T, die mit λ assoziiert sind, nämlich u + v, αv ∈ E, und E ist geschlossen unter Addition und Skalarmultiplikation. Der mit λ assoziierte Eigenraum E ist also ein linearer Unterraum von V. Wenn dieser Unterraum die Dimension 1 hat, wird er manchmal als Eigenlinie bezeichnet. ⓘ

Die geometrische Multiplizität γT(λ) eines Eigenwerts λ ist die Dimension des zu λ gehörenden Eigenraums, d. h. die maximale Anzahl linear unabhängiger Eigenvektoren, die zu diesem Eigenwert gehören. Nach der Definition von Eigenwerten und Eigenvektoren ist γT(λ) ≥ 1, weil zu jedem Eigenwert mindestens ein Eigenvektor gehört. ⓘ

Die Eigenräume von T bilden immer eine direkte Summe. Folglich sind die Eigenvektoren verschiedener Eigenwerte immer linear unabhängig. Daher kann die Summe der Dimensionen der Eigenräume die Dimension n des Vektorraums, auf dem T operiert, nicht überschreiten, und es kann nicht mehr als n verschiedene Eigenwerte geben. ⓘ

Jeder Unterraum, der von Eigenvektoren von T aufgespannt wird, ist ein invarianter Unterraum von T, und die Einschränkung von T auf einen solchen Unterraum ist diagonalisierbar. Wenn der gesamte Vektorraum V von den Eigenvektoren von T aufgespannt werden kann oder wenn die direkte Summe der Eigenräume, die mit allen Eigenwerten von T assoziiert sind, der gesamte Vektorraum V ist, dann kann eine Basis von V, die Eigenbasis, aus linear unabhängigen Eigenvektoren von T gebildet werden. Wenn T eine Eigenbasis zulässt, ist T diagonalisierbar. ⓘ

Spektraltheorie

In der Funktionalanalysis betrachtet man lineare Abbildungen zwischen linearen Funktionenräumen (also lineare Abbildungen zwischen unendlichdimensionalen Vektorräumen). Meistens spricht man von linearen Operatoren anstatt von linearen Abbildungen. Sei ein Vektorraum über einem Körper mit und ein linearer Operator. In der Funktionalanalysis ordnet man ein Spektrum zu. Dieses besteht aus allen für die der Operator nicht invertierbar ist. Dieses Spektrum muss jedoch nicht – wie bei Abbildungen zwischen endlichdimensionalen Vektorräumen – diskret sein. Denn im Gegensatz zu den linearen Abbildungen zwischen endlichdimensionalen Vektorräumen, die nur verschiedene Eigenwerte haben, haben lineare Operatoren im Allgemeinen unendlich viele Elemente im Spektrum. Daher ist es zum Beispiel möglich, dass das Spektrum von linearen Operatoren Häufungspunkte besitzt. Um die Untersuchung des Operators und des Spektrums zu vereinfachen, unterteilt man das Spektrum in unterschiedliche Teilspektren. Elemente, die die Gleichung für ein lösen, nennt man wie in der linearen Algebra Eigenwerte. Die Gesamtheit der Eigenwerte nennt man das Punktspektrum von Wie in der linearen Algebra wird jedem Eigenwert ein Raum von Eigenvektoren zugeordnet. Da die Eigenvektoren meist als Funktionen aufgefasst werden, spricht man auch von Eigenfunktionen. ⓘ

Wenn λ ein Eigenwert von T ist, dann ist der Operator (T - λI) nicht eineindeutig, und daher gibt es seine Inverse (T - λI)-1 nicht. Die Umkehrung gilt für endlich-dimensionale Vektorräume, aber nicht für unendlich-dimensionale Vektorräume. Im Allgemeinen kann der Operator (T - λI) keine Inverse haben, selbst wenn λ kein Eigenwert ist. ⓘ

Assoziative Algebren und Darstellungstheorie

Man kann das algebraische Objekt, das auf den Vektorraum wirkt, verallgemeinern, indem man einen einzelnen Operator, der auf einen Vektorraum wirkt, durch eine Algebra-Darstellung ersetzt - eine assoziative Algebra, die auf ein Modul wirkt. Die Untersuchung solcher Aktionen ist das Gebiet der Darstellungstheorie. ⓘ

Das abbildungstheoretische Konzept des Gewichts ist ein Analogon der Eigenwerte, während Gewichtsvektoren und Gewichtsräume die Analoga von Eigenvektoren bzw. Eigenräumen sind. ⓘ

Dynamische Gleichungen

Die einfachsten Differenzengleichungen haben die Form

Die Lösung dieser Gleichung für x in Abhängigkeit von t ergibt sich aus ihrer charakteristischen Gleichung

die durch Stapeln einer Reihe von Gleichungen in Matrixform gefunden werden kann, die aus der obigen Differenzgleichung und den k - 1 Gleichungen besteht was ein k-dimensionales System erster Ordnung im gestapelten Variablenvektor ergibt in Bezug auf seinen einmal verzögerten Wert und die charakteristische Gleichung der Matrix dieses Systems. Diese Gleichung ergibt k charakteristische Wurzeln zur Verwendung in der Lösungsgleichung

Ein ähnliches Verfahren wird zur Lösung einer Differentialgleichung der Form

Berechnung

Die Berechnung von Eigenwerten und Eigenvektoren ist ein Thema, bei dem die Theorie, wie sie in elementaren Lehrbüchern der linearen Algebra dargestellt wird, oft sehr weit von der Praxis entfernt ist. ⓘ

Klassisches Verfahren

Die klassische Methode besteht darin, zunächst die Eigenwerte zu bestimmen und dann die Eigenvektoren für jeden Eigenwert zu berechnen. Sie ist in mehrfacher Hinsicht schlecht geeignet für nicht exakte Arithmetik, wie z. B. Fließkommazahlen. ⓘ

Eigenwerte

Die Eigenwerte einer Matrix können bestimmt werden, indem man die Wurzeln des charakteristischen Polynoms findet. Dies ist einfach für Matrizen einfach, aber die Schwierigkeit steigt schnell mit der Größe der Matrix. ⓘ

Theoretisch können die Koeffizienten des charakteristischen Polynoms genau berechnet werden, da sie Summen von Produkten von Matrixelementen sind; und es gibt Algorithmen, die alle Wurzeln eines Polynoms beliebigen Grades mit beliebiger Genauigkeit finden können. Dieser Ansatz ist jedoch in der Praxis nicht praktikabel, da die Koeffizienten durch unvermeidliche Rundungsfehler verunreinigt würden und die Wurzeln eines Polynoms eine extrem empfindliche Funktion der Koeffizienten sein können (wie das Wilkinson-Polynom zeigt). Selbst für Matrizen, deren Elemente ganze Zahlen sind, wird die Berechnung nicht trivial, weil die Summen sehr lang sind; der konstante Term ist die Determinante, die für eine eine Summe von verschiedenen Produkten ist. ⓘ

Explizite algebraische Formeln für die Wurzeln eines Polynoms gibt es nur, wenn der Grad 4 oder weniger ist. Nach dem Abel-Ruffini-Theorem gibt es keine allgemeine, explizite und exakte algebraische Formel für die Wurzeln eines Polynoms mit Grad 5 oder mehr. (Die Allgemeinheit ist wichtig, weil jedes Polynom mit Grad ist das charakteristische Polynom einer Begleitmatrix der Ordnung .) Daher können für Matrizen der Ordnung 5 oder mehr die Eigenwerte und Eigenvektoren nicht durch eine explizite algebraische Formel erhalten werden und müssen daher durch numerische Näherungsmethoden berechnet werden. Selbst die exakte Formel für die Wurzeln eines Polynoms vom Grad 3 ist numerisch unpraktisch. ⓘ

Eigenvektoren

Sobald der (exakte) Wert eines Eigenwerts bekannt ist, können die entsprechenden Eigenvektoren gefunden werden, indem man Lösungen der Eigenwertgleichung findet, die nicht Null sind, d. h. ein System von linearen Gleichungen mit bekannten Koeffizienten. Wenn zum Beispiel bekannt ist, dass 6 ein Eigenwert der Matrix

kann man die Eigenvektoren der Matrix durch Lösen der folgenden Gleichung ermitteln , d.h.

Diese Matrixgleichung ist äquivalent zu zwei linearen Gleichungen

Beide Gleichungen reduzieren sich auf die einzige lineare Gleichung . Daher kann jeder Vektor der Form für jede reelle Zahl ungleich Null ein Eigenvektor von mit dem Eigenwert . ⓘ

Die Matrix hat einen weiteren Eigenwert . Eine ähnliche Berechnung zeigt, dass die entsprechenden Eigenvektoren die Lösungen ungleich Null sind von sind, d.h. jeder Vektor der Form für jede reelle Zahl ungleich Null . ⓘ

Einfache iterative Methoden

Der umgekehrte Ansatz, zunächst die Eigenvektoren zu suchen und dann jeden Eigenwert aus seinem Eigenvektor zu bestimmen, erweist sich für Computer als weitaus praktikabler. Der einfachste Algorithmus besteht darin, einen beliebigen Startvektor zu wählen und ihn dann wiederholt mit der Matrix zu multiplizieren (optional kann der Vektor normalisiert werden, damit seine Elemente eine vernünftige Größe haben); dadurch konvergiert der Vektor gegen einen Eigenvektor. Eine Variante ist, den Vektor stattdessen zu multiplizieren mit zu multiplizieren; dadurch konvergiert der Vektor zu einem Eigenvektor des Eigenwerts, der am nächsten zu . ⓘ

Wenn (eine gute Annäherung an) einen Eigenvektor von ist, dann kann der entsprechende Eigenwert berechnet werden als

wobei bezeichnet die konjugierte Transponierung von . ⓘ

Moderne Methoden

Während die exakte Berechnung der Nullstellen des charakteristischen Polynoms schon für dreireihige Matrizen nicht so einfach ist, wird sie für große Matrizen meist unmöglich, sodass man sich dann auf das Bestimmen von Näherungswerten beschränkt. Hierzu werden Verfahren bevorzugt, die sich durch numerische Stabilität und geringen Rechenaufwand auszeichnen. Dazu gehören Methoden für dichtbesetzte kleine bis mittlere Matrizen, wie

- der QR-Algorithmus,

- der QZ-Algorithmus,

- der QS-Algorithmus und

- die Deflation

sowie spezielle Methoden für symmetrische Matrizen als auch Methoden für dünnbesetzte große Matrizen wie

- die Potenzmethode,

- die inverse Iteration,

- das Lanczos-Verfahren,

- die Unterraumiteration,

- das Arnoldi-Verfahren,

- das Jacobi-Verfahren und

- das Jacobi-Davidson-Verfahren.

Des Weiteren gibt es noch Methoden zur Abschätzung, z. B. mithilfe

- der Matrixnorm und

- der Gerschgorin-Kreise,

die immer eine grobe Abschätzung (unter gewissen Bedingungen sogar genaue Bestimmung) zulassen.

- Die Folded Spectrum Method liefert mit jedem Durchlauf einen Eigenvektor, der jedoch auch aus der Mitte des Spektrums stammen kann. ⓘ

Die meisten numerischen Methoden, die die Eigenwerte einer Matrix berechnen, bestimmen auch eine Reihe von entsprechenden Eigenvektoren als Nebenprodukt der Berechnung, obwohl sich manche Implementierer dafür entscheiden, die Eigenvektorinformationen zu verwerfen, sobald sie nicht mehr benötigt werden. ⓘ

Anwendungen

Durch Lösung eines Eigenwertproblems berechnet man

- Eigenfrequenzen, Eigenformen und gegebenenfalls auch die Dämpfungscharakteristik eines schwingungsfähigen Systems,

- die Knicklast eines Knickstabs (siehe Balkentheorie),

- das Beulversagen (eine Art des Materialversagens durch unzureichende Steifigkeit) eines leeren Rohres unter Außendruck,

- die Hauptkomponenten einer Punktmenge (z. B. zur Kompression von Bildern oder zur Bestimmung von Faktoren in der Psychologie: Hauptkomponentenanalyse),

- die Hauptspannungen in der Festigkeitslehre (Umrechnung der Spannungen in ein Koordinatensystem, in dem es keine Schubspannungen gibt),

- die Hauptstreckungen in der Festigkeitslehre als Eigenwerte der Deformationstensoren,

- die Hauptträgheitsachsen eines asymmetrischen Querschnitts (um einen Balken – Träger oder Ähnliches – in diesen beiden Richtungen unabhängig voneinander zu berechnen),

- vielfältige andere technische Problemstellungen, die mit der jeweils spezifisch definierten Stabilität eines Systems zu tun haben,

- den PageRank einer Homepage als Eigenvektor der Google-Matrix, dort gewertet als ein Maß für die relative Wichtigkeit einer Homepage im Internet,

- die Grenzverteilungen von Markow-Ketten mit diskretem Zustandsraum und diskreten Zeitschritten, die durch eine stochastische Matrix beschrieben werden (die Linkseigenvektoren zum Eigenwert 1 sind die stationären Verteilungen, die Rechtseigenvektoren zum Eigenwert 1 sind die Absorptionswahrscheinlichkeiten),

- die Drehachse und damit die Fixpunkte, von denen der Satz vom Fußball spricht.

Eigenwerte spielen in der Quantenmechanik eine besondere Rolle. Physikalische Größen wie z. B. der Drehimpuls werden hier durch Operatoren repräsentiert. Messbar sind nur die Eigenwerte der Operatoren. Hat z. B. der Hamiltonoperator, der die Energie eines quantenmechanischen Systems repräsentiert, ein diskretes Spektrum, so kann die Energie nur diskrete Werte annehmen, was z. B. für die Energieniveaus in einem Atom typisch ist. So stellen bei den Lösungen der bekannten Schrödingergleichung (im Jahr 1926 durch den Physiker Erwin Schrödinger aufgestellt) die Eigenwerte die erlaubten Energiewerte der Elektronen und die Eigenfunktionen die zugehörigen Wellenfunktionen der Elektronen dar. ⓘ

Auch die Unmöglichkeit der gleichzeitigen präzisen Messung gewisser Größen (z. B. von Ort und Impuls), wie von der Heisenbergschen Unschärferelation ausgedrückt, ist letztlich darauf zurückzuführen, dass für die jeweiligen Operatoren kein gemeinsames System von Eigenvektoren existiert. ⓘ

Eigenwerte von geometrischen Transformationen

In der folgenden Tabelle sind einige Beispieltransformationen in der Ebene zusammen mit ihren 2×2-Matrizen, Eigenwerten und Eigenvektoren aufgeführt. ⓘ

| Skalierung | Ungleiche Skalierung | Drehung | Horizontale Scherung | Hyperbolische Drehung | |

|---|---|---|---|---|---|

| Abbildung |

|

|

|

| |

| Matrix | |||||

| Charakteristisch Polynom |

|||||

| Eigenwerte, | |||||

| Algebraische Mult, |

|||||

| Geometrische Mult., |

|||||

| Eigenvektoren | Alle Vektoren ungleich Null |

Die charakteristische Gleichung für eine Drehung ist eine quadratische Gleichung mit der Diskriminante was immer dann eine negative Zahl ist, wenn θ nicht ein ganzzahliges Vielfaches von 180° ist. Abgesehen von diesen Sonderfällen sind die beiden Eigenwerte also komplexe Zahlen, ; und alle Eigenvektoren haben nicht-reelle Einträge. Abgesehen von diesen Sonderfällen ändert eine Drehung die Richtung jedes Vektors, der nicht Null ist, in der Ebene. ⓘ

Eine lineare Transformation, die ein Quadrat in ein Rechteck mit der gleichen Fläche überführt (eine Squeeze-Mapping), hat reziproke Eigenwerte. ⓘ

Schrödinger-Gleichung

Ein Beispiel für eine Eigenwertgleichung, bei der die Transformation in Form eines Differentialoperators dargestellt wird, ist die zeitunabhängige Schrödinger-Gleichung in der Quantenmechanik:

wobei der Hamilton-Operator, ist ein Differentialoperator zweiter Ordnung und , die Wellenfunktion, ist eine ihrer Eigenfunktionen, die dem Eigenwert entspricht, der als seine Energie interpretiert wird. ⓘ

Interessiert man sich jedoch nur für die Lösungen der Schrödinger-Gleichung im Grenzzustand, so sucht man im Raum der quadratisch integrablen Funktionen. Da dieser Raum ein Hilbert-Raum mit einem wohldefinierten Skalarprodukt ist, kann man eine Basismenge einführen, in der und als eindimensionales Array (d.h. ein Vektor) bzw. eine Matrix dargestellt werden kann. Auf diese Weise kann man die Schrödingergleichung in Matrixform darstellen. ⓘ

In diesem Zusammenhang wird häufig die Bra-Ket-Schreibweise verwendet. Ein Vektor, der einen Zustand des Systems darstellt, wird im Hilbert-Raum der quadratisch integrierbaren Funktionen wie folgt dargestellt . In dieser Notation lautet die Schrödinger-Gleichung:

wobei ist ein Eigenzustand von und stellt den Eigenwert dar. ist ein beobachtbarer selbstadjungierter Operator, das unendlich-dimensionale Analogon der Hermitschen Matrizen. Wie im Fall der Matrizen gilt in der obigen Gleichung der Vektor, den man durch Anwendung der Transformation auf erhält. . ⓘ

Wellentransport

Licht, akustische Wellen und Mikrowellen werden beim Durchlaufen eines statischen ungeordneten Systems zahlreiche Male zufällig gestreut. Auch wenn die Wellen durch die Mehrfachstreuung wiederholt zufällig gestreut werden, ist der kohärente Wellentransport durch das System letztlich ein deterministischer Prozess, der durch eine Feldübertragungsmatrix beschrieben werden kann . Die Eigenvektoren des Übertragungsoperators bilden eine Reihe von unordnungsspezifischen Eingangswellenfronten, die es den Wellen ermöglichen, in die Eigenkanäle des ungeordneten Systems einzukoppeln: die unabhängigen Wege, die Wellen durch das System zurücklegen können. Die Eigenwerte, von entsprechen dem mit jedem Eigenkanal verbundenen Intensitätsdurchlassgrad. Eine der bemerkenswerten Eigenschaften des Transmissionsoperators von Diffusionssystemen ist ihre bimodale Eigenwertverteilung mit und . Eine weitere bemerkenswerte Eigenschaft offener Eigenkanäle, die über die perfekte Durchlässigkeit hinausgeht, ist das statistisch robuste räumliche Profil der Eigenkanäle. ⓘ

Molekulare Orbitale

In der Quantenmechanik, insbesondere in der Atom- und Molekülphysik, können die Atom- und Molekülorbitale im Rahmen der Hartree-Fock-Theorie durch die Eigenvektoren des Fock-Operators definiert werden. Die entsprechenden Eigenwerte werden über das Koopmans'sche Theorem als Ionisierungspotentiale interpretiert. In diesem Fall wird der Begriff Eigenvektor in einer etwas allgemeineren Bedeutung verwendet, da der Fock-Operator ausdrücklich von den Orbitalen und ihren Eigenwerten abhängig ist. Will man diesen Aspekt hervorheben, so spricht man von nichtlinearen Eigenwertproblemen. Solche Gleichungen werden in der Regel durch ein Iterationsverfahren gelöst, in diesem Fall als selbstkonsistente Feldmethode bezeichnet. In der Quantenchemie stellt man die Hartree-Fock-Gleichung häufig in einem nicht-orthogonalen Basissatz dar. Diese spezielle Darstellung ist ein verallgemeinertes Eigenwertproblem, das als Roothaan-Gleichung bezeichnet wird. ⓘ

Geologie und Glaziologie

In der Geologie, insbesondere bei der Untersuchung von Gletscherschutt, werden Eigenvektoren und Eigenwerte als Methode verwendet, mit der eine Vielzahl von Informationen über die Ausrichtung und Neigung der Bestandteile eines Gesteins in einem dreidimensionalen Raum durch sechs Zahlen zusammengefasst werden kann. In der Praxis kann ein Geologe solche Daten für Hunderte oder Tausende von Klasten in einer Bodenprobe sammeln, die nur grafisch verglichen werden können, z. B. in einem Tri-Plot-Diagramm (Sneed und Folk) oder als Stereonetz in einem Wulff-Netz. ⓘ

Die Ausgabe des Orientierungstensors erfolgt in den drei orthogonalen (senkrechten) Achsen des Raums. Die drei Eigenvektoren sind geordnet nach ihren Eigenwerten ; ist dann die primäre Orientierung/Neigung des Schotters, ist die sekundäre und ist die tertiäre Orientierung, bezogen auf die Festigkeit. Die Orientierung des Schotters ist definiert als die Richtung des Eigenvektors auf einer Windrose von 360°. Die Neigung wird als Eigenwert, dem Modul des Tensors, gemessen: dieser reicht von 0° (keine Neigung) bis 90° (senkrecht). Die relativen Werte von , und werden durch die Beschaffenheit des Sedimentes bestimmt. Wenn ist, wird das Gewebe als isotrop bezeichnet. Wenn wird das Gewebe als planar bezeichnet. Wenn wird das Gewebe als linear bezeichnet. ⓘ

Prinzipielle Komponentenanalyse

Die Eigenwertzerlegung einer symmetrischen positiv semidefiniten (PSD) Matrix ergibt eine orthogonale Basis von Eigenvektoren, von denen jeder einen nichtnegativen Eigenwert hat. Die orthogonale Zerlegung einer PSD-Matrix wird in der multivariaten Analyse verwendet, bei der die Kovarianzmatrizen der Stichproben PSD sind. Diese orthogonale Zerlegung wird in der Statistik als Hauptkomponentenanalyse (PCA) bezeichnet. Die PCA untersucht die linearen Beziehungen zwischen den Variablen. Die PCA wird mit der Kovarianzmatrix oder der Korrelationsmatrix durchgeführt (wobei jede Variable so skaliert wird, dass ihre Stichprobenvarianz gleich eins ist). Bei der Kovarianz- oder Korrelationsmatrix entsprechen die Eigenvektoren den Hauptkomponenten und die Eigenwerte der durch die Hauptkomponenten erklärten Varianz. Die Hauptkomponentenanalyse der Korrelationsmatrix liefert eine orthogonale Basis für den Raum der beobachteten Daten: In dieser Basis entsprechen die größten Eigenwerte den Hauptkomponenten, die mit dem größten Teil der Kovarianz zwischen einer Reihe von Beobachtungsdaten verbunden sind. ⓘ

Die Hauptkomponentenanalyse wird als Mittel zur Dimensionalitätsreduktion bei der Untersuchung großer Datensätze, wie sie in der Bioinformatik vorkommen, eingesetzt. In der Q-Methodik bestimmen die Eigenwerte der Korrelationsmatrix die Beurteilung der praktischen Signifikanz durch den Q-Methodiker (die sich von der statistischen Signifikanz der Hypothesentests unterscheidet; vgl. Kriterien zur Bestimmung der Anzahl der Faktoren). Ganz allgemein kann die Hauptkomponentenanalyse als Methode der Faktorenanalyse in der Strukturgleichungsmodellierung verwendet werden. ⓘ

Schwingungsanalyse

Eigenwertprobleme treten bei der Schwingungsanalyse von mechanischen Strukturen mit vielen Freiheitsgraden auf. Die Eigenwerte sind die Eigenfrequenzen der Schwingung, und die Eigenvektoren sind die Formen dieser Schwingungsmoden. Die ungedämpfte Schwingung wird insbesondere bestimmt durch

oder

d. h., die Beschleunigung ist proportional zur Position (d. h., wir erwarten in der Zeit sinusförmig ist). ⓘ

In Dimensionen, wird zu einer Massenmatrix und eine Steifigkeitsmatrix. Zulässige Lösungen sind dann eine Linearkombination von Lösungen des verallgemeinerten Eigenwertproblems

wobei ist der Eigenwert und ist die (imaginäre) Winkelfrequenz. Die Hauptschwingungsformen unterscheiden sich von den Hauptnachgiebigkeitsformen, die die Eigenvektoren von allein sind. Außerdem wird die gedämpfte Schwingung, die durch

zu einem sogenannten quadratischen Eigenwertproblem,

Dieses kann durch algebraische Manipulationen auf ein verallgemeinertes Eigenwertproblem reduziert werden, was allerdings die Lösung eines größeren Systems erfordert. ⓘ

Die Orthogonalitätseigenschaften der Eigenvektoren ermöglichen die Entkopplung der Differentialgleichungen, so dass das System als lineare Summation der Eigenvektoren dargestellt werden kann. Das Eigenwertproblem komplexer Strukturen wird häufig mit Hilfe der Finite-Elemente-Analyse gelöst, doch lässt sich die Lösung auf skalarwertige Schwingungsprobleme verallgemeinern. ⓘ

Eigenflächen

In der Bildverarbeitung können verarbeitete Bilder von Gesichtern als Vektoren betrachtet werden, deren Komponenten die Helligkeiten der einzelnen Pixel sind. Die Dimension dieses Vektorraums ist die Anzahl der Pixel. Die Eigenvektoren der Kovarianzmatrix, die mit einer großen Menge normalisierter Bilder von Gesichtern assoziiert sind, werden Eigenflächen genannt; dies ist ein Beispiel für die Hauptkomponentenanalyse. Sie sind sehr nützlich, um ein beliebiges Gesichtsbild als lineare Kombination einiger dieser Komponenten darzustellen. Im Bereich der Gesichtserkennung in der Biometrie bieten Eigengesichter eine Möglichkeit zur Datenkomprimierung von Gesichtern zu Identifikationszwecken. Es wurden auch Forschungsarbeiten zu Eigenbildsystemen zur Bestimmung von Handgesten durchgeführt. ⓘ

Ähnlich wie bei diesem Konzept stellen Eigenstimmen die allgemeine Richtung der Variabilität in der menschlichen Aussprache einer bestimmten Äußerung, z. B. eines Wortes in einer Sprache, dar. Auf der Grundlage einer linearen Kombination solcher Eigenstimmen kann eine neue Sprachaussprache des Wortes konstruiert werden. Diese Konzepte haben sich in automatischen Spracherkennungssystemen für die Sprecheranpassung als nützlich erwiesen. ⓘ

Tensor des Trägheitsmoments

In der Mechanik definieren die Eigenvektoren des Trägheitsmomententensors die Hauptachsen eines starren Körpers. Der Trägheitsmomententensor ist eine Schlüsselgröße, die zur Bestimmung der Rotation eines starren Körpers um seinen Massenschwerpunkt benötigt wird. ⓘ

Spannungstensor

In der Festkörpermechanik ist der Spannungstensor symmetrisch und kann daher in einen Diagonaltensor mit den Eigenwerten auf der Diagonalen und Eigenvektoren als Basis zerlegt werden. Da er diagonal ist, hat der Spannungstensor in dieser Ausrichtung keine Scherkomponenten; die Komponenten, die er hat, sind die Hauptkomponenten. ⓘ

Graphen

In der Spektraltheorie der Graphen ist ein Eigenwert eines Graphen definiert als Eigenwert der Adjazenzmatrix des Graphen oder (zunehmend) der Laplace-Matrix des Graphen aufgrund seines diskreten Laplace-Operators, der entweder (manchmal auch kombinatorischer Laplace-Operator genannt) oder (manchmal als normalisierte Laplace-Matrix bezeichnet), wobei eine Diagonalmatrix ist mit gleich dem Grad des Vertex ist, und in ist der Diagonaleintrag ist . Der Haupteigenvektor eines Graphen ist entweder als der Eigenvektor definiert, der dem th größten oder kleinsten Eigenwert des Laplacian entspricht. Der erste Haupteigenvektor des Graphen wird auch einfach als Haupteigenvektor bezeichnet. ⓘ

Der Haupteigenvektor wird verwendet, um die Zentralität der Eckpunkte zu messen. Ein Beispiel dafür ist der PageRank-Algorithmus von Google. Der Haupteigenvektor einer modifizierten Adjazenzmatrix des World-Wide-Web-Graphen gibt die Seitenränge als seine Komponenten an. Dieser Vektor entspricht der stationären Verteilung der Markov-Kette, die durch die zeilennormierte Adjazenzmatrix dargestellt wird; allerdings muss die Adjazenzmatrix zunächst modifiziert werden, um sicherzustellen, dass eine stationäre Verteilung existiert. Der zweitkleinste Eigenvektor kann zur Partitionierung des Graphen in Cluster durch spektrales Clustering verwendet werden. Für das Clustering stehen auch andere Methoden zur Verfügung. ⓘ

Grundlegende Reproduktionszahl

Die Basisreproduktionszahl () ist eine grundlegende Zahl bei der Untersuchung der Ausbreitung von Infektionskrankheiten. Setzt man eine infektiöse Person in eine Population vollständig empfänglicher Personen, so ist die durchschnittliche Anzahl der Personen, die eine typische infektiöse Person infizieren wird. Die Generationszeit einer Infektion ist die Zeit, von der Ansteckung einer Person bis zur Ansteckung der nächsten Person. In einer heterogenen Population definiert die Matrix der nächsten Generation, wie viele Personen in der Population nach Ablauf der Zeit infiziert werden. verstrichen ist. ist dann der größte Eigenwert der nächsten Generationsmatrix. ⓘ

![{\displaystyle \left[{\begin{smallmatrix}2&1\\1&2\end{smallmatrix}}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/838a30dc9d065ec434dff490bd84061ed569db3b)

![{\displaystyle {\begin{aligned}|A-\lambda I|&=\left|{\begin{bmatrix}2&1\\1&2\end{bmatrix}}-\lambda {\begin{bmatrix}1&0\\0&1\end{bmatrix}}\right|={\begin{vmatrix}2-\lambda &1\\1&2-\lambda \end{vmatrix}}\\[6pt]&=3-4\lambda +\lambda ^{2}\\[6pt]&=(\lambda -3)(\lambda -1).\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0084c80ab8c7637830cdf01f1c754f92a6598ac0)

![{\displaystyle {\begin{aligned}|A-\lambda I|&=\left|{\begin{bmatrix}2&0&0\\0&3&4\\0&4&9\end{bmatrix}}-\lambda {\begin{bmatrix}1&0&0\\0&1&0\\0&0&1\end{bmatrix}}\right|={\begin{vmatrix}2-\lambda &0&0\\0&3-\lambda &4\\0&4&9-\lambda \end{vmatrix}},\\[6pt]&=(2-\lambda ){\bigl [}(3-\lambda )(9-\lambda )-16{\bigr ]}=-\lambda ^{3}+14\lambda ^{2}-35\lambda +22.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/30165fb86a7e23644d2e3373a1c2c68af4756523)