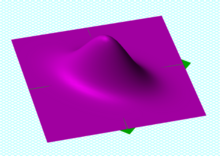

Eine bivariate Gaußsche Wahrscheinlichkeitsdichtefunktion, zentriert bei (0, 0), mit einer Kovarianzmatrix, gegeben durch

ⓘ

ⓘ

Stichprobenpunkte aus einer bivariaten Gauß-Verteilung mit einer Standardabweichung von 3 etwa in der Richtung links unten-rechts oben und von 1 in der orthogonalen Richtung. Da die

x- und

y-Komponenten kovariieren, sind die Varianzen von

und

die Verteilung nicht vollständig beschreiben. A

Kovarianzmatrix erforderlich; die Richtungen der Pfeile entsprechen den Eigenvektoren dieser Kovarianzmatrix und ihre Längen den Quadratwurzeln der Eigenwerte.

ⓘIn der Wahrscheinlichkeitstheorie und Statistik ist eine Kovarianzmatrix (auch Autokovarianzmatrix, Dispersionsmatrix, Varianzmatrix oder Varianz-Kovarianzmatrix genannt) eine quadratische Matrix, die die Kovarianz zwischen jedem Paar von Elementen eines bestimmten Zufallsvektors angibt. Jede Kovarianzmatrix ist symmetrisch und positiv halbdefinit und ihre Hauptdiagonale enthält die Varianzen (d. h. die Kovarianz jedes Elements mit sich selbst). ⓘ

Intuitiv verallgemeinert die Kovarianzmatrix den Begriff der Varianz auf mehrere Dimensionen. So kann beispielsweise die Varianz in einer Sammlung von Zufallspunkten im zweidimensionalen Raum nicht vollständig durch eine einzige Zahl beschrieben werden, und auch die Varianzen in den  und

und  Richtungen alle notwendigen Informationen enthalten; eine

Richtungen alle notwendigen Informationen enthalten; eine  Matrix wäre notwendig, um die zweidimensionale Variation vollständig zu charakterisieren. ⓘ

Matrix wäre notwendig, um die zweidimensionale Variation vollständig zu charakterisieren. ⓘ

Die Kovarianzmatrix eines Zufallsvektors  wird typischerweise bezeichnet durch

wird typischerweise bezeichnet durch  oder

oder  . ⓘ

. ⓘ

Definition

In diesem Artikel werden fettgedruckte, nicht tiefgestellte  und

und  für Zufallsvektoren und nicht fettgedruckte, tiefgestellte

für Zufallsvektoren und nicht fettgedruckte, tiefgestellte  und

und  werden für skalare Zufallsvariablen verwendet. ⓘ

werden für skalare Zufallsvariablen verwendet. ⓘ

Wenn die Einträge in dem Spaltenvektor ⓘ

ⓘ

ⓘ

Zufallsvariablen mit endlicher Varianz und Erwartungswert sind, dann ist die Kovarianzmatrix  diejenige Matrix, deren

diejenige Matrix, deren  Eintrag ist die Kovarianz ⓘ

Eintrag ist die Kovarianz ⓘ

![{\displaystyle \operatorname {K} _{X_{i}X_{j}}=\operatorname {cov} [X_{i},X_{j}]=\operatorname {E} [(X_{i}-\operatorname {E} [X_{i}])(X_{j}-\operatorname {E} [X_{j}])]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/83bec85f5e2cab5d3406677dd806e554a442331f) ⓘ

ⓘ

wobei der Operator  den Erwartungswert (Mittelwert) seines Arguments bezeichnet. ⓘ

den Erwartungswert (Mittelwert) seines Arguments bezeichnet. ⓘ

Widersprüchliche Nomenklaturen und Bezeichnungen

Die Nomenklaturen sind unterschiedlich. Einige Statistiker, die dem Wahrscheinlichkeitsforscher William Feller in seinem zweibändigen Werk An Introduction to Probability Theory and Its Applications folgen, nennen die Matrix  die Varianz des Zufallsvektors

die Varianz des Zufallsvektors  weil sie die natürliche Verallgemeinerung der eindimensionalen Varianz auf höhere Dimensionen ist. Andere nennen sie die Kovarianzmatrix, weil sie die Matrix der Kovarianzen zwischen den skalaren Komponenten des Vektors ist

weil sie die natürliche Verallgemeinerung der eindimensionalen Varianz auf höhere Dimensionen ist. Andere nennen sie die Kovarianzmatrix, weil sie die Matrix der Kovarianzen zwischen den skalaren Komponenten des Vektors ist  .

.

![{\displaystyle \operatorname {var} (\mathbf {X} )=\operatorname {cov} (\mathbf {X} ,\mathbf {X} )=\operatorname {E} \left[(\mathbf {X} -\operatorname {E} [\mathbf {X} ])(\mathbf {X} -\operatorname {E} [\mathbf {X} ])^{\rm {T}}\right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/92051943c03f3ff5b282d8090e65118c40ca400b) ⓘ

ⓘ

Beide Formen sind Standard, und es gibt keine Unklarheiten zwischen ihnen. Die Matrix  wird häufig auch als Varianz-Kovarianz-Matrix bezeichnet, da die diagonalen Terme tatsächlich Varianzen sind. ⓘ

wird häufig auch als Varianz-Kovarianz-Matrix bezeichnet, da die diagonalen Terme tatsächlich Varianzen sind. ⓘ

Zum Vergleich: Die Schreibweise für die Kreuzkovarianzmatrix zwischen zwei Vektoren lautet

![{\displaystyle \operatorname {cov} (\mathbf {X} ,\mathbf {Y} )=\operatorname {K} _{\mathbf {X} \mathbf {Y} }=\operatorname {E} \left[(\mathbf {X} -\operatorname {E} [\mathbf {X} ])(\mathbf {Y} -\operatorname {E} [\mathbf {Y} ])^{\rm {T}}\right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1112b836c2cd9fde4ac076a44dfdbd213395a56b) ⓘ

ⓘ

Eigenschaften

Beziehung zur Autokorrelationsmatrix

Die Autokovarianzmatrix  ist mit der Autokorrelationsmatrix verwandt

ist mit der Autokorrelationsmatrix verwandt  durch

durch

![{\displaystyle \operatorname {K} _{\mathbf {X} \mathbf {X} }=\operatorname {E} [(\mathbf {X} -\operatorname {E} [\mathbf {X} ])(\mathbf {X} -\operatorname {E} [\mathbf {X} ])^{\rm {T}}]=\operatorname {R} _{\mathbf {X} \mathbf {X} }-\operatorname {E} [\mathbf {X} ]\operatorname {E} [\mathbf {X} ]^{\rm {T}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/00175de2c055b834a6f012910f7a5a3d1ed96353)

wobei die Autokorrelationsmatrix definiert ist als ![{\displaystyle \operatorname {R} _{\mathbf {X} \mathbf {X} }=\operatorname {E} [\mathbf {X} \mathbf {X} ^{\rm {T}}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/375369663d22bba80d770f6374289f95dd22cf63) . ⓘ

. ⓘ

Beziehung zur Korrelationsmatrix

Eine eng mit der Kovarianzmatrix verbundene Einheit ist die Matrix der Pearson-Produkt-Moment-Korrelationskoeffizienten zwischen den einzelnen Zufallsvariablen im Zufallsvektor  die wie folgt geschrieben werden kann

die wie folgt geschrieben werden kann

wobei  die Matrix der Diagonalelemente von

die Matrix der Diagonalelemente von  (d. h. eine Diagonalmatrix der Varianzen von

(d. h. eine Diagonalmatrix der Varianzen von  für

für  ). ⓘ

). ⓘ

Äquivalent dazu kann die Korrelationsmatrix als Kovarianzmatrix der standardisierten Zufallsvariablen angesehen werden  für

für  . ⓘ

. ⓘ

![{\displaystyle \operatorname {corr} (\mathbf {X} )={\begin{bmatrix}1&{\frac {\operatorname {E} [(X_{1}-\mu _{1})(X_{2}-\mu _{2})]}{\sigma (X_{1})\sigma (X_{2})}}&\cdots &{\frac {\operatorname {E} [(X_{1}-\mu _{1})(X_{n}-\mu _{n})]}{\sigma (X_{1})\sigma (X_{n})}}\\\\{\frac {\operatorname {E} [(X_{2}-\mu _{2})(X_{1}-\mu _{1})]}{\sigma (X_{2})\sigma (X_{1})}}&1&\cdots &{\frac {\operatorname {E} [(X_{2}-\mu _{2})(X_{n}-\mu _{n})]}{\sigma (X_{2})\sigma (X_{n})}}\\\\\vdots &\vdots &\ddots &\vdots \\\\{\frac {\operatorname {E} [(X_{n}-\mu _{n})(X_{1}-\mu _{1})]}{\sigma (X_{n})\sigma (X_{1})}}&{\frac {\operatorname {E} [(X_{n}-\mu _{n})(X_{2}-\mu _{2})]}{\sigma (X_{n})\sigma (X_{2})}}&\cdots &1\end{bmatrix}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/df091a047aa8a9d829b25f68a5bbe6d56938b146) ⓘ

ⓘ

Jedes Element auf der Hauptdiagonalen einer Korrelationsmatrix ist die Korrelation einer Zufallsvariablen mit sich selbst, die immer gleich 1 ist. Jedes Element der Nebendiagonalen liegt zwischen -1 und +1 einschließlich. ⓘ

Inverse der Kovarianzmatrix

Die Inverse dieser Matrix,  ist, falls vorhanden, die inverse Kovarianzmatrix, auch Konzentrationsmatrix oder Präzisionsmatrix genannt. ⓘ

ist, falls vorhanden, die inverse Kovarianzmatrix, auch Konzentrationsmatrix oder Präzisionsmatrix genannt. ⓘ

Grundlegende Eigenschaften

Für ![{\displaystyle \operatorname {K} _{\mathbf {X} \mathbf {X} }=\operatorname {var} (\mathbf {X} )=\operatorname {E} \left[\left(\mathbf {X} -\operatorname {E} [\mathbf {X} ]\right)\left(\mathbf {X} -\operatorname {E} [\mathbf {X} ]\right)^{\rm {T}}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bed55fb51d1aad5b83b37076bdbd9ad0177a813b) und

und ![{\displaystyle \mathbf {\mu _{X}} =\operatorname {E} [{\textbf {X}}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/25987aa171cbd6ec023a92eb06b6ee750de39309) , wobei

, wobei  eine

eine  -dimensionale Zufallsvariable ist, gelten die folgenden grundlegenden Eigenschaften:

-dimensionale Zufallsvariable ist, gelten die folgenden grundlegenden Eigenschaften:

ist positiv-semidefinit, d.h.

ist positiv-semidefinit, d.h.

ist symmetrisch, d. h.

ist symmetrisch, d. h.

- Für jede konstante (d. h. nicht zufällige)

Matrix

Matrix  und konstanten

und konstanten  Vektor

Vektor  hat man

hat man

- Wenn

ein weiterer Zufallsvektor mit der gleichen Dimension wie

ein weiterer Zufallsvektor mit der gleichen Dimension wie  , dann

, dann  wobei

wobei  die Kreuzkovarianzmatrix von

die Kreuzkovarianzmatrix von  und

und  . ⓘ

. ⓘ

Blockmatrizen

Der gemeinsame Mittelwert  und die gemeinsame Kovarianzmatrix

und die gemeinsame Kovarianzmatrix  von

von  und

und  können in Blockform geschrieben werden ⓘ

können in Blockform geschrieben werden ⓘ

ⓘ

ⓘ

wobei  ,

,  und

und  . ⓘ

. ⓘ

und

und  können als die Varianzmatrizen der Randverteilungen für

können als die Varianzmatrizen der Randverteilungen für  und

und  identifiziert werden. ⓘ

identifiziert werden. ⓘ

Wenn  und

und  gemeinsam normalverteilt sind,

gemeinsam normalverteilt sind,

dann ist die bedingte Verteilung für  gegeben

gegeben  ist gegeben durch

ist gegeben durch

definiert durch den bedingten Mittelwert

ⓘ

ⓘ

und bedingte Varianz

ⓘ

ⓘ

Die Matrix  ist bekannt als die Matrix der Regressionskoeffizienten, während in der linearen Algebra

ist bekannt als die Matrix der Regressionskoeffizienten, während in der linearen Algebra  das Schur-Komplement von

das Schur-Komplement von  in

in  . ⓘ

. ⓘ

Die Matrix der Regressionskoeffizienten kann häufig in transponierter Form angegeben werden,  die sich für die Nachmultiplikation eines Zeilenvektors der erklärenden Variablen

die sich für die Nachmultiplikation eines Zeilenvektors der erklärenden Variablen  anstelle der Vormultiplikation eines Spaltenvektors

anstelle der Vormultiplikation eines Spaltenvektors  . In dieser Form entsprechen sie den Koeffizienten, die man durch Invertierung der Matrix der Normalgleichungen der gewöhnlichen kleinsten Quadrate (OLS) erhält. ⓘ

. In dieser Form entsprechen sie den Koeffizienten, die man durch Invertierung der Matrix der Normalgleichungen der gewöhnlichen kleinsten Quadrate (OLS) erhält. ⓘ

Beziehung zum Erwartungswert des Zufallsvektors

Ist  der Erwartungswertvektor, so lässt sich mit dem Verschiebungssatz von Steiner angewandt auf mehrdimensionale Zufallsvariablen zeigen, dass ⓘ

der Erwartungswertvektor, so lässt sich mit dem Verschiebungssatz von Steiner angewandt auf mehrdimensionale Zufallsvariablen zeigen, dass ⓘ

. ⓘ

. ⓘ

Hierbei sind Erwartungswerte von Vektoren und Matrizen komponentenweise zu verstehen. ⓘ

Ein Zufallsvektor, der einer gegebenen Kovarianzmatrix gehorchen und den Erwartungswert  haben soll, kann wie folgt simuliert werden:

haben soll, kann wie folgt simuliert werden:

zunächst ist die Kovarianzmatrix zu zerlegen (z. B. mit der Cholesky-Zerlegung):

. ⓘ

. ⓘ

Anschließend lässt sich der Zufallsvektor berechnen zu ⓘ

ⓘ

ⓘ

mit einem (anderen) Zufallsvektor  mit voneinander unabhängigen standardnormalverteilten Komponenten. ⓘ

mit voneinander unabhängigen standardnormalverteilten Komponenten. ⓘ

Kovarianzmatrix zweier Vektoren

Die Kovarianzmatrix zweier Vektoren lautet ⓘ

ⓘ

ⓘ

mit dem Erwartungswert  des Zufallsvektors

des Zufallsvektors  und dem Erwartungswert

und dem Erwartungswert  des Zufallsvektors

des Zufallsvektors  . ⓘ

. ⓘ

Kovarianzmatrix in Matrix-Notation

Die Kovarianzmatrix lässt sich in der Matrix-Notation darstellen als ⓘ

, ⓘ

, ⓘ

wobei  die Einsmatrix und

die Einsmatrix und  die Anzahl Dimensionen bezeichnet. ⓘ

die Anzahl Dimensionen bezeichnet. ⓘ

Partielle Kovarianzmatrix

Eine Kovarianzmatrix mit allen Elementen, die nicht Null sind, sagt aus, dass alle einzelnen Zufallsvariablen miteinander verbunden sind. Dies bedeutet, dass die Variablen nicht nur direkt, sondern auch indirekt über andere Variablen korreliert sind. Oft sind solche indirekten, gemeinsamen Korrelationen trivial und uninteressant. Sie können unterdrückt werden, indem man die partielle Kovarianzmatrix berechnet, d. h. den Teil der Kovarianzmatrix, der nur den interessanten Teil der Korrelationen zeigt. ⓘ

Wenn zwei Vektoren von Zufallsvariablen  und

und  über einen anderen Vektor korreliert sind

über einen anderen Vektor korreliert sind  korreliert sind, werden die letzteren Korrelationen in einer Matrix unterdrückt

korreliert sind, werden die letzteren Korrelationen in einer Matrix unterdrückt

Die partielle Kovarianzmatrix  ist effektiv die einfache Kovarianzmatrix

ist effektiv die einfache Kovarianzmatrix  als ob die uninteressanten Zufallsvariablen

als ob die uninteressanten Zufallsvariablen  konstant gehalten würden. ⓘ

konstant gehalten würden. ⓘ

Kovarianzmatrix als Parameter einer Verteilung

Wenn ein Spaltenvektor  von

von  möglicherweise korrelierter Zufallsvariablen gemeinsam normalverteilt oder, allgemeiner, elliptisch verteilt ist, dann kann seine Wahrscheinlichkeitsdichtefunktion

möglicherweise korrelierter Zufallsvariablen gemeinsam normalverteilt oder, allgemeiner, elliptisch verteilt ist, dann kann seine Wahrscheinlichkeitsdichtefunktion  durch die Kovarianzmatrix ausgedrückt werden

durch die Kovarianzmatrix ausgedrückt werden  wie folgt ausgedrückt werden

wie folgt ausgedrückt werden

wobei ![{\displaystyle \mathbf {\mu =\operatorname {E} [X]} }](https://wikimedia.org/api/rest_v1/media/math/render/svg/d9c821aa85a1cbc2edfffb9343c51c7cd3541b34) und

und  ist die Determinante von

ist die Determinante von  . ⓘ

. ⓘ

Kovarianzmatrix als linearer Operator

Auf einen Vektor angewandt, bildet die Kovarianzmatrix eine Linearkombination c der Zufallsvariablen X auf einen Vektor der Kovarianzen mit diesen Variablen ab:  . Als bilineare Form behandelt, ergibt sie die Kovarianz zwischen den beiden Linearkombinationen:

. Als bilineare Form behandelt, ergibt sie die Kovarianz zwischen den beiden Linearkombinationen:  . Die Varianz einer Linearkombination ist dann

. Die Varianz einer Linearkombination ist dann  , ihre Kovarianz mit sich selbst. ⓘ

, ihre Kovarianz mit sich selbst. ⓘ

In ähnlicher Weise liefert die (pseudo-)inverse Kovarianzmatrix ein inneres Produkt  das den Mahalanobis-Abstand induziert, ein Maß für die "Unwahrscheinlichkeit" von c. ⓘ

das den Mahalanobis-Abstand induziert, ein Maß für die "Unwahrscheinlichkeit" von c. ⓘ

Welche Matrizen sind Kovarianzmatrizen?

Ausgehend von der oben genannten Identität, sei  sei ein

sei ein  reellwertiger Vektor, dann ⓘ

reellwertiger Vektor, dann ⓘ

ⓘ

ⓘ

die immer nicht-negativ sein muss, da sie die Varianz einer reellen Zufallsvariablen ist, so dass eine Kovarianzmatrix immer eine positiv-halbfinite Matrix ist. ⓘ

Das obige Argument kann wie folgt erweitert werden:

![{\displaystyle {\begin{aligned}&w^{\rm {T}}\operatorname {E} \left[(\mathbf {X} -\operatorname {E} [\mathbf {X} ])(\mathbf {X} -\operatorname {E} [\mathbf {X} ])^{\rm {T}}\right]w=\operatorname {E} \left[w^{\rm {T}}(\mathbf {X} -\operatorname {E} [\mathbf {X} ])(\mathbf {X} -\operatorname {E} [\mathbf {X} ])^{\rm {T}}w\right]\\&=\operatorname {E} {\big [}{\big (}w^{\rm {T}}(\mathbf {X} -\operatorname {E} [\mathbf {X} ]){\big )}^{2}{\big ]}\geq 0,\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4c9fb5265a1f97a7cc67b23c9942182f63051a73)

wobei die letzte Ungleichung aus der Beobachtung folgt, dass

![{\displaystyle w^{\rm {T}}(\mathbf {X} -\operatorname {E} [\mathbf {X} ])}](https://wikimedia.org/api/rest_v1/media/math/render/svg/127bb7293f5d9738d76b0c9461d4236befd8dccb)

ein Skalar ist.

ⓘ

Umgekehrt ist jede symmetrische positiv-halbdefinite Matrix eine Kovarianzmatrix. Um dies zu sehen, nehmen wir an  eine

eine  symmetrische positiv-halbdefinite Matrix. Aus dem endlich-dimensionalen Fall des Spektralsatzes folgt, dass

symmetrische positiv-halbdefinite Matrix. Aus dem endlich-dimensionalen Fall des Spektralsatzes folgt, dass  eine nichtnegative symmetrische Quadratwurzel hat, die mit M1/2 bezeichnet werden kann. Sei

eine nichtnegative symmetrische Quadratwurzel hat, die mit M1/2 bezeichnet werden kann. Sei  sei eine beliebige

sei eine beliebige  Spaltenvektor-bewertete Zufallsvariable, deren Kovarianzmatrix die

Spaltenvektor-bewertete Zufallsvariable, deren Kovarianzmatrix die  Identitätsmatrix ist. Dann ist ⓘ

Identitätsmatrix ist. Dann ist ⓘ

ⓘ

ⓘ

Komplexe Zufallsvektoren

Die Varianz einer komplexen skalarwertigen Zufallsvariablen mit Erwartungswert  wird üblicherweise durch komplexe Konjugation definiert:

wird üblicherweise durch komplexe Konjugation definiert:

![{\displaystyle \operatorname {var} (Z)=\operatorname {E} \left[(Z-\mu _{Z}){\overline {(Z-\mu _{Z})}}\right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b3a3d7abfa56fdb689ebd3c01388715ad4773d4a) ⓘ

ⓘ

wobei die komplex Konjugierte einer komplexen Zahl  bezeichnet wird mit

bezeichnet wird mit  bezeichnet wird; somit ist die Varianz einer komplexen Zufallsvariablen eine reelle Zahl. ⓘ

bezeichnet wird; somit ist die Varianz einer komplexen Zufallsvariablen eine reelle Zahl. ⓘ

Wenn  ist ein Spaltenvektor komplexwertiger Zufallsvariablen, dann wird die konjugierte Transponierung

ist ein Spaltenvektor komplexwertiger Zufallsvariablen, dann wird die konjugierte Transponierung  wird sowohl durch Transponieren als auch durch Konjugieren gebildet. Im folgenden Ausdruck ergibt das Produkt eines Vektors mit seiner konjugierten Transponierung eine quadratische Matrix, die Kovarianzmatrix, als deren Erwartungswert:

wird sowohl durch Transponieren als auch durch Konjugieren gebildet. Im folgenden Ausdruck ergibt das Produkt eines Vektors mit seiner konjugierten Transponierung eine quadratische Matrix, die Kovarianzmatrix, als deren Erwartungswert:

![{\displaystyle \operatorname {K} _{\mathbf {Z} \mathbf {Z} }=\operatorname {cov} [\mathbf {Z} ,\mathbf {Z} ]=\operatorname {E} \left[(\mathbf {Z} -\mathbf {\mu _{Z}} )(\mathbf {Z} -\mathbf {\mu _{Z}} )^{\mathrm {H} }\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/88c60e556c5e5f705d6448f79339174ec62b1ffd) , ⓘ

, ⓘ

Die so erhaltene Matrix ist hermitesch positiv-halbfinit, mit reellen Zahlen in der Hauptdiagonalen und komplexen Zahlen außerhalb der Diagonalen. ⓘ

- Eigenschaften

- Die Kovarianzmatrix ist eine hermitesche Matrix, d. h.

.

.

- Die Diagonalelemente der Kovarianzmatrix sind reell. ⓘ

Pseudo-Kovarianzmatrix

Für komplexe Zufallsvektoren ist eine andere Art des zweiten zentralen Moments, die Pseudo-Kovarianzmatrix (auch Beziehungsmatrix genannt), wie folgt definiert:

![{\displaystyle \operatorname {J} _{\mathbf {Z} \mathbf {Z} }=\operatorname {cov} [\mathbf {Z} ,{\overline {\mathbf {Z} }}]=\operatorname {E} \left[(\mathbf {Z} -\mathbf {\mu _{Z}} )(\mathbf {Z} -\mathbf {\mu _{Z}} )^{\mathrm {T} }\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bba62bd04d95107abdaa72eb5b505496ad4151ea) ⓘ

ⓘ

Im Gegensatz zur oben definierten Kovarianzmatrix wird in der Definition die Hermitsche Transposition durch die Transposition ersetzt.

Ihre Diagonalelemente können komplexwertig sein; es handelt sich um eine komplexe symmetrische Matrix. ⓘ

Schätzung

Wenn  und

und  sind zentrierte Datenmatrizen der Dimension

sind zentrierte Datenmatrizen der Dimension  und

und  d. h. mit n Spalten von Beobachtungen von p und q Zeilen von Variablen, von denen die Zeilenmittelwerte subtrahiert wurden, dann können, wenn die Zeilenmittelwerte aus den Daten geschätzt wurden, Stichproben-Kovarianzmatrizen

d. h. mit n Spalten von Beobachtungen von p und q Zeilen von Variablen, von denen die Zeilenmittelwerte subtrahiert wurden, dann können, wenn die Zeilenmittelwerte aus den Daten geschätzt wurden, Stichproben-Kovarianzmatrizen  und

und  wie folgt definiert werden

wie folgt definiert werden

oder, wenn die Reihenmittelwerte a priori bekannt sind,

ⓘ

ⓘ

Diese empirischen Stichproben-Kovarianzmatrizen sind die einfachsten und am häufigsten verwendeten Schätzer für die Kovarianzmatrizen, aber es gibt auch andere Schätzer, darunter regularisierte oder Schrumpfungsschätzer, die bessere Eigenschaften haben können. ⓘ

Anwendungen

Die Kovarianzmatrix ist ein nützliches Instrument in vielen verschiedenen Bereichen. Aus ihr lässt sich eine Transformationsmatrix ableiten, die so genannte Weißungstransformation, die es ermöglicht, die Daten vollständig zu dekorrelieren oder, aus einem anderen Blickwinkel betrachtet, eine optimale Basis für die Darstellung der Daten auf kompakte Weise zu finden (siehe Rayleigh-Quotient für einen formalen Beweis und zusätzliche Eigenschaften von Kovarianzmatrizen).

Dies wird als Hauptkomponentenanalyse (PCA) und Karhunen-Loève-Transformation (KL-Transformation) bezeichnet. ⓘ

Die Kovarianzmatrix spielt eine Schlüsselrolle in der Finanzwirtschaft, insbesondere in der Portfoliotheorie und ihrem Trennungssatz für Investmentfonds sowie im Modell zur Bewertung von Kapitalanlagen. Die Matrix der Kovarianzen zwischen den Renditen verschiedener Vermögenswerte wird verwendet, um unter bestimmten Annahmen die relativen Anteile verschiedener Vermögenswerte zu bestimmen, die Anleger im Rahmen einer Diversifizierung halten sollten (in einer normativen Analyse) oder voraussichtlich halten werden (in einer positiven Analyse). ⓘ

Verwendung in der Optimierung

Die Evolutionsstrategie, eine bestimmte Familie von Randomized Search Heuristiken, stützt sich in ihrem Mechanismus im Wesentlichen auf eine Kovarianzmatrix. Der charakteristische Mutationsoperator zieht den Aktualisierungsschritt aus einer multivariaten Normalverteilung unter Verwendung einer evolvierenden Kovarianzmatrix. Es gibt einen formalen Beweis dafür, dass sich die Kovarianzmatrix der Evolutionsstrategie an die Inverse der Hess'schen Matrix der Suchlandschaft anpasst, und zwar bis zu einem skalaren Faktor und kleinen zufälligen Fluktuationen (bewiesen für eine Ein-Eltern-Strategie und ein statisches Modell, wenn die Populationsgröße zunimmt, unter Berufung auf die quadratische Approximation).

Intuitiv wird dieses Ergebnis durch die Überlegung gestützt, dass die optimale Kovarianzverteilung Mutationsschritte anbieten kann, deren Äquidensitätswahrscheinlichkeitskonturen mit den Levelsets der Landschaft übereinstimmen und somit die Fortschrittsrate maximieren. ⓘ

Kovarianzabbildung

Bei der Kovarianzabbildung werden die Werte der  oder

oder  Matrix als 2-dimensionale Karte aufgetragen. Wenn Vektoren

Matrix als 2-dimensionale Karte aufgetragen. Wenn Vektoren  und

und  diskrete Zufallsfunktionen sind, zeigt die Karte statistische Beziehungen zwischen verschiedenen Regionen der Zufallsfunktionen. Statistisch unabhängige Regionen der Funktionen erscheinen auf der Karte als flache Nullebenen, während positive oder negative Korrelationen als Hügel bzw. Täler dargestellt werden. ⓘ

diskrete Zufallsfunktionen sind, zeigt die Karte statistische Beziehungen zwischen verschiedenen Regionen der Zufallsfunktionen. Statistisch unabhängige Regionen der Funktionen erscheinen auf der Karte als flache Nullebenen, während positive oder negative Korrelationen als Hügel bzw. Täler dargestellt werden. ⓘ

In der Praxis werden die Spaltenvektoren  , und

, und  werden experimentell als Reihen von

werden experimentell als Reihen von  Stichproben, z. B.

Stichproben, z. B.

![{\displaystyle [\mathbf {X} _{1},\mathbf {X} _{2},...\mathbf {X} _{n}]={\begin{bmatrix}X_{1}(t_{1})&X_{2}(t_{1})&\cdots &X_{n}(t_{1})\\\\X_{1}(t_{2})&X_{2}(t_{2})&\cdots &X_{n}(t_{2})\\\\\vdots &\vdots &\ddots &\vdots \\\\X_{1}(t_{m})&X_{2}(t_{m})&\cdots &X_{n}(t_{m})\end{bmatrix}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/be824f93648e01daa17bd4e9d99b4398026b0149)

wobei  ist der i-te diskrete Wert in der Stichprobe j der Zufallsfunktion

ist der i-te diskrete Wert in der Stichprobe j der Zufallsfunktion  . Die in der Kovarianzformel benötigten Erwartungswerte werden anhand des Stichprobenmittelwerts geschätzt, z. B.

. Die in der Kovarianzformel benötigten Erwartungswerte werden anhand des Stichprobenmittelwerts geschätzt, z. B.

und die Kovarianzmatrix wird durch die Kovarianzmatrix der Stichprobe geschätzt

wobei die eckigen Klammern wie zuvor die Mittelwertbildung der Stichprobe bezeichnen, mit der Ausnahme, dass die Bessel-Korrektur vorgenommen werden sollte, um Verzerrungen zu vermeiden. Mit dieser Schätzung kann die partielle Kovarianzmatrix wie folgt berechnet werden

wobei der umgekehrte Schrägstrich den linken Matrix-Divisionsoperator bezeichnet, der das Erfordernis, eine Matrix zu invertieren, umgeht und in einigen Berechnungspaketen wie Matlab verfügbar ist. ⓘ

Abbildung 1: Konstruktion einer partiellen Kovarianzkarte von N

2-Molekülen, die eine durch einen Freie-Elektronen-Laser induzierte Coulomb-Explosion durchlaufen. Die Felder a und b bilden die beiden Terme der Kovarianzmatrix ab, die in Feld c dargestellt ist. Feld d bildet die Gleichtaktkorrelationen über Intensitätsschwankungen des Lasers ab. Tafel e zeigt die partielle Kovarianzmatrix, die um die Intensitätsschwankungen korrigiert ist. Tafel f zeigt, dass eine 10%ige Überkorrektur die Abbildung verbessert und Ionen-Ionen-Korrelationen deutlich sichtbar macht. Aufgrund der Impulserhaltung erscheinen diese Korrelationen als Linien, die annähernd senkrecht zur Autokorrelationslinie (und zu den periodischen Modulationen, die durch das Ringing des Detektors verursacht werden) verlau

fen.

ⓘAbb. 1 zeigt, wie eine partielle Kovarianzkarte am Beispiel eines Experiments am Freie-Elektronen-Laser FLASH in Hamburg erstellt wird. Die Zufallsfunktion  ist das Flugzeitspektrum von Ionen aus einer Coulomb-Explosion von Stickstoffmolekülen, die durch einen Laserpuls mehrfach ionisiert wurden. Da bei jedem Laserpuls nur einige hundert Moleküle ionisiert werden, sind die Einzelschussspektren stark schwankend. Das Sammeln typischerweise

ist das Flugzeitspektrum von Ionen aus einer Coulomb-Explosion von Stickstoffmolekülen, die durch einen Laserpuls mehrfach ionisiert wurden. Da bei jedem Laserpuls nur einige hundert Moleküle ionisiert werden, sind die Einzelschussspektren stark schwankend. Das Sammeln typischerweise  solcher Spektren,

solcher Spektren,  und deren Mittelwertbildung über

und deren Mittelwertbildung über  ergibt ein glattes Spektrum

ergibt ein glattes Spektrum  das unten in Abb. 1 in rot dargestellt ist. Das durchschnittliche Spektrum

das unten in Abb. 1 in rot dargestellt ist. Das durchschnittliche Spektrum  zeigt mehrere Stickstoffionen in Form von Peaks, die durch ihre kinetische Energie verbreitert sind, aber um die Korrelationen zwischen den Ionisationsstufen und den Ionenimpulsen zu finden, muss eine Kovarianzkarte berechnet werden. ⓘ

zeigt mehrere Stickstoffionen in Form von Peaks, die durch ihre kinetische Energie verbreitert sind, aber um die Korrelationen zwischen den Ionisationsstufen und den Ionenimpulsen zu finden, muss eine Kovarianzkarte berechnet werden. ⓘ

In dem Beispiel von Abb. 1 sind die Spektren  und

und  die gleichen, nur der Bereich der Flugzeit

die gleichen, nur der Bereich der Flugzeit  unterschiedlich ist. Tafel a zeigt

unterschiedlich ist. Tafel a zeigt  , Tafel b zeigt

, Tafel b zeigt  und Tafel c zeigt ihre Differenz, die

und Tafel c zeigt ihre Differenz, die  (beachten Sie die Änderung der Farbskala). Leider wird diese Karte von uninteressanten Gleichtaktkorrelationen überlagert, die durch die von Schuss zu Schuss schwankende Laserintensität verursacht werden. Um solche Korrelationen zu unterdrücken, wird die Laserintensität

(beachten Sie die Änderung der Farbskala). Leider wird diese Karte von uninteressanten Gleichtaktkorrelationen überlagert, die durch die von Schuss zu Schuss schwankende Laserintensität verursacht werden. Um solche Korrelationen zu unterdrücken, wird die Laserintensität  bei jedem Schuss aufgezeichnet, in

bei jedem Schuss aufgezeichnet, in  und

und  berechnet, wie die Felder d und e zeigen. Die Unterdrückung der uninteressanten Korrelationen ist jedoch unvollkommen, da es neben der Laserintensität noch andere Quellen für Gleichtaktschwankungen gibt, und im Prinzip sollten alle diese Quellen in Vektor

berechnet, wie die Felder d und e zeigen. Die Unterdrückung der uninteressanten Korrelationen ist jedoch unvollkommen, da es neben der Laserintensität noch andere Quellen für Gleichtaktschwankungen gibt, und im Prinzip sollten alle diese Quellen in Vektor  . In der Praxis reicht es jedoch oft aus, die partielle Kovarianzkorrektur zu überkompensieren, wie Tafel f zeigt, wo interessante Korrelationen von Ionenimpulsen nun deutlich als gerade Linien sichtbar sind, die auf Ionisationsstufen von atomarem Stickstoff zentriert sind. ⓘ

. In der Praxis reicht es jedoch oft aus, die partielle Kovarianzkorrektur zu überkompensieren, wie Tafel f zeigt, wo interessante Korrelationen von Ionenimpulsen nun deutlich als gerade Linien sichtbar sind, die auf Ionisationsstufen von atomarem Stickstoff zentriert sind. ⓘ

Zweidimensionale Infrarotspektroskopie

Die zweidimensionale Infrarotspektroskopie nutzt die Korrelationsanalyse, um 2D-Spektren der kondensierten Phase zu erhalten. Es gibt zwei Versionen dieser Analyse: die synchrone und die asynchrone. Mathematisch gesehen wird die erstere durch die Kovarianzmatrix der Probe ausgedrückt, und die Technik ist äquivalent zur Kovarianzabbildung. ⓘ

Stichproben-Kovarianzmatrix

Eine Schätzung der Korrelationsmatrix in der Grundgesamtheit  erhält man, indem man die Varianzen und Kovarianzen in der Grundgesamtheit

erhält man, indem man die Varianzen und Kovarianzen in der Grundgesamtheit  und

und  durch die empirischen Varianzen und empirischen Kovarianzen (ihre empirischen Gegenstücke)

durch die empirischen Varianzen und empirischen Kovarianzen (ihre empirischen Gegenstücke)  und

und  ersetzt (sofern die

ersetzt (sofern die  -Variablen Zufallsvariablen darstellen schätzen die die Parameter in der Grundgesamtheit). Diese sind gegeben durch ⓘ

-Variablen Zufallsvariablen darstellen schätzen die die Parameter in der Grundgesamtheit). Diese sind gegeben durch ⓘ

und

und  . ⓘ

. ⓘ

Dies führt zur Stichproben-Kovarianzmatrix  :

:

. ⓘ

. ⓘ

Zum Beispiel sind  und

und  gegeben durch ⓘ

gegeben durch ⓘ

und

und  , ⓘ

, ⓘ

mit dem arithmetischen Mittel ⓘ

. ⓘ

. ⓘ

Spezielle Kovarianzmatrizen

Kovarianzmatrix des gewöhnlichen Kleinste-Quadrate-Schätzers

Für die Kovarianzmatrix des gewöhnlichen Kleinste-Quadrate-Schätzers

ergibt sich nach den obigen Rechenregeln:

. ⓘ

. ⓘ

Diese Kovarianzmatrix ist unbekannt, da die Varianz der Störgrößen  unbekannt ist. Einen Schätzer für die Kovarianzmatrix

unbekannt ist. Einen Schätzer für die Kovarianzmatrix  erhält man, indem man die unbekannte Störgrößenvarianz

erhält man, indem man die unbekannte Störgrößenvarianz  durch den erwartungstreuen Schätzer der Störgrößenvarianz

durch den erwartungstreuen Schätzer der Störgrößenvarianz  ersetzt (siehe hierzu: Erwartungstreue Schätzung des unbekannten Varianzparameters). ⓘ

ersetzt (siehe hierzu: Erwartungstreue Schätzung des unbekannten Varianzparameters). ⓘ

Kovarianzmatrix bei scheinbar unverbundenen Regressionsgleichungen

Bei scheinbar unverbundenen Regressionsgleichungen (englisch: seemingly unrelated regression equations, kurz SURE) des Modells ⓘ

, ⓘ

, ⓘ

wobei der Fehlerterm  idiosynkratisch ist, ergibt sich die Kovarianzmatrix als ⓘ

idiosynkratisch ist, ergibt sich die Kovarianzmatrix als ⓘ

ⓘ

ⓘ

Beispiel

Bei 10 Datenpunkten seien jeweils die Werte  und

und  gemessen worden:

gemessen worden:

Messwerte ⓘ

|

|

| 1,0 |

1,41

|

| 2,0 |

1,56

|

| 2,0 |

2,19

|

| 4,0 |

2,79

|

| 5,0 |

3,04

|

| 6,0 |

2,23

|

| 9,0 |

3,74

|

| 9,0 |

3,84

|

| 9,0 |

2,80

|

| 13,0 |

4,18

|

Die Berechnung des geschätzten Mittelwertes ergibt:  ,

,  ,

,  ;

;  ,

,  . ⓘ

. ⓘ

Daher ist die Stichprobenkovarianzmatrix  . ⓘ

. ⓘ

In Bezug auf den Mittelpunkt  der Punktwolke kann im Diagramm eine Konzentrationsellipse eingezeichnet werden. Die Punkte auf dem Rand der Ellipse sind also durch folgende Menge gegeben:

der Punktwolke kann im Diagramm eine Konzentrationsellipse eingezeichnet werden. Die Punkte auf dem Rand der Ellipse sind also durch folgende Menge gegeben:

. ⓘ

. ⓘ

![{\displaystyle \operatorname {K} _{X_{i}X_{j}}=\operatorname {cov} [X_{i},X_{j}]=\operatorname {E} [(X_{i}-\operatorname {E} [X_{i}])(X_{j}-\operatorname {E} [X_{j}])]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/83bec85f5e2cab5d3406677dd806e554a442331f)

![{\displaystyle \operatorname {var} (\mathbf {X} )=\operatorname {cov} (\mathbf {X} ,\mathbf {X} )=\operatorname {E} \left[(\mathbf {X} -\operatorname {E} [\mathbf {X} ])(\mathbf {X} -\operatorname {E} [\mathbf {X} ])^{\rm {T}}\right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/92051943c03f3ff5b282d8090e65118c40ca400b)

![{\displaystyle \operatorname {cov} (\mathbf {X} ,\mathbf {Y} )=\operatorname {K} _{\mathbf {X} \mathbf {Y} }=\operatorname {E} \left[(\mathbf {X} -\operatorname {E} [\mathbf {X} ])(\mathbf {Y} -\operatorname {E} [\mathbf {Y} ])^{\rm {T}}\right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1112b836c2cd9fde4ac076a44dfdbd213395a56b)

![{\displaystyle \operatorname {K} _{\mathbf {X} \mathbf {X} }=\operatorname {E} [(\mathbf {X} -\operatorname {E} [\mathbf {X} ])(\mathbf {X} -\operatorname {E} [\mathbf {X} ])^{\rm {T}}]=\operatorname {R} _{\mathbf {X} \mathbf {X} }-\operatorname {E} [\mathbf {X} ]\operatorname {E} [\mathbf {X} ]^{\rm {T}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/00175de2c055b834a6f012910f7a5a3d1ed96353)

![{\displaystyle \operatorname {R} _{\mathbf {X} \mathbf {X} }=\operatorname {E} [\mathbf {X} \mathbf {X} ^{\rm {T}}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/375369663d22bba80d770f6374289f95dd22cf63)

![{\displaystyle \operatorname {corr} (\mathbf {X} )={\begin{bmatrix}1&{\frac {\operatorname {E} [(X_{1}-\mu _{1})(X_{2}-\mu _{2})]}{\sigma (X_{1})\sigma (X_{2})}}&\cdots &{\frac {\operatorname {E} [(X_{1}-\mu _{1})(X_{n}-\mu _{n})]}{\sigma (X_{1})\sigma (X_{n})}}\\\\{\frac {\operatorname {E} [(X_{2}-\mu _{2})(X_{1}-\mu _{1})]}{\sigma (X_{2})\sigma (X_{1})}}&1&\cdots &{\frac {\operatorname {E} [(X_{2}-\mu _{2})(X_{n}-\mu _{n})]}{\sigma (X_{2})\sigma (X_{n})}}\\\\\vdots &\vdots &\ddots &\vdots \\\\{\frac {\operatorname {E} [(X_{n}-\mu _{n})(X_{1}-\mu _{1})]}{\sigma (X_{n})\sigma (X_{1})}}&{\frac {\operatorname {E} [(X_{n}-\mu _{n})(X_{2}-\mu _{2})]}{\sigma (X_{n})\sigma (X_{2})}}&\cdots &1\end{bmatrix}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/df091a047aa8a9d829b25f68a5bbe6d56938b146)

![{\displaystyle \operatorname {K} _{\mathbf {X} \mathbf {X} }=\operatorname {var} (\mathbf {X} )=\operatorname {E} \left[\left(\mathbf {X} -\operatorname {E} [\mathbf {X} ]\right)\left(\mathbf {X} -\operatorname {E} [\mathbf {X} ]\right)^{\rm {T}}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bed55fb51d1aad5b83b37076bdbd9ad0177a813b)

![{\displaystyle \mathbf {\mu _{X}} =\operatorname {E} [{\textbf {X}}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/25987aa171cbd6ec023a92eb06b6ee750de39309)

![{\displaystyle \mathbf {\mu =\operatorname {E} [X]} }](https://wikimedia.org/api/rest_v1/media/math/render/svg/d9c821aa85a1cbc2edfffb9343c51c7cd3541b34)

![{\displaystyle {\begin{aligned}&w^{\rm {T}}\operatorname {E} \left[(\mathbf {X} -\operatorname {E} [\mathbf {X} ])(\mathbf {X} -\operatorname {E} [\mathbf {X} ])^{\rm {T}}\right]w=\operatorname {E} \left[w^{\rm {T}}(\mathbf {X} -\operatorname {E} [\mathbf {X} ])(\mathbf {X} -\operatorname {E} [\mathbf {X} ])^{\rm {T}}w\right]\\&=\operatorname {E} {\big [}{\big (}w^{\rm {T}}(\mathbf {X} -\operatorname {E} [\mathbf {X} ]){\big )}^{2}{\big ]}\geq 0,\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4c9fb5265a1f97a7cc67b23c9942182f63051a73)

![{\displaystyle w^{\rm {T}}(\mathbf {X} -\operatorname {E} [\mathbf {X} ])}](https://wikimedia.org/api/rest_v1/media/math/render/svg/127bb7293f5d9738d76b0c9461d4236befd8dccb)

![{\displaystyle \operatorname {var} (Z)=\operatorname {E} \left[(Z-\mu _{Z}){\overline {(Z-\mu _{Z})}}\right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b3a3d7abfa56fdb689ebd3c01388715ad4773d4a)

![{\displaystyle \operatorname {K} _{\mathbf {Z} \mathbf {Z} }=\operatorname {cov} [\mathbf {Z} ,\mathbf {Z} ]=\operatorname {E} \left[(\mathbf {Z} -\mathbf {\mu _{Z}} )(\mathbf {Z} -\mathbf {\mu _{Z}} )^{\mathrm {H} }\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/88c60e556c5e5f705d6448f79339174ec62b1ffd)

![{\displaystyle \operatorname {J} _{\mathbf {Z} \mathbf {Z} }=\operatorname {cov} [\mathbf {Z} ,{\overline {\mathbf {Z} }}]=\operatorname {E} \left[(\mathbf {Z} -\mathbf {\mu _{Z}} )(\mathbf {Z} -\mathbf {\mu _{Z}} )^{\mathrm {T} }\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bba62bd04d95107abdaa72eb5b505496ad4151ea)

![{\displaystyle [\mathbf {X} _{1},\mathbf {X} _{2},...\mathbf {X} _{n}]={\begin{bmatrix}X_{1}(t_{1})&X_{2}(t_{1})&\cdots &X_{n}(t_{1})\\\\X_{1}(t_{2})&X_{2}(t_{2})&\cdots &X_{n}(t_{2})\\\\\vdots &\vdots &\ddots &\vdots \\\\X_{1}(t_{m})&X_{2}(t_{m})&\cdots &X_{n}(t_{m})\end{bmatrix}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/be824f93648e01daa17bd4e9d99b4398026b0149)