Statistik

| Statistik ⓘ |

|---|

|

|

Die Statistik ist die Disziplin, die sich mit der Sammlung, Organisation, Analyse, Interpretation und Präsentation von Daten beschäftigt. Bei der Anwendung der Statistik auf ein wissenschaftliches, industrielles oder soziales Problem geht man üblicherweise von einer statistischen Population oder einem statistischen Modell aus, das untersucht werden soll. Bei den Populationen kann es sich um verschiedene Gruppen von Menschen oder Objekten handeln, z. B. "alle in einem Land lebenden Menschen" oder "jedes Atom, aus dem ein Kristall besteht". Die Statistik befasst sich mit allen Aspekten von Daten, einschließlich der Planung der Datenerhebung in Form von Umfragen und Experimenten. ⓘ

Wenn keine Volkszählungsdaten erhoben werden können, sammeln Statistiker Daten, indem sie spezielle Versuchspläne und Erhebungsstichproben entwickeln. Repräsentative Stichproben stellen sicher, dass Rückschlüsse und Schlussfolgerungen von der Stichprobe auf die Grundgesamtheit möglich sind. Bei einer experimentellen Studie werden Messungen an dem zu untersuchenden System vorgenommen, das System manipuliert und dann weitere Messungen mit demselben Verfahren durchgeführt, um festzustellen, ob die Manipulation die Messwerte verändert hat. Im Gegensatz dazu werden bei einer Beobachtungsstudie keine experimentellen Manipulationen vorgenommen. ⓘ

Bei der Datenanalyse kommen hauptsächlich zwei statistische Methoden zum Einsatz: die deskriptive Statistik, die Daten aus einer Stichprobe anhand von Indizes wie dem Mittelwert oder der Standardabweichung zusammenfasst, und die inferentielle Statistik, die Schlussfolgerungen aus Daten zieht, die zufälligen Schwankungen unterliegen (z. B. Beobachtungsfehler, Stichprobenschwankungen). Die deskriptive Statistik befasst sich meist mit zwei Gruppen von Eigenschaften einer Verteilung (Stichprobe oder Grundgesamtheit): Die zentrale Tendenz (oder Lage) versucht, den zentralen oder typischen Wert der Verteilung zu charakterisieren, während die Streuung (oder Variabilität) das Ausmaß beschreibt, in dem die Mitglieder der Verteilung von ihrem Zentrum und voneinander abweichen. Rückschlüsse auf die mathematische Statistik werden im Rahmen der Wahrscheinlichkeitstheorie gezogen, die sich mit der Analyse von Zufallsphänomenen befasst. ⓘ

Ein statistisches Standardverfahren umfasst die Sammlung von Daten, die zur Prüfung der Beziehung zwischen zwei statistischen Datensätzen oder einem Datensatz und synthetischen Daten, die aus einem idealisierten Modell abgeleitet werden, führen. Es wird eine Hypothese für die statistische Beziehung zwischen den beiden Datensätzen vorgeschlagen und diese als Alternative zu einer idealisierten Nullhypothese, die besagt, dass es keine Beziehung zwischen zwei Datensätzen gibt, verglichen. Die Ablehnung oder Widerlegung der Nullhypothese erfolgt durch statistische Tests, die quantifizieren, inwieweit die Nullhypothese angesichts der für den Test verwendeten Daten als falsch erwiesen werden kann. Wenn man von einer Nullhypothese ausgeht, werden zwei grundlegende Fehlerformen unterschieden: Fehler vom Typ I (die Nullhypothese wird fälschlicherweise abgelehnt, was zu einem "falsch positiven" Ergebnis führt) und Fehler vom Typ II (die Nullhypothese wird nicht abgelehnt und eine tatsächliche Beziehung zwischen Populationen wird übersehen, was zu einem "falsch negativen" Ergebnis führt). Mit diesem Rahmen werden zahlreiche Probleme in Verbindung gebracht, die von der Beschaffung eines ausreichenden Stichprobenumfangs bis zur Festlegung einer geeigneten Nullhypothese reichen. ⓘ

Auch Messverfahren, die statistische Daten erzeugen, sind fehleranfällig. Viele dieser Fehler werden als zufällig (Rauschen) oder systematisch (Verzerrung) eingestuft, aber auch andere Arten von Fehlern (z. B. Flüchtigkeitsfehler, wenn ein Analyst falsche Einheiten meldet) können auftreten. Das Vorhandensein fehlender Daten oder Zensierung kann zu verzerrten Schätzungen führen, und es wurden spezielle Techniken entwickelt, um diese Probleme zu lösen. ⓘ

Einführung

Die Statistik ist ein mathematischer Wissenschaftszweig, der sich mit der Erhebung, Analyse, Interpretation oder Erklärung und Darstellung von Daten befasst, oder ein Zweig der Mathematik. Manche betrachten die Statistik eher als eine eigenständige mathematische Wissenschaft denn als einen Zweig der Mathematik. Während bei vielen wissenschaftlichen Untersuchungen Daten verwendet werden, befasst sich die Statistik mit der Verwendung von Daten im Kontext von Ungewissheit und der Entscheidungsfindung angesichts von Ungewissheit. ⓘ

Bei der Anwendung der Statistik auf ein Problem ist es üblich, mit einer zu untersuchenden Population oder einem Prozess zu beginnen. Populationen können unterschiedliche Themen sein, wie z. B. "alle in einem Land lebenden Menschen" oder "jedes Atom, aus dem ein Kristall besteht". Im Idealfall stellen Statistiker Daten über die gesamte Bevölkerung zusammen (ein Vorgang, der als Volkszählung bezeichnet wird). Dies kann von staatlichen Statistikämtern organisiert werden. Zur Zusammenfassung der Bevölkerungsdaten können deskriptive Statistiken verwendet werden. Zu den numerischen Deskriptoren gehören Mittelwert und Standardabweichung für kontinuierliche Daten (wie Einkommen), während Häufigkeit und Prozentsatz für die Beschreibung kategorischer Daten (wie Bildung) nützlicher sind. ⓘ

Wenn eine Volkszählung nicht durchführbar ist, wird eine ausgewählte Teilmenge der Bevölkerung, eine so genannte Stichprobe, untersucht. Sobald eine für die Grundgesamtheit repräsentative Stichprobe bestimmt ist, werden Daten für die Stichprobenmitglieder in einem Beobachtungs- oder Versuchsrahmen erhoben. Auch hier kann die deskriptive Statistik zur Zusammenfassung der Stichprobendaten verwendet werden. Die Ziehung der Stichprobe enthält jedoch ein Zufallselement; daher sind auch die numerischen Deskriptoren der Stichprobe mit Unsicherheit behaftet. Um aussagekräftige Schlussfolgerungen über die gesamte Grundgesamtheit zu ziehen, wird die Inferenzstatistik benötigt. Sie nutzt Muster in den Stichprobendaten, um unter Berücksichtigung des Zufalls Rückschlüsse auf die repräsentierte Grundgesamtheit zu ziehen. Diese Rückschlüsse können in Form von Ja/Nein-Fragen zu den Daten (Hypothesentests), der Schätzung numerischer Merkmale der Daten (Schätzung), der Beschreibung von Zusammenhängen innerhalb der Daten (Korrelation) und der Modellierung von Beziehungen innerhalb der Daten (z. B. mithilfe der Regressionsanalyse) erfolgen. Schlussfolgerungen können sich auch auf Vorhersagen, Prognosen und Schätzungen von unbeobachteten Werten in der untersuchten Population oder in Verbindung mit dieser erstrecken. Sie kann auch die Extrapolation und Interpolation von Zeitreihen oder räumlichen Daten sowie Data Mining umfassen. ⓘ

Mathematische Statistik

Mathematische Statistik ist die Anwendung der Mathematik auf die Statistik. Zu den dabei verwendeten mathematischen Techniken gehören mathematische Analyse, lineare Algebra, stochastische Analyse, Differentialgleichungen und maßtheoretische Wahrscheinlichkeitstheorie. ⓘ

Geschichte

Die ersten Schriften über statistische Schlussfolgerungen stammen von arabischen Mathematikern und Kryptographen während des islamischen Goldenen Zeitalters zwischen dem 8. und 13. Jahrhundert. Al-Khalil (717-786) schrieb das Buch der kryptografischen Nachrichten, das die erste Verwendung von Permutationen und Kombinationen enthält, um alle möglichen arabischen Wörter mit und ohne Vokale aufzulisten. In seinem Buch Manuscript on Deciphering Cryptographic Messages (Manuskript über die Entschlüsselung kryptografischer Nachrichten) beschrieb Al-Kindi detailliert, wie man die Frequenzanalyse zur Entschlüsselung verschlüsselter Nachrichten einsetzt. Al-Kindi machte auch den frühesten bekannten Gebrauch von statistischen Schlussfolgerungen, während er und spätere arabische Kryptographen die ersten statistischen Methoden zur Entschlüsselung verschlüsselter Nachrichten entwickelten. Ibn Adlan (1187-1268) leistete später einen wichtigen Beitrag über die Verwendung des Stichprobenumfangs bei der Häufigkeitsanalyse. ⓘ

Die frühesten europäischen Schriften zur Statistik stammen aus dem Jahr 1663, als John Graunt sein Buch Natural and Political Observations upon the Bills of Mortality veröffentlichte. Frühe Anwendungen des statistischen Denkens drehten sich um den Bedarf der Staaten, ihre Politik auf demografische und wirtschaftliche Daten zu stützen, daher die Etymologie stat-. Zu Beginn des 19. Jahrhunderts weitete sich der Bereich der Statistik auf die Sammlung und Analyse von Daten im Allgemeinen aus. Heute wird die Statistik in vielen Bereichen der Verwaltung, der Wirtschaft sowie der Natur- und Sozialwissenschaften eingesetzt. ⓘ

Die mathematischen Grundlagen der modernen Statistik wurden im 17. Jahrhundert mit der Entwicklung der Wahrscheinlichkeitsrechnung durch Gerolamo Cardano, Blaise Pascal und Pierre de Fermat gelegt. Die mathematische Wahrscheinlichkeitstheorie entstand aus der Untersuchung von Glücksspielen, obwohl das Konzept der Wahrscheinlichkeit bereits im mittelalterlichen Recht und von Philosophen wie Juan Caramuel untersucht wurde. Die Methode der kleinsten Quadrate wurde erstmals von Adrien-Marie Legendre im Jahr 1805 beschrieben. ⓘ

Die moderne Statistik entstand Ende des 19. und Anfang des 20. Jahrhunderts in drei Phasen. Die erste Welle um die Jahrhundertwende wurde von Francis Galton und Karl Pearson angeführt, die die Statistik in eine strenge mathematische Disziplin verwandelten, die nicht nur in der Wissenschaft, sondern auch in der Industrie und der Politik zur Analyse eingesetzt wird. Zu Galtons Beiträgen gehörten die Einführung der Konzepte der Standardabweichung, der Korrelation und der Regressionsanalyse sowie die Anwendung dieser Methoden auf die Untersuchung einer Vielzahl menschlicher Merkmale - unter anderem Größe, Gewicht und Wimpernlänge. Pearson entwickelte unter anderem den Pearson-Produkt-Moment-Korrelationskoeffizienten, der als Produkt-Moment definiert ist, die Methode der Momente für die Anpassung von Verteilungen an Stichproben und die Pearson-Verteilung. Galton und Pearson gründeten Biometrika als erste Zeitschrift für mathematische Statistik und Biostatistik (damals noch Biometrie genannt), und letzterer gründete die weltweit erste universitäre Statistikabteilung am University College London. ⓘ

Ronald Fisher prägte während des Lady-Tasting-Tee-Experiments den Begriff der Nullhypothese, die "im Verlauf eines Experiments niemals bewiesen oder festgestellt, aber möglicherweise widerlegt wird". ⓘ

Die zweite Welle der 1910er und 20er Jahre wurde von William Sealy Gosset eingeleitet und erreichte ihren Höhepunkt in den Erkenntnissen von Ronald Fisher, der die Lehrbücher verfasste, die die akademische Disziplin an Universitäten in aller Welt definieren sollten. Fishers wichtigste Veröffentlichungen waren seine 1918 erschienene bahnbrechende Arbeit The Correlation between Relatives on the Supposition of Mendelian Inheritance (in der er erstmals den statistischen Begriff Varianz verwendete), sein klassisches Werk Statistical Methods for Research Workers von 1925 und sein 1935 erschienenes The Design of Experiments, in dem er strenge Modelle für die Versuchsplanung entwickelte. Er entwickelte die Konzepte der Suffizienz, der Hilfsstatistik, des linearen Diskriminators von Fisher und der Fisher-Information. In seinem 1930 erschienenen Buch The Genetical Theory of Natural Selection (Die genetische Theorie der natürlichen Selektion) wandte er die Statistik auf verschiedene biologische Konzepte an, wie z. B. das Fisher-Prinzip (das A. W. F. Edwards als "das wohl berühmteste Argument in der Evolutionsbiologie" bezeichnete) und den Fisher'schen Runaway-Effekt, ein Konzept der sexuellen Selektion, bei dem es sich um einen positiven Rückkopplungseffekt handelt, der sich in der Evolution zeigt. ⓘ

Die letzte Welle, in der vor allem frühere Entwicklungen verfeinert und erweitert wurden, geht auf die gemeinsame Arbeit von Egon Pearson und Jerzy Neyman in den 1930er Jahren zurück. Sie führten die Konzepte des "Typ II"-Fehlers, der Teststärke und der Konfidenzintervalle ein. Jerzy Neyman zeigte 1934, dass geschichtete Zufallsstichproben im Allgemeinen eine bessere Schätzmethode sind als gezielte (Quoten-)Stichproben. ⓘ

Heutzutage werden statistische Methoden in allen Bereichen angewandt, in denen es um die Entscheidungsfindung geht, um genaue Schlussfolgerungen aus einer gesammelten Datenmenge zu ziehen und um Entscheidungen angesichts von Unsicherheiten auf der Grundlage statistischer Methoden zu treffen. Der Einsatz moderner Computer hat umfangreiche statistische Berechnungen beschleunigt und auch neue Methoden ermöglicht, die manuell nicht durchführbar sind. Die Statistik ist nach wie vor ein aktiver Forschungsbereich, der sich beispielsweise mit dem Problem der Analyse von Big Data befasst. ⓘ

Die moderne Statistik entstand aus verschiedenen historischen (datenanalytischen) Entwicklungen, die im Laufe des 19. und 20. Jahrhunderts zu der heutigen Statistik zusammengewachsen sind. Insbesondere die Teilung der Statistik in eine deskriptive und eine schließende Statistik spiegelt diese historische Entwicklung wider. ⓘ

Amtliche Statistik

Die Anfänge der amtlichen Statistik reichen bis weit vor Christi Geburt zurück. Die ersten amtlichen Statistiken waren Volkszählungen (vermutlich erstmals in Ägypten zirka 2700 v. Chr., während der Xia-Dynastie zirka 2000 v. Chr., in der Stadt Mari in Mesopotamien zirka 1700 v. Chr.). Im alten Griechenland gab es zumindest in Athen Bürgerregister, Register zur Bevölkerungsbewegung, Einfuhrlisten zollpflichtiger Waren (wie Importe von Getreide) und Vermögenskataster. Bei römischen Volkszählungen wurden die Bürger und ihr Vermögen erfasst. ⓘ

In Deutschland fand die erste Volkszählung 1449 in Nürnberg statt. Die Stadtverwaltung wollte die Bevölkerung und Vorräte erfassen, um zu entscheiden, ob man Flüchtlinge aus dem Markgrafenkrieg noch in die Stadt lassen konnte oder nicht. Den Anfang mit umfangreichen (amtlichen) statistischen Erhebungen machte der französische Staatsmann Colbert 1665 mit der Einrichtung einer Handelsstatistik. ⓘ

In Preußen wurden seit 1683 auf Anordnung des Kurfürsten Friedrich Wilhelm Bevölkerungsstatistiken (Geburten, Eheschließungen und Todesfälle) erstellt und im Lauf der Zeit erweitert: 1719 der Hausbestand und Kommunalfinanzen, 1778 der Viehbestand, Aussaat, Getreidepreise, Flachs- und Tabakanbau, Fabriken, Hütten- und Bergwerke, Schifffahrt und Handel. Andere deutsche Staaten und Städte zogen nach, so Bayern im Jahre 1771 mit der Dachsbergschen Volksbeschreibung. Seit der Errichtung des Statistischen Amtes des Deutschen Reiches 1872 wird in Deutschland eine gesamte amtliche Statistik geführt. Auch in Österreich wurde 1753 durch Maria Theresia eine erste Volkszählung durchgeführt. ⓘ

Um 1870 existierten in den meisten großen Staaten in Europa moderne statistische Behörden. Auf den Konferenzen des Statistischen Kongresses (1853–1878) wurden Qualitätsnormen formuliert, derer sich die meisten Staaten bedienten. ⓘ

Im Gegensatz zu heutigen Ergebnissen der amtlichen Statistik wurden die erstellten Statistiken nicht veröffentlicht und galten als Staatsgeheimnisse. ⓘ

Universitätsstatistik

Unabhängig von der amtlichen Statistik hat sich die sogenannte Universitätsstatistik, ein inzwischen kaum mehr geläufiger Begriff für die beschreibende Staats- und Länderkunde, entwickelt. Das Sammelwerk des Italieners Sansovino (1562) ist eine erste Auflistung der Regierungsformen von zwanzig Staaten. Ähnliche Werke entstanden unter anderem von dem Italiener Botero (1589), dem Franzosen d'Avitys (1616) und dem Niederländer de Laet (1624–1640). Der Hauptvertreter der Universitätsstatistik in Deutschland war der Statistiker Achenwall. ⓘ

Die amtliche Statistik diente der Verwaltung und der Unterstützung von Regierungs- oder Verwaltungsentscheidungen. Die Universitätsstatistik sollte mehr eine allgemeine Informationsquelle für Staatsmänner sein und enthielt anfangs nur textuelle Beschreibungen. Dazu gehörten Regierungsform, Gesetzesbestimmungen und Einzeltatsachen, eben „Staatsmerkwürdigkeiten“ im Sinne von des Merkens würdig. Erst später kamen tabellarische Aufstellungen hinzu, wie bei Büsching. Die Universitätsstatistiker haben jedoch selbst keine Erhebungen durchgeführt, sondern durch den Zugang zu den amtlichen Statistiken diese bearbeitet und veröffentlicht. ⓘ

Das 19. Jahrhundert brachte Verfeinerungen der Beobachtungspraktiken, ihre institutionelle Verstetigung und die Idee der Objektivierung. Am Ende des 19. Jahrhunderts fand der Begriff der „Population“ vermehrt Anwendung. Bis 1890 lag eine voll ausgebildete mathematisierte Statistik vor. Adolphe Quetelet ergründete seit der Mitte des Jahrhunderts gesellschaftliches Zahlenmaterial nach Durchschnitten, Korrelationen und Gesetzmäßigkeiten und erfand den „Statistischen Durchschnittsbürger“ (l'homme moyen). ⓘ

Politische Arithmetik

Erst die politischen Arithmetiker begannen, nach Gesetzmäßigkeiten in den Daten zu forschen. Dies hatte ihren Ursprung in den populärer werdenden Tontinen, einer Art Rentenversicherung. Der Engländer Graunt analysierte 1660 Geburts- und Sterbelisten und wollte allgemeine Gesetzmäßigkeiten über das Geschlechterverhältnis, das Verhältnis von Sterbe- und Geburtsfällen, Sterbehäufigkeiten finden. Der englische Statistiker und Ökonom Petty übertrug diese Art von Analyse auf Wirtschaftsdaten. Der Hauptvertreter der politischen Arithmetiker in Deutschland ist der Statistiker Süßmilch mit seinem Werk Die Göttliche Ordnung in den Verhältnissen des menschlichen Geschlechts, aus der Geburt, dem Tode und der Fortpflanzung desselben erwiesen von 1741. ⓘ

Diese Art von Statistiken hatte auch Einfluss auf philosophische Fragen, beispielsweise zur Existenz des freien Willens des Individuums. Quetelet stellte fest, dass die Zahl der Eheschließungen in belgischen Städten geringere Abweichungen vom Durchschnitt zeigt als die Zahl der Todesfälle. Und das, obwohl der Zeitpunkt der Eheschließung dem freien Willen unterliegt und der Todeszeitpunkt (in der Regel) nicht. ⓘ

Wahrscheinlichkeitsrechnung

Aus Betrachtungen von Glücksspielen entstand die moderne Wahrscheinlichkeitsrechnung. Als Geburtsstunde der Wahrscheinlichkeitsrechnung gilt der Briefwechsel zwischen Pascal und Fermat im Jahr 1654. Das Fundament der modernen Wahrscheinlichkeitsrechnung wurde mit dem Erscheinen von Kolmogorovs Lehrbuch Grundbegriffe der Wahrscheinlichkeitsrechnung im Jahr 1933 abgeschlossen. ⓘ

Statistische Daten

Datenerhebung

Stichprobenziehung

Wenn keine vollständigen Erhebungsdaten gesammelt werden können, erheben Statistiker Stichprobendaten, indem sie spezielle Versuchspläne und Erhebungsstichproben entwickeln. Die Statistik selbst bietet auch Instrumente für Vorhersagen und Prognosen durch statistische Modelle. ⓘ

Um eine Stichprobe als Richtschnur für eine gesamte Population zu verwenden, ist es wichtig, dass sie die Gesamtpopulation wirklich repräsentiert. Repräsentative Stichproben stellen sicher, dass Rückschlüsse und Schlussfolgerungen von der Stichprobe auf die Gesamtpopulation gezogen werden können. Ein großes Problem besteht darin, festzustellen, inwieweit die ausgewählte Stichprobe tatsächlich repräsentativ ist. Die Statistik bietet Methoden zur Schätzung und Korrektur von Verzerrungen innerhalb der Stichprobe und der Datenerhebungsverfahren. Es gibt auch Methoden für die Versuchsplanung von Experimenten, die diese Probleme bereits zu Beginn einer Studie verringern und die Fähigkeit der Studie, Wahrheiten über die Grundgesamtheit zu erkennen, verbessern können. ⓘ

Die Stichprobentheorie ist Teil der mathematischen Disziplin der Wahrscheinlichkeitsrechnung. Die Wahrscheinlichkeitstheorie wird in der mathematischen Statistik verwendet, um die Stichprobenverteilungen von Stichprobenstatistiken und, allgemeiner, die Eigenschaften statistischer Verfahren zu untersuchen. Jede statistische Methode ist gültig, wenn das betrachtete System oder die betrachtete Population die Annahmen der Methode erfüllt. Der Unterschied zwischen der klassischen Wahrscheinlichkeitstheorie und der Stichprobentheorie besteht grob gesagt darin, dass die Wahrscheinlichkeitstheorie von den gegebenen Parametern einer Grundgesamtheit ausgeht, um Wahrscheinlichkeiten abzuleiten, die sich auf Stichproben beziehen. Die statistische Inferenz hingegen geht in die entgegengesetzte Richtung, indem sie induktiv von Stichproben auf die Parameter einer größeren oder gesamten Population schließt. ⓘ

Experimentelle und beobachtende Studien

Ein häufiges Ziel eines statistischen Forschungsprojekts ist die Untersuchung der Kausalität und insbesondere die Schlussfolgerung über die Auswirkungen von Änderungen der Werte von Prädiktoren oder unabhängigen Variablen auf abhängige Variablen. Es gibt zwei Hauptarten von statistischen Kausalstudien: experimentelle Studien und Beobachtungsstudien. Bei beiden Arten von Studien werden die Auswirkungen von Unterschieden zwischen einer unabhängigen Variablen (oder mehreren Variablen) auf das Verhalten der abhängigen Variablen beobachtet. Der Unterschied zwischen den beiden Arten liegt in der Art und Weise, wie die Studie tatsächlich durchgeführt wird. Beide können sehr effektiv sein. Bei einer experimentellen Studie werden Messungen an dem zu untersuchenden System vorgenommen, das System manipuliert und dann weitere Messungen mit demselben Verfahren durchgeführt, um festzustellen, ob die Manipulation die Messwerte verändert hat. Im Gegensatz dazu werden bei einer Beobachtungsstudie keine experimentellen Eingriffe vorgenommen. Stattdessen werden Daten gesammelt und Korrelationen zwischen Prädiktoren und Reaktion untersucht. Die Instrumente der Datenanalyse eignen sich zwar am besten für Daten aus randomisierten Studien, werden aber auch auf andere Arten von Daten angewandt, wie z. B. natürliche Experimente und Beobachtungsstudien, für die ein Statistiker eine modifizierte, stärker strukturierte Schätzmethode (z. B. Differenz-in-Differenzen-Schätzung und Instrumentalvariablen, neben vielen anderen) verwendet, die konsistente Schätzer liefert. ⓘ

In der Planungsphase (oder auch Definitionsphase) müssen die Forschungsfragen (Problem- und Zielstellung der Untersuchung und ihre theoretische Begründung) klar festgelegt werden. Zur Beantwortung muss folgendes entschieden werden:

- Wie wird die Grundgesamtheit definiert,

- an welchen statistischen Einheiten soll gemessen werden,

- welche Variablen sollen erhoben werden,

- welche Operationalisierungen sollen vorgenommen werden,

- welche Art und welchen Umfang soll die Erhebung haben.

Eine statistische Untersuchung ist selten eine unmittelbare Abfolge der fünf Schritte, sondern meist ein ständiger Wechsel zwischen den verschiedenen Phasen in Abhängigkeit von den Daten, Analyseergebnissen und theoretischen Überlegungen. Ein wichtiges Teilgebiet ist das statistische experimentelle Design, das üblicherweise auch eine sog. Fallzahlplanung (z. B. bei klinischen Studien) enthält. Sind diese Fallzahlen zu gering, so kann es vorkommen, dass die Studie zu wenig Power besitzt, um den Zusammenhang zu zeigen. Grundsätzlich ist zu sagen, dass Studien mit höheren Fallzahlen auch mehr Power besitzen. Mithilfe von statistischen Verfahren ist es möglich bei der Anwendung eines t-Tests (dieser prüft, ob sich zwei Mittelwerte einer Stichprobe statistisch signifikant voneinander unterscheiden) die Fallzahl genau zu berechnen. ⓘ

Experimente

Die grundlegenden Schritte eines statistischen Experiments sind:

- Planung der Untersuchung, einschließlich der Ermittlung der Anzahl der Wiederholungen der Studie, unter Verwendung folgender Informationen: vorläufige Schätzungen zur Größe der Behandlungseffekte, Alternativhypothesen und die geschätzte experimentelle Variabilität. Überlegungen zur Auswahl der Versuchspersonen und zur Forschungsethik sind notwendig. Statistiker empfehlen, in den Experimenten (mindestens) eine neue Behandlung mit einer Standardbehandlung oder Kontrolle zu vergleichen, um eine unverzerrte Schätzung des Unterschieds in den Behandlungseffekten zu ermöglichen.

- Versuchsplanung mit Blocking, um den Einfluss von Störvariablen zu verringern, und randomisierte Zuordnung der Behandlungen zu den Probanden, um unverzerrte Schätzungen der Behandlungseffekte und des Versuchsfehlers zu ermöglichen. In dieser Phase erstellen die Experimentatoren und Statistiker das Versuchsprotokoll, das die Durchführung des Experiments leitet und die primäre Analyse der experimentellen Daten festlegt.

- Durchführung des Experiments gemäß dem Versuchsprotokoll und Analyse der Daten gemäß dem Versuchsprotokoll.

- Weitere Untersuchung des Datensatzes in Sekundäranalysen, um neue Hypothesen für zukünftige Studien vorzuschlagen.

- Dokumentieren und Präsentieren der Ergebnisse der Studie. ⓘ

Experimente über menschliches Verhalten sind von besonderer Bedeutung. Die berühmte Hawthorne-Studie untersuchte Veränderungen in der Arbeitsumgebung im Hawthorne-Werk der Western Electric Company. Die Forscher wollten herausfinden, ob eine bessere Beleuchtung die Produktivität der Fließbandarbeiter steigern würde. Die Forscher maßen zunächst die Produktivität im Werk, änderten dann die Beleuchtung in einem Bereich des Werks und überprüften, ob sich die Änderungen der Beleuchtung auf die Produktivität auswirkten. Es stellte sich heraus, dass sich die Produktivität (unter den Versuchsbedingungen) tatsächlich verbesserte. Allerdings wird die Studie heute wegen Fehlern in den Versuchsverfahren stark kritisiert, insbesondere wegen des Fehlens einer Kontrollgruppe und der Blindheit. Der Hawthorne-Effekt bezieht sich auf die Feststellung, dass sich ein Ergebnis (in diesem Fall die Produktivität der Arbeitnehmer) durch die Beobachtung selbst verändert. Die Teilnehmer der Hawthorne-Studie wurden nicht deshalb produktiver, weil die Beleuchtung verändert wurde, sondern weil sie beobachtet wurden. ⓘ

Beobachtungsstudie

Ein Beispiel für eine Beobachtungsstudie ist eine Studie, in der der Zusammenhang zwischen Rauchen und Lungenkrebs untersucht wird. Bei dieser Art von Studie werden in der Regel Beobachtungen über den interessierenden Bereich in einer Erhebung gesammelt und anschließend statistisch ausgewertet. In diesem Fall würden die Forscher Beobachtungen sowohl von Rauchern als auch von Nichtrauchern sammeln, vielleicht im Rahmen einer Kohortenstudie, und dann die Anzahl der Lungenkrebsfälle in jeder Gruppe untersuchen. Eine Fall-Kontroll-Studie ist eine weitere Art von Beobachtungsstudie, bei der Personen mit und ohne das interessierende Ergebnis (z. B. Lungenkrebs) zur Teilnahme eingeladen und ihre Expositionsgeschichte erfasst werden. ⓘ

Arten von Daten

Es wurden verschiedene Versuche unternommen, eine Taxonomie der Messgrößen zu erstellen. Der Psychophysiker Stanley Smith Stevens definierte Nominal-, Ordinal-, Intervall- und Verhältnisskalen. Nominale Messungen weisen keine sinnvolle Rangfolge der Werte auf und erlauben eine beliebige Eins-zu-Eins-Transformation (injektiv). Ordinale Messungen weisen ungenaue Differenzen zwischen aufeinanderfolgenden Werten auf, haben aber eine sinnvolle Reihenfolge dieser Werte und lassen jede ordnungserhaltende Transformation zu. Bei Intervallmessungen sind sinnvolle Abstände zwischen den Messungen definiert, aber der Nullwert ist willkürlich (wie im Fall von Längengrad- und Temperaturmessungen in Celsius oder Fahrenheit), und sie erlauben jede lineare Transformation. Bei Verhältnismessungen sind sowohl ein sinnvoller Nullwert als auch die Abstände zwischen verschiedenen Messungen definiert, und sie erlauben eine beliebige Skalierungstransformation. ⓘ

Da Variablen, die nur nominalen oder ordinalen Messungen entsprechen, nicht sinnvoll numerisch gemessen werden können, werden sie manchmal als kategoriale Variablen zusammengefasst, während Verhältnis- und Intervallmessungen als quantitative Variablen zusammengefasst werden, die aufgrund ihrer numerischen Natur entweder diskret oder kontinuierlich sein können. Solche Unterscheidungen können in der Informatik oft lose mit dem Datentyp korreliert werden, indem dichotome kategoriale Variablen mit dem booleschen Datentyp, polytome kategoriale Variablen mit beliebig zugewiesenen ganzen Zahlen im integralen Datentyp und kontinuierliche Variablen mit dem reellen Datentyp mit Gleitkommaarithmetik dargestellt werden können. Die Zuordnung von Informatik-Datentypen zu statistischen Datentypen hängt jedoch davon ab, welche Kategorisierung von letzteren implementiert wird. ⓘ

Es wurden andere Kategorisierungen vorgeschlagen. Mosteller und Tukey (1977) unterschieden zum Beispiel zwischen Noten, Rängen, gezählten Brüchen, Zählungen, Beträgen und Salden. Nelder (1990) beschrieb kontinuierliche Zählungen, kontinuierliche Verhältnisse, Zählverhältnisse und kategoriale Arten von Daten. (Siehe auch: Chrisman (1998), van den Berg (1991)). ⓘ

Die Frage, ob es angemessen ist, verschiedene Arten von statistischen Methoden auf Daten anzuwenden, die mit verschiedenen Arten von Messverfahren gewonnen wurden, wird durch Fragen der Transformation von Variablen und der genauen Interpretation von Forschungsfragen erschwert. "Die Beziehung zwischen den Daten und dem, was sie beschreiben, spiegelt lediglich die Tatsache wider, dass bestimmte Arten von statistischen Aussagen Wahrheitswerte haben können, die unter bestimmten Transformationen nicht invariant sind. Ob eine Transformation sinnvoll ist oder nicht, hängt von der Frage ab, die man zu beantworten versucht.": 82 ⓘ

Methoden

Deskriptive Statistik

Eine deskriptive Statistik (im Sinne des Substantivs "Anzahl") ist eine zusammenfassende Statistik, die Merkmale einer Informationssammlung quantitativ beschreibt oder zusammenfasst, während die deskriptive Statistik im Sinne des Substantivs "Masse" den Prozess der Verwendung und Analyse dieser Statistiken bezeichnet. Die deskriptive Statistik unterscheidet sich von der inferentiellen Statistik (oder induktiven Statistik) dadurch, dass die deskriptive Statistik darauf abzielt, eine Stichprobe zusammenzufassen, anstatt die Daten zu verwenden, um etwas über die Grundgesamtheit zu erfahren, die durch die Stichprobe repräsentiert werden soll. ⓘ

Inferentielle Statistik

Statistische Inferenz ist der Prozess der Datenanalyse, der dazu dient, Eigenschaften einer zugrunde liegenden Wahrscheinlichkeitsverteilung abzuleiten. Bei der inferenzstatistischen Analyse werden Eigenschaften einer Grundgesamtheit abgeleitet, z. B. durch Testen von Hypothesen und Ableiten von Schätzungen. Dabei wird davon ausgegangen, dass der beobachtete Datensatz eine Stichprobe aus einer größeren Grundgesamtheit ist. Die Inferenzstatistik kann von der deskriptiven Statistik abgegrenzt werden. Die deskriptive Statistik befasst sich ausschließlich mit den Eigenschaften der beobachteten Daten und beruht nicht auf der Annahme, dass die Daten aus einer größeren Grundgesamtheit stammen. ⓘ

Terminologie und Theorie der inferentiellen Statistik

Statistik, Schätzer und zentrale Größen

Betrachten wir unabhängige identisch verteilte (IID) Zufallsvariablen mit einer gegebenen Wahrscheinlichkeitsverteilung: Die Standardtheorie der statistischen Inferenz und Schätzung definiert eine Zufallsstichprobe als den Zufallsvektor, der durch den Spaltenvektor dieser IID-Variablen gegeben ist. Die untersuchte Population wird durch eine Wahrscheinlichkeitsverteilung beschrieben, deren Parameter unbekannt sein können. ⓘ

Eine Statistik ist eine Zufallsvariable, die eine Funktion der Zufallsstichprobe ist, aber nicht von unbekannten Parametern abhängt. Die Wahrscheinlichkeitsverteilung der Statistik kann jedoch unbekannte Parameter haben. Betrachten wir nun eine Funktion des unbekannten Parameters: Ein Schätzer ist eine Statistik, die zur Schätzung einer solchen Funktion verwendet wird. Zu den häufig verwendeten Schätzern gehören der Stichprobenmittelwert, die unverzerrte Stichprobenvarianz und die Stichprobenkovarianz. ⓘ

Eine Zufallsvariable, die eine Funktion der Zufallsstichprobe und des unbekannten Parameters ist, deren Wahrscheinlichkeitsverteilung jedoch nicht von dem unbekannten Parameter abhängt, wird als Pivotgröße oder Pivot bezeichnet. Weit verbreitete Pivots sind der z-Score, die Chi-Quadrat-Statistik und der Student's t-Wert. ⓘ

Zwischen zwei Schätzern für einen bestimmten Parameter gilt derjenige mit dem geringeren mittleren quadratischen Fehler als effizienter. Darüber hinaus gilt ein Schätzer als unvoreingenommen, wenn sein Erwartungswert gleich dem wahren Wert des zu schätzenden unbekannten Parameters ist, und als asymptotisch unvoreingenommen, wenn sein Erwartungswert an der Grenze zum wahren Wert eines solchen Parameters konvergiert. ⓘ

Andere wünschenswerte Eigenschaften für Schätzer sind: UMVUE-Schätzer, die für alle möglichen Werte des zu schätzenden Parameters die geringste Varianz aufweisen (diese Eigenschaft ist in der Regel leichter zu überprüfen als die Effizienz), und konsistente Schätzer, die mit einer gewissen Wahrscheinlichkeit zum wahren Wert des Parameters konvergieren. ⓘ

Es wurden mehrere Methoden vorgeschlagen: die Methode der Momente, die Maximum-Likelihood-Methode, die Methode der kleinsten Quadrate und die neuere Methode der Schätzung von Gleichungen. ⓘ

Nullhypothese und Alternativhypothese

Die Interpretation statistischer Informationen kann häufig die Aufstellung einer Nullhypothese beinhalten, die in der Regel (aber nicht unbedingt) besagt, dass keine Beziehung zwischen den Variablen besteht oder dass keine Veränderung im Laufe der Zeit stattgefunden hat. ⓘ

Die beste Veranschaulichung für einen Neuling ist das Dilemma eines Strafprozesses. Die Nullhypothese (H0) besagt, dass der Angeklagte unschuldig ist, während die Alternativhypothese (H1) besagt, dass der Angeklagte schuldig ist. Die Anklage erfolgt aufgrund des Verdachts der Schuld. Die H0 (Status quo) steht im Gegensatz zu H1 und wird aufrechterhalten, es sei denn, H1 wird durch Beweise "ohne begründeten Zweifel" gestützt. Die "Nichtverwerfung von H0" bedeutet in diesem Fall jedoch nicht Unschuld, sondern lediglich, dass die Beweise für eine Verurteilung nicht ausreichend waren. Die Geschworenen akzeptieren also nicht notwendigerweise H0, sondern lehnen H0 nicht ab. Während man eine Nullhypothese nicht "beweisen" kann, kann man mit einem Potenztest, der auf Fehler vom Typ II prüft, testen, wie nahe sie an der Wahrheit ist. ⓘ

Was Statistiker als Alternativhypothese bezeichnen, ist einfach eine Hypothese, die der Nullhypothese widerspricht. ⓘ

Fehler

Wenn man von einer Nullhypothese ausgeht, werden zwei große Fehlerkategorien unterschieden:

- Fehler vom Typ I, bei denen die Nullhypothese fälschlicherweise abgelehnt wird, was zu einem "falsch positiven" Ergebnis führt.

- Fehler vom Typ II, bei denen die Nullhypothese nicht abgelehnt wird und ein tatsächlicher Unterschied zwischen den Populationen übersehen wird, was zu einem "falschen Negativ" führt. ⓘ

Die Standardabweichung bezieht sich auf das Ausmaß, in dem einzelne Beobachtungen in einer Stichprobe von einem zentralen Wert, wie dem Stichproben- oder Populationsmittelwert, abweichen, während der Standardfehler sich auf eine Schätzung der Differenz zwischen Stichprobenmittelwert und Populationsmittelwert bezieht. ⓘ

Ein statistischer Fehler ist der Betrag, um den eine Beobachtung von ihrem erwarteten Wert abweicht. Ein Residuum ist der Betrag, um den eine Beobachtung von dem Wert abweicht, den der Schätzer des erwarteten Wertes bei einer gegebenen Stichprobe annimmt (auch Vorhersage genannt). ⓘ

Der mittlere quadratische Fehler wird verwendet, um effiziente Schätzer zu erhalten, eine weit verbreitete Klasse von Schätzern. Der mittlere quadratische Fehler ist einfach die Quadratwurzel des mittleren quadratischen Fehlers. ⓘ

Viele statistische Methoden zielen darauf ab, die Summe der Quadrate der Residuen zu minimieren, und diese werden "Methoden der kleinsten Quadrate" genannt, im Gegensatz zu den kleinsten absoluten Abweichungen. Bei letzterer werden kleine und große Fehler gleich gewichtet, während bei ersterer die großen Fehler stärker gewichtet werden. Die Restsumme der Quadrate ist außerdem differenzierbar, was eine praktische Eigenschaft für die Regression darstellt. Die Methode der kleinsten Quadrate, die auf eine lineare Regression angewandt wird, heißt gewöhnliche kleinste Quadrate, und die Methode der kleinsten Quadrate, die auf eine nichtlineare Regression angewandt wird, heißt nichtlineare kleinste Quadrate. Auch in einem linearen Regressionsmodell wird der nicht deterministische Teil des Modells als Fehlerterm, Störung oder einfacher als Rauschen bezeichnet. Sowohl die lineare Regression als auch die nichtlineare Regression werden in der polynomialen kleinsten Quadrate behandelt, die ebenfalls die Varianz in einer Vorhersage der abhängigen Variablen (y-Achse) als Funktion der unabhängigen Variablen (x-Achse) und der Abweichungen (Fehler, Rauschen, Störungen) von der geschätzten (angepassten) Kurve beschreibt. ⓘ

Auch Messverfahren, die statistische Daten erzeugen, sind mit Fehlern behaftet. Viele dieser Fehler werden als zufällig (Rauschen) oder systematisch (Verzerrung) eingestuft, aber auch andere Arten von Fehlern (z. B. Flüchtigkeitsfehler, wenn ein Analyst falsche Einheiten meldet) können von Bedeutung sein. Das Vorhandensein fehlender Daten oder Zensierung kann zu verzerrten Schätzungen führen, und es wurden spezielle Techniken entwickelt, um diese Probleme zu lösen. ⓘ

Intervall-Schätzung

In den meisten Studien wird nur ein Teil einer Population untersucht, so dass die Ergebnisse nicht die gesamte Population repräsentieren. Alle aus der Stichprobe gewonnenen Schätzungen sind nur eine Annäherung an den Wert der Grundgesamtheit. Mit Hilfe von Konfidenzintervallen können Statistiker ausdrücken, wie gut die Stichprobenschätzung mit dem wahren Wert in der Gesamtpopulation übereinstimmt. Häufig werden sie als 95%-Konfidenzintervalle ausgedrückt. Formal gesehen ist ein 95 %-Konfidenzintervall für einen Wert ein Bereich, in dem das Intervall den wahren Wert (der Grundgesamtheit) in 95 % aller möglichen Fälle einschließen würde, wenn die Stichprobe und die Analyse unter denselben Bedingungen wiederholt würden (was einen anderen Datensatz ergeben würde). Dies bedeutet nicht, dass die Wahrscheinlichkeit, dass der wahre Wert im Konfidenzintervall liegt, 95 % beträgt. Aus frequentistischer Sicht macht eine solche Behauptung nicht einmal Sinn, da der wahre Wert keine Zufallsvariable ist. Entweder liegt der wahre Wert innerhalb des gegebenen Intervalls oder nicht. Es stimmt jedoch, dass vor der Erhebung von Daten und angesichts eines Plans für die Konstruktion des Konfidenzintervalls die Wahrscheinlichkeit 95 % beträgt, dass das noch zu berechnende Intervall den wahren Wert abdeckt: Zu diesem Zeitpunkt sind die Grenzen des Intervalls noch zu beobachtende Zufallsvariablen. Ein Ansatz, der zu einem Intervall führt, das als mit einer bestimmten Wahrscheinlichkeit den wahren Wert enthaltend interpretiert werden kann, ist die Verwendung eines glaubwürdigen Intervalls aus der Bayes'schen Statistik: Dieser Ansatz hängt von einer anderen Art der Interpretation dessen ab, was mit "Wahrscheinlichkeit" gemeint ist, nämlich als Bayes'sche Wahrscheinlichkeit. ⓘ

Konfidenzintervalle können im Prinzip symmetrisch oder asymmetrisch sein. Ein Intervall kann asymmetrisch sein, weil es als untere oder obere Grenze für einen Parameter dient (linksseitiges Intervall oder rechtsseitiges Intervall), es kann aber auch asymmetrisch sein, weil das zweiseitige Intervall unter Verletzung der Symmetrie um den Schätzwert herum gebildet wird. Manchmal werden die Grenzen für ein Konfidenzintervall asymptotisch erreicht und diese werden zur Annäherung an die wahren Grenzen verwendet. ⓘ

Signifikanz

Die Statistik gibt selten eine einfache Ja/Nein-Antwort auf die zu untersuchende Frage. Die Interpretation hängt oft von der statistischen Signifikanz ab, die auf die Zahlen angewandt wird, und bezieht sich oft auf die Wahrscheinlichkeit, dass ein Wert die Nullhypothese genau zurückweist (manchmal auch als p-Wert bezeichnet). ⓘ

Der Standardansatz besteht darin, eine Nullhypothese gegen eine Alternativhypothese zu testen. Ein kritischer Bereich ist die Menge der Werte des Schätzers, die zur Widerlegung der Nullhypothese führt. Die Wahrscheinlichkeit eines Fehlers vom Typ I ist also die Wahrscheinlichkeit, dass der Schätzer zum kritischen Bereich gehört, wenn die Nullhypothese wahr ist (statistische Signifikanz), und die Wahrscheinlichkeit eines Fehlers vom Typ II ist die Wahrscheinlichkeit, dass der Schätzer nicht zum kritischen Bereich gehört, wenn die Alternativhypothese wahr ist. Die statistische Aussagekraft eines Tests ist die Wahrscheinlichkeit, dass er die Nullhypothese korrekt zurückweist, wenn die Nullhypothese falsch ist. ⓘ

Der Verweis auf statistische Signifikanz bedeutet nicht unbedingt, dass das Gesamtergebnis in der Realität signifikant ist. So kann sich beispielsweise in einer großen Studie zu einem Medikament zeigen, dass das Medikament eine statistisch signifikante, aber sehr geringe positive Wirkung hat, so dass es unwahrscheinlich ist, dass das Medikament dem Patienten merklich hilft. ⓘ

Obwohl das akzeptable Niveau der statistischen Signifikanz grundsätzlich diskutiert werden kann, ist das Signifikanzniveau der größte p-Wert, mit dem der Test die Nullhypothese zurückweisen kann. Dieser Test ist logisch gleichbedeutend mit der Aussage, dass der p-Wert die Wahrscheinlichkeit ist, unter der Annahme, dass die Nullhypothese wahr ist, ein Ergebnis zu beobachten, das mindestens so extrem ist wie die Teststatistik. Je kleiner also das Signifikanzniveau ist, desto geringer ist die Wahrscheinlichkeit, einen Fehler vom Typ I zu begehen. ⓘ

Mit diesem Rahmen sind in der Regel einige Probleme verbunden (siehe Kritik an Hypothesentests):

- Ein statistisch hoch signifikanter Unterschied kann immer noch ohne praktische Bedeutung sein, aber es ist möglich, die Tests entsprechend zu formulieren, um dies zu berücksichtigen. Eine Möglichkeit besteht darin, nicht mehr nur das Signifikanzniveau anzugeben, sondern auch den p-Wert, wenn angegeben wird, ob eine Hypothese abgelehnt oder angenommen wurde. Der p-Wert sagt jedoch nichts über die Größe oder Bedeutung des beobachteten Effekts aus und kann auch dazu führen, dass die Bedeutung kleiner Unterschiede in großen Studien übertrieben wird. Ein besserer und zunehmend verbreiteter Ansatz ist die Angabe von Konfidenzintervallen. Obwohl diese aus denselben Berechnungen wie die Hypothesentests oder p-Werte hervorgehen, beschreiben sie sowohl die Größe des Effekts als auch die ihn umgebende Unsicherheit.

- Irrtum des transponierten Konditionals, auch bekannt als Irrtum des Staatsanwalts: Kritisiert wird, dass der Ansatz der Hypothesentests dazu zwingt, eine Hypothese (die Nullhypothese) zu bevorzugen, da die Wahrscheinlichkeit des beobachteten Ergebnisses bei der Nullhypothese bewertet wird und nicht die Wahrscheinlichkeit der Nullhypothese bei dem beobachteten Ergebnis. Eine Alternative zu diesem Ansatz bietet die Bayes'sche Inferenz, die allerdings die Festlegung einer Vorwahrscheinlichkeit erfordert.

- Die Ablehnung der Nullhypothese beweist nicht automatisch die Alternativhypothese.

- Wie alles in der Inferenzstatistik hängt auch diese Methode von der Stichprobengröße ab, so dass die p-Werte bei "fat tails" ernsthaft falsch berechnet werden können. ⓘ

Die Aufbereitungsphase umfasst die Kodierung der Daten, die Datenbereinigung (Plausibilitätsprüfung und Korrektur, Ausreißer, fehlende Werte) und evtl. (statistisch oder sachlogisch) notwendige Transformationen der erhobenen Variablen. ⓘ

In die Aufbereitung fallen auch Imputationsmethoden für fehlende Werte. Dies bezeichnet Methoden, die fehlenden Werte durch ein zu begründendes Modell einzufügen. Hierbei ist äußerste Vorsicht geboten, mittlerweile existiert eine eigene Forschung im Bereich der Imputationsmethoden. ⓘ

Konventionen und Zeichen präzisieren die Ergebnisse einer sorgfältigen Aufbereitung. Die Statistik der Stadt Bern arbeitet nach den folgenden Regeln:

| Symbol | Bedeutung ⓘ |

|---|---|

| – | Gedankenstrich: Es kommt nichts vor (Wert genau Null). Ein Strich wird außerdem gesetzt, wenn die begrifflichen Voraussetzungen für eine Eintragung fehlen, das Zeichen bei Berechnungen aber durch eine Null ersetzt werden darf. |

| 0 0.0 | Eine Größe, die kleiner ist als die Hälfte der kleinsten verwendeten Einheit. |

| () | Leere Klammer: Eine Zahlenangabe unterbleibt aus Gründen des Datenschutzes. |

| … | Drei Punkte bedeuten je nach Kontext: Zahl nicht bekannt, gegenstandslos, aus statistischen Gründen nicht aufgeführt oder nicht anwendbar. |

| 1, 2 | Eine hochgestellte Zahl dient als Hinweis auf eine Fußnote. |

| r | Ein hochgestelltes r macht einen gegenüber früher korrigierten Wert ersichtlich („restated“). |

| g | Ein hochgestelltes g steht bei geschätzten Daten. |

| / | Ein Schrägstrich zwischen zwei Jahreszahlen kennzeichnet die zugehörigen Werte als Mittelwert. |

| – | Ein Bindestrich zwischen zwei Jahreszahlen kennzeichnet die zugehörigen Werte als Summe. |

| Σ | Allfällige Unterschiede zwischen Gesamtsumme und addierten Einzelwerten oder Teilsummen sind auf zufällige Rundungsdifferenzen zurückzuführen. |

Beispiele

Einige bekannte statistische Tests und Verfahren sind:

- Varianzanalyse (ANOVA)

- Chi-Quadrat-Test

- Korrelation

- Faktorenanalyse

- Mann-Whitney U

- Mittlere quadratische gewichtete Abweichung (MSWD)

- Produkt-Moment-Korrelationskoeffizient nach Pearson

- Regressionsanalyse

- Spearman's Rangkorrelationskoeffizient

- Student's t-Test

- Zeitreihenanalyse

- Conjoint-Analyse ⓘ

Explorative Datenanalyse

Die explorative Datenanalyse (EDA) ist ein Ansatz zur Analyse von Datensätzen, um deren Hauptmerkmale zusammenzufassen, häufig mit visuellen Methoden. Ein statistisches Modell kann verwendet werden oder auch nicht, aber in erster Linie geht es bei der EDA darum zu sehen, was die Daten uns über die formale Modellierung oder Hypothesenprüfung hinaus sagen können. ⓘ

Missbräuchliche Verwendung

Der Missbrauch von Statistiken kann zu subtilen, aber schwerwiegenden Beschreibungs- und Interpretationsfehlern führen - subtil in dem Sinne, dass selbst erfahrenen Fachleuten solche Fehler unterlaufen, und schwerwiegend in dem Sinne, dass sie zu verheerenden Fehlentscheidungen führen können. So sind beispielsweise die Sozialpolitik, die medizinische Praxis und die Zuverlässigkeit von Bauwerken wie Brücken auf die richtige Anwendung von Statistiken angewiesen. ⓘ

Selbst wenn statistische Verfahren korrekt angewandt werden, können die Ergebnisse für diejenigen, denen es an Fachwissen mangelt, schwer zu interpretieren sein. Die statistische Signifikanz eines Trends in den Daten - die das Ausmaß misst, in dem ein Trend durch zufällige Schwankungen in der Stichprobe verursacht werden könnte - kann mit einem intuitiven Gefühl für seine Bedeutung übereinstimmen oder auch nicht. Die grundlegenden statistischen Fähigkeiten (und die Skepsis), die Menschen benötigen, um mit Informationen in ihrem täglichen Leben richtig umzugehen, werden als statistische Kompetenz bezeichnet. ⓘ

Es besteht die allgemeine Auffassung, dass statistisches Wissen allzu oft absichtlich missbraucht wird, indem Wege gefunden werden, nur die Daten zu interpretieren, die für den Vortragenden vorteilhaft sind. Misstrauen und Missverständnisse gegenüber Statistiken werden mit dem Zitat "Es gibt drei Arten von Lügen: Lügen, verdammte Lügen und Statistiken" in Verbindung gebracht. Der Missbrauch von Statistiken kann sowohl unbeabsichtigt als auch absichtlich erfolgen, und in dem Buch How to Lie with Statistics von Darrell Huff wird eine Reihe von Überlegungen angestellt. In dem Versuch, Licht in die Verwendung und den Missbrauch von Statistiken zu bringen, werden Übersichten über die in bestimmten Bereichen verwendeten statistischen Techniken erstellt (z. B. Warne, Lazo, Ramos und Ritter (2012)). ⓘ

Zu den Möglichkeiten, den Missbrauch von Statistiken zu vermeiden, gehören die Verwendung geeigneter Diagramme und die Vermeidung von Verzerrungen. Ein Missbrauch kann auftreten, wenn Schlussfolgerungen übermäßig verallgemeinert werden und behauptet wird, dass sie für mehr repräsentativ sind, als es tatsächlich der Fall ist, wobei häufig bewusst oder unbewusst Stichprobenverzerrungen übersehen werden. Balkendiagramme sind wohl die am einfachsten zu verwendenden und zu verstehenden Diagramme, die entweder von Hand oder mit einfachen Computerprogrammen erstellt werden können. Leider achten die meisten Menschen nicht auf Verzerrungen oder Fehler, so dass sie nicht bemerkt werden. Daher glauben Menschen oft, dass etwas wahr ist, auch wenn es nicht gut dargestellt ist. Damit die aus Statistiken gewonnenen Daten glaubwürdig und genau sind, muss die Stichprobe repräsentativ für die Gesamtheit sein. Laut Huff kann die Zuverlässigkeit einer Stichprobe durch [Voreingenommenheit] zerstört werden... erlauben Sie sich ein gewisses Maß an Skepsis. ⓘ

Um das Verständnis der Statistik zu fördern, schlug Huff eine Reihe von Fragen vor, die in jedem Fall gestellt werden sollten:

- Wer sagt das? (Hat er/sie ein Hühnchen zu rupfen?)

- Woher weiß er/sie das? (Verfügt er/sie über die Mittel, um die Fakten zu kennen?)

- Was fehlt? (Gibt er/sie uns ein vollständiges Bild?)

- Hat jemand das Thema gewechselt? (Bietet er/sie uns die richtige Antwort auf ein falsches Problem?)

- Ergibt es Sinn? (Ist seine/ihre Schlussfolgerung logisch und stimmt sie mit dem überein, was wir bereits wissen?) ⓘ

Fehlinterpretation: Korrelation

Das Konzept der Korrelation ist besonders bemerkenswert, weil es Verwirrung stiften kann. Bei der statistischen Analyse eines Datensatzes zeigt sich häufig, dass zwei Variablen (Eigenschaften) der betrachteten Population dazu neigen, gemeinsam zu variieren, als ob sie miteinander verbunden wären. Eine Studie über das Jahreseinkommen, bei der auch das Sterbealter untersucht wird, könnte beispielsweise ergeben, dass arme Menschen tendenziell ein kürzeres Leben haben als wohlhabende Menschen. Man sagt, dass die beiden Variablen miteinander korreliert sind; sie können aber auch die Ursache füreinander sein. Die Korrelationsphänomene könnten durch ein drittes, bisher unberücksichtigtes Phänomen, eine so genannte "lurking variable" oder "confounding variable", verursacht werden. Aus diesem Grund ist es nicht möglich, sofort auf eine kausale Beziehung zwischen den beiden Variablen zu schließen. ⓘ

Anwendungen

Angewandte Statistik, theoretische Statistik und mathematische Statistik

Die angewandte Statistik, die manchmal auch als statistische Wissenschaft bezeichnet wird, umfasst die deskriptive Statistik und die Anwendung der Inferenzstatistik. Die theoretische Statistik befasst sich mit den logischen Argumenten, die der Rechtfertigung von Ansätzen zur statistischen Inferenz zugrunde liegen, und umfasst auch die mathematische Statistik. Die mathematische Statistik umfasst nicht nur die Manipulation von Wahrscheinlichkeitsverteilungen, die für die Ableitung von Ergebnissen im Zusammenhang mit Methoden der Schätzung und Inferenz notwendig sind, sondern auch verschiedene Aspekte der Computerstatistik und der Versuchsplanung. ⓘ

Statistische Berater können Organisationen und Unternehmen helfen, die nicht über internes Fachwissen für ihre speziellen Fragen verfügen. ⓘ

Maschinelles Lernen und Data Mining

Bei Modellen des maschinellen Lernens handelt es sich um statistische und probabilistische Modelle, die durch den Einsatz von Rechenalgorithmen Muster in Daten erfassen. ⓘ

Statistik im akademischen Bereich

Statistik ist in einer Vielzahl von akademischen Disziplinen anwendbar, darunter Natur- und Sozialwissenschaften, Verwaltung und Wirtschaft. Die Wirtschaftsstatistik wendet statistische Methoden in der Ökonometrie, der Rechnungsprüfung und der Produktion und dem Betrieb an, einschließlich der Verbesserung von Dienstleistungen und der Marketingforschung. Eine Studie in zwei Fachzeitschriften für Tropenbiologie ergab, dass die 12 häufigsten statistischen Tests folgende sind: Varianzanalyse (ANOVA), Chi-Quadrat-Test, Student's T-Test, lineare Regression, Pearson's Korrelationskoeffizient, Mann-Whitney U-Test, Kruskal-Wallis-Test, Shannon's Diversity Index, Tukey's Test, Clusteranalyse, Spearman's Rangkorrelationstest und Hauptkomponentenanalyse. ⓘ

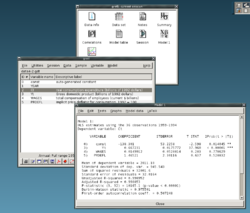

Ein typischer Statistikkurs umfasst deskriptive Statistik, Wahrscheinlichkeit, Binomial- und Normalverteilungen, Hypothesentests und Konfidenzintervalle, lineare Regression und Korrelation. Moderne statistische Grundkurse für Studenten im Grundstudium konzentrieren sich auf die richtige Auswahl von Tests, die Interpretation der Ergebnisse und die Verwendung freier Statistiksoftware. ⓘ

Statistische Berechnungen

Die Entwicklung der Computer seit der zweiten Hälfte des 20. Jahrhunderts hat einen großen Einfluss auf die Statistik. Frühe statistische Modelle waren fast immer lineare Modelle. Die immer größere Rechenkapazität und die Entwicklung geeigneter numerischer Algorithmen verursachte ein gesteigertes Interesse an nicht-linearen Modellen, wie künstlichen neuronalen Netzwerken und führte zur Entwicklung komplexer statistischer Modelle, beispielsweise verallgemeinerte lineare Modelle oder Mehrebenenmodelle. ⓘ

Durch die individuelle Verfügbarkeit von Statistik-Software kann man auch Daten selbst darstellen und eine Vielzahl von Berechnungen durchführen. Dies reicht von der Berechnung von Lageparametern (wie Mittelwerte, Median, Modus) und Streuungsmaßen (wie Standardabweichung, Varianz, Spannweite) bis zu komplexen statistischen Modellen. Auch ist in der Regel die Darstellung von Daten in einer Vielzahl von Diagrammen, wie Box-Plots, Stamm-Blatt-Diagrammen möglich. Für spezialisierte Grafiken kann man auf Visualisierungsprogramme zurückgreifen. ⓘ

Der Zuwachs an Rechenleistung hat ebenfalls zu einer zunehmenden Popularität computerintensiver Methoden auf der Basis von Resampling-Techniken (Permutationstests, Bootstrapping-Verfahren) geführt. Auch die Anwendung der Bayessche Statistik ist durch Verwendung von Monte-Carlo-Simulationen, wie z. B. dem Gibbs-Sampling oder den Metropolis-Algorithmus, wesentlich einfacher und umsetzbarer geworden. ⓘ

Die gestiegene Rechenleistung hat auch dazu geführt, dass rechenintensive Methoden, die auf einer erneuten Stichprobenziehung beruhen, wie Permutationstests und Bootstrap, immer beliebter werden, während Techniken wie das Gibbs-Sampling den Einsatz von Bayes'schen Modellen möglich gemacht haben. Die Computerrevolution hat Auswirkungen auf die Zukunft der Statistik, da der Schwerpunkt nun auf der "experimentellen" und "empirischen" Statistik liegt. Inzwischen gibt es eine große Anzahl von allgemeiner und spezieller Statistiksoftware. Beispiele für verfügbare Software, die komplexe statistische Berechnungen durchführen kann, sind Programme wie Mathematica, SAS, SPSS und R. ⓘ

Unternehmensstatistik

In der Wirtschaft ist die "Statistik" ein weit verbreitetes Management- und Entscheidungshilfeinstrument. Sie wird insbesondere im Finanzmanagement, im Marketingmanagement sowie im Produktions-, Dienstleistungs- und Betriebsmanagement eingesetzt. Auch im Rechnungswesen und in der Wirtschaftsprüfung wird Statistik häufig eingesetzt. Die Disziplin der Managementwissenschaften formalisiert die Verwendung von Statistiken und anderer Mathematik in der Wirtschaft. (Ökonometrie ist die Anwendung statistischer Methoden auf Wirtschaftsdaten, um wirtschaftliche Zusammenhänge empirisch zu erfassen). ⓘ

Ein typischer Kurs "Wirtschaftsstatistik" richtet sich an Studierende der Wirtschaftswissenschaften und umfasst deskriptive Statistik (Erfassung, Beschreibung, Analyse und Zusammenfassung von Daten), Wahrscheinlichkeitsrechnung (typischerweise Binomial- und Normalverteilung), Hypothesentests und Konfidenzintervalle, lineare Regression und Korrelation; (Folge-)Kurse können Prognosen, Zeitreihen, Entscheidungsbäume, multiple lineare Regression und andere Themen der Wirtschaftsanalytik im Allgemeinen umfassen. Siehe auch Wirtschaftsmathematik § Hochschulniveau. Professionelle Zertifizierungsprogramme, wie z. B. die CFA-Prüfung, umfassen häufig Themen aus der Statistik. ⓘ

Statistik in der Mathematik oder in der Kunst

Traditionell befasste sich die Statistik mit dem Ziehen von Schlussfolgerungen unter Verwendung einer halbstandardisierten Methodik, die in den meisten Wissenschaften "Pflichtfach" war. Diese Tradition hat sich mit der Anwendung der Statistik in nicht-inferentiellen Kontexten geändert. Was einst als trockenes Fach galt, das in vielen Bereichen als Voraussetzung für ein Studium galt, wird heute mit Begeisterung betrachtet. Anfänglich von einigen mathematischen Puristen verspottet, wird es heute in bestimmten Bereichen als unverzichtbare Methodik angesehen. ⓘ

- In der Zahlentheorie können Streudiagramme von Daten, die durch eine Verteilungsfunktion erzeugt wurden, mit den bekannten Werkzeugen der Statistik umgewandelt werden, um zugrundeliegende Muster zu erkennen, die dann zu Hypothesen führen können.

- Prädiktive statistische Methoden zur Vorhersage, die die Chaostheorie und die fraktale Geometrie kombinieren, können zur Erstellung von Videoarbeiten verwendet werden.

- Die Prozesskunst von Jackson Pollock beruhte auf künstlerischen Experimenten, bei denen zugrundeliegende Verteilungen in der Natur künstlerisch aufgedeckt wurden. Mit dem Aufkommen der Computer wurden statistische Methoden angewandt, um solche verteilungsgesteuerten natürlichen Prozesse zu formalisieren und bewegte Videokunst zu schaffen und zu analysieren.

- In der Performance-Kunst können statistische Methoden prädiktiv eingesetzt werden, wie z. B. bei einem Kartentrick, der auf einem Markov-Prozess basiert, der nur zu einem bestimmten Zeitpunkt funktioniert und dessen Ausgang sich mit Hilfe statistischer Methoden vorhersagen lässt.

- Statistik kann auch dazu verwendet werden, Kunst zu schaffen, wie in der von Iannis Xenakis erfundenen statistischen oder stochastischen Musik, bei der die Musik aufführungsspezifisch ist. Obwohl diese Art von Kunst nicht immer wie erwartet ausfällt, verhält sie sich doch auf eine Weise, die mit Hilfe der Statistik vorhersehbar und abstimmbar ist. ⓘ

Spezialisierte Disziplinen

Statistische Verfahren werden in einer Vielzahl von wissenschaftlichen und sozialen Forschungsbereichen eingesetzt, z. B. in der Biostatistik, Computerbiologie, Computersoziologie, Netzwerkbiologie, Sozialwissenschaft, Soziologie und Sozialforschung. In einigen Forschungsbereichen wird die angewandte Statistik so intensiv genutzt, dass sie über eine spezielle Terminologie verfügen. Zu diesen Disziplinen gehören:

- Versicherungsmathematik (Risikobewertung in der Versicherungs- und Finanzbranche)

- Angewandte Informationsökonomie

- Astrostatistik (statistische Auswertung von astronomischen Daten)

- Biostatistik

- Chemometrik (zur Analyse von Daten aus der Chemie)

- Data Mining (Anwendung von Statistik und Mustererkennung, um Wissen aus Daten zu gewinnen)

- Datenwissenschaft

- Demografie (statistische Untersuchung von Populationen)

- Ökonometrie (statistische Analyse von Wirtschaftsdaten)

- Energiestatistik

- Technische Statistik

- Epidemiologie (statistische Analyse von Krankheiten)

- Geografie und geografische Informationssysteme, insbesondere im Bereich der räumlichen Analyse

- Bildverarbeitung

- Jurimetrik (Recht)

- Medizinische Statistik

- Politische Wissenschaft

- Psychologische Statistik

- Zuverlässigkeitstechnik

- Sozialstatistik

- Statistische Mechanik

Darüber hinaus gibt es bestimmte Arten der statistischen Analyse, die ebenfalls ihre eigene Fachterminologie und Methodik entwickelt haben:

- Bootstrap / Jackknife-Wiederholungsstichproben

- Multivariate Statistik

- Statistische Klassifizierung

- Strukturierte Datenanalyse

- Strukturgleichungsmodellierung

- Methodik der Erhebung

- Survival-Analyse

- Statistik in verschiedenen Sportarten, insbesondere Baseball - bekannt als Sabermetrics - und Kricket

Auch in der Wirtschaft und im verarbeitenden Gewerbe bildet die Statistik ein wichtiges Basisinstrument. Sie wird eingesetzt, um die Variabilität von Messsystemen zu verstehen, um Prozesse zu steuern (wie bei der statistischen Prozesskontrolle oder SPC), um Daten zusammenzufassen und um datengestützte Entscheidungen zu treffen. In diesen Bereichen ist sie ein Schlüsselinstrument, vielleicht sogar das einzige zuverlässige Instrument. ⓘ

Etymologie

Das Wort Statistik stammt von lateinisch statisticum „den Staat betreffend“ und italienisch statista Staatsmann oder Politiker, was wiederum aus dem griechischen στατίζω (einordnen) kommt. Die deutsche Statistik, eingeführt von Gottfried Achenwall 1749, bezeichnete ursprünglich die „Lehre von den Daten über den Staat“. Im 19. Jahrhundert hatte der Schotte John Sinclair das Wort erstmals in seiner heutigen Bedeutung des allgemeinen Sammelns und Auswertens von Daten benutzt. ⓘ

Schritte der praktischen Umsetzung der Statistik

Die Durchführung einer statistischen Untersuchung erfolgt immer im Zusammenspiel von statistisch-mathematischer Methodik und theoretischem Fachwissen. Sie kann grob in fünf Schritte eingeteilt werden: ⓘ

Erhebung

Nach der Festlegung der Erhebungsart ergeben sich entsprechende Schritte.

- Primär-statistische Erhebung

Der Forscher erhebt seine Daten selbst, etwa durch Umfrage. Damit muss das Prozedere der Datenerhebung, etwa durch das ADM-Design, festgelegt werden und die Erhebung nach diesen Vorschriften durchgeführt werden.

- Sekundär-statistische Erhebung

Der Forscher nutzt Einzeldaten, die von anderen erhoben wurden, etwa durch ein Statistisches Amt. So spart er Arbeit, da er nicht selbst erhebt. Oft jedoch passen die erhobenen Variablen nicht exakt zur Forschungsfrage oder der gewünschten Operationalisierung.

- Tertiär-statistische Erhebung

Der Forscher nutzt nur für eine statistische Raumbezugseinheit aggregierte Daten, die von anderen erhoben und veröffentlicht wurden. ⓘ

Ferner differenziert man zwischen randomisierten Daten und reinen Observationsdaten (aus denen durch Computer-Simulationen noch quasirandomisierte Daten erstellt werden können, z. B. durch Propensity Score Matching). ⓘ

Interpretation

Die Interpretation der Ergebnisse der statistischen Analyse erfolgt natürlich unter Berücksichtigung des jeweiligen Fachgebietes. Von großer und fachübergreifender Wichtigkeit jedoch ist die Umsetzung von Zahlen in Sprache, die treffsichere sprachliche Umsetzung der gewonnenen Ergebnisse, die wissenschaftliche Kriterien erfüllt. Ohne den Rückbezug auf die im Verlauf des im wissenschaftlichen Erkenntnisprozess aufgestellten Hypothesen und Fragestellungen bleibt die statistische Analyse ohne Belang. In der statistischen Auswertung werden auch die meisten Schwächen einer statistischen Analyse sichtbar. Zu oft bleibt nur die reine Zahlendarstellung und zu wenig wird das Augenmerk auf eine klare sprachliche Ergebnissicherung gelegt. Eine überzeugende statistische Auswertung wird die gewonnenen Ergebnisse in einen flüssigen Text einbauen, versehen mit der Relevanz, den ersten Schritten von der Frage zur statistischen Methode, dem Höhepunkt einer strukturierten Ergebnisdarstellung und zu guter Letzt dem Verweis auf den größeren wissenschaftlichen Kontext, durchaus auch im Bewusstsein möglicher Schwachstellen der Analyse. Erst der Verweis und Querbezug auf andere wissenschaftlich gewonnene und valide Studienergebnisse trägt dann zu einem Erkenntnisfortschritt bei. ⓘ

Informationsgehalt und -bewertung

Statistiken stellen eine Repräsentation gesammelter Daten dar. Je nach Art und Weise der Datengewinnung entspricht der Gehalt der Informationen einem brauchbaren Ergebnis. Bei Verlassen der reellen und objektiven Prozesse können aber auch falsche Schlüsse aus Statistiken gezogen werden. So lässt sich ermitteln, wie groß der Anteil von Schwarzfahrern in Zügen oder die Durchschnittseinkommen der Bevölkerung an einem bestimmten Ort sein könnten. Allein aus statistisch verknüpfbaren Daten sollten aber keine Zusammenhänge gebildet werden. ⓘ

Im Umgang mit Statistiken gilt es stets, den gesamten Datengehalt auf Relevanz, auf Beziehung der Teilinformationen zueinander und zum Umfeld zu prüfen. Auch bei geeigneter Interpretation der Daten können falsche Belege gefunden werden, wenn die eine oder andere Beziehung weggelassen oder ins falsche Umfeld gesetzt wird. Es wird daher von Statistiken gefordert, dass sie „objektiv“ (unabhängig vom Standpunkt des Statistikerstellers), „reliabel“ (verlässlich), „valide“ (überkontextuell gültig), „signifikant“ (bedeutend) und „relevant“ (wichtig) sind. ⓘ

Schulen und Denkrichtungen

In Lehrbüchern wird mitunter der Eindruck vermittelt, es gebe nur das eine, sich ständig weiterentwickelnde Statistikmodell. In der Deskriptiven Statistik gibt es wenig Kontroversen, in der Induktiven Statistik gibt es jedoch verschiedene Denkschulen, die ein Problem unterschiedlich analysieren, bewerten und numerisch berechnen. Wenig bekannte Ansätze sind

- die Fiduzialinferenz von Ronald Aylmer Fisher,

- die Likelihoodinferenz basierend auf den Arbeiten von George Alfred Barnard, Allan Birnbaum und Anthony W.F. Edwards und

- die Strukturinferenz von Donald A. S. Fraser. ⓘ

Dominiert wird die induktive Statistik durch

- die klassische Inferenz, entwickelt durch Ronald Aylmer Fisher, Egon Pearson und Jerzy Neyman,

- die Bayes-Inferenz, entwickelt durch Harold Jeffreys, Dennis Victor Lindley und Leonard Jimmie Savage, sowie

- die statistische Entscheidungstheorie von Abraham Wald. ⓘ

Die folgende Tabelle zeigt einige Unterschiede zwischen den Inferenzarten auf:

| klassische Inferenz | Bayes-Inferenz | statistische Entscheidungstheorie ⓘ | |

|---|---|---|---|

| verwendetes Inferenzkonzept | objektivistisch, kognitivistisch, frequentistisch | subjektivistisch, kognitivistisch, nichtfrequentistisch | subjektivistisch, dezisionistisch, nichtfrequentistisch |

| Verwendete Information | früher: Priorinformation → jetzt: Stichprobendaten → später: Handlungsfolgen | ||

| nur Stichprobendaten | zusätzlich Priorinformation | zusätzlich Handlungsfolgen | |

| Informationsverarbeitung | Stichproben- und Likelihood-Funktionen | zusätzlich Priorverteilungen für Priorinformationen und Posteriorverteilung mittels Bayes Formel | zusätzlich Verlustfunktion für Handlungsfolgen |

| Eingesetzte Methoden | Punkt- und Intervallschätzung sowie Testverfahren auf Basis der Stichprobenverteilungen | Punkt- und Intervallschätzung sowie Testverfahren auf Basis der Posteriorverteilungen | Aufstellung von Entscheidungsfunktionen |

| Methodenbeurteilung | Unbekannter Parameter ist fix und Wahrscheinlichkeitsaussagen betreffen nur die Schätzung . | Unbekannter Parameter ist stochastisch und Wahrscheinlichkeitsaussagen betreffen auch . | |