Normalverteilung

|

Wahrscheinlichkeitsdichtefunktion  Die rote Kurve ist die Standardnormalverteilung | |||

|

Kumulative Verteilungsfunktion  | |||

| Notation | |||

|---|---|---|---|

| Parameter |

= Mittelwert (Ort) = Varianz (Skalenquadrat) | ||

| Unterstützung | |||

| CDF | |||

| Quantil | |||

| Mittelwert | |||

| Median | |||

| Modus | |||

| Varianz | |||

| MAD | |||

| Schrägheit | |||

| Bsp. Kurtosis | |||

| Entropie | |||

| MGF | |||

| CF | |||

| Fisher-Information |

| ||

| Kullback-Leibler-Divergenz | |||

| Teil einer Serie über Statistik ⓘ |

| Wahrscheinlichkeitsrechnung |

|---|

|

|

|

|

|

|

In der Statistik ist die Normalverteilung (auch bekannt als Gauß-, Gauß- oder Laplace-Gauß-Verteilung) ein Typ der kontinuierlichen Wahrscheinlichkeitsverteilung für eine reellwertige Zufallsvariable. Die allgemeine Form ihrer Wahrscheinlichkeitsdichtefunktion ist

Der Parameter ist der Mittelwert oder Erwartungswert der Verteilung (und auch ihr Median und Modus), während der Parameter ihre Standardabweichung ist. Die Varianz der Verteilung ist . Eine Zufallsvariable mit einer Gaußschen Verteilung gilt als normalverteilt und wird als Normalabweichung bezeichnet. ⓘ

Normalverteilungen sind in der Statistik von großer Bedeutung und werden in den Natur- und Sozialwissenschaften häufig zur Darstellung von reellwertigen Zufallsvariablen verwendet, deren Verteilungen nicht bekannt sind. Ihre Bedeutung ist zum Teil auf den zentralen Grenzwertsatz zurückzuführen. Es besagt, dass unter bestimmten Bedingungen der Durchschnitt vieler Stichproben (Beobachtungen) einer Zufallsvariablen mit endlichem Mittelwert und Varianz selbst eine Zufallsvariable ist, deren Verteilung mit zunehmender Anzahl der Stichproben gegen eine Normalverteilung konvergiert. Daher haben physikalische Größen, von denen man annimmt, dass sie die Summe vieler unabhängiger Prozesse sind, wie z. B. Messfehler, oft Verteilungen, die nahezu normal sind. ⓘ

Darüber hinaus haben Gaußverteilungen einige einzigartige Eigenschaften, die für analytische Untersuchungen von Nutzen sind. Zum Beispiel ist jede lineare Kombination einer festen Sammlung von Normalabweichungen eine Normalabweichung. Viele Ergebnisse und Methoden, wie z. B. die Ausbreitung der Unsicherheit und die Anpassung von Parametern nach der Methode der kleinsten Quadrate, lassen sich analytisch in expliziter Form ableiten, wenn die relevanten Variablen normalverteilt sind. ⓘ

Eine Normalverteilung wird manchmal informell als Glockenkurve bezeichnet. Viele andere Verteilungen sind jedoch glockenförmig (z. B. Cauchy-, Student's t- und logistische Verteilungen). ⓘ

Die univariate Wahrscheinlichkeitsverteilung wird für Vektoren in der multivariaten Normalverteilung und für Matrizen in der Matrixnormalverteilung verallgemeinert. ⓘ

Die besondere Bedeutung der Normalverteilung beruht unter anderem auf dem zentralen Grenzwertsatz, dem zufolge Verteilungen, die durch additive Überlagerung einer großen Zahl von unabhängigen Einflüssen entstehen, unter schwachen Voraussetzungen annähernd normalverteilt sind. Die Familie der Normalverteilungen bildet eine Lage-Skalen-Familie. ⓘ

Die Abweichungen der Messwerte vieler natur-, wirtschafts- und ingenieurwissenschaftlicher Vorgänge vom Erwartungswert lassen sich durch die Normalverteilung (bei biologischen Prozessen oft logarithmische Normalverteilung) in sehr guter Näherung beschreiben (vor allem Prozesse, die in mehreren Faktoren unabhängig voneinander in verschiedene Richtungen wirken). ⓘ

Zufallsvariablen mit Normalverteilung benutzt man zur Beschreibung zufälliger Vorgänge wie:

- zufällige Streuung von Messwerten,

- zufällige Abweichungen vom Sollmaß bei der Fertigung von Werkstücken,

- Beschreibung der brownschen Molekularbewegung. ⓘ

In der Versicherungsmathematik ist die Normalverteilung geeignet zur Modellierung von Schadensdaten im Bereich mittlerer Schadenshöhen. ⓘ

In der Messtechnik wird häufig eine Normalverteilung angesetzt, um die Streuung von Messwerten zu beschreiben. ⓘ

Die Standardabweichung beschreibt die Breite der Normalverteilung. Die Halbwertsbreite einer Normalverteilung ist ungefähr das -Fache (genau ) der Standardabweichung. Es gilt näherungsweise:

- Im Intervall der Abweichung vom Erwartungswert sind 68,27 % aller Messwerte zu finden,

- Im Intervall der Abweichung vom Erwartungswert sind 95,45 % aller Messwerte zu finden,

- Im Intervall der Abweichung vom Erwartungswert sind 99,73 % aller Messwerte zu finden.

Und ebenso lassen sich umgekehrt für gegebene Wahrscheinlichkeiten die maximalen Abweichungen vom Erwartungswert finden:

- 50 % aller Messwerte haben eine Abweichung von höchstens vom Erwartungswert,

- 90 % aller Messwerte haben eine Abweichung von höchstens vom Erwartungswert,

- 95 % aller Messwerte haben eine Abweichung von höchstens vom Erwartungswert,

- 99 % aller Messwerte haben eine Abweichung von höchstens vom Erwartungswert. ⓘ

Somit kann neben dem Erwartungswert, der als Schwerpunkt der Verteilung interpretiert werden kann, auch der Standardabweichung eine einfache Bedeutung im Hinblick auf die Größenordnungen der auftretenden Wahrscheinlichkeiten bzw. Häufigkeiten zugeordnet werden. ⓘ

Definitionen

Standard-Normalverteilung

Der einfachste Fall einer Normalverteilung wird als Standardnormalverteilung oder Einheitsnormalverteilung bezeichnet. Dies ist ein Spezialfall, wenn und und wird durch diese Wahrscheinlichkeitsdichtefunktion (oder Dichte) beschrieben:

Die Variable hat einen Mittelwert von 0 und eine Varianz und Standardabweichung von 1. Die Dichte hat ihre Spitze bei . und Wendepunkte bei und . ⓘ

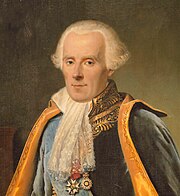

Obwohl die obige Dichte am häufigsten als Standardnormalverteilung bezeichnet wird, haben einige Autoren diesen Begriff verwendet, um andere Versionen der Normalverteilung zu beschreiben. Carl Friedrich Gauß zum Beispiel definierte die Standardnormalverteilung als

was eine Varianz von 1/2 hat, und Stephen Stigler definierte einst die Standardnormale als

definiert, die eine einfache funktionale Form und eine Varianz von : ⓘ

Allgemeine Normalverteilung

Jede Normalverteilung ist eine Version der Standardnormalverteilung, deren Bereich um einen Faktor gestreckt wurde (die Standardabweichung) gestreckt und dann durch (den Mittelwert):

Die Wahrscheinlichkeitsdichte muss skaliert werden durch skaliert werden, so dass das Integral immer noch 1 ist. ⓘ

Wenn eine Standard-Normalabweichung ist, dann eine Normalverteilung mit Erwartungswert und Standardabweichung . Dies ist gleichbedeutend mit der Aussage, dass die "Standard"-Normalverteilung um einen Faktor von und verschoben um verschoben wird, um eine andere Normalverteilung zu erhalten, die . Umgekehrt, wenn eine Normalabweichung mit den Parametern und ist, dann kann diese Verteilung neu skaliert und verschoben werden, und zwar mit der Formel in die "Standard"-Normalverteilung umgewandelt werden. Diese Variante wird auch als die standardisierte Form von . ⓘ

Notation

Die Wahrscheinlichkeitsdichte der Gaußschen Standardverteilung (Standardnormalverteilung, mit Mittelwert Null und Einheitsvarianz) wird häufig mit dem griechischen Buchstaben (phi) bezeichnet. Die alternative Form des griechischen Buchstabens phi, wird ebenfalls recht häufig verwendet. ⓘ

Die Normalverteilung wird oft als oder . Wenn also eine Zufallsvariable normalverteilt ist mit Mittelwert und Standardabweichung , kann man schreiben ⓘ

Alternative Parametrisierungen

Einige Autoren befürworten die Verwendung der Genauigkeit als Parameter zu verwenden, der die Breite der Verteilung definiert, anstelle der Abweichung oder der Varianz . Die Präzision wird normalerweise als der Kehrwert der Varianz definiert, . Die Formel für die Verteilung lautet dann ⓘ

Es wird behauptet, dass diese Wahl Vorteile bei numerischen Berechnungen hat, wenn sehr nahe bei Null liegt, und vereinfacht die Formeln in einigen Zusammenhängen, wie z. B. bei der Bayes'schen Inferenz von Variablen mit multivariater Normalverteilung. ⓘ

Alternativ dazu kann der Kehrwert der Standardabweichung als Präzision definiert werden, wobei der Ausdruck der Normalverteilung wie folgt lautet ⓘ

Nach Stigler ist diese Formulierung vorteilhaft, weil sie eine viel einfachere und leichter zu merkende Formel und einfache Näherungsformeln für die Quantile der Verteilung bietet. ⓘ

Normalverteilungen bilden eine Exponentialfamilie mit natürlichen Parametern und , und natürlichen Statistiken x und x2. Die dualen Erwartungsparameter der Normalverteilung sind η1 = μ und η2 = μ2 + σ2. ⓘ

Kumulative Verteilungsfunktionen

Die kumulative Verteilungsfunktion (CDF) der Standardnormalverteilung, die gewöhnlich mit dem großen griechischen Buchstaben (phi) bezeichnet wird, ist das Integral ⓘ

Die zugehörige Fehlerfunktion gibt die Wahrscheinlichkeit an, dass eine Zufallsvariable mit Normalverteilung, Mittelwert 0 und Varianz 1/2, in den Bereich . Das heißt:

Diese Integrale können nicht in Form von elementaren Funktionen ausgedrückt werden und werden oft als spezielle Funktionen bezeichnet. Es sind jedoch zahlreiche numerische Näherungen bekannt; siehe unten. ⓘ

Die beiden Funktionen sind eng miteinander verwandt, nämlich ⓘ

Für eine allgemeine Normalverteilung mit Dichte , Mittelwert und Abweichung ist die kumulative Verteilungsfunktion ⓘ

Das Komplement der Standardnormalverteilung CDF, wird oft als Q-Funktion bezeichnet, insbesondere in technischen Texten. Sie gibt die Wahrscheinlichkeit an, dass der Wert einer standardnormalen Zufallsvariablen größer ist als : . Andere Definitionen der -Funktion, die alle einfache Transformationen von sind, werden ebenfalls gelegentlich verwendet. ⓘ

Der Graph der Standard-Normal-CDF hat eine 2-fache Rotationssymmetrie um den Punkt (0,1/2); das heißt, . Ihre Antiderivative (unbestimmtes Integral) kann wie folgt ausgedrückt werden:

Die CDF der Standardnormalverteilung kann durch Integration durch Teile zu einer Reihe erweitert werden:

wobei die doppelte Fakultät bezeichnet. ⓘ

Eine asymptotische Erweiterung der CDF für große x kann auch durch Integration durch Teile abgeleitet werden. Weitere Informationen finden Sie unter Fehlerfunktion#Asymptotische Entwicklung. ⓘ

Eine schnelle Annäherung an die CDF der Standardnormalverteilung lässt sich mit Hilfe einer Taylorreihen-Approximation finden: ⓘ

Standardabweichung und Streuung

Aus der Standardnormalverteilungstabelle ist ersichtlich, dass für normalverteilte Zufallsvariablen jeweils ungefähr

- 68,3 % der Realisierungen im Intervall ,

- 95,4 % im Intervall und

- 99,7 % im Intervall

liegen. Da in der Praxis viele Zufallsvariablen annähernd normalverteilt sind, werden diese Werte aus der Normalverteilung oft als Faustformel benutzt. So wird beispielsweise oft als die halbe Breite des Intervalls angenommen, das die mittleren zwei Drittel der Werte in einer Stichprobe umfasst, siehe Quantil. ⓘ

Diese Praxis ist aber nicht empfehlenswert, denn sie kann zu sehr großen Fehlern führen. Zum Beispiel ist die Verteilung optisch kaum von der Normalverteilung zu unterscheiden (siehe Bild), aber bei ihr liegen im Intervall 92,5 % der Werte, wobei die Standardabweichung von bezeichnet. Solche kontaminierten Normalverteilungen sind in der Praxis sehr häufig; das genannte Beispiel beschreibt die Situation, wenn zehn Präzisionsmaschinen etwas herstellen, aber eine davon schlecht justiert ist und mit zehnmal so hohen Abweichungen wie die anderen neun produziert. ⓘ

Werte außerhalb der zwei- bis dreifachen Standardabweichung werden oft als Ausreißer behandelt. Ausreißer können ein Hinweis auf grobe Fehler der Datenerfassung sein. Es kann den Daten aber auch eine stark schiefe Verteilung zugrunde liegen. Andererseits liegt bei einer Normalverteilung im Durchschnitt ca. jeder 20. Messwert außerhalb der zweifachen Standardabweichung und ca. jeder 500. Messwert außerhalb der dreifachen Standardabweichung. ⓘ

Da der Anteil der Werte außerhalb der sechsfachen Standardabweichung mit ca. 2 ppb verschwindend klein wird, gilt ein solches Intervall als gutes Maß für eine nahezu vollständige Abdeckung aller Werte. Das wird im Qualitätsmanagement durch die Methode Six Sigma genutzt, indem die Prozessanforderungen Toleranzgrenzen von mindestens vorschreiben. Allerdings geht man dort von einer langfristigen Erwartungswertverschiebung um 1,5 Standardabweichungen aus, sodass der zulässige Fehleranteil auf 3,4 ppm steigt. Dieser Fehleranteil entspricht einer viereinhalbfachen Standardabweichung (). Ein weiteres Problem der -Methode ist, dass die -Punkte praktisch nicht bestimmbar sind. Bei unbekannter Verteilung (d. h., wenn es sich nicht ganz sicher um eine Normalverteilung handelt) grenzen zum Beispiel die Extremwerte von 1.400.000.000 Messungen ein 75-%-Konfidenzintervall für die -Punkte ein. ⓘ

| Prozent innerhalb | Prozent außerhalb | ppb außerhalb | Bruchteil außerhalb | |

|---|---|---|---|---|

| 0,674490 | 50 % | 50 % | 500.000.000 | 1 / 2 |

| 0,994458 | 68 % | 32 % | 320.000.000 | 1 / 3,125 |

| 1 | 68,268 9492 % | 31,731 0508 % | 317.310.508 | 1 / 3,151 4872 |

| 1,281552 | 80 % | 20 % | 200.000.000 | 1 / 5 |

| 1,644854 | 90 % | 10 % | 100.000.000 | 1 / 10 |

| 1,959964 | 95 % | 5 % | 50.000.000 | 1 / 20 |

| 2 | 95,449 9736 % | 4,550 0264 % | 45.500.264 | 1 / 21,977 895 |

| 2,354820 | 98,146 8322 % | 1,853 1678 % | 18.531.678 | 1 / 54 |

| 2,575829 | 99 % | 1 % | 10.000.000 | 1 / 100 |

| 3 | 99,730 0204 % | 0,269 9796 % | 2.699.796 | 1 / 370,398 |

| 3,290527 | 99,9 % | 0,1 % | 1.000.000 | 1 / 1.000 |

| 3,890592 | 99,99 % | 0,01 % | 100.000 | 1 / 10.000 |

| 4 | 99,993 666 % | 0,006 334 % | 63.340 | 1 / 15.787 |

| 4,417173 | 99,999 % | 0,001 % | 10.000 | 1 / 100.000 |

| 4,891638 | 99,9999 % | 0,0001 % | 1.000 | 1 / 1.000.000 |

| 5 | 99,999 942 6697 % | 0,000 057 3303 % | 573,3303 | 1 / 1.744.278 |

| 5,326724 | 99,999 99 % | 0,000 01 % | 100 | 1 / 10.000.000 |

| 5,730729 | 99,999 999 % | 0,000 001 % | 10 | 1 / 100.000.000 |

| 6 | 99,999 999 8027 % | 0,000 000 1973 % | 1,973 | 1 / 506.797.346 |

| 6,109410 | 99,999 9999 % | 0,000 0001 % | 1 | 1 / 1.000.000.000 |

| 6,466951 | 99,999 999 99 % | 0,000 000 01 % | 0,1 | 1 / 10.000.000.000 |

| 6,806502 | 99,999 999 999 % | 0,000 000 001 % | 0,01 | 1 / 100.000.000.000 |

| 7 | 99,999 999 999 7440 % | 0,000 000 000 256 % | 0,002 56 | 1 / 390.682.215.445 |

Die Wahrscheinlichkeiten für bestimmte Streuintervalle können berechnet werden als ⓘ

- , ⓘ

wobei die Verteilungsfunktion der Standardnormalverteilung ist. ⓘ

Umgekehrt können für gegebenes durch ⓘ

die Grenzen des zugehörigen Streuintervalls mit Wahrscheinlichkeit berechnet werden. ⓘ

Genauer gesagt liegt die Wahrscheinlichkeit, dass eine Normalabweichung im Bereich zwischen und ist gegeben durch

Auf 12 signifikante Stellen genau sind die Werte für sind:

| OEIS ⓘ | ||||||

|---|---|---|---|---|---|---|

| 1 | 0.682689492137 | 0.317310507863 |

|

OEIS: A178647 | ||

| 2 | 0.954499736104 | 0.045500263896 |

|

OEIS: A110894 | ||

| 3 | 0.997300203937 | 0.002699796063 |

|

OEIS: A270712 | ||

| 4 | 0.999936657516 | 0.000063342484 |

| |||

| 5 | 0.999999426697 | 0.000000573303 |

| |||

| 6 | 0.999999998027 | 0.000000001973 |

|

Quantilsfunktion

Die Quantilsfunktion einer Verteilung ist die Umkehrung der kumulativen Verteilungsfunktion. Die Quantilsfunktion der Standardnormalverteilung wird als Probitfunktion bezeichnet und kann durch die inverse Fehlerfunktion ausgedrückt werden:

Für eine normale Zufallsvariable mit Mittelwert und Varianz ist die Quantilsfunktion

Das Quantil der Standardnormalverteilung wird üblicherweise bezeichnet als . Diese Werte werden bei Hypothesentests, der Konstruktion von Konfidenzintervallen und Q-Q-Diagrammen verwendet. Eine normale Zufallsvariable größer ist als mit der Wahrscheinlichkeit , und liegt außerhalb des Intervalls mit der Wahrscheinlichkeit . Insbesondere ist das Quantil beträgt 1,96; daher liegt eine normale Zufallsvariable nur in 5 % der Fälle außerhalb des Intervalls nur in 5 % der Fälle. ⓘ

Die folgende Tabelle zeigt das Quantil so dass im Bereich mit einer bestimmten Wahrscheinlichkeit . Diese Werte sind nützlich, um Toleranzintervalle für Stichprobendurchschnitte und andere statistische Schätzer mit normaler (oder asymptotisch normaler) Verteilung zu bestimmen. Beachten Sie, dass die folgende Tabelle zeigt , nicht wie oben definiert. ⓘ

| ⓘ | ||||

|---|---|---|---|---|

| 0.80 | 1.281551565545 | 0.999 | 3.290526731492 | |

| 0.90 | 1.644853626951 | 0.9999 | 3.890591886413 | |

| 0.95 | 1.959963984540 | 0.99999 | 4.417173413469 | |

| 0.98 | 2.326347874041 | 0.999999 | 4.891638475699 | |

| 0.99 | 2.575829303549 | 0.9999999 | 5.326723886384 | |

| 0.995 | 2.807033768344 | 0.99999999 | 5.730728868236 | |

| 0.998 | 3.090232306168 | 0.999999999 | 6.109410204869 |

Für kleine hat die Quantilsfunktion die nützliche asymptotische Erweiterung ⓘ

Eigenschaften

Die Normalverteilung ist die einzige Verteilung, deren Kumulanten jenseits der ersten beiden (d. h. abgesehen von Mittelwert und Varianz) Null sind. Sie ist auch die kontinuierliche Verteilung mit der maximalen Entropie für einen bestimmten Mittelwert und eine bestimmte Varianz. Geary hat unter der Annahme, dass Mittelwert und Varianz endlich sind, gezeigt, dass die Normalverteilung die einzige Verteilung ist, bei der Mittelwert und Varianz, die aus einer Reihe unabhängiger Ziehungen berechnet werden, unabhängig voneinander sind. ⓘ

Die Normalverteilung ist eine Unterklasse der elliptischen Verteilungen. Die Normalverteilung ist symmetrisch um ihren Mittelwert und ist über die gesamte reelle Linie ungleich Null. Daher ist sie möglicherweise kein geeignetes Modell für Variablen, die von Natur aus positiv oder stark schief sind, wie z. B. das Gewicht einer Person oder der Preis einer Aktie. Solche Variablen können besser durch andere Verteilungen beschrieben werden, wie z. B. die Log-Normal-Verteilung oder die Pareto-Verteilung. ⓘ

Der Wert der Normalverteilung ist praktisch Null, wenn der Wert mehr als ein paar Standardabweichungen vom Mittelwert entfernt liegt (z. B. deckt eine Streuung von drei Standardabweichungen alle bis auf 0,27 % der Gesamtverteilung ab). Daher ist es möglicherweise kein geeignetes Modell, wenn man einen signifikanten Anteil an Ausreißern erwartet - Werte, die viele Standardabweichungen vom Mittelwert entfernt liegen - und die kleinsten Quadrate und andere statistische Schlussfolgerungsmethoden, die für normalverteilte Variablen optimal sind, werden oft sehr unzuverlässig, wenn sie auf solche Daten angewendet werden. In diesen Fällen sollte eine Verteilung mit stärkerem Schwanz angenommen und die entsprechenden robusten statistischen Schlussfolgerungsmethoden angewandt werden. ⓘ

Die Gauß-Verteilung gehört zur Familie der stabilen Verteilungen, die die Attraktoren von Summen unabhängiger, identisch verteilter Verteilungen sind, unabhängig davon, ob der Mittelwert oder die Varianz endlich ist oder nicht. Mit Ausnahme der Gauß-Verteilung, die ein Grenzfall ist, haben alle stabilen Verteilungen starke Schwänze und eine unendliche Varianz. Die Gauß-Verteilung ist eine der wenigen stabilen Verteilungen, deren Wahrscheinlichkeitsdichtefunktionen analytisch ausgedrückt werden können; die anderen sind die Cauchy-Verteilung und die Lévy-Verteilung. ⓘ

Symmetrien und Ableitungen

Die Normalverteilung mit der Dichte (Mittelwert und Standardabweichung ) hat die folgenden Eigenschaften:

- Sie ist symmetrisch um den Punkt der gleichzeitig der Modus, der Median und der Mittelwert der Verteilung ist.

- Sie ist unimodal: ihre erste Ableitung ist positiv für negativ für und Null nur bei

- Die Fläche, die von der Kurve und der -Achse begrenzt wird, ist eins (d. h. gleich eins).

- Ihre erste Ableitung ist

- Die Dichte hat zwei Wendepunkte (an denen die zweite Ableitung von Null ist und das Vorzeichen wechselt), die eine Standardabweichung vom Mittelwert entfernt liegen, nämlich bei und

- Die Dichte ist log-konkav.

- Die Dichte ist unendlich differenzierbar, und zwar superglatt der Ordnung 2. ⓘ

Außerdem ist die Dichte der Standardnormalverteilung (d. h. und ) auch die folgenden Eigenschaften:

- Ihre erste Ableitung ist

- Ihre zweite Ableitung ist

- Allgemeiner ausgedrückt, ist ihre n-te Ableitung wobei ist das n-te (probabilistische) Hermite-Polynom.

- Die Wahrscheinlichkeit, dass eine normalverteilte Variable mit bekannter und in einer bestimmten Menge liegt, lässt sich berechnen, indem man die Tatsache nutzt, dass der Bruchteil eine Standardnormalverteilung hat. ⓘ

Momente

Die einfachen und absoluten Momente einer Variablen sind die Erwartungswerte von und beziehungsweise. Wenn der erwartete Wert von Null ist, werden diese Parameter als zentrale Momente bezeichnet; andernfalls werden diese Parameter als nicht-zentrale Momente bezeichnet. Normalerweise sind wir nur an Momenten mit ganzzahliger Ordnung interessiert . ⓘ

Wenn eine Normalverteilung hat, existieren die nicht-zentralen Momente und sind endlich für jeden deren Realteil größer als -1 ist. Für jede nichtnegative ganze Zahl sind die einfachen zentralen Momente:

Hier die doppelte Fakultät, d. h. das Produkt aller Zahlen von bis 1, die die gleiche Parität haben wie ⓘ

Die zentralen absoluten Momente stimmen für alle geraden Ordnungen mit den einfachen Momenten überein, sind aber für ungerade Ordnungen ungleich Null. Für jede nichtnegative ganze Zahl ⓘ

Die letzte Formel gilt auch für jede nicht-ganzzahlige Zahl Wenn der Mittelwert können die einfachen und absoluten Momente als konfluente hypergeometrische Funktionen ausgedrückt werden und ⓘ

Diese Ausdrücke bleiben auch dann gültig, wenn nicht eine ganze Zahl ist. Siehe auch verallgemeinerte Hermite-Polynome. ⓘ

| Ordnung | Nicht-zentrales Moment | Zentrales Moment ⓘ |

|---|---|---|

| 1 | ||

| 2 | ||

| 3 | ||

| 4 | ||

| 5 | ||

| 6 | ||

| 7 | ||

| 8 |

Der Erwartungswert von bedingt durch das Ereignis, dass in einem Intervall liegt ist gegeben durch

wobei und sind die Dichte bzw. die kumulative Verteilungsfunktion von . Für ist dies als das inverse Mills-Verhältnis bekannt. Beachten Sie, dass oben die Dichte von anstelle der Standardnormaldichte wie im inversen Mills-Verhältnis verwendet wird, so dass wir hier anstelle von . ⓘ

Fouriertransformation und charakteristische Funktion

Die Fourier-Transformierte einer Normaldichte mit Mittelwert und Standardabweichung ist ⓘ

wobei ist die imaginäre Einheit. Wenn der Mittelwert ist der erste Faktor 1, und die Fourier-Transformierte ist, abgesehen von einem konstanten Faktor, eine Normaldichte im Frequenzbereich, mit Mittelwert 0 und Standardabweichung . Insbesondere ist die Standardnormalverteilung ist eine Eigenfunktion der Fourier-Transformation. ⓘ

In der Wahrscheinlichkeitstheorie ist die Fourier-Transformation der Wahrscheinlichkeitsverteilung einer reellwertigen Zufallsvariablen eng verbunden mit der charakteristischen Funktion dieser Variablen, die definiert ist als der Erwartungswert von als eine Funktion der reellen Variablen (dem Frequenzparameter der Fourier-Transformation). Diese Definition kann analytisch auf eine komplexwertige Variable erweitert werden . Die Beziehung zwischen beiden ist:

Moment- und Kumulanten-Erzeugungsfunktionen

Die momenterzeugende Funktion einer reellen Zufallsvariablen ist der Erwartungswert von in Abhängigkeit von dem reellen Parameter . Für eine Normalverteilung mit der Dichte , Mittelwert und Abweichung existiert die momenterzeugende Funktion und ist gleich ⓘ

Die kumulierende Erzeugungsfunktion ist der Logarithmus der momenterzeugenden Funktion, nämlich ⓘ

Da es sich um ein quadratisches Polynom in ist, sind nur die ersten beiden Kumulanten ungleich Null, nämlich der Mittelwert und die Varianz . ⓘ

Stein-Operator und Klasse

Im Rahmen der Steinschen Methode sind der Stein-Operator und die Klasse einer Zufallsvariablen sind und die Klasse aller absolut stetigen Funktionen . ⓘ

Null-Varianz-Grenze

Im Grenzwert, wenn gegen Null tendiert, tendiert die Wahrscheinlichkeitsdichte schließlich gegen Null tendiert bei jedem , wächst aber unbegrenzt, wenn Daher kann die Normalverteilung nicht als gewöhnliche Funktion definiert werden, wenn . ⓘ

Man kann jedoch die Normalverteilung mit der Varianz Null als verallgemeinerte Funktion definieren, und zwar als Diracs "Deltafunktion" übersetzt durch den Mittelwert , d.h. Ihre CDF ist dann die mit dem Mittelwert übersetzte Heaviside-Stufenfunktion nämlich

Maximale Entropie

Von allen Wahrscheinlichkeitsverteilungen über den reellen Zahlen mit einem bestimmten Mittelwert und Varianz ist die Normalverteilung diejenige mit maximaler Entropie. Wenn eine stetige Zufallsvariable mit der Wahrscheinlichkeitsdichte ist, dann ist die Entropie von ist definiert als

wobei ist immer dann gleich Null, wenn . Dieses Funktional kann unter der Voraussetzung, dass die Verteilung ordnungsgemäß normalisiert ist und eine bestimmte Varianz aufweist, mit Hilfe der Variationsrechnung maximiert werden. Es wird eine Funktion mit zwei Lagrange-Multiplikatoren definiert:

wobei wird vorerst als eine Dichtefunktion mit Mittelwert und Standardabweichung . ⓘ

Bei maximaler Entropie ist eine kleine Variation um eine Abweichung um die gleich 0 ist:

Da dies für jede kleine gelten muss, muss der Term in Klammern Null sein, und die Lösung für ergibt:

Die Anwendung der Zwangsgleichungen zur Lösung für und erhält man die Dichte der Normalverteilung:

Die Entropie einer Normalverteilung ist gleich

Andere Eigenschaften

- Wenn die charakteristische Funktion einer Zufallsvariablen von der Form , wobei ein Polynom ist, dann besagt das Marcinkiewicz-Theorem (benannt nach Józef Marcinkiewicz), dass höchstens ein quadratisches Polynom sein kann, und daher eine normale Zufallsvariable ist. Die Folge dieses Ergebnisses ist, dass die Normalverteilung die einzige Verteilung mit einer endlichen Anzahl (zwei) von Kumulanten ungleich Null ist.

- Wenn und sind gemeinsam normal und unkorreliert, dann sind sie unabhängig. Die Bedingung, dass und gemeinsam normal sind, ist wesentlich; ohne sie gilt die Eigenschaft nicht.[Beweis] Für nicht-normale Zufallsvariablen impliziert Unkorreliertheit nicht Unabhängigkeit.

- Die Kullback-Leibler-Divergenz einer Normalverteilung von einer anderen ist gegeben durch: Der Hellinger-Abstand zwischen gleichen Verteilungen ist gleich

- Die Fisher-Informationsmatrix für eine Normalverteilung ist diagonal und hat die Form

- Die konjugierte Priorität des Mittelwerts einer Normalverteilung ist eine andere Normalverteilung. Genauer gesagt, wenn iid sind und der Prior ist ist, dann ist die Posteriorverteilung für den Schätzer von sein

- Die Familie der Normalverteilungen bildet nicht nur eine Exponentialfamilie (EF), sondern sogar eine natürliche Exponentialfamilie (NEF) mit quadratischer Varianzfunktion (NEF-QVF). Viele Eigenschaften von Normalverteilungen lassen sich auf Eigenschaften von NEF-QVF-Verteilungen, NEF-Verteilungen oder EF-Verteilungen im Allgemeinen verallgemeinern. NEF-QVF-Verteilungen umfassen 6 Familien, darunter Poisson-, Gamma-, Binomial- und negative Binomialverteilungen, während viele der in der Wahrscheinlichkeitsrechnung und Statistik untersuchten Familien NEF- oder EF-Verteilungen sind.

- In der Informationsgeometrie bildet die Familie der Normalverteilungen eine statistische Mannigfaltigkeit mit konstanter Krümmung . Die gleiche Familie ist flach in Bezug auf die (±1)-Verbindungen und . ⓘ

Symmetrie

Der Graph der Wahrscheinlichkeitsdichte ist eine Gaußsche Glockenkurve, deren Höhe und Breite von abhängt. Sie ist achsensymmetrisch zur Geraden mit der Gleichung und somit eine symmetrische Wahrscheinlichkeitsverteilung um ihren Erwartungswert. Der Graph der Verteilungsfunktion ist punktsymmetrisch zum Punkt Für gilt insbesondere und für alle . ⓘ

Normierung

Für wird die Funktion immer höher und schmaler, der Flächeninhalt bleibt jedoch unverändert 1. ⓘ

Wichtig ist, dass die gesamte Fläche unter der Kurve gleich , also gleich der Wahrscheinlichkeit des sicheren Ereignisses, ist. Somit folgt, dass, wenn zwei Gaußsche Glockenkurven dasselbe , aber unterschiedliches haben, die Kurve mit dem größeren breiter und niedriger ist (da ja beide zugehörigen Flächen jeweils den Wert haben und nur die Standardabweichung größer ist). Zwei Glockenkurven mit gleichem aber unterschiedlichem haben kongruente Graphen, die um die Differenz der -Werte parallel zur -Achse gegeneinander verschoben sind. ⓘ

Jede Normalverteilung ist tatsächlich normiert, denn mit Hilfe der linearen Substitution erhalten wir

- . ⓘ

Für die Normiertheit des letzteren Integrals siehe Fehlerintegral. ⓘ

Berechnung

Da sich nicht auf eine elementare Stammfunktion zurückführen lässt, wurde für die Berechnung früher meist auf Tabellen zurückgegriffen (siehe Standardnormalverteilungstabelle). Heutzutage sind in statistischen Programmiersprachen wie zum Beispiel R Funktionen verfügbar, die auch die Transformation auf beliebige und beherrschen. ⓘ

Erwartungswert

Der Erwartungswert der Standardnormalverteilung ist . Es sei , so gilt ⓘ

da der Integrand integrierbar und punktsymmetrisch ist. ⓘ

Ist nun , so gilt ist standardnormalverteilt, und somit ⓘ

Standardabweichung der Normalverteilung

Eindimensionale Normalverteilungen werden durch Angabe von Erwartungswert und Varianz vollständig beschrieben. Ist also eine --verteilte Zufallsvariable – in Symbolen –, so ist ihre Standardabweichung einfach . ⓘ

Ein Beispiel (mit Schwankungsbreite)

Die Körpergröße des Menschen ist näherungsweise normalverteilt. Bei einer Stichprobe von 1.284 Mädchen und 1.063 Jungen zwischen 14 und 18 Jahren wurde bei den Mädchen eine durchschnittliche Körpergröße von 166,3 cm (Standardabweichung 6,39 cm) und bei den Jungen eine durchschnittliche Körpergröße von 176,8 cm (Standardabweichung 7,46 cm) gemessen. ⓘ

Demnach lässt obige Schwankungsbreite erwarten, dass 68,3 % der Mädchen eine Körpergröße im Bereich 166,3 cm ± 6,39 cm und 95,4 % im Bereich 166,3 cm ± 12,8 cm haben,

- 16 % [≈ (100 % − 68,3 %)/2] der Mädchen kleiner als 160 cm (und 16 % entsprechend größer als 173 cm) sind und

- 2,5 % [≈ (100 % − 95,4 %)/2] der Mädchen kleiner als 154 cm (und 2,5 % entsprechend größer als 179 cm) sind. ⓘ

Für die Jungen lässt sich erwarten, dass 68 % eine Körpergröße im Bereich 176,8 cm ± 7,46 cm und 95 % im Bereich 176,8 cm ± 14,92 cm haben,

- 16 % der Jungen kleiner als 169 cm (und 16 % größer als 184 cm) und

- 2,5 % der Jungen kleiner als 162 cm (und 2,5 % größer als 192 cm) sind. ⓘ

Variationskoeffizient

Aus Erwartungswert und Standardabweichung der -Verteilung erhält man unmittelbar den Variationskoeffizienten

Schiefe

Die Schiefe besitzt unabhängig von den Parametern und immer den Wert . ⓘ

Wölbung

Die Wölbung ist ebenfalls von und unabhängig und ist gleich . Um die Wölbungen anderer Verteilungen besser einschätzen zu können, werden sie oft mit der Wölbung der Normalverteilung verglichen. Dabei wird die Wölbung der Normalverteilung auf normiert (Subtraktion von 3); diese Größe wird als Exzess bezeichnet. ⓘ

Charakteristische Funktion

Die charakteristische Funktion für eine standardnormalverteilte Zufallsvariable ist

- . ⓘ

Für eine Zufallsvariable erhält man daraus mit :

- . ⓘ

Verwandte Verteilungen

Zentraler Grenzwertsatz

Das zentrale Grenzwertsyndrom besagt, dass die Summe vieler Zufallsvariablen unter bestimmten (recht häufigen) Bedingungen eine annähernde Normalverteilung aufweist. Genauer gesagt, wenn unabhängige und identisch verteilte Zufallsvariablen mit der gleichen willkürlichen Verteilung, Mittelwert Null und Varianz sind und ist ihr Mittelwert skaliert mit

Wenn dann zunimmt, wird die Wahrscheinlichkeitsverteilung von zur Normalverteilung mit Mittelwert und Varianz Null tendieren . ⓘ

Das Theorem kann auf Variablen erweitert werden die nicht unabhängig und/oder nicht identisch verteilt sind, erweitert werden, wenn bestimmte Einschränkungen hinsichtlich des Grades der Abhängigkeit und der Momente der Verteilungen gemacht werden. ⓘ

Viele Teststatistiken, Ergebnisse und Schätzer, die man in der Praxis antrifft, enthalten Summen bestimmter Zufallsvariablen, und noch mehr Schätzer können durch die Verwendung von Einflussfunktionen als Summen von Zufallsvariablen dargestellt werden. Der zentrale Grenzwertsatz besagt, dass diese statistischen Parameter asymptotisch normalverteilt sind. ⓘ

Der zentrale Grenzwertsatz besagt auch, dass bestimmte Verteilungen beispielsweise durch die Normalverteilung angenähert werden können:

- Die Binomialverteilung ist annähernd normal mit Mittelwert und Varianz für große und für nicht zu nahe an 0 oder 1 liegt.

- Die Poisson-Verteilung mit dem Parameter ist annähernd normal mit Mittelwert und Varianz für große Werte von .

- Die Chi-Quadrat-Verteilung ist annähernd normal mit Mittelwert und Varianz für große Werte .

- Die Student's t-Verteilung ist annähernd normal mit Mittelwert 0 und Varianz 1, wenn groß ist. ⓘ

Ob diese Näherungen ausreichend genau sind, hängt von dem Zweck ab, für den sie benötigt werden, sowie von der Konvergenzrate zur Normalverteilung. In der Regel sind solche Näherungen in den Schwänzen der Verteilung weniger genau. ⓘ

Eine allgemeine obere Schranke für den Approximationsfehler im zentralen Grenzwertsatz ist durch das Berry-Esseen-Theorem gegeben, Verbesserungen der Approximation sind durch die Edgeworth-Erweiterungen gegeben. ⓘ

Dieses Theorem kann auch verwendet werden, um die Modellierung der Summe vieler gleichförmiger Rauschquellen als Gaußsches Rauschen zu rechtfertigen. Siehe AWGN. ⓘ

Operationen und Funktionen von Normalvariablen

Die Wahrscheinlichkeitsdichte, die kumulative Verteilung und die inverse kumulative Verteilung einer beliebigen Funktion einer oder mehrerer unabhängiger oder korrelierter Normalvariablen können mit der numerischen Methode des Raytracing (Matlab-Code) berechnet werden. In den folgenden Abschnitten werden einige Spezialfälle betrachtet. ⓘ

Operationen mit einer einzelnen Normalvariablen

Wenn ist normalverteilt mit Mittelwert und Varianz , dann

- für beliebige reelle Zahlen und ebenfalls normalverteilt, mit dem Mittelwert und Standardabweichung . Das heißt, die Familie der Normalverteilungen ist bei linearen Transformationen geschlossen.

- Das Exponential von ist lognormal verteilt: eX ~ ln(N (μ, σ2)).

- Der Absolutwert von hat eine gefaltete Normalverteilung: |X| ~ Nf (μ, σ2). Wenn wird dies als Halbnormalverteilung bezeichnet.

- Der Absolutwert der normalisierten Residuen, |X - μ|/σ, hat eine Chi-Verteilung mit einem Freiheitsgrad: .

- Das Quadrat von X/σ hat die nichtzentrale Chi-Quadrat-Verteilung mit einem Freiheitsgrad: . Wenn wird die Verteilung einfach chi-Quadratisch genannt.

- Die logarithmische Wahrscheinlichkeit einer normalen Variablen ist einfach der Logarithmus ihrer Wahrscheinlichkeitsdichtefunktion: Da es sich um ein skaliertes und verschobenes Quadrat einer Standardnormalvariablen handelt, wird sie als skalierte und verschobene chi-Quadrat-Variable verteilt.

- Die Verteilung der Variablen X, die auf ein Intervall [a, b] beschränkt ist, wird als verkürzte Normalverteilung bezeichnet.

- (X - μ)-2 hat eine Lévy-Verteilung mit Ort 0 und Skala σ-2. ⓘ

Operationen auf zwei unabhängigen Normalvariablen

- Wenn und sind zwei unabhängige normalverteilte Zufallsvariablen mit Mittelwerten , und Standardabweichungen , , dann ist ihre Summe ebenfalls normalverteilt sein,[Beweis] mit Mittelwert und Varianz .

- Insbesondere, wenn und unabhängige Normalabweichungen mit Mittelwert und Varianz Null sind , dann und ebenfalls unabhängig und normalverteilt, mit Mittelwert und Varianz Null . Dies ist ein Spezialfall der Polarisationsidentität.

- Wenn , sind zwei unabhängige Normalabweichungen mit Mittelwert und Abweichung und , beliebige reelle Zahlen sind, dann ist die Variable ebenfalls normalverteilt mit dem Mittelwert und Abweichung . Daraus folgt, dass die Normalverteilung stabil ist (mit Exponent ). ⓘ

- . ⓘ

Ein elementarer Beweis wird Poisson zugeschrieben. ⓘ

Die mittlere absolute Abweichung ist und der Interquartilsabstand . ⓘ

Operationen auf zwei unabhängigen Standardnormalvariablen

Wenn und sind zwei unabhängige Standardnormalzufallsvariablen mit Mittelwert 0 und Varianz 1, dann

- Ihre Summe und Differenz sind normalverteilt mit dem Mittelwert Null und der Varianz Zwei: .

- Ihr Produkt folgt der Produktverteilung mit der Dichtefunktion wobei ist die modifizierte Besselfunktion der zweiten Art. Diese Verteilung ist symmetrisch um Null, unbeschränkt bei und hat die charakteristische Funktion .

- Ihr Verhältnis folgt der Standard-Cauchy-Verteilung: .

- Ihre euklidische Norm hat die Rayleigh-Verteilung. ⓘ

Operationen mit mehreren unabhängigen Normalvariablen

- Jede Linearkombination von unabhängigen Normalabweichungen ist eine Normalabweichung.

- Wenn Sind mehrere unabhängige Standardnormalzufallsvariablen vorhanden, so hat die Summe ihrer Quadrate die Chi-Quadrat-Verteilung mit Freiheitsgraden

- Wenn sind unabhängige normalverteilte Zufallsvariablen mit Mittelwerten und Varianzen sind, dann ist ihr Stichprobenmittelwert unabhängig von der Stichprobenstandardabweichung, was mit Hilfe des Satzes von Basu oder des Satzes von Cochran nachgewiesen werden kann. Das Verhältnis dieser beiden Größen hat die Student's t-Verteilung mit Freiheitsgraden:

- Wenn , Wenn es sich um unabhängige Standardnormalzufallsvariablen handelt, dann hat das Verhältnis ihrer normalisierten Quadratsummen die F-Verteilung mit (n, m) Freiheitsgraden: ⓘ

Operationen an mehrfach korrelierten Normalvariablen

- Eine quadratische Form eines Normalvektors, d. h. eine quadratische Funktion mehrerer unabhängiger oder korrelierter normaler Variablen, ist eine verallgemeinerte Chi-Quadrat-Variable. ⓘ

Operationen mit der Dichtefunktion

Die geteilte Normalverteilung lässt sich am direktesten definieren, indem man die skalierten Abschnitte der Dichtefunktionen verschiedener Normalverteilungen zusammenfügt und die Dichte so umskaliert, dass sie zu 1 integriert wird. Die abgeschnittene Normalverteilung ergibt sich aus der Neuskalierung eines Abschnitts einer einzelnen Dichtefunktion. ⓘ

Unendliche Teilbarkeit und der Satz von Cramér

Für jede positive ganze Zahl ist jede Normalverteilung mit Mittelwert und Varianz ist die Verteilung der Summe von unabhängigen Normalabweichungen, jeweils mit Mittelwert und Varianz . Diese Eigenschaft wird als unendliche Teilbarkeit bezeichnet. ⓘ

Umgekehrt, wenn und unabhängige Zufallsvariablen sind und ihre Summe eine Normalverteilung hat, dann sind beide und Normalabweichungen sein. ⓘ

Dieses Ergebnis ist als Cramér-Zerlegungstheorem bekannt und entspricht der Aussage, dass die Faltung zweier Verteilungen nur dann normal ist, wenn beide normal sind. Das Cramér-Theorem besagt, dass eine Linearkombination unabhängiger nicht-gaußscher Variablen niemals eine exakte Normalverteilung hat, auch wenn sie sich ihr beliebig stark annähern kann. ⓘ

Approximation der Binomialverteilung durch die Normalverteilung

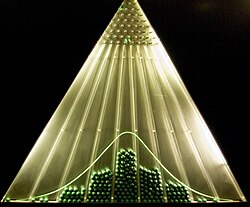

Die Normalverteilung kann zur Approximation der Binomialverteilung verwendet werden, wenn der Stichprobenumfang hinreichend groß und in der Grundgesamtheit der Anteil der gesuchten Eigenschaft weder zu groß noch zu klein ist (Satz von Moivre-Laplace, zentraler Grenzwertsatz, zur experimentellen Bestätigung siehe auch unter Galtonbrett). ⓘ

Ist ein Bernoulli-Versuch mit voneinander unabhängigen Stufen (bzw. Zufallsexperimenten) mit einer Erfolgswahrscheinlichkeit gegeben, so lässt sich die Wahrscheinlichkeit für Erfolge allgemein durch berechnen (Binomialverteilung). ⓘ

Diese Binomialverteilung kann durch eine Normalverteilung approximiert werden, wenn hinreichend groß und weder zu groß noch zu klein ist. Als Faustregel dafür gilt . Für den Erwartungswert und die Standardabweichung gilt dann:

- und .

Damit gilt für die Standardabweichung . ⓘ

Falls diese Bedingung nicht erfüllt sein sollte, ist die Ungenauigkeit der Näherung immer noch vertretbar, wenn gilt: und zugleich . ⓘ

Folgende Näherung ist dann brauchbar:

Bei der Normalverteilung wird die untere Grenze um 0,5 verkleinert und die obere Grenze um 0,5 vergrößert, um eine bessere Approximation gewährleisten zu können. Dies nennt man auch „Stetigkeitskorrektur“. Nur wenn einen sehr hohen Wert besitzt, kann auf sie verzichtet werden. ⓘ

Da die Binomialverteilung diskret ist, muss auf einige Punkte geachtet werden:

- Der Unterschied zwischen oder (sowie zwischen größer und größer gleich) muss beachtet werden (was ja bei der Normalverteilung nicht der Fall ist). Deshalb muss bei die nächstkleinere natürliche Zahl gewählt werden, d. h.

- bzw. ,

- damit mit der Normalverteilung weitergerechnet werden kann.

- Zum Beispiel: ⓘ

- Außerdem ist

- (unbedingt mit Stetigkeitskorrektur)

- und lässt sich somit durch die oben angegebene Formel berechnen. ⓘ

Der große Vorteil der Approximation liegt darin, dass sehr viele Stufen einer Binomialverteilung sehr schnell und einfach bestimmt werden können. ⓘ

Das Bernsteinsche Theorem besagt, dass, wenn und unabhängig sind und und ebenfalls unabhängig sind, dann müssen sowohl X als auch Y notwendigerweise normalverteilt sein. ⓘ

Erweiterungen

Der Begriff der Normalverteilung, eine der wichtigsten Verteilungen in der Wahrscheinlichkeitstheorie, ist weit über den Standardrahmen des univariaten (d. h. eindimensionalen) Falles (Fall 1) hinaus erweitert worden. Alle diese Erweiterungen werden auch als Normal- oder Gaußsche Gesetze bezeichnet, so dass eine gewisse Zweideutigkeit der Bezeichnungen besteht.

- Die multivariate Normalverteilung beschreibt das Gaußsche Gesetz im k-dimensionalen euklidischen Raum. Ein Vektor X ∈ Rk ist multivariat-normalverteilt, wenn jede Linearkombination seiner Komponenten Σk

j=1aj Xj eine (univariate) Normalverteilung hat. Die Varianz von X ist eine k×k symmetrische positiv-definite Matrix V. Die multivariate Normalverteilung ist ein Spezialfall der elliptischen Verteilungen. Als solche sind ihre Isodichteorte im Fall von k = 2 Ellipsen und im Fall von beliebigem k Ellipsoide. - Gleichgerichtete Gaußverteilung eine gleichgerichtete Version der Normalverteilung, bei der alle negativen Elemente auf 0 zurückgesetzt werden

- Die komplexe Normalverteilung befasst sich mit den komplexen Normalvektoren. Ein komplexer Vektor X ∈ Ck wird als normal bezeichnet, wenn sowohl seine realen als auch seine imaginären Komponenten gemeinsam eine 2k-dimensionale multivariate Normalverteilung besitzen. Die Varianz-Kovarianz-Struktur von X wird durch zwei Matrizen beschrieben: die Varianzmatrix Γ und die Relationsmatrix C.

- Die Matrixnormalverteilung beschreibt den Fall der normalverteilten Matrizen.

- Gaußsche Prozesse sind die normalverteilten stochastischen Prozesse. Sie können als Elemente eines unendlich-dimensionalen Hilbert-Raums H betrachtet werden und sind somit die Analoga der multivariaten Normalvektoren für den Fall k = ∞. Ein Zufallselement h ∈ H wird als normal bezeichnet, wenn für eine beliebige Konstante a ∈ H das Skalarprodukt (a, h) eine (univariate) Normalverteilung aufweist. Die Varianzstruktur eines solchen Gaußschen Zufallselements kann durch den linearen Kovarianzoperator K: H → H beschrieben werden. Mehrere Gaußsche Prozesse wurden so populär, dass sie eigene Namen erhielten:

- Brownsche Bewegung,

- Brownsche Brücke,

- Ornstein-Uhlenbeck-Prozess.

- Die q-Gauß-Verteilung ist eine abstrakte mathematische Konstruktion, die ein "q-Analogon" der Normalverteilung darstellt.

- Die q-Gauß-Verteilung ist ein Analogon der Gauß-Verteilung in dem Sinne, dass sie die Tsallis-Entropie maximiert und einen Typ der Tsallis-Verteilung darstellt. Es ist zu beachten, dass sich diese Verteilung von der obigen q-Gauß-Verteilung unterscheidet. ⓘ

Eine Zufallsvariable X hat eine zweiteilige Normalverteilung, wenn sie eine Verteilung hat ⓘ

wobei μ der Mittelwert ist und σ1 und σ2 die Standardabweichungen der Verteilung links bzw. rechts vom Mittelwert sind. ⓘ

Der Mittelwert, die Varianz und das dritte zentrale Moment dieser Verteilung sind bestimmt worden ⓘ

wobei E(X), V(X) und T(X) jeweils der Mittelwert, die Varianz und das dritte zentrale Moment sind. ⓘ

Eine der wichtigsten praktischen Anwendungen des Gaußschen Gesetzes ist die Modellierung der empirischen Verteilungen vieler verschiedener Zufallsvariablen, die in der Praxis vorkommen. In einem solchen Fall wäre eine mögliche Erweiterung eine reichhaltigere Familie von Verteilungen, die mehr als zwei Parameter haben und daher in der Lage sind, die empirische Verteilung genauer zu beschreiben. Beispiele für solche Erweiterungen sind:

- Pearson-Verteilung - eine Familie von Wahrscheinlichkeitsverteilungen mit vier Parametern, die das Normalgesetz um verschiedene Schrägheits- und Wölbungswerte erweitern.

- Die verallgemeinerte Normalverteilung, auch bekannt als Exponentialverteilung, ermöglicht Verteilungsschwänze mit dickerem oder dünnerem asymptotischen Verhalten. ⓘ

Statistische Inferenz

Schätzung von Parametern

Häufig sind die Parameter der Normalverteilung nicht bekannt, so dass man sie schätzen muss. Das heißt, wenn man eine Stichprobe aus einer Normal Grundgesamtheit möchte man die Näherungswerte der Parameter erfahren und . Der Standardansatz für dieses Problem ist die Maximum-Likelihood-Methode, die eine Maximierung der Log-Likelihood-Funktion erfordert:

Man nimmt die Ableitungen nach und und das Lösen des sich daraus ergebenden Systems von Bedingungen erster Ordnung ergibt die Maximum-Likelihood-Schätzungen:

Stichprobenmittelwert

Schätzer wird als Stichprobenmittelwert bezeichnet, da er das arithmetische Mittel aller Beobachtungen ist. Die Statistik ist vollständig und ausreichend für und daher nach dem Lehmann-Scheffé-Theorem, der einheitlich minimale unvoreingenommene Varianzschätzer (UMVU) ist. In endlichen Stichproben ist sie normalverteilt:

Die Varianz dieses Schätzers ist gleich dem μμ-Element der inversen Fisher-Informationsmatrix . Dies impliziert, dass der Schätzer für endliche Stichproben effizient ist. Von praktischer Bedeutung ist die Tatsache, dass der Standardfehler von proportional ist zu ist, d. h. wenn man den Standardfehler um den Faktor 10 verringern will, muss man die Anzahl der Punkte in der Stichprobe um den Faktor 100 erhöhen. Diese Tatsache wird häufig bei der Bestimmung des Stichprobenumfangs für Meinungsumfragen und der Anzahl der Versuche bei Monte-Carlo-Simulationen verwendet. ⓘ

Vom Standpunkt der asymptotischen Theorie aus gesehen, konsistent, d. h. es konvergiert mit der Wahrscheinlichkeit zu als . Der Schätzer ist auch asymptotisch normal, was eine einfache Folge der Tatsache ist, dass er bei endlichen Stichproben normal ist:

Varianz der Stichprobe

Der Schätzer wird als Stichprobenvarianz bezeichnet, da er die Varianz der Stichprobe ist (). In der Praxis wird häufig ein anderer Schätzer anstelle des . Dieser andere Schätzer hat die Bezeichnung bezeichnet und wird auch als Stichprobenvarianz bezeichnet, was eine gewisse terminologische Zweideutigkeit darstellt; seine Quadratwurzel wird als Stichprobenstandardabweichung bezeichnet. Der Schätzer unterscheidet sich von dadurch, dass (n - 1) anstelle von n im Nenner steht (die so genannte Bessel-Korrektur):

Der Unterschied zwischen und wird für große n vernachlässigbar klein. Bei endlichen Stichproben ist die Motivation für die Verwendung von ist, dass es sich um einen unverzerrten Schätzer des zugrunde liegenden Parameters ist, während verzerrt ist. Außerdem ist der Schätzer nach dem Lehmann-Scheffé-Theorem einheitlich minimal variance unbiased (UMVU), was ihn zum "besten" Schätzer unter allen unbiased Schätzern macht. Es kann jedoch gezeigt werden, dass der verzerrte Schätzer "besser" ist als der im Hinblick auf das Kriterium des mittleren quadratischen Fehlers (MSE). Bei endlichen Stichproben haben beide und eine skalierte Chi-Quadrat-Verteilung mit (n - 1) Freiheitsgraden:

Der erste dieser Ausdrücke zeigt, dass die Varianz von gleich ist zu was etwas größer ist als das σσ-Element der inversen Fisher-Informationsmatrix . Daher kein effizienter Schätzer für , und da darüber hinaus UMVU ist, können wir schlussfolgern, dass der effiziente Finite-Stichproben-Schätzer für nicht existiert. ⓘ

Unter Anwendung der asymptotischen Theorie sind beide Schätzer und konsistent, d. h. sie konvergieren mit einer bestimmten Wahrscheinlichkeit zu wenn der Stichprobenumfang . Die beiden Schätzer sind auch beide asymptotisch normal:

Insbesondere sind beide Schätzer asymptotisch effizient für . ⓘ

Konfidenzintervalle

Nach dem Theorem von Cochran sind bei Normalverteilungen der Stichprobenmittelwert und die Stichprobenvarianz s2 unabhängig, was bedeutet, dass es keinen Gewinn bringt, ihre gemeinsame Verteilung zu betrachten. Es gibt auch ein umgekehrtes Theorem: Wenn in einer Stichprobe der Stichprobenmittelwert und die Stichprobenvarianz unabhängig sind, dann muss die Stichprobe aus der Normalverteilung stammen. Die Unabhängigkeit zwischen und s kann verwendet werden, um die sogenannte t-Statistik zu konstruieren:

Diese Größe t hat die Student's t-Verteilung mit (n - 1) Freiheitsgraden und ist eine Hilfsstatistik (unabhängig vom Wert der Parameter). Die Umkehrung der Verteilung dieser t-Statistik ermöglicht es, das Konfidenzintervall für μ zu konstruieren; in ähnlicher Weise erhält man durch die Umkehrung der χ2-Verteilung der Statistik s2 das Konfidenzintervall für σ2:

wobei tk,p und χ 2

k,p die p-ten Quantile der t- bzw. χ2-Verteilung sind. Diese Konfidenzintervalle haben das Konfidenzniveau 1 - α, was bedeutet, dass die wahren Werte μ und σ2 mit der Wahrscheinlichkeit (oder dem Signifikanzniveau) α außerhalb dieser Intervalle liegen. In der Praxis nimmt man gewöhnlich α = 5 % an, was zu Konfidenzintervallen von 95 % führt. ⓘ

Näherungsformeln lassen sich aus den asymptotischen Verteilungen von und s2 ableiten:

Die Näherungsformeln werden für große Werte von n gültig und sind für die manuelle Berechnung bequemer, da die Standard-Normalquantile zα/2 nicht von n abhängen. Insbesondere der am häufigsten verwendete Wert von α = 5 % führt zu |z0,025| = 1,96. ⓘ

Normalitätstests

Normalitätstests bewerten die Wahrscheinlichkeit, dass der gegebene Datensatz {x1, ..., xn} aus einer Normalverteilung stammt. Üblicherweise lautet die Nullhypothese H0, dass die Beobachtungen normalverteilt sind mit einem nicht spezifizierten Mittelwert μ und einer Varianz σ2, während die Alternative Ha lautet, dass die Verteilung willkürlich ist. Viele Tests (über 40) wurden für dieses Problem entwickelt. Die wichtigsten davon werden im Folgenden beschrieben: Diagnostische Diagramme sind intuitiv ansprechender, aber gleichzeitig subjektiv, da sie auf einer informellen menschlichen Beurteilung beruhen, um die Nullhypothese zu akzeptieren oder zu verwerfen.

- Q-Q-Diagramm, auch bekannt als Normalwahrscheinlichkeitsdiagramm oder Rankit-Diagramm, ist ein Diagramm der sortierten Werte des Datensatzes gegen die erwarteten Werte der entsprechenden Quantile der Standardnormalverteilung. Das heißt, es handelt sich um eine Darstellung von Punkten der Form (Φ-1(pk), x(k)), wobei die gezeichneten Punkte pk gleich pk = (k - α)/(n + 1 - 2α) sind und α eine Anpassungskonstante ist, die zwischen 0 und 1 liegen kann. Wenn die Nullhypothese wahr ist, sollten die gezeichneten Punkte ungefähr auf einer Geraden liegen.

- P-P-Diagramm - ähnelt dem Q-Q-Diagramm, wird aber viel seltener verwendet. Bei dieser Methode werden die Punkte (Φ(z(k)), pk) geplottet, wobei . Bei normalverteilten Daten sollte diese Darstellung auf einer 45°-Linie zwischen (0, 0) und (1, 1) liegen.

Anpassungsgütetests: Momentenbasierte Tests:

- D'Agostino's K-Quadrat-Test

- Jarque-Bera-Test

- Shapiro-Wilk-Test: Dieser basiert auf der Tatsache, dass die Linie im Q-Q-Diagramm die Steigung σ hat. Der Test vergleicht die Schätzung der kleinsten Quadrate dieser Steigung mit dem Wert der Stichprobenvarianz und lehnt die Nullhypothese ab, wenn sich diese beiden Größen signifikant unterscheiden.

Tests auf der Grundlage der empirischen Verteilungsfunktion:

- Anderson-Darling-Test

- Lilliefors-Test (eine Anpassung des Kolmogorov-Smirnov-Tests) ⓘ

Mit Hilfe von Quantil-Quantil-Diagrammen bzw. Normal-Quantil-Diagrammen ist eine einfache grafische Überprüfung auf Normalverteilung möglich.

Mit der Maximum-Likelihood-Methode können die Parameter und der Normalverteilung geschätzt und die empirischen Daten mit der angepassten Normalverteilung grafisch verglichen werden. ⓘ

Bayes'sche Analyse der Normalverteilung

Die Bayes'sche Analyse normalverteilter Daten wird durch die vielen verschiedenen Möglichkeiten erschwert, die in Betracht gezogen werden können:

- Entweder der Mittelwert oder die Varianz oder keines von beiden kann als feste Größe betrachtet werden.

- Wenn die Varianz nicht bekannt ist, kann die Analyse direkt in Form der Varianz oder in Form der Präzision, dem Kehrwert der Varianz, durchgeführt werden. Der Grund dafür, die Formeln in Form der Präzision auszudrücken, ist, dass die Analyse der meisten Fälle vereinfacht wird.

- Es müssen sowohl univariate als auch multivariate Fälle berücksichtigt werden.

- Den unbekannten Variablen können entweder konjugierte oder unzulässige Prioritätsverteilungen zugewiesen werden.

- Eine zusätzliche Gruppe von Fällen tritt bei der linearen Bayes'schen Regression auf, bei der im Basismodell von normalverteilten Daten ausgegangen wird und den Regressionskoeffizienten Normalprioritäten zugewiesen werden. Die sich daraus ergebende Analyse ähnelt den Grundfällen unabhängiger, identisch verteilter Daten. ⓘ

Die Formeln für die nichtlinearen Regressionsfälle sind in dem Artikel über konjugierte Prioren zusammengefasst. ⓘ

Summe von zwei quadratischen Gleichungen

Skalare Form

Die folgende Hilfsformel ist nützlich zur Vereinfachung der Gleichungen zur Aktualisierung der Posteriorwerte, die sonst ziemlich mühsam werden. ⓘ

Diese Gleichung schreibt die Summe von zwei quadratischen Gleichungen in x um, indem sie die Quadrate erweitert, die Terme in x gruppiert und das Quadrat vervollständigt. Beachten Sie die folgenden Hinweise zu den komplexen konstanten Faktoren, die an einige der Terme angehängt sind:

- Der Faktor hat die Form eines gewichteten Durchschnitts von y und z.

- Dies zeigt, dass dieser Faktor aus einer Situation resultiert, in der sich die Kehrwerte der Mengen a und b direkt addieren. Um also a und b selbst zu kombinieren, muss man das Ergebnis reziprokieren, addieren und wieder reziprokieren, um wieder zu den ursprünglichen Einheiten zu gelangen. Dies ist genau die Art von Operation, die der harmonische Mittelwert durchführt, daher ist es nicht überraschend, dass die Hälfte des harmonischen Mittels von a und b ist. ⓘ

Vektorielle Form

Eine ähnliche Formel lässt sich für die Summe von zwei Vektorquadraten aufstellen: Wenn x, y, z Vektoren der Länge k sind, und A und B symmetrische, invertierbare Matrizen der Größe , dann ⓘ

wobei ⓘ

Man beachte, dass die Form x′ A x als quadratische Form bezeichnet wird und ein Skalar ist:

Mit anderen Worten, sie summiert alle möglichen Kombinationen von Produkten von Paaren von Elementen aus x, mit einem separaten Koeffizienten für jedes. Darüber hinaus, da nur die Summe für alle Elemente außerhalb der Diagonalen von A von Bedeutung, und es bedeutet keinen Verlust an Allgemeinheit, wenn man annimmt, dass A symmetrisch ist. Wenn A symmetrisch ist, dann ist die Form ⓘ

Summe der Differenzen vom Mittelwert

Eine weitere nützliche Formel lautet wie folgt:

Bei bekannter Varianz

Für eine Menge von i.i.d. normalverteilten Datenpunkten X der Größe n, bei der jeder einzelne Punkt x mit bekannter Varianz σ2 folgt, ist die konjugierte Prioritätsverteilung ebenfalls normalverteilt. ⓘ

Dies lässt sich einfacher zeigen, indem man die Varianz als Genauigkeit umschreibt, d. h. τ = 1/σ2 verwendet. Wenn dann und gehen wir wie folgt vor. ⓘ

Zunächst ist die Wahrscheinlichkeitsfunktion (unter Verwendung der obigen Formel für die Summe der Differenzen zum Mittelwert):

Dann gehen wir wie folgt vor:

In der obigen Herleitung haben wir die obige Formel für die Summe zweier Quadratzahlen verwendet und alle konstanten Faktoren eliminiert, die nicht zu μ gehören. Das Ergebnis ist der Kern einer Normalverteilung, mit Mittelwert und Genauigkeit d.h. ⓘ

Dies kann als eine Reihe von Bayes'schen Aktualisierungsgleichungen für die Posterior-Parameter in Bezug auf die Prior-Parameter geschrieben werden:

Das heißt, um n Datenpunkte mit einer Gesamtpräzision von nτ (oder äquivalent dazu einer Gesamtvarianz von n/σ2) und einem Mittelwert von Werten zu kombinieren eine neue Gesamtpräzision ableiten, indem man einfach die Gesamtpräzision der Daten zur vorherigen Gesamtpräzision addiert, und einen neuen Mittelwert durch einen präzisionsgewichteten Mittelwert bilden, d. h. einen gewichteten Mittelwert aus dem Datenmittelwert und dem vorherigen Mittelwert, jeweils gewichtet mit der zugehörigen Gesamtpräzision. Dies ist logisch, wenn man sich die Präzision als Indikator für die Sicherheit der Beobachtungen vorstellt: In der Verteilung des posterioren Mittelwerts wird jede der Eingabekomponenten mit ihrer Gewissheit gewichtet, und die Gewissheit dieser Verteilung ist die Summe der einzelnen Gewissheiten. (Zur Veranschaulichung vergleiche man den Ausdruck "das Ganze ist (oder ist nicht) größer als die Summe seiner Teile". Außerdem ist zu bedenken, dass das Wissen über das Posterior aus einer Kombination des Wissens über das Prior und die Wahrscheinlichkeit resultiert, so dass es sinnvoll ist, dass wir uns dessen sicherer sind als einer seiner Komponenten). ⓘ

Die obige Formel verdeutlicht, warum es bequemer ist, die Bayes'sche Analyse konjugierter Prioren für die Normalverteilung in Bezug auf die Präzision durchzuführen. Die Posterior-Präzision ist einfach die Summe der Prior- und Likelihood-Präzisionen, und der Posterior-Mittelwert wird, wie oben beschrieben, durch einen präzisionsgewichteten Durchschnitt berechnet. Die gleichen Formeln lassen sich auch als Varianzformeln schreiben, indem man alle Präzisionswerte reziprokiert, was zu den folgenden unschönen Formeln führt ⓘ

Bei bekanntem Mittelwert

Für eine Menge von i.i.d. normalverteilten Datenpunkten X der Größe n, bei der jeder einzelne Punkt x mit bekanntem Mittelwert μ hat der konjugierte Prior der Varianz eine inverse Gammaverteilung oder eine skalierte inverse Chi-Quadrat-Verteilung. Die beiden sind gleichwertig, haben aber unterschiedliche Parametrisierungen. Obwohl die inverse Gamma-Verteilung häufiger verwendet wird, verwenden wir der Einfachheit halber die skalierte inverse Chi-Quadrat-Verteilung. Der Prior für σ2 lautet wie folgt:

Die Likelihood-Funktion von oben, geschrieben in Form der Varianz, ist:

wobei ⓘ

Dann:

Das obige ist auch eine skalierte inverse Chi-Quadrat-Verteilung, wobei ⓘ

oder äquivalent ⓘ

Durch Reparametrisierung im Sinne einer inversen Gamma-Verteilung ergibt sich folgendes Ergebnis:

Mit unbekanntem Mittelwert und unbekannter Varianz

Für eine Menge von i.i.d. normalverteilten Datenpunkten X der Größe n, bei der jeder einzelne Punkt x mit unbekanntem Mittelwert μ und unbekannter Varianz σ2 wird ein kombinierter (multivariater) konjugierter Prior über den Mittelwert und die Varianz gelegt, der aus einer Normal-Invers-Gamma-Verteilung besteht. Logischerweise ergibt sich dies wie folgt:

- Aus der Analyse des Falles mit unbekanntem Mittelwert, aber bekannter Varianz geht hervor, dass die Aktualisierungsgleichungen hinreichende Statistiken beinhalten, die aus den Daten berechnet werden und aus dem Mittelwert der Datenpunkte und der Gesamtvarianz der Datenpunkte bestehen, die wiederum aus der bekannten Varianz geteilt durch die Anzahl der Datenpunkte berechnet wird.

- Aus der Analyse des Falles mit unbekannter Varianz aber bekanntem Mittelwert geht hervor, dass die Aktualisierungsgleichungen ausreichende Statistiken über die Daten beinhalten, die aus der Anzahl der Datenpunkte und der Summe der quadrierten Abweichungen bestehen.

- Denken Sie daran, dass die posterioren Aktualisierungswerte bei der Verarbeitung weiterer Daten als Prioritätsverteilung dienen. Daher sollten wir unsere Prioritäten logischerweise in Form der soeben beschriebenen hinreichenden Statistiken betrachten, wobei die gleiche Semantik so weit wie möglich beibehalten werden sollte.

- Um den Fall zu behandeln, dass sowohl Mittelwert als auch Varianz unbekannt sind, könnten wir unabhängige Prioritäten über den Mittelwert und die Varianz setzen, mit festen Schätzungen des durchschnittlichen Mittelwerts, der Gesamtvarianz, der Anzahl der Datenpunkte, die zur Berechnung des Varianzpriors verwendet werden, und der Summe der quadrierten Abweichungen. Beachten Sie jedoch, dass in der Realität die Gesamtvarianz des Mittelwerts von der unbekannten Varianz abhängt und die Summe der quadrierten Abweichungen, die in den Varianzprior eingeht, (scheinbar) vom unbekannten Mittelwert abhängt. In der Praxis ist die letztgenannte Abhängigkeit relativ unwichtig: Durch die Verschiebung des tatsächlichen Mittelwerts verschieben sich die erzeugten Punkte um den gleichen Betrag, und die quadrierten Abweichungen bleiben im Durchschnitt gleich. Bei der Gesamtvarianz des Mittelwerts ist dies jedoch nicht der Fall: Wenn die unbekannte Varianz zunimmt, nimmt die Gesamtvarianz des Mittelwerts proportional zu, und wir möchten diese Abhängigkeit erfassen.

- Dies legt nahe, einen bedingten Prior des Mittelwerts auf der unbekannten Varianz zu erstellen, mit einem Hyperparameter, der den Mittelwert der mit dem Prior verbundenen Pseudobeobachtungen angibt, und einem weiteren Parameter, der die Anzahl der Pseudobeobachtungen angibt. Diese Anzahl dient als Skalierungsparameter für die Varianz und ermöglicht es, die Gesamtvarianz des Mittelwerts im Verhältnis zum tatsächlichen Varianzparameter zu steuern. Der Prior für die Varianz hat ebenfalls zwei Hyperparameter, von denen einer die Summe der quadrierten Abweichungen der Pseudobeobachtungen angibt, die mit dem Prior verbunden sind, und ein anderer wiederum die Anzahl der Pseudobeobachtungen spezifiziert. Man beachte, dass jeder der Prioren einen Hyperparameter hat, der die Anzahl der Pseudobeobachtungen angibt, und in jedem Fall steuert dieser die relative Varianz dieses Priors. Diese werden als zwei separate Hyperparameter angegeben, so dass die Varianz (auch Konfidenz genannt) der beiden Prioren getrennt gesteuert werden kann.

- Dies führt unmittelbar zur Normal-Inverse-Gamma-Verteilung, die das Produkt der beiden soeben definierten Verteilungen ist, wobei konjugierte Prioren verwendet werden (eine Inverse-Gamma-Verteilung über die Varianz und eine Normalverteilung über den Mittelwert, bedingt durch die Varianz) und mit denselben vier Parametern wie eben definiert. ⓘ

Die Prioritäten sind normalerweise wie folgt definiert:

Die Aktualisierungsgleichungen können abgeleitet werden und sehen wie folgt aus:

Zu der jeweiligen Anzahl der Pseudobeobachtungen wird die Anzahl der tatsächlichen Beobachtungen addiert. Der neue mittlere Hyperparameter ist wiederum ein gewichteter Durchschnitt, diesmal gewichtet nach der relativen Anzahl der Beobachtungen. Schließlich ist die Aktualisierung für ähnelt dem Fall mit bekanntem Mittelwert, aber in diesem Fall wird die Summe der quadrierten Abweichungen in Bezug auf den beobachteten Datenmittelwert und nicht auf den wahren Mittelwert genommen, und folglich muss ein neuer "Interaktionsterm" hinzugefügt werden, um die zusätzliche Fehlerquelle zu berücksichtigen, die sich aus der Abweichung zwischen Prior und Datenmittelwert ergibt. ⓘ

Die Priorverteilungen sind

Daher ist der gemeinsame Prior

Die Likelihood-Funktion aus dem obigen Abschnitt mit bekannter Varianz ist:

Wenn man sie in Form der Varianz und nicht der Genauigkeit schreibt, erhält man:

wobei

Das Posterior ist also (ohne Berücksichtigung der Hyperparameter als Konditionierungsfaktoren):

Mit anderen Worten, die Posterior-Verteilung hat die Form eines Produkts aus einer Normalverteilung über p(μ | σ2) mal einer inversen Gamma-Verteilung über p(σ2), mit Parametern, die die gleichen sind wie die obigen Aktualisierungsgleichungen. ⓘ

Vorkommen und Anwendungen

Das Auftreten von Normalverteilungen in praktischen Problemen lässt sich grob in vier Kategorien einteilen:

- Genaue Normalverteilungen;

- Näherungsweise Normalgesetze, z. B. wenn eine solche Näherung durch den zentralen Grenzwertsatz gerechtfertigt ist; und

- Verteilungen, die als normal modelliert werden - die Normalverteilung ist die Verteilung mit der maximalen Entropie für einen bestimmten Mittelwert und eine bestimmte Varianz.

- Regressionsprobleme - die Normalverteilung wird gefunden, nachdem systematische Effekte ausreichend gut modelliert worden sind. ⓘ

Exakte Normalität

Bestimmte Größen in der Physik sind normalverteilt, wie erstmals von James Clerk Maxwell nachgewiesen wurde. Beispiele für solche Größen sind:

- Wahrscheinlichkeitsdichtefunktion eines Grundzustands in einem harmonischen Quantenoszillator.

- Die Position eines Teilchens, das eine Diffusion erfährt. Befindet sich das Teilchen zu Beginn an einem bestimmten Punkt (d. h. seine Wahrscheinlichkeitsverteilung ist die Dirac-Delta-Funktion), so wird sein Ort nach der Zeit t durch eine Normalverteilung mit der Varianz t beschrieben, die die Diffusionsgleichung erfüllt . Wenn der Anfangsort durch eine bestimmte Dichtefunktion gegeben ist gegeben ist, dann ist die Dichte zum Zeitpunkt t die Faltung von g und der normalen PDF. ⓘ

Annähernde Normalität

Näherungsweise Normalverteilungen treten in vielen Situationen auf, wie im zentralen Grenzwertsatz erklärt wird. Wenn das Ergebnis durch viele kleine Effekte hervorgerufen wird, die additiv und unabhängig voneinander wirken, ist die Verteilung annähernd normal. Die Annäherung an die Normalverteilung ist nicht gültig, wenn die Effekte multiplikativ (statt additiv) wirken oder wenn es einen einzigen externen Einfluss gibt, der wesentlich größer ist als die übrigen Effekte.

- Bei Zählproblemen, bei denen der zentrale Grenzwertsatz eine diskret-kontinuierliche Annäherung beinhaltet und bei denen unendlich teilbare und zerlegbare Verteilungen beteiligt sind, wie z. B.

- Binomiale Zufallsvariablen, die mit binären Antwortvariablen verbunden sind;

- Poisson-Zufallsvariablen, die mit seltenen Ereignissen verbunden sind;

- Wärmestrahlung hat auf sehr kurzen Zeitskalen eine Bose-Einstein-Verteilung und auf längeren Zeitskalen aufgrund des zentralen Grenzwertsatzes eine Normalverteilung. ⓘ

Angenommene Normalität

Das Auftreten der Normalkurve - der Laplacian-Kurve der Fehler - kann ich nur als ein sehr anormales Phänomen erkennen. Sie wird in bestimmten Verteilungen grob angenähert; aus diesem Grund und wegen ihrer schönen Einfachheit können wir sie vielleicht als erste Annäherung verwenden, insbesondere bei theoretischen Untersuchungen.

- Pearson (1901)

Es gibt statistische Methoden, um diese Annahme empirisch zu testen; siehe den obigen Abschnitt Normalitätstests.

- In der Biologie neigen die Logarithmen verschiedener Variablen dazu, eine Normalverteilung zu haben, d. h. sie neigen dazu, eine Log-Normalverteilung zu haben (nach der Trennung in männliche/weibliche Teilpopulationen), mit Beispielen wie:

- Größenmaße von lebendem Gewebe (Länge, Größe, Hautfläche, Gewicht);

- Die Länge von trägen Anhängseln (Haare, Krallen, Nägel, Zähne) biologischer Exemplare in Wachstumsrichtung; vermutlich fällt auch die Dicke von Baumrinde in diese Kategorie;

- Bestimmte physiologische Messungen, wie der Blutdruck eines erwachsenen Menschen.

- Im Finanzwesen, insbesondere im Black-Scholes-Modell, werden Veränderungen des Logarithmus von Wechselkursen, Preisindizes und Börsenindizes als normal angenommen (diese Variablen verhalten sich wie Zinseszinsen, nicht wie einfache Zinsen, und sind daher multiplikativ). Einige Mathematiker wie Benoit Mandelbrot haben argumentiert, dass die Log-Levy-Verteilung, die schwere Schwänze aufweist, ein geeigneteres Modell wäre, insbesondere für die Analyse von Börsencrashs. Nassim Nicholas Taleb hat in seinen Werken die Verwendung der Normalverteilung in Finanzmodellen kritisiert.

- Messfehler in physikalischen Experimenten werden oft durch eine Normalverteilung modelliert. Die Verwendung einer Normalverteilung bedeutet nicht, dass man davon ausgeht, dass die Messfehler normalverteilt sind, vielmehr führt die Verwendung der Normalverteilung zu möglichst konservativen Vorhersagen, wenn man nur den Mittelwert und die Varianz der Fehler kennt.

- Bei standardisierten Tests können die Ergebnisse normalverteilt werden, indem man entweder die Anzahl und den Schwierigkeitsgrad der Fragen auswählt (wie beim IQ-Test) oder die rohen Testergebnisse durch Anpassung an die Normalverteilung in "Output"-Werte umwandelt. Der traditionelle Bereich des SAT von 200-800 basiert beispielsweise auf einer Normalverteilung mit einem Mittelwert von 500 und einer Standardabweichung von 100. ⓘ

- Viele Werte werden von der Normalverteilung abgeleitet, darunter Perzentilränge ("Perzentile" oder "Quantile"), Normalkurvenäquivalente, Stanine, z-Scores und T-Scores. Darüber hinaus wird bei einigen verhaltensstatistischen Verfahren davon ausgegangen, dass die Ergebnisse normalverteilt sind, z. B. bei t-Tests und ANOVAs. Bei der Benotung nach der Glockenkurve werden relative Noten auf der Grundlage einer Normalverteilung der Noten vergeben.

- In der Hydrologie wird die Verteilung von lang anhaltenden Flussabflüssen oder Niederschlägen, z. B. Monats- und Jahressummen, gemäß dem zentralen Grenzwertsatz häufig als praktisch normal verteilt angesehen. Das blaue Bild, das mit CumFreq erstellt wurde, zeigt ein Beispiel für die Anpassung der Normalverteilung an die geordneten Oktober-Regenfälle, wobei der 90%ige Vertrauensbereich auf der Grundlage der Binomialverteilung dargestellt ist. Die Niederschlagsdaten werden als Teil der kumulativen Häufigkeitsanalyse durch das Einzeichnen von Positionen dargestellt. ⓘ

Methodische Probleme und Peer-Review

John Ioannidis argumentiert, dass die Verwendung normalverteilter Standardabweichungen als Maßstab für die Validierung von Forschungsergebnissen falsifizierbare Vorhersagen über nicht normalverteilte Phänomene ungetestet lässt. Dazu gehören beispielsweise Phänomene, die nur auftreten, wenn alle notwendigen Bedingungen gegeben sind, und von denen eines ein anderes nicht auf additive Weise ersetzen kann, sowie Phänomene, die nicht zufällig verteilt sind. Ioannidis argumentiert, dass die standardabweichungszentrierte Validierung Hypothesen und Theorien, bei denen einige, aber nicht alle falsifizierbaren Vorhersagen normalverteilt sind, einen falschen Anschein von Gültigkeit verleiht, da der Teil der falsifizierbaren Vorhersagen, gegen den es Beweise gibt, in den nicht normalverteilten Teilen des Bereichs der falsifizierbaren Vorhersagen liegen kann und in einigen Fällen auch liegt, sowie Hypothesen, für die keine der falsifizierbaren Vorhersagen normalverteilt sind, grundlos als unfalsifizierbar abtut, obwohl sie tatsächlich falsifizierbare Vorhersagen machen. Ioannidis argumentiert, dass viele Fälle, in denen sich gegenseitig ausschließende Theorien von Forschungszeitschriften als "bestätigt" akzeptiert werden, darauf zurückzuführen sind, dass die Zeitschriften empirische Falsifikationen von nicht normalverteilten Vorhersagen nicht berücksichtigen, und nicht darauf, dass sich gegenseitig ausschließende Theorien wahr sind, was sie nicht sein können, obwohl zwei sich gegenseitig ausschließende Theorien beide falsch und eine dritte richtig sein kann. ⓘ

Berechnungsmethoden

Generierung von Werten aus der Normalverteilung

Bei Computersimulationen, insbesondere bei Anwendungen der Monte-Carlo-Methode, ist es oft wünschenswert, normalverteilte Werte zu erzeugen. Die unten aufgeführten Algorithmen erzeugen alle die Standardnormalabweichungen, da ein N(μ, σ2) als X = μ + σZ erzeugt werden kann, wobei Z standardnormal ist. Alle diese Algorithmen setzen voraus, dass ein Zufallszahlengenerator U zur Verfügung steht, der in der Lage ist, gleichmäßige Zufallsvariablen zu erzeugen.

- Die einfachste Methode basiert auf der Eigenschaft der Wahrscheinlichkeitsintegraltransformation: Wenn U gleichmäßig auf (0,1) verteilt ist, dann hat Φ-1(U) die Standardnormalverteilung. Der Nachteil dieser Methode ist, dass sie auf der Berechnung der Probit-Funktion Φ-1 beruht, die nicht analytisch durchgeführt werden kann. Einige Näherungsmethoden sind in Hart (1968) und in dem erf-Artikel beschrieben. Wichura gibt einen schnellen Algorithmus zur Berechnung dieser Funktion mit 16 Dezimalstellen an, der von R zur Berechnung von Zufallsvariablen der Normalverteilung verwendet wird.

- Ein einfach zu programmierender Näherungsansatz, der sich auf den zentralen Grenzwertsatz stützt, lautet wie folgt: Erzeugen Sie 12 gleichmäßige U(0,1)-Abweichungen, addieren Sie sie alle und ziehen Sie 6 ab - die resultierende Zufallsvariable hat annähernd die Standardnormalverteilung. In Wahrheit handelt es sich um eine Irwin-Hall-Verteilung, die eine 12-teilige polynomiale Annäherung an die Normalverteilung elfter Ordnung ist. Diese Zufallsabweichung hat einen begrenzten Bereich von (-6, 6). Beachten Sie, dass bei einer echten Normalverteilung nur 0,00034 % aller Stichproben außerhalb von ±6σ liegen.

- Bei der Box-Muller-Methode werden zwei unabhängige Zufallszahlen U und V verwendet, die gleichmäßig auf (0,1) verteilt sind. Dann haben die beiden Zufallsvariablen X und Y beide die Standardnormalverteilung und sind unabhängig. Diese Formulierung ergibt sich daraus, dass für einen bivariaten normalen Zufallsvektor (X, Y) die quadrierte Norm X2 + Y2 die Chi-Quadrat-Verteilung mit zwei Freiheitsgraden hat, was eine leicht zu erzeugende exponentielle Zufallsvariable ist, die der Größe -2ln(U) in diesen Gleichungen entspricht; und der Winkel ist gleichmäßig um den Kreis verteilt, der durch die Zufallsvariable V gewählt wird.

- Die Marsaglia-Polar-Methode ist eine Abwandlung der Box-Muller-Methode, die keine Berechnung der Sinus- und Kosinusfunktionen erfordert. Bei dieser Methode werden U und V aus der Gleichverteilung (-1,1) gezogen und anschließend wird S = U2 + V2 berechnet. Wenn S größer oder gleich 1 ist, beginnt die Methode von vorne, andernfalls werden die beiden Größen zurückgegeben. Auch hier sind X und Y unabhängige, standardnormale Zufallsvariablen.

- Die Ratio-Methode ist eine Ablehnungsmethode. Der Algorithmus geht wie folgt vor:

- Erzeugen Sie zwei unabhängige gleichmäßige Abweichungen U und V;

- Berechne X = √8/e (V - 0,5)/U;

- Optional: wenn X2 ≤ 5 - 4e1/4U, dann akzeptiere X und beende den Algorithmus;

- Fakultativ: wenn X2 ≥ 4e-1,35/U + 1,4, dann wird X zurückgewiesen und der Algorithmus beginnt wieder bei Schritt 1;

- Wenn X2 ≤ -4 lnU, dann wird X akzeptiert, andernfalls beginnt der Algorithmus von vorne.

- Durch die beiden optionalen Schritte kann die Auswertung des Logarithmus im letzten Schritt in den meisten Fällen vermieden werden. Diese Schritte können stark verbessert werden, so dass der Logarithmus nur noch selten ausgewertet wird.

- Der Ziggurat-Algorithmus ist schneller als die Box-Muller-Transformation und dennoch exakt. In etwa 97% aller Fälle benötigt er nur zwei Zufallszahlen, eine zufällige ganze Zahl und eine zufällige Uniform, eine Multiplikation und einen if-Test. Nur in 3 % der Fälle, in denen die Kombination dieser beiden außerhalb des "Kerns der Zikkurat" liegt (eine Art Ablehnungsstichprobe mit Logarithmen), müssen Exponentiale und einheitlichere Zufallszahlen verwendet werden.

- Mit Hilfe der ganzzahligen Arithmetik kann eine Stichprobe aus der Standardnormalverteilung gezogen werden. Diese Methode ist genau in dem Sinne, dass sie die Bedingungen der idealen Annäherung erfüllt, d. h. sie ist gleichbedeutend mit der Stichprobenziehung einer reellen Zahl aus der Standardnormalverteilung und der Rundung dieser Zahl auf die nächste darstellbare Gleitkommazahl.

- Es gibt auch einige Untersuchungen zum Zusammenhang zwischen der schnellen Hadamard-Transformation und der Normalverteilung, da die Transformation nur Addition und Subtraktion erfordert und durch den zentralen Grenzwertsatz Zufallszahlen aus fast jeder Verteilung in die Normalverteilung transformiert werden. In diesem Zusammenhang kann eine Reihe von Hadamard-Transformationen mit zufälligen Permutationen kombiniert werden, um beliebige Datensätze in normalverteilte Daten zu verwandeln. ⓘ

Numerische Näherungen für die Normal-CDF und die Normal-Quantil-Funktion

Die Standard-Normal-CDF wird in wissenschaftlichen und statistischen Berechnungen häufig verwendet. ⓘ

Die Werte Φ(x) können durch eine Vielzahl von Methoden, wie numerische Integration, Taylor-Reihen, asymptotische Reihen und Kettenbrüche, sehr genau angenähert werden. Je nach gewünschtem Genauigkeitsgrad werden unterschiedliche Näherungen verwendet. ⓘ

- Zelen & Severo (1964) geben die Approximation für Φ(x) für x > 0 mit dem absoluten Fehler |ε(x)| < 7,5-10-8 an (Algorithmus 26.2.17): wobei ϕ(x) die Standard-Normal-PDF ist, und b0 = 0,2316419, b1 = 0,319381530, b2 = -0,356563782, b3 = 1,781477937, b4 = -1,821255978, b5 = 1,330274429.