T-Test

Der t-Test ist ein Begriff aus der mathematischen Statistik, er bezeichnet eine Gruppe von Hypothesentests mit t-verteilter Testprüfgröße. Oft ist jedoch mit dem t-Test der Einstichproben- bzw. Zweistichproben-t-Test auf einen Mittelwertunterschied gemeint. ⓘ

- Der Einstichproben-t-Test (auch Einfacher t-Test; engl. one-sample t-test) prüft anhand des Mittelwertes einer Stichprobe, ob der Mittelwert einer Grundgesamtheit sich von einem vorgegebenen Sollwert unterscheidet. Dabei wird vorausgesetzt, dass die Daten der Stichprobe einer normalverteilten Grundgesamtheit entstammen bzw. es einen genügend großen Stichprobenumfang gibt, so dass der zentrale Grenzwertsatz erfüllt ist.

- Der Zweistichproben-t-Test (auch Doppelter t-Test; engl. two-sample t-test) prüft anhand der Mittelwerte zweier unabhängiger Stichproben, wie sich die Mittelwerte zweier Grundgesamtheiten zueinander verhalten. Dabei wird vorausgesetzt, dass die Daten der Stichproben einer normalverteilten Grundgesamtheit entstammen bzw. es genügend große Stichprobenumfänge gibt, so dass der zentrale Grenzwertsatz erfüllt ist. Der klassische t-Test setzt voraus, dass beide Stichproben aus Grundgesamtheiten mit gleicher Varianz entstammen. Der Welch-Test ist eine Variante, die die Gleichheit der Varianzen nicht voraussetzt.

- Der t-Differenzentest (auch Differenzen-t-Test oder Paardifferenzentest; engl. paired t-test) prüft mit den Differenzen der Messwerte von zwei Variablen, die an denselben Untersuchungseinheiten erfasst wurden, ob Mittelwertunterschiede bezüglich dieser beiden Variablen in der Grundgesamtheit vorliegen. In diesem Fall wird auch von verbundenen oder abhängigen Stichproben zur Unterscheidung vom Fall zweier unabhängiger Stichproben gesprochen. Der t-Differenzentest findet sich im zweiten Abschnitt des Artikels Zweistichproben-t-Test. Er setzt voraus, dass die Differenzen normalverteilt sind.

- Der t-Test des Regressionskoeffizienten prüft in der linearen Regression unter der Annahme normalverteilter Störgrößen, ob ein Regressionskoeffizient null ist.

- Steigers Z-Test prüft, ob der Bravais-Pearson-Korrelationskoeffizient gleich einem vorgegebenen Wert ist (z. B. gleich null). Dabei wird vorausgesetzt, dass die Daten der Stichproben einer bivariaten normalverteilten Grundgesamtheit entstammen. ⓘ

Der t-Test ist ein statistischer Hypothesentest, bei dem die Teststatistik unter der Nullhypothese einer Student's t-Verteilung folgt. ⓘ

Ein t-Test wird am häufigsten angewendet, wenn die Teststatistik einer Normalverteilung folgen würde, wenn der Wert eines Skalierungsterms in der Teststatistik bekannt wäre. Wenn der Skalierungsterm unbekannt ist und durch eine auf den Daten basierende Schätzung ersetzt wird, folgt die Teststatistik (unter bestimmten Bedingungen) einer Student's t-Verteilung. Der t-Test kann z. B. verwendet werden, um festzustellen, ob sich die Mittelwerte zweier Datensätze signifikant voneinander unterscheiden. ⓘ

Geschichte

Der Begriff "t-Statistik" ist eine Abkürzung für "Hypothesentest-Statistik". In der Statistik wurde die t-Verteilung erstmals 1876 von Helmert und Lüroth als Posteriorverteilung abgeleitet. Die t-Verteilung erschien auch in einer allgemeineren Form als Pearson Typ IV-Verteilung in Karl Pearsons Arbeit von 1895. Die T-Verteilung, die auch als Student's t-Verteilung bekannt ist, verdankt ihren Namen jedoch William Sealy Gosset, der sie erstmals 1908 in englischer Sprache in der wissenschaftlichen Zeitschrift Biometrika unter dem Pseudonym "Student" veröffentlichte, weil sein Arbeitgeber es vorzog, dass seine Mitarbeiter bei der Veröffentlichung wissenschaftlicher Arbeiten Pseudonyme anstelle ihres richtigen Namens verwendeten. Gosset arbeitete bei der Guinness-Brauerei in Dublin, Irland, und interessierte sich für die Probleme kleiner Proben - zum Beispiel für die chemischen Eigenschaften von Gerste bei kleinen Probengrößen. Eine zweite Version der Etymologie des Begriffs Student lautet daher, dass Guinness nicht wollte, dass seine Konkurrenten wussten, dass sie den t-Test zur Bestimmung der Qualität des Rohmaterials verwendeten (siehe Student's t-distribution für eine detaillierte Geschichte dieses Pseudonyms, das nicht mit dem wörtlichen Begriff Student zu verwechseln ist). Obwohl der Begriff Student" nach William Gosset benannt ist, wurde die Verteilung erst durch die Arbeit von Ronald Fisher als Student's distribution" und Student's t-test" bekannt. ⓘ

Gosset wurde eingestellt, weil Claude Guinness die besten Absolventen von Oxford und Cambridge einstellte, um Biochemie und Statistik auf die industriellen Prozesse von Guinness anzuwenden. Gosset entwickelte den t-Test als wirtschaftliche Methode zur Überwachung der Qualität von Bier. Der t-Test wurde bei der Fachzeitschrift Biometrika eingereicht, dort akzeptiert und 1908 veröffentlicht. ⓘ

Guinness gewährte technischen Mitarbeitern Studienurlaub, den Gosset während der ersten beiden Semester des akademischen Jahres 1906-1907 im biometrischen Labor von Professor Karl Pearson am University College London nutzte. Die Identität von Gosset war damals den Kollegen aus der Statistik und dem Chefredakteur Karl Pearson bekannt. ⓘ

Verwendungen

Die am häufigsten verwendeten t-Tests sind Ein-Stichproben- und Zwei-Stichproben-Tests:

- Ein Ein-Stichproben-Lokalisierungstest prüft, ob der Mittelwert einer Grundgesamtheit einen in einer Nullhypothese angegebenen Wert hat.

- Ein Zwei-Stichproben-Lokalisierungstest der Nullhypothese, dass die Mittelwerte zweier Populationen gleich sind. Alle diese Tests werden in der Regel als Student's t-Tests bezeichnet, obwohl diese Bezeichnung streng genommen nur verwendet werden sollte, wenn die Varianzen der beiden Populationen ebenfalls als gleich angenommen werden; die Form des Tests, die verwendet wird, wenn diese Annahme entfällt, wird manchmal als Welch's t-Test bezeichnet. Diese Tests werden häufig als t-Tests für ungepaarte oder unabhängige Stichproben bezeichnet, da sie in der Regel angewendet werden, wenn sich die statistischen Einheiten, die den beiden zu vergleichenden Stichproben zugrunde liegen, nicht überschneiden. ⓘ

Annahmen

Die meisten Teststatistiken haben die Form t = Z/s, wobei Z und s Funktionen der Daten sind. ⓘ

Z kann empfindlich auf die Alternativhypothese reagieren (d. h. seine Größe ist tendenziell größer, wenn die Alternativhypothese wahr ist), während s ein Skalierungsparameter ist, mit dem die Verteilung von t bestimmt werden kann. ⓘ

Ein Beispiel: Beim t-Test für eine Stichprobe

wobei X der Stichprobenmittelwert aus einer Stichprobe X1, X2, ..., Xn, mit dem Umfang n ist, s der Standardfehler des Mittelwerts ist, der Schätzwert der Standardabweichung der Grundgesamtheit und μ der Mittelwert der Grundgesamtheit ist. ⓘ

Die Annahmen, die einem t-Test in der einfachsten Form zugrunde liegen, sind folgende:

- X folgt einer Normalverteilung mit Mittelwert μ und Varianz σ2/n

- s2(n - 1)/σ2 folgt einer χ2-Verteilung mit n - 1 Freiheitsgraden. Diese Annahme ist erfüllt, wenn die Beobachtungen, die zur Schätzung von s2 verwendet werden, aus einer Normalverteilung stammen (und i.i.d. für jede Gruppe).

- Z und s sind unabhängig. ⓘ

Beim t-Test, der die Mittelwerte zweier unabhängiger Stichproben vergleicht, sollten die folgenden Annahmen erfüllt sein:

- Die Mittelwerte der beiden zu vergleichenden Populationen sollten Normalverteilungen folgen. Unter schwachen Annahmen folgt dies bei großen Stichproben aus dem zentralen Grenzwertsatz, selbst wenn die Verteilung der Beobachtungen in jeder Gruppe nicht normal ist.

- Wenn die ursprüngliche Definition des t-Tests von Student verwendet wird, sollten die beiden zu vergleichenden Populationen die gleiche Varianz aufweisen (überprüfbar mit dem F-Test, dem Levene-Test, dem Bartlett-Test oder dem Brown-Forsythe-Test; oder grafisch bewertbar mit einem Q-Q-Plot). Wenn die Stichprobengrößen in den beiden zu vergleichenden Gruppen gleich sind, ist der ursprüngliche Student's t-Test sehr robust gegenüber dem Vorhandensein von ungleichen Varianzen. Der Welch'sche t-Test ist unempfindlich gegenüber der Gleichheit der Varianzen, unabhängig davon, ob die Stichprobengrößen ähnlich sind.

- Die Daten, die zur Durchführung des Tests verwendet werden, sollten entweder unabhängig von den beiden zu vergleichenden Populationen entnommen werden oder vollständig gepaart sein. Dies ist im Allgemeinen nicht anhand der Daten prüfbar, aber wenn bekannt ist, dass die Daten abhängig sind (z. B. gepaart durch das Testdesign), muss ein abhängiger Test angewendet werden. Bei teilweise gepaarten Daten können die klassischen unabhängigen t-Tests ungültige Ergebnisse liefern, da die Teststatistik möglicherweise nicht einer t-Verteilung folgt, während der abhängige t-Test suboptimal ist, da er die ungepaarten Daten verwirft. ⓘ

Die meisten t-Tests mit zwei Stichproben sind robust gegenüber allen außer großen Abweichungen von den Annahmen. ⓘ

Für die Genauigkeit erfordern der t-Test und der Z-Test Normalität der Stichprobenmittelwerte, und der t-Test erfordert zusätzlich, dass die Stichprobenvarianz einer skalierten χ2-Verteilung folgt und dass der Stichprobenmittelwert und die Stichprobenvarianz statistisch unabhängig sind. Die Normalität der einzelnen Datenwerte ist nicht erforderlich, wenn diese Bedingungen erfüllt sind. Nach dem zentralen Grenzwertsatz werden die Stichprobenmittelwerte von mäßig großen Stichproben häufig durch eine Normalverteilung angenähert, selbst wenn die Daten nicht normalverteilt sind. Bei nicht normalverteilten Daten kann die Verteilung der Stichprobenvarianz erheblich von einer χ2-Verteilung abweichen. ⓘ

Wenn der Stichprobenumfang jedoch groß ist, impliziert das Slutsky-Theorem, dass die Verteilung der Stichprobenvarianz nur geringe Auswirkungen auf die Verteilung der Teststatistik hat. Das heißt, wenn der Stichprobenumfang zunimmt:

- gemäß dem zentralen Grenzwertsatz.

- gemäß dem Gesetz der großen Zahlen.

- ⓘ

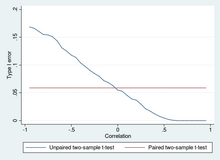

Ungepaarte und gepaarte t-Tests mit zwei Stichproben

Zwei-Stichproben-t-Tests für einen Mittelwertunterschied umfassen unabhängige Stichproben (ungepaarte Stichproben) oder gepaarte Stichproben. Gepaarte t-Tests sind eine Form des Blockings und haben eine größere Aussagekraft (Wahrscheinlichkeit, einen Fehler vom Typ II, auch bekannt als falsches Negativ, zu vermeiden) als ungepaarte Tests, wenn die gepaarten Einheiten in Bezug auf "Rauschfaktoren" ähnlich sind, die unabhängig von der Zugehörigkeit zu den beiden verglichenen Gruppen sind. In einem anderen Zusammenhang können gepaarte t-Tests verwendet werden, um die Auswirkungen von Störfaktoren in einer Beobachtungsstudie zu reduzieren. ⓘ

Unabhängige (ungepaarte) Stichproben

Der t-Test für unabhängige Stichproben wird verwendet, wenn zwei getrennte Sätze unabhängiger und identisch verteilter Stichproben erhalten werden und eine Variable aus jeder der beiden Populationen verglichen wird. Nehmen wir zum Beispiel an, dass wir die Wirkung einer medizinischen Behandlung bewerten und 100 Probanden in unsere Studie aufnehmen und dann 50 Probanden nach dem Zufallsprinzip der Behandlungsgruppe und 50 Probanden der Kontrollgruppe zuordnen. In diesem Fall haben wir zwei unabhängige Stichproben und würden die ungepaarte Form des t-Tests verwenden. ⓘ

Gepaarte Stichproben

T-Tests mit gepaarten Stichproben bestehen in der Regel aus einer Stichprobe von gepaarten Paaren ähnlicher Einheiten oder einer Gruppe von Einheiten, die zweimal getestet wurde (ein t-Test mit wiederholten Messungen). ⓘ

Ein typisches Beispiel für einen t-Test mit wiederholten Messungen wäre, wenn Probanden vor einer Behandlung, z. B. gegen Bluthochdruck, getestet werden und dieselben Probanden nach der Behandlung mit einem blutdrucksenkenden Medikament erneut getestet werden. Indem wir die Werte desselben Patienten vor und nach der Behandlung vergleichen, verwenden wir jeden Patienten als seine eigene Kontrolle. Auf diese Weise wird die korrekte Ablehnung der Nullhypothese (hier: kein Unterschied durch die Behandlung) sehr viel wahrscheinlicher, wobei sich die statistische Aussagekraft allein dadurch erhöht, dass die zufällige Variation zwischen den Patienten nun eliminiert wurde. Die Erhöhung der statistischen Aussagekraft hat jedoch ihren Preis: Es sind mehr Tests erforderlich, da jeder Proband zweimal getestet werden muss. Da die Hälfte der Stichprobe nun von der anderen Hälfte abhängt, hat die gepaarte Version des Student's t-Tests nur n/2 - 1 Freiheitsgrade (wobei n die Gesamtzahl der Beobachtungen ist). Paare werden zu einzelnen Testeinheiten, und die Stichprobe muss verdoppelt werden, um die gleiche Anzahl von Freiheitsgraden zu erreichen. Normalerweise gibt es n - 1 Freiheitsgrade (wobei n die Gesamtzahl der Beobachtungen ist). ⓘ

Ein t-Test für gepaarte Stichproben auf der Grundlage einer "gepaarten Stichprobe" ergibt sich aus einer ungepaarten Stichprobe, die anschließend zur Bildung einer gepaarten Stichprobe verwendet wird, indem zusätzliche Variablen verwendet werden, die zusammen mit der interessierenden Variable gemessen wurden. Der Abgleich erfolgt durch die Identifizierung von Wertepaaren, die aus je einer Beobachtung aus den beiden Stichproben bestehen, wobei das Paar in Bezug auf andere gemessene Variablen ähnlich ist. Dieser Ansatz wird manchmal in Beobachtungsstudien verwendet, um die Auswirkungen von Störfaktoren zu reduzieren oder zu eliminieren. ⓘ

T-Tests mit gepaarten Stichproben werden oft als "t-Tests mit abhängigen Stichproben" bezeichnet. ⓘ

Berechnungen

Im Folgenden werden explizite Ausdrücke angegeben, die zur Durchführung verschiedener t-Tests verwendet werden können. In jedem Fall wird die Formel für eine Teststatistik angegeben, die einer t-Verteilung unter der Nullhypothese entweder genau folgt oder sich ihr stark annähert. Auch die entsprechenden Freiheitsgrade sind in jedem Fall angegeben. Mit jeder dieser Statistiken kann entweder ein einseitiger oder ein zweiseitiger Test durchgeführt werden. ⓘ

Sobald der t-Wert und die Freiheitsgrade bestimmt sind, kann ein p-Wert anhand einer Tabelle mit Werten aus der Student's t-Verteilung ermittelt werden. Liegt der berechnete p-Wert unter dem für die statistische Signifikanz gewählten Schwellenwert (in der Regel 0,10, 0,05 oder 0,01), so wird die Nullhypothese zugunsten der Alternativhypothese verworfen. ⓘ

t-Test bei einer Stichprobe

Zum Testen der Nullhypothese, dass der Stichprobenmittelwert gleich einem bestimmten Wert μ0 ist, verwendet man die Statistik ⓘ

wobei der Stichprobenmittelwert, s die Standardabweichung der Stichprobe und n der Stichprobenumfang ist. Die bei diesem Test verwendeten Freiheitsgrade sind n - 1. Obwohl die Grundgesamtheit nicht normalverteilt zu sein braucht, wird die Verteilung der Grundgesamtheit der Stichprobenmittelwerte als normalverteilt angenommen. ⓘ

Nach dem zentralen Grenzwertsatz gilt, wenn die Beobachtungen unabhängig sind und das zweite Moment existiert, dass annähernd normal N(0;1) sein. ⓘ

Steigung einer Regressionsgeraden

Angenommen, man passt das Modell ⓘ

wobei x bekannt ist, α und β unbekannt sind, ε eine normalverteilte Zufallsvariable mit Mittelwert 0 und unbekannter Varianz σ2 ist und Y das interessierende Ergebnis ist. Wir wollen die Nullhypothese testen, dass die Steigung β gleich einem bestimmten Wert β0 ist (der oft als 0 angenommen wird, in diesem Fall ist die Nullhypothese, dass x und y unkorreliert sind). ⓘ

Sei ⓘ

Dann hat ⓘ

eine t-Verteilung mit n - 2 Freiheitsgraden, wenn die Nullhypothese wahr ist. Der Standardfehler des Steigungskoeffizienten:

kann in Bezug auf die Residuen geschrieben werden. Sei ⓘ

Dann ist der tscore gegeben durch:

Eine andere Möglichkeit, den tscore zu bestimmen, ist:

wobei r der Korrelationskoeffizient nach Pearson ist. ⓘ

Der tscore, Achsenabschnitt kann aus dem tscore, Steigung bestimmt werden:

wobei sx2 die Stichprobenvarianz ist. ⓘ

Unabhängiger t-Test für zwei Stichproben

Gleicher Stichprobenumfang und gleiche Varianz

Bei zwei Gruppen (1, 2) ist dieser Test nur anwendbar, wenn:

- die beiden Stichprobenumfänge (d.h. die Anzahl n der Teilnehmer jeder Gruppe) gleich sind;

- kann davon ausgegangen werden, dass die beiden Verteilungen die gleiche Varianz haben;

Verstöße gegen diese Annahmen werden im Folgenden erörtert. ⓘ

Die t-Statistik zur Prüfung, ob die Mittelwerte unterschiedlich sind, kann wie folgt berechnet werden:

wobei

Hier ist sp die gepoolte Standardabweichung für n = n1 = n2 und s 2

X1 und s 2

X2 sind die unverzerrten Schätzer der Varianzen der beiden Stichproben. Der Nenner von t ist der Standardfehler der Differenz zwischen zwei Mittelwerten. ⓘ

Für Signifikanztests sind die Freiheitsgrade für diesen Test 2n - 2, wobei n die Anzahl der Teilnehmer in jeder Gruppe ist. ⓘ

Gleicher oder ungleicher Stichprobenumfang, ähnliche Varianzen (1/2 < sX1/sX2 < 2)

Dieser Test wird nur verwendet, wenn angenommen werden kann, dass die beiden Verteilungen die gleiche Varianz haben. (Wenn diese Annahme verletzt ist, siehe unten.) Die vorstehenden Formeln sind ein Spezialfall der nachstehenden Formeln, die man erhält, wenn beide Stichproben gleich groß sind: n = n1 = n2. <span title="Aus: Englische Wikipedia, Abschnitt "Equal or unequal sample sizes, similar variances (1/2 < sX1/sX2 < 2)"" class="plainlinks"><_sX1/sX2_<_2) ⓘ

Die t-Statistik zur Prüfung, ob die Mittelwerte unterschiedlich sind, kann wie folgt berechnet werden:

- <span title="Aus: Englische Wikipedia, Abschnitt "Equal or unequal sample sizes, similar variances (1/2 < sX1/sX2 < 2)"" class="plainlinks"><_sX1/sX2_<_2) ⓘ

wobei <span title="Aus: Englische Wikipedia, Abschnitt "Equal or unequal sample sizes, similar variances (1/2 < sX1/sX2 < 2)"" class="plainlinks"><_sX1/sX2_<_2) ⓘ

- <span title="Aus: Englische Wikipedia, Abschnitt "Equal or unequal sample sizes, similar variances (1/2 < sX1/sX2 < 2)"" class="plainlinks"><_sX1/sX2_<_2) ⓘ

ist die gepoolte Standardabweichung der beiden Stichproben: Sie ist so definiert, dass ihr Quadrat ein unverzerrter Schätzer der gemeinsamen Varianz ist, unabhängig davon, ob die Populationsmittelwerte gleich sind oder nicht. In diesen Formeln ist ni - 1 die Anzahl der Freiheitsgrade für jede Gruppe, und der Gesamtstichprobenumfang minus zwei (d. h. n1 + n2 - 2) ist die Gesamtzahl der Freiheitsgrade, die bei Signifikanztests verwendet wird. <span title="Aus: Englische Wikipedia, Abschnitt "Equal or unequal sample sizes, similar variances (1/2 < sX1/sX2 < 2)"" class="plainlinks"><_sX1/sX2_<_2) ⓘ

Gleicher oder ungleicher Stichprobenumfang, ungleiche Varianzen (sX1 > 2sX2 oder sX2 > 2sX1)

Dieser Test, der auch als Welch's t-Test bekannt ist, wird nur verwendet, wenn die beiden Varianzen der Grundgesamtheit nicht als gleich angenommen werden (die beiden Stichprobenumfänge können gleich oder ungleich sein) und daher getrennt geschätzt werden müssen. Die t-Statistik, mit der geprüft wird, ob die Populationsmittelwerte unterschiedlich sind, wird wie folgt berechnet:

- 2sX2 or sX2 > 2sX1)"" class="plainlinks">>_2sX2_or_sX2_>_2sX1) ⓘ

wobei 2sX2 or sX2 > 2sX1)"" class="plainlinks">>_2sX2_or_sX2_>_2sX1) ⓘ

- 2sX2 or sX2 > 2sX1)"" class="plainlinks">>_2sX2_or_sX2_>_2sX1) ⓘ

Dabei ist si2 der unverzerrte Schätzer der Varianz jeder der beiden Stichproben mit ni = Anzahl der Teilnehmer in Gruppe i (i = 1 oder 2). In diesem Fall nicht eine gepoolte Varianz. Zur Verwendung bei Signifikanztests wird die Verteilung der Teststatistik als gewöhnliche Student's t-Verteilung approximiert, wobei die Freiheitsgrade wie folgt berechnet werden 2sX2 or sX2 > 2sX1)"" class="plainlinks">>_2sX2_or_sX2_>_2sX1) ⓘ

- 2sX2 or sX2 > 2sX1)"" class="plainlinks">>_2sX2_or_sX2_>_2sX1) ⓘ

Dies ist als Welch-Satterthwaite-Gleichung bekannt. Die tatsächliche Verteilung der Teststatistik hängt (geringfügig) von den beiden unbekannten Varianzen der Grundgesamtheit ab (siehe Behrens-Fisher-Problem). 2sX2 or sX2 > 2sX1)"" class="plainlinks">>_2sX2_or_sX2_>_2sX1) ⓘ

Abhängiger t-Test für gepaarte Stichproben

Dieser Test wird verwendet, wenn die Stichproben abhängig sind, d. h. wenn es nur eine Stichprobe gibt, die zweimal getestet wurde (wiederholte Messungen), oder wenn es zwei Stichproben gibt, die zusammengefügt oder "gepaart" wurden. Dies ist ein Beispiel für einen gepaarten Differenztest. Die t-Statistik wird wie folgt berechnet ⓘ

wobei und sind der Durchschnitt und die Standardabweichung der Unterschiede zwischen allen Paaren. Bei den Paaren handelt es sich z. B. entweder um die Ergebnisse einer Person vor und nach dem Test oder um Paare von Personen, die zu sinnvollen Gruppen zusammengefasst wurden (z. B. aus derselben Familie oder Altersgruppe: siehe Tabelle). Die Konstante μ0 ist Null, wenn geprüft werden soll, ob der Mittelwert der Differenz signifikant unterschiedlich ist. Der verwendete Freiheitsgrad ist n - 1, wobei n die Anzahl der Paare darstellt. ⓘ

Beispiel für wiederholte Messungen Nummer Name Test 1 Test 2 1 Mike 35% 67% 2 Melanie 50% 46% 3 Melissa 90% 86% 4 Mitchell 78% 91%

ⓘBeispiel für übereinstimmende Paare Paar Name Alter Test 1 John 35 250 1 Jane 36 340 2 Jimmy 22 460 2 Jessy 21 200

Praktische Beispiele

A1 bezeichne eine Menge, die durch Ziehen einer Zufallsstichprobe von sechs Messungen erhalten wurde:

und A2 bezeichne eine zweite, auf ähnliche Weise erhaltene Menge:

Dies könnten zum Beispiel die Gewichte von Schrauben sein, die aus einem Eimer ausgewählt wurden. ⓘ

Wir testen die Nullhypothese, dass die Mittelwerte der Populationen, aus denen die beiden Stichproben gezogen wurden, gleich sind. ⓘ

Die Differenz zwischen den beiden Stichprobenmittelwerten, die jeweils mit Xi bezeichnet werden und bei allen oben besprochenen Ansätzen für Zwei-Stichproben-Tests im Zähler stehen, beträgt ⓘ

Die Standardabweichungen für die beiden Stichproben betragen etwa 0,05 bzw. 0,11. Bei derart kleinen Stichproben wäre ein Test auf Gleichheit zwischen den beiden Varianzen der Grundgesamtheit nicht sehr aussagekräftig. Da die Stichprobengrößen gleich sind, werden die beiden Formen des t-Tests für zwei Stichproben in diesem Beispiel ähnlich abschneiden. ⓘ

Ungleiche Varianzen

Folgt man dem Ansatz für ungleiche Varianzen (siehe oben), so ergeben sich folgende Ergebnisse

und die Freiheitsgrade ⓘ

Die Teststatistik beträgt ungefähr 1,959, was einen zweiseitigen Test p-Wert von 0,09077 ergibt. ⓘ

Gleiche Varianzen

Wird der Ansatz für gleiche Varianzen (siehe oben) verfolgt, ergeben sich folgende Ergebnisse ⓘ

und die Freiheitsgrade ⓘ

Die Teststatistik ist ungefähr gleich 1,959, was einen zweiseitigen p-Wert von 0,07857 ergibt. ⓘ

Verwandte statistische Tests

Alternativen zum t-Test für Standortprobleme

Der t-Test ist ein exakter Test für die Gleichheit der Mittelwerte von zwei i.i.d. Normalpopulationen mit unbekannten, aber gleichen Varianzen. (Der Welch'sche t-Test ist ein nahezu exakter Test für den Fall, dass die Daten normal sind, aber die Varianzen unterschiedlich sein können.) Bei mäßig großen Stichproben und einem einseitigen Test ist der t-Test relativ robust gegenüber mäßigen Verstößen gegen die Normalitätsannahme. Bei hinreichend großen Stichproben nähert sich der t-Test asymptotisch dem z-Test an und wird selbst bei großen Abweichungen von der Normalität robust. ⓘ

Wenn die Daten im Wesentlichen nicht normal sind und der Stichprobenumfang gering ist, kann der t-Test zu irreführenden Ergebnissen führen. Siehe Standorttest für Gaußsche Skalenmischverteilungen für einige Theorien im Zusammenhang mit einer bestimmten Familie von Nicht-Normalverteilungen. ⓘ

Wenn die Normalitätsannahme nicht zutrifft, kann eine nichtparametrische Alternative zum t-Test eine bessere statistische Aussagekraft haben. Wenn die Daten jedoch nicht normal sind und die Varianzen zwischen den Gruppen unterschiedlich sind, kann ein t-Test eine bessere Typ-1-Fehlerkontrolle aufweisen als einige nichtparametrische Alternativen. Darüber hinaus testen nicht-parametrische Methoden, wie z. B. der Mann-Whitney-U-Test (siehe unten), in der Regel nicht auf einen Mittelwertunterschied und sollten daher mit Vorsicht eingesetzt werden, wenn ein Mittelwertunterschied von vorrangigem wissenschaftlichem Interesse ist. Beispielsweise hält der Mann-Whitney-U-Test den Fehler vom Typ 1 auf dem gewünschten Niveau Alpha, wenn beide Gruppen die gleiche Verteilung haben. Er hat auch die Kraft, eine Alternative aufzudecken, bei der Gruppe B die gleiche Verteilung wie A hat, aber nach einer Verschiebung um eine Konstante (in diesem Fall gäbe es tatsächlich einen Unterschied in den Mittelwerten der beiden Gruppen). Es könnte jedoch Fälle geben, in denen die Gruppen A und B unterschiedliche Verteilungen, aber die gleichen Mittelwerte haben (z. B. zwei Verteilungen, eine mit positiver Schiefe und die andere mit negativer Schiefe, aber so verschoben, dass sie die gleichen Mittelwerte haben). In solchen Fällen könnte MW mehr als das Alpha-Niveau haben, um die Nullhypothese abzulehnen, aber die Interpretation des Unterschieds der Mittelwerte auf ein solches Ergebnis zurückzuführen, wäre falsch. ⓘ

Bei Vorhandensein eines Ausreißers ist der t-Test nicht robust. Wenn beispielsweise bei zwei unabhängigen Stichproben die Datenverteilungen asymmetrisch sind (d. h. die Verteilungen sind schief) oder die Verteilungen große Schwänze haben, dann kann der Wilcoxon-Rangsummentest (auch bekannt als Mann-Whitney-U-Test) eine drei- bis viermal höhere Aussagekraft haben als der t-Test. Das nichtparametrische Gegenstück zum t-Test für gepaarte Stichproben ist der Wilcoxon-Signed-Rank-Test für gepaarte Stichproben. Für eine Diskussion über die Wahl zwischen dem t-Test und nichtparametrischen Alternativen siehe Lumley, et al. (2002). ⓘ

Die einseitige Varianzanalyse (ANOVA) verallgemeinert den t-Test für zwei Stichproben, wenn die Daten zu mehr als zwei Gruppen gehören. ⓘ

Ein Design, das sowohl gepaarte Beobachtungen als auch unabhängige Beobachtungen umfasst

Wenn sowohl gepaarte als auch unabhängige Beobachtungen im Zweistichproben-Design vorhanden sind, können unter der Annahme, dass die Daten vollständig zufällig fehlen (MCAR), die gepaarten oder unabhängigen Beobachtungen verworfen werden, um mit den oben genannten Standardtests fortzufahren. Alternativ kann unter Verwendung aller verfügbaren Daten, unter der Annahme von Normalität und MCAR, der verallgemeinerte t-Test für sich teilweise überschneidende Stichproben verwendet werden. ⓘ

Multivariate Tests

Eine Verallgemeinerung der Student's t-Statistik, die so genannte Hotelling's t-Quadrat-Statistik, ermöglicht die Prüfung von Hypothesen über mehrere (oft korrelierte) Messgrößen innerhalb derselben Stichprobe. Zum Beispiel könnte ein Forscher eine Reihe von Probanden einem Persönlichkeitstest unterziehen, der aus mehreren Persönlichkeitsskalen besteht (z. B. dem Minnesota Multiphasic Personality Inventory). Da die Messwerte dieser Art in der Regel positiv korreliert sind, ist es nicht ratsam, separate univariate t-Tests zum Testen der Hypothesen durchzuführen, da diese die Kovarianz zwischen den Messwerten vernachlässigen und die Wahrscheinlichkeit erhöhen würden, dass mindestens eine Hypothese fälschlicherweise abgelehnt wird (Fehler vom Typ I). In diesem Fall ist ein einziger multivariater Test für die Hypothesenprüfung vorzuziehen. Die Fisher-Methode zur Kombination mehrerer Tests mit reduziertem Alpha bei positiver Korrelation zwischen den Tests ist eine davon. Eine andere ist die T2-Statistik von Hotelling, die einer T2-Verteilung folgt. In der Praxis wird diese Verteilung jedoch nur selten verwendet, da tabellierte Werte für T2 schwer zu finden sind. In der Regel wird T2 stattdessen in eine F-Statistik umgewandelt. ⓘ

Bei einem multivariaten Einstichprobentest lautet die Hypothese, dass der mittlere Vektor (μ) gleich einem gegebenen Vektor (μ0) ist. Die Teststatistik ist Hotellings t2:

wobei n der Stichprobenumfang, x der Vektor der Spaltenmittelwerte und S eine m × m Stichproben-Kovarianzmatrix ist. ⓘ

Bei einem multivariaten Test mit zwei Stichproben lautet die Hypothese, dass die Mittelwertvektoren (μ1, μ2) von zwei Stichproben gleich sind. Die Teststatistik ist Hotellings Zwei-Stichproben-t2:

Software-Implementierungen

Viele Tabellenkalkulationsprogramme und Statistikpakete, wie z. B. QtiPlot, LibreOffice Calc, Microsoft Excel, SAS, SPSS, Stata, DAP, gretl, R, Python, PSPP, MATLAB und Minitab, enthalten Implementierungen des Studentschen t-Tests. ⓘ

| Sprache/Programm | Funktion | Hinweise ⓘ |

|---|---|---|

| Microsoft Excel vor 2010 | TTEST(array1, array2, Tails, Typ) |

Siehe [1] |

| Microsoft Excel 2010 und höher | T.TEST(Array1, Array2, Endwerte, Typ) |

Siehe [2] |

| Apple Numbers | TTEST(Stichprobe-1-Werte, Stichprobe-2-Werte, Tails, Testart) |

Siehe [3] |

| LibreOffice Calc | TTEST(Daten1; Daten2; Modus; Typ) |

Siehe [4] |

| Google Sheets | TTEST(bereich1, bereich2, tails, typ) |

Siehe [5] |

| Python | scipy.stats.ttest_ind(a, b, equal_var=True) |

Siehe [6] |

| MATLAB | ttest(Daten1, Daten2) |

Siehe [7] |

| Mathematica | TTest[{Daten1,Daten2}] |

Siehe [8] |

| R | t.test(Daten1, Daten2, var.equal=TRUE) |

Siehe [9] |

| SAS | PROC TTEST |

Siehe [10] |

| Java | tTest(Stichprobe1, Stichprobe2) |

Siehe [11] |

| Julia | EqualVarianceTTest(Stichprobe1, Stichprobe2) |

Siehe [12] |

| Stata | ttest Daten1 == Daten2 |

Siehe [13] |