Korrelation

In der Statistik bedeutet Korrelation oder Abhängigkeit jede statistische Beziehung, ob kausal oder nicht, zwischen zwei Zufallsvariablen oder bivariaten Daten. Obwohl der Begriff "Korrelation" im weitesten Sinne jede Art von Zusammenhang bezeichnen kann, bezieht er sich in der Statistik normalerweise auf das Ausmaß, in dem ein Paar von Variablen linear miteinander verbunden ist. Bekannte Beispiele für abhängige Phänomene sind die Korrelation zwischen der Körpergröße von Eltern und ihren Nachkommen sowie die Korrelation zwischen dem Preis einer Ware und der Menge, die die Verbraucher bereit sind zu kaufen, wie sie in der so genannten Nachfragekurve dargestellt wird. ⓘ

Korrelationen sind nützlich, weil sie auf eine vorhersagbare Beziehung hinweisen, die in der Praxis genutzt werden kann. Ein Stromversorgungsunternehmen könnte beispielsweise an einem milden Tag aufgrund der Korrelation zwischen der Stromnachfrage und dem Wetter weniger Strom produzieren. In diesem Beispiel besteht ein kausaler Zusammenhang, da extreme Wetterbedingungen die Menschen dazu veranlassen, mehr Strom zum Heizen oder Kühlen zu verwenden. Im Allgemeinen reicht jedoch das Vorhandensein einer Korrelation nicht aus, um auf das Vorhandensein einer kausalen Beziehung zu schließen (d. h. Korrelation impliziert keine Kausalität). ⓘ

Formal gesehen sind Zufallsvariablen abhängig, wenn sie eine mathematische Eigenschaft der probabilistischen Unabhängigkeit nicht erfüllen. Im informellen Sprachgebrauch ist Korrelation gleichbedeutend mit Abhängigkeit. Im technischen Sinne bezieht sich die Korrelation jedoch auf eine von mehreren spezifischen Arten von mathematischen Operationen zwischen den geprüften Variablen und ihren jeweiligen Erwartungswerten. Im Wesentlichen ist die Korrelation ein Maß dafür, wie zwei oder mehr Variablen zueinander in Beziehung stehen. Es gibt verschiedene Korrelationskoeffizienten, die oft mit oder bezeichnet, die den Grad der Korrelation messen. Der gebräuchlichste von ihnen ist der Pearson-Korrelationskoeffizient, der nur auf eine lineare Beziehung zwischen zwei Variablen anspricht (die auch dann gegeben sein kann, wenn eine Variable eine nichtlineare Funktion der anderen ist). Andere Korrelationskoeffizienten - wie z. B. die Spearmansche Rangkorrelation - wurden entwickelt, um robuster als der Pearson-Korrelationskoeffizient zu sein, d. h. empfindlicher gegenüber nichtlinearen Beziehungen. Die gegenseitige Information kann auch zur Messung der Abhängigkeit zwischen zwei Variablen verwendet werden. ⓘ

Eine Korrelation (mittellat. correlatio für „Wechselbeziehung“) beschreibt eine Beziehung zwischen zwei oder mehreren Merkmalen, Zuständen oder Funktionen. Die Beziehung muss keine kausale Beziehung sein: manche Elemente eines Systems beeinflussen sich gegenseitig nicht, oder es besteht eine stochastische, also vom Zufall beeinflusste Beziehung zwischen ihnen. ⓘ

- In der Statistik wird der Zusammenhang zwischen zwei statistischen Variablen mit verschiedenen Zusammenhangsmaßen gemessen. Ein bekanntes Zusammenhangmaß ist der Bravais-Pearson-Korrelationskoeffizient.

- In der Signalanalyse bzw. Bildanalyse wird zur Beschreibung des Zusammenhangs zweier Signale mit unterschiedlichen Zeit- bzw. Ortsverschiebungen die Kreuzkorrelationsfunktion eingesetzt. Für Details siehe Korrelation (Signalverarbeitung).

- In der Informationstheorie kann die allgemeine (nicht notwendigerweise lineare) Korrelation zweier Zufallsgrößen mit Hilfe der Transinformation quantifiziert werden.

- In der Softwaretechnik bezeichnet der Korrelationstest ein Verfahren, in dem nicht nur einzelne Parameter einer Funktion auf Plausibilität (zum Beispiel in Datentyp oder Wertebereich) geprüft werden, sondern auch Kombinationen dieser Parameter berücksichtigt werden.

- In der archäologischen und geologischen Stratigraphie ist Korrelation die anhand gleicher Merkmale feststellbare relative Altersgleichheit räumlich getrennter Schichten(folgen) ⓘ

Produkt-Moment-Koeffizient von Pearson

Das bekannteste Maß für die Abhängigkeit zwischen zwei Größen ist der Pearson-Produkt-Moment-Korrelationskoeffizient (PPMCC) oder "Pearson-Korrelationskoeffizient", der im Allgemeinen einfach "Korrelationskoeffizient" genannt wird. Man erhält ihn, indem man das Verhältnis der Kovarianz der beiden fraglichen Variablen unseres numerischen Datensatzes, normiert auf die Quadratwurzel ihrer Varianzen, nimmt. Mathematisch gesehen dividiert man einfach die Kovarianz der beiden Variablen durch das Produkt ihrer Standardabweichungen. Karl Pearson entwickelte den Koeffizienten aus einer ähnlichen, aber etwas anderen Idee von Francis Galton. ⓘ

Mit dem Pearson-Produkt-Moment-Korrelationskoeffizienten wird versucht, eine Linie der besten Anpassung durch einen Datensatz mit zwei Variablen zu erstellen, indem im Wesentlichen die erwarteten Werte festgelegt werden, und der resultierende Pearson-Korrelationskoeffizient gibt an, wie weit der tatsächliche Datensatz von den erwarteten Werten entfernt ist. Je nach dem Vorzeichen unseres Pearson-Korrelationskoeffizienten können wir entweder eine negative oder eine positive Korrelation feststellen, wenn es irgendeine Art von Beziehung zwischen den Variablen unseres Datensatzes gibt. ⓘ

Der Populationskorrelationskoeffizient zwischen zwei Zufallsvariablen und mit erwarteten Werten und und Standardabweichungen und ist definiert als:

wobei der Erwartungswertoperator ist, die Kovarianz bedeutet und ist eine weit verbreitete alternative Schreibweise für den Korrelationskoeffizienten. Die Pearson-Korrelation ist nur definiert, wenn beide Standardabweichungen endlich und positiv sind. Eine alternative Formel, die ausschließlich auf Momenten beruht, lautet:

Korrelation und Unabhängigkeit

Eine Korrelation als Maß des Zusammenhangs soll zwei Fragen klären:

- Wie stark ist der Zusammenhang?

- Die Maßzahlen der Korrelation liegen betragsmäßig meist in einem Bereich von Null (=kein Zusammenhang) bis Eins (=starker Zusammenhang). Betrachtet man die Haar- und Augenfarbe von Studenten, so ergibt sich ein korrigierter Kontingenzkoeffizient von 0,55. Da dieser im mittleren Bereich zwischen Null und Eins liegt, haben wir einen mittelstarken Zusammenhang vorliegen.

- Falls möglich, welche Richtung hat der Zusammenhang?

- Ein Beispiel für eine positive Korrelation (wenn mehr, dann mehr) ist: „Mehr Futter, dickere Kühe.“ Ein Beispiel für eine negative oder Antikorrelation (wenn mehr, dann weniger) ist: „Mehr zurückgelegte Strecke mit dem Auto, weniger Treibstoff im Tank.“ ⓘ

Oft gibt es Sättigungsgrenzen. Beispiel: Wenn ich mehr Gas gebe, fährt mein Auto schneller (aber nicht schneller als seine technisch bedingte Maximalgeschwindigkeit). In vielen Korrelationen der Wirtschaft gilt: die Grenzkosten steigen und der Grenznutzen sinkt. ⓘ

Wie ist die Skalierung der an der Korrelation beteiligten Variablen? ⓘ

- Wichtig zur Bestimmung des Korrelationskoeffizienten ist das jeweilige Skalenniveau. Je nach Skalenpaarung ist ein anderes Korrelationsmaß zu bestimmen und unterschiedlich zu interpretieren, beispielsweise CramersV oder Phi bei nominaler Paarung, Spearman’scher Rangkorrelationskoeffizient bei ordinaler Paarung und der Produkt-Moment-Korrelationskoeffizient von Bravais und Pearson bei der Korrelation metrisch (auch kardinal) skalierter Merkmale. ⓘ

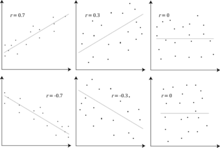

Aus der Cauchy-Schwarz-Ungleichung ergibt sich, dass der absolute Wert des Pearson-Korrelationskoeffizienten nicht größer als 1 ist. Der Wert eines Korrelationskoeffizienten liegt daher zwischen -1 und +1. Der Korrelationskoeffizient ist +1 im Fall einer perfekten direkten (zunehmenden) linearen Beziehung (Korrelation), -1 im Fall einer perfekten inversen (abnehmenden) linearen Beziehung (Antikorrelation) und ein Wert im offenen Intervall in allen anderen Fällen, der den Grad der linearen Abhängigkeit zwischen den Variablen angibt. Je mehr er sich dem Wert Null nähert, desto geringer ist die Beziehung (näher an unkorreliert). Je näher der Koeffizient entweder bei -1 oder bei 1 liegt, desto stärker ist die Korrelation zwischen den Variablen. ⓘ

Nehmen wir zum Beispiel an, die Zufallsvariable ist symmetrisch um Null verteilt, und . Dann ist vollständig bestimmt durch bestimmt, so dass und vollkommen abhängig sind, aber ihre Korrelation gleich Null ist; sie sind unkorreliert. In dem besonderen Fall, dass und gemeinsam normal sind, ist Unkorreliertheit gleichbedeutend mit Unabhängigkeit. ⓘ

Auch wenn unkorrelierte Daten nicht notwendigerweise Unabhängigkeit bedeuten, kann man prüfen, ob Zufallsvariablen unabhängig sind, wenn ihre gegenseitige Information 0 ist. ⓘ

Stichprobenkorrelationskoeffizient

Gegeben eine Reihe von Messungen des Paares indiziert durch kann der Stichprobenkorrelationskoeffizient verwendet werden, um die Pearson-Korrelation der Grundgesamtheit zwischen und . Der Stichprobenkorrelationskoeffizient ist definiert als ⓘ

wobei und sind die Stichprobenmittelwerte von und und und die korrigierten Stichprobenstandardabweichungen von und . ⓘ

Äquivalente Ausdrücke für sind

wobei und sind die unkorrigierten Stichprobenstandardabweichungen von und . ⓘ

Wenn und Ergebnisse von Messungen sind, die Messfehler enthalten, liegen die realistischen Grenzen für den Korrelationskoeffizienten nicht zwischen -1 und +1, sondern in einem kleineren Bereich. Für den Fall eines linearen Modells mit einer einzigen unabhängigen Variablen ist das Bestimmtheitsmaß (R-Quadrat) das Quadrat von des Produkt-Moment-Koeffizienten von Pearson. ⓘ

Beispiel

Betrachten Sie die gemeinsame Wahrscheinlichkeitsverteilung von X und Y, die in der folgenden Tabelle angegeben ist. ⓘ

ⓘyx−1 0 1 0 0 1/3 0 1 1/3 0 1/3

Für diese gemeinsame Verteilung lauten die Randverteilungen:

Daraus ergeben sich die folgenden Erwartungen und Varianzen:

Daher:

Rangkorrelationskoeffizienten

Rangkorrelationskoeffizienten wie der Spearmansche Rangkorrelationskoeffizient und der Kendallsche Rangkorrelationskoeffizient (τ) messen das Ausmaß, in dem bei einem Anstieg einer Variablen die andere Variable tendenziell zunimmt, ohne dass dieser Anstieg durch eine lineare Beziehung dargestellt werden muss. Wenn die eine Variable zunimmt, während die andere abnimmt, sind die Rangkorrelationskoeffizienten negativ. Es ist üblich, diese Rangkorrelationskoeffizienten als Alternativen zum Pearson-Koeffizienten zu betrachten, die entweder verwendet werden, um den Berechnungsaufwand zu verringern oder um den Koeffizienten weniger empfindlich gegenüber Nicht-Normalitäten in Verteilungen zu machen. Diese Ansicht hat jedoch kaum eine mathematische Grundlage, da Rangkorrelationskoeffizienten eine andere Art von Beziehung messen als der Produkt-Moment-Korrelationskoeffizient von Pearson und am besten als Maß für eine andere Art von Assoziation und nicht als alternatives Maß für den Korrelationskoeffizienten der Grundgesamtheit zu betrachten sind. ⓘ

Um die Art der Rangkorrelation und ihren Unterschied zur linearen Korrelation zu veranschaulichen, betrachten wir die folgenden vier Zahlenpaare :

- (0, 1), (10, 100), (101, 500), (102, 2000). ⓘ

Wenn wir von jedem Paar zum nächsten Paar übergehen zunimmt und damit auch . Diese Beziehung ist perfekt in dem Sinne, dass ein Anstieg von immer mit einem Anstieg von . Dies bedeutet, dass wir eine perfekte Rangkorrelation haben, und sowohl der Korrelationskoeffizient von Spearman als auch der von Kendall ist 1, während der Produkt-Moment-Korrelationskoeffizient von Pearson in diesem Beispiel 0,7544 beträgt, was bedeutet, dass die Punkte bei weitem nicht auf einer Geraden liegen. Ebenso gilt, dass immer abnimmt, wenn steigt, sind die Rangkorrelationskoeffizienten -1, während der Pearson-Produkt-Moment-Korrelationskoeffizient nahe bei -1 liegen kann oder auch nicht, je nachdem, wie nahe die Punkte an einer Geraden liegen. Obwohl im Extremfall einer perfekten Rangkorrelation die beiden Koeffizienten gleich sind (beide +1 oder beide -1), ist dies im Allgemeinen nicht der Fall, so dass die Werte der beiden Koeffizienten nicht sinnvoll verglichen werden können. Für die drei Paare (1, 1) (2, 3) (3, 2) beträgt der Spearman-Koeffizient beispielsweise 1/2, während der Kendall-Koeffizient 1/3 beträgt. ⓘ

Andere Maße für die Abhängigkeit zwischen Zufallsvariablen

Die durch einen Korrelationskoeffizienten gegebene Information reicht nicht aus, um die Abhängigkeitsstruktur zwischen Zufallsvariablen zu definieren. Der Korrelationskoeffizient definiert die Abhängigkeitsstruktur nur in ganz bestimmten Fällen vollständig, z. B. wenn die Verteilung eine multivariate Normalverteilung ist. (Siehe Diagramm oben.) Bei elliptischen Verteilungen charakterisiert er die (Hyper-)Ellipsen gleicher Dichte; er charakterisiert jedoch nicht vollständig die Abhängigkeitsstruktur (z. B. bestimmen die Freiheitsgrade einer multivariaten t-Verteilung den Grad der Schwanzabhängigkeit). ⓘ

Die Distanzkorrelation wurde eingeführt, um den Mangel der Pearson-Korrelation zu beheben, dass sie für abhängige Zufallsvariablen Null sein kann; eine Distanzkorrelation von Null impliziert Unabhängigkeit. ⓘ

Der Randomized Dependence Coefficient ist ein rechnerisch effizientes, Copula-basiertes Maß für die Abhängigkeit zwischen multivariaten Zufallsvariablen. Der RDC ist invariant in Bezug auf nichtlineare Skalierungen von Zufallsvariablen, ist in der Lage, ein breites Spektrum funktionaler Assoziationsmuster zu entdecken und nimmt bei Unabhängigkeit den Wert Null an. ⓘ

Bei zwei binären Variablen misst das Odds Ratio deren Abhängigkeit und nimmt einen Bereich nicht negativer Zahlen, möglicherweise unendlich, an: . Verwandte Statistiken wie Yule's Y und Yule's Q normalisieren dies auf den korrelationsähnlichen Bereich . Das Odds Ratio wird durch das logistische Modell verallgemeinert, um Fälle zu modellieren, in denen die abhängigen Variablen diskret sind und es eine oder mehrere unabhängige Variablen geben kann. ⓘ

Das Korrelationsverhältnis, die entropiebasierte gegenseitige Information, die Gesamtkorrelation, die duale Gesamtkorrelation und die polychorische Korrelation sind ebenfalls in der Lage, allgemeinere Abhängigkeiten zu erkennen, ebenso wie die Berücksichtigung der Kopula zwischen ihnen, während das Bestimmtheitsmaß den Korrelationskoeffizienten auf die Mehrfachregression verallgemeinert. ⓘ

Empfindlichkeit gegenüber der Datenverteilung

Der Grad der Abhängigkeit zwischen den Variablen X und Y hängt nicht von der Skala ab, auf der die Variablen ausgedrückt werden. Das heißt, wenn wir die Beziehung zwischen X und Y analysieren, bleiben die meisten Korrelationsmaße von der Transformation von X in a + bX und von Y in c + dY unberührt, wobei a, b, c und d Konstanten sind (b und d sind positiv). Dies gilt sowohl für einige Korrelationsstatistiken als auch für ihre Populationsanaloga. Einige Korrelationsstatistiken, wie z. B. der Rangkorrelationskoeffizient, sind auch invariant gegenüber monotonen Transformationen der Randverteilungen von X und/oder Y. ⓘ

Die meisten Korrelationsmaße sind empfindlich gegenüber der Art und Weise, wie X und Y abgetastet werden. Die Abhängigkeiten sind tendenziell stärker, wenn sie über einen größeren Wertebereich betrachtet werden. Betrachtet man also den Korrelationskoeffizienten zwischen der Körpergröße von Vätern und ihren Söhnen über alle erwachsenen Männer und vergleicht ihn mit demselben Korrelationskoeffizienten, der berechnet wird, wenn die Väter zwischen 165 cm und 170 cm groß sind, so ist die Korrelation im letzteren Fall schwächer. Es wurden mehrere Verfahren entwickelt, die versuchen, die Einschränkung der Spannweite in einer oder beiden Variablen zu korrigieren, und die häufig in Metaanalysen verwendet werden; die gebräuchlichsten sind die Fall-II- und Fall-III-Gleichungen von Thorndike. ⓘ

Verschiedene gebräuchliche Korrelationsmaße können für bestimmte gemeinsame Verteilungen von X und Y undefiniert sein. So ist beispielsweise der Pearson-Korrelationskoeffizient in Form von Momenten definiert und daher undefiniert, wenn die Momente undefiniert sind. Abhängigkeitsmaße auf der Grundlage von Quantilen sind immer definiert. Auf Stichproben basierende Statistiken, die zur Schätzung von Populationsmaßen der Abhängigkeit dienen, können wünschenswerte statistische Eigenschaften aufweisen, wie z. B. Unverzerrtheit oder asymptotische Konsistenz, je nach der räumlichen Struktur der Population, aus der die Daten entnommen wurden. ⓘ

Die Empfindlichkeit gegenüber der Datenverteilung kann zu einem Vorteil genutzt werden. Die skalierte Korrelation beispielsweise ist so konzipiert, dass sie die Empfindlichkeit gegenüber dem Bereich nutzt, um Korrelationen zwischen schnellen Komponenten von Zeitreihen herauszufiltern. Durch eine kontrollierte Verringerung des Wertebereichs werden die Korrelationen auf langen Zeitskalen herausgefiltert und nur die Korrelationen auf kurzen Zeitskalen aufgedeckt. ⓘ

Korrelationsmatrizen

Die Korrelationsmatrix von Zufallsvariablen ist die Matrix, deren Eintrag ist . Somit sind die Diagonaleinträge alle identisch eins. Wenn die verwendeten Korrelationsmaße Produkt-Moment-Koeffizienten sind, ist die Korrelationsmatrix die gleiche wie die Kovarianzmatrix der standardisierten Zufallsvariablen für . Dies gilt sowohl für die Matrix der Populationskorrelationen (in diesem Fall ist die Standardabweichung der Population ist) als auch für die Matrix der Stichprobenkorrelationen (in diesem Fall die Standardabweichung der Stichprobe bezeichnet). Folglich ist jede von ihnen notwendigerweise eine positiv-semidefinite Matrix. Darüber hinaus ist die Korrelationsmatrix streng positiv definiert, wenn keine Variable alle ihre Werte exakt als lineare Funktion der Werte der anderen Variablen erzeugen kann. ⓘ

Die Korrelationsmatrix ist symmetrisch, weil die Korrelation zwischen und die gleiche ist wie die Korrelation zwischen und . ⓘ

Eine Korrelationsmatrix erscheint zum Beispiel in einer Formel für das multiple Bestimmtheitsmaß, ein Maß für die Anpassungsfähigkeit bei multiplen Regressionen. ⓘ

In der statistischen Modellierung werden Korrelationsmatrizen, die die Beziehungen zwischen Variablen darstellen, in verschiedene Korrelationsstrukturen eingeteilt, die sich durch Faktoren wie die Anzahl der für ihre Schätzung erforderlichen Parameter unterscheiden. Bei einer austauschbaren Korrelationsmatrix werden beispielsweise alle Variablenpaare als gleich korreliert modelliert, so dass alle nichtdiagonalen Elemente der Matrix einander gleich sind. Andererseits wird eine autoregressive Matrix häufig verwendet, wenn die Variablen eine Zeitreihe darstellen, da die Korrelationen wahrscheinlich größer sind, wenn die Messungen zeitlich näher beieinander liegen. Weitere Beispiele sind unabhängig, unstrukturiert, M-abhängig und Toeplitz. ⓘ

In der explorativen Datenanalyse besteht die Ikonographie der Korrelationen darin, eine Korrelationsmatrix durch ein Diagramm zu ersetzen, in dem die "bemerkenswerten" Korrelationen durch eine durchgezogene Linie (positive Korrelation) oder eine gepunktete Linie (negative Korrelation) dargestellt werden. ⓘ

Nächste gültige Korrelationsmatrix

Bei einigen Anwendungen (z. B. bei der Erstellung von Datenmodellen aus nur teilweise beobachteten Daten) möchte man die "nächstgelegene" Korrelationsmatrix zu einer "ungefähren" Korrelationsmatrix finden (z. B. eine Matrix, die aufgrund ihrer Berechnungsweise typischerweise keine semidefinite Positivität aufweist). ⓘ

Im Jahr 2002 formalisierte Higham den Begriff der Nähe unter Verwendung der Frobenius-Norm und stellte eine Methode zur Berechnung der nächstgelegenen Korrelationsmatrix unter Verwendung des Dykstra-Projektionsalgorithmus zur Verfügung, von der eine Implementierung als Online-Web-API verfügbar ist. ⓘ

Dies weckte das Interesse an diesem Thema, und in den folgenden Jahren wurden neue theoretische (z. B. die Berechnung der nächstgelegenen Korrelationsmatrix mit Faktorstruktur) und numerische (z. B. die Verwendung der Newton-Methode zur Berechnung der nächstgelegenen Korrelationsmatrix) Ergebnisse erzielt. ⓘ

Unkorreliertheit und Unabhängigkeit von stochastischen Prozessen

Ähnlich für zwei stochastische Prozesse und : Wenn sie unabhängig sind, dann sind sie unkorreliert. Das Gegenteil dieser Aussage ist jedoch nicht unbedingt der Fall. Selbst wenn zwei Variablen unkorreliert sind, sind sie möglicherweise nicht unabhängig voneinander. ⓘ

Häufige Missverständnisse

Korrelation und Kausalität

Das gängige Diktum "Korrelation impliziert keine Kausalität" bedeutet, dass aus der Korrelation allein nicht auf eine kausale Beziehung zwischen den Variablen geschlossen werden kann. Dieses Diktum sollte nicht so verstanden werden, dass Korrelationen nicht auf das mögliche Vorhandensein von Kausalbeziehungen hinweisen können. Die Ursachen, die der Korrelation zugrunde liegen, können jedoch indirekt und unbekannt sein, und hohe Korrelationen überschneiden sich auch mit Identitätsbeziehungen (Tautologien), bei denen kein kausaler Prozess vorliegt. Folglich ist eine Korrelation zwischen zwei Variablen keine hinreichende Bedingung für die Feststellung einer kausalen Beziehung (in beide Richtungen). ⓘ

Eine Korrelation zwischen Alter und Körpergröße bei Kindern ist kausal ziemlich transparent, eine Korrelation zwischen der Stimmung und der Gesundheit bei Menschen ist es weniger. Führt eine bessere Stimmung zu einer besseren Gesundheit, oder führt eine gute Gesundheit zu einer guten Stimmung, oder beides? Oder liegt beidem ein anderer Faktor zugrunde? Mit anderen Worten: Eine Korrelation kann als Beweis für einen möglichen Kausalzusammenhang gewertet werden, gibt aber keinen Aufschluss darüber, wie der Kausalzusammenhang aussehen könnte, wenn überhaupt. ⓘ

Einfache lineare Korrelationen

Der Pearson-Korrelationskoeffizient gibt die Stärke einer linearen Beziehung zwischen zwei Variablen an, aber sein Wert charakterisiert ihre Beziehung im Allgemeinen nicht vollständig. Insbesondere, wenn der bedingte Mittelwert von gegeben , bezeichnet als nicht linear ist in ist, bestimmt der Korrelationskoeffizient nicht vollständig die Form von . ⓘ

Die nebenstehende Abbildung zeigt Streudiagramme des Anscombe-Quartetts, einer von Francis Anscombe geschaffenen Gruppe von vier verschiedenen Variablenpaaren. Die vier Variablen haben denselben Mittelwert (7,5), dieselbe Varianz (4,12), dieselbe Korrelation (0,816) und dieselbe Regressionslinie (y = 3 + 0,5x). Wie in den Diagrammen zu sehen ist, ist die Verteilung der Variablen jedoch sehr unterschiedlich. Die erste (oben links) scheint normal verteilt zu sein und entspricht dem, was man erwarten würde, wenn man zwei Variablen als korreliert betrachtet und der Normalitätsannahme folgt. Die zweite (oben rechts) ist nicht normalverteilt; es ist zwar eine offensichtliche Beziehung zwischen den beiden Variablen zu beobachten, aber sie ist nicht linear. In diesem Fall gibt der Pearson-Korrelationskoeffizient nicht an, dass eine exakte funktionale Beziehung besteht, sondern nur, inwieweit diese Beziehung durch eine lineare Beziehung angenähert werden kann. Im dritten Fall (unten links) ist die lineare Beziehung perfekt, mit Ausnahme eines Ausreißers, der so viel Einfluss ausübt, dass der Korrelationskoeffizient von 1 auf 0,816 sinkt. Das vierte Beispiel (unten rechts) schließlich zeigt ein weiteres Beispiel, bei dem ein Ausreißer ausreicht, um einen hohen Korrelationskoeffizienten zu erzeugen, obwohl die Beziehung zwischen den beiden Variablen nicht linear ist. ⓘ

Diese Beispiele zeigen, dass der Korrelationskoeffizient als zusammenfassende Statistik die visuelle Untersuchung der Daten nicht ersetzen kann. Die Beispiele werden manchmal als Beweis dafür angeführt, dass die Pearson-Korrelation eine Normalverteilung der Daten voraussetzt, was jedoch nur teilweise richtig ist. Die Pearson-Korrelation kann für jede Verteilung mit einer endlichen Kovarianzmatrix genau berechnet werden, was die meisten in der Praxis vorkommenden Verteilungen einschließt. Der Pearson-Korrelationskoeffizient (zusammen mit dem Stichprobenmittelwert und der Varianz) ist jedoch nur dann eine ausreichende statistische Größe, wenn die Daten aus einer multivariaten Normalverteilung stammen. Daher charakterisiert der Pearson-Korrelationskoeffizient die Beziehung zwischen den Variablen nur dann vollständig, wenn die Daten aus einer multivariaten Normalverteilung stammen. ⓘ

Bivariate Normalverteilung

Wenn ein Paar von Zufallsvariablen einer bivariaten Normalverteilung folgt, ist der bedingte Mittelwert eine lineare Funktion von , und der bedingte Mittelwert eine lineare Funktion von . Der Korrelationskoeffizient zwischen und bestimmt zusammen mit den marginalen Mittelwerten und Varianzen von und bestimmt diese lineare Beziehung:

wobei und sind die erwarteten Werte von und und und sind die Standardabweichungen von und jeweils. ⓘ

Die empirische Korrelation ist eine Schätzung des Korrelationskoeffizienten . Eine Verteilungsschätzung für ist gegeben durch

Korrelation und Kausalzusammenhang

Von der Korrelation zum Kausalzusammenhang

Eine Korrelation beschreibt keine Ursache-Wirkungs-Beziehung in die eine und/oder andere Richtung, d. h. aus einem starken Zusammenhang folgt nicht, dass es auch eine eindeutige Ursache-Wirkungs-Beziehung gibt. ⓘ

Beispiele:

- Aus der Tatsache, dass in Sommern mit hohem Speiseeisumsatz viele Sonnenbrände auftreten, kann man nicht schlussfolgern, dass Eisessen Sonnenbrand erzeugt.

- Zwischen dem Rückgang der Störche im Burgenland und einem Rückgang der Anzahl Neugeborener könnte es durchaus eine Korrelation geben. Diese Korrelation hätte ihre Ursache aber weder darin, dass Störche Kinder bringen, noch darin, dass Störche sich zu Kindern hingezogen fühlen. Der Zusammenhang wäre sehr viel indirekterer Natur.

- Menschen, die viel lachen, geben in Meinungsumfragen regelmäßig an, glücklicher zu sein als andere. Da diese beiden Phänomene stets zusammen auftreten, ist denkbar,

- dass glückliche Menschen mehr lachen,

- dass Menschen, die viel zu lachen haben, dadurch glücklicher werden,

- dass es gar keinen direkten Zusammenhang gibt, sondern dass sowohl das Lachen wie auch das Glück davon abhingen, wie das Wetter an dem Tag war, an dem die Beobachtungen gemacht wurden. ⓘ

In den ersten beiden Beispielen hängen die jeweiligen Messgrößen über eine dritte Größe ursächlich zusammen. Im ersten Fall ist es die Sonneneinstrahlung, die sowohl Eisverkauf als auch Sonnenbrand bewirkt, im zweiten Fall die Verstädterung, die sowohl Nistplätze vernichtet als auch dazu führt, dass Menschen weniger Kinder bekommen (siehe Vereinbarkeit von Familie und Beruf). Korrelationen dieser Art werden etwas mißverständlich Scheinkorrelationen genannt (eigentlich handelt es sich um Schein-Kausalitäten). ⓘ

In der Presse werden Korrelationen oft in einer Weise berichtet, die eine direkte Kausalität suggeriert, obwohl eine Gemengelage direkter und indirekter Zusammenhänge besteht. ⓘ

| Beispiele für Schlagzeilen | denkbare alternative Einflussfaktoren und Wirkmechanismen | Anmerkungen ⓘ |

|---|---|---|

| Zuwanderer sind häufiger kriminell | Diebstahl, Raub u. ä. sind häufig Verzweiflungstaten. Solche Verzweiflung entsteht u. a. durch finanzielle Armut, geringen sozio-ökonomischen Status, Arbeits- und Orientierungslosigkeit und fehlenden Halt in Familie und Freundeskreis wie bei Um- und Zuzug meist der Fall; Aggression ist u. a. ein häufiges Symptom von Traumatisierungsfolgestörungen, die beispielsweise häufig mit Flucht und Vertreibung einhergehen; Phänomen der selbsterfüllenden Prophezeiung: erfährt ein Mensch immer wieder, dass mit den ihm eigenen sichtbaren Merkmalen (Bsp. junger Mann dunkler Hautfarbe mit spezifischem sprachlichen Akzent) in der Gesellschaft bestimmte Persönlichkeitseigenschaften oder Verhaltensweisen assoziiert werden (Bsp. geringerer beruflicher Erfolg, höheres Aggressionspotenzial/Gewaltbereitschaft, Unehrlichkeit …), kann diese ständige Konfrontation zur zunehmenden Adaption eben jener Verhaltensweisen/Eigenschaften führen. Leider führt auch der Versuch, der Gesellschaft „das Gegenteil zu beweisen“ und z. B. in schulischen Abschlussprüfungen besonders erfolgreich abzuschneiden, durch den so induzierten konstanten Stress und die zusätzliche kognitive Belastung häufig genau zum gegensätzlichen (und insofern wieder klischeehaft erwarteten) Ausgang (Bsp. schlechteres Testergebnis und so geminderte (Berufs-)Chancen trotz eigentlich hoher Intelligenz). | Problem in diesem spezifischen Beispiel ist auch, dass Kriminalität häufig zu schlecht ausdifferenziert wird. Beispielsweise wurde in Flüchtlingskriminalitätsstatistiken immer wieder auch Schwarzfahren eingerechnet, was häufig nicht (nur) auf finanzielle Engpässe zurückzuführen ist, sondern (auch) auf mangelhafte Einweisung in das ÖPNV-System bzw. den korrekten Ablauf von Auswahl der Preisstufe über Bezahlvorgang zum Abstempeln. Auch die häufig vorhandene Sprachbarriere ist hier ein nicht zu ignorierender Faktor. Fraglich ist also, ob Schwarzfahren und ähnliche oft auf nur vorübergehende/anfängliche Verständnisprobleme zurückzuführende Delikte in die gleichen Vergleichsstatistiken zur Kriminalität einfließen sollten wie schwere Verbrechen. |

| CO2 erklärt Nahtoderfahrung | Ab dem Herztod steigt der CO2-Level im Blut schnell an, da das CO2-reiche (und sauerstoffarme) Blut nicht mehr über den Lungenblutkreislauf durch sauerstoffreiches (CO2-armes) Blut „ersetzt“ werden und über den großen Blutkreislauf zu den Organen (inkl. dem Gehirn) transportiert werden kann. Relativ schnell darauf tritt – bei nicht rechtzeitig eingeleiteten Hilfsmaßnahmen – auch der irreversible Hirntod ein. In der dazwischenliegenden Phase (herztot, noch nicht hirntot) erleben viele Patienten sogenannte Nahtoderfahrungen. Dass also in einem ähnlichen Zeitraum sowohl ein Anstieg des CO2-Levels im Blut als auch das Auftreten von Nahtoderfahrungen beobachtet werden kann, sagt noch nichts über Ursächlichkeit aus. Alternativ könnte der Abfall der Sauerstoffkonzentration verantwortlich sein, vielleicht bestehen Nahtoderfahrungen in diesem Zeitfenster jedoch auch völlig unabhängig von jeglichen parallel ablaufenden körperlichen Veränderungen. Eine mögliche Kausalität (Ursachenzuordnung) lässt sich hier nur schwer überprüfen, da beide Phänomene (CO2-Anreicherung und Nahtoderfahrung) unweigerlich (nur) in diesem spezifischen Zeitfenster auftreten und schwer experimentell kontrolliert werden können. | |

| Größere Leute verdienen mehr | Konfundierende Variable (zusätzlicher Einflussfaktor) könnte sein: Selbstvertrauen – höheres Selbstbewusstsein in körperlich größeren Menschen führt über Zwischenschritte zu im Schnitt besser bezahlten Arbeitsstellen | |

| Kreative haben mehr Sex | Neben den vermuteten für diese Berufsgruppe spezifischen und ggf. „attraktiveren“ Persönlichkeitseigenschaften sind mögliche Gründe: Berufe mit flexibler Zeiteinteilung könnten ein reicheres Sexleben ermöglichen; Grundsätzliche Zufriedenheit als ermöglichender Faktor erfüllter Sexualität hängt vielleicht von Gefallen am Job und Überzeugung von dessen Sinnhaftigkeit ab, was möglicherweise in künstlerischen Berufen häufiger der Fall ist, für die sich die dort Tätigen oft gegen familiären und gesellschaftlichen Widerstand hinwegsetzen mussten. | Worst Case Szenario: Im Fall dieser Studie stimmt schon die Überschrift nicht mit dem Studieninhalt bzw. -ergebnis überein: Aussage der Studie war, dass hauptberuflich im kreativen Bereich tätige Menschen im Schnitt doppelt so viele Sexualpartner haben wie der „Rest“. Vor diesem Hintergrund kommt als weitere Ursache die Gruppendynamik und minderheitsinternen Normen innerhalb vieler Künstlergesellschaften in Frage. Studienspezifisch kommt als kritisch zu betrachtender Faktor die Erhebungsweise und die Begrenzung der Befragung auf eine relativ kleine Stichprobe von insgesamt nur 425 Briten hinzu. |

| Glückliche Menschen sind gesünder | Körperliche und psychische Gesundheit oder auch nur die Abwesenheit von Krankheit trägt mitunter maßgeblich zum subjektiven Glücksempfinden bei. Auch hier kann zudem eine gemeinsame (moderierende) Einflussvariable der Sozioökonomische Status bzw. die zur Verfügung stehenden finanziellen Mittel und der Bildungsgrad sein, die sowohl Einfluss auf das allgemeine Sicherheitsempfinden, Stressfaktoren und der übertragenen Verantwortung (beruflich und privat, für sich selbst und andere) sowie auf das Essverhalten haben. | |

| Senkung der Arbeitslosigkeit erfordert starkes Wirtschaftswachstum | Vielleicht umgekehrte Kausalitätsrichtung: Stärkung des Wirtschaftswachstums erfordert geringere Arbeitslosigkeit |

In manchen Fällen mag die vermutete und ggf. naheliegende Kausalität (Ursache-Wirkungs-Gefüge) tatsächlich vorliegen, die reine Feststellung einer Korrelation lässt eine solche Aussage aber nie mit Sicherheit zu. ⓘ

Vom Kausalzusammenhang zur Korrelation

Liegt allerdings tatsächlich eine Ursache-Wirkungs-Beziehung vor, dann erwartet man eine Korrelation von Ursache und Wirkung. Eine Korrelation wird als Indiz dafür gewertet, dass zwei statistische Größen ursächlich miteinander zusammenhängen könnten. ⓘ

Das funktioniert immer dann besonders gut, wenn beide Größen durch eine „Je … desto“-Beziehung (Proportionalität) miteinander zusammenhängen und eine der Größen alleine von der anderen Größe abhängt. ⓘ

Beispielsweise kann man nachweisen, dass Getreide unter bestimmten Bedingungen besser gedeiht, wenn man es mehr bewässert. Diese Erkenntnis beruht auf dem Wissen über das Getreide – zum Beispiel durch Erfahrung oder wissenschaftliche Überlegungen. Die Korrelation unterscheidet nicht, ob das Wasser direkt auf das Wachstum des Getreides wirkt, oder ob es nicht etwa stattdessen die Lebensbedingungen eines Pflanzenschädlings verschlechtert, der darum das Wachstum des Getreides weniger stark behindert, als zuvor. Eine Ursache-Wirkung-Beziehung kann nur beschreiben, welche Seite (hier das Wasser) eine Wirkung (das Wachstum des Getreides) hat. Gibt es mehrere Einflussfaktoren auf das Wachstum des Getreides (beispielsweise die Temperatur, den Nährstoffgehalt des Bodens, das einfallende Licht usw.), ist die Menge des Wassers nicht mehr die einzige Erklärung für das Wachstum des Getreides. Die Erklärungskraft reduziert sich somit. Die Korrelation zwischen der Menge des Wassers und dem Wachstum des Getreides bleibt jedoch unverändert; sie ist ein tatsächlicher Zusammenhang, den man aber nicht immer beweisen bzw. vollständig beschreiben kann. ⓘ

Fehlschlüsse – Cum hoc ergo propter hoc

Der Fehlschluss von Korrelation auf Kausalität wird auch als Cum hoc ergo propter hoc bezeichnet. Um Kausalitäten wirklich herstellen und Kausalitätsrichtungen definieren zu können, ist grundsätzlich eine substanzwissenschaftliche Betrachtung notwendig. Die Frage „warum wirkt sich Lärm im Haus negativ auf die Intelligenz der Kinder aus?“ kann in diesem Fall nur von Personengruppen mit entsprechendem Fachwissen, wie zum Beispiel Psychologen und Umweltwissenschaftlern, erklärt werden. ⓘ

Zur Beurteilung einer Hypothese wären zum Beispiel Experimente nötig, bei denen ein Faktor experimentell festgelegt wird (z. B. der Lärm im Haus) und der andere Faktor gemessen wird (z. B. Intelligenz der Kinder). Solche Experimente würden mithilfe der Regressionsanalyse oder Varianzanalyse evaluiert. Eine Regression dagegen beschreibt den Zusammenhang, kann ihn aber nicht erklären. Viele derartige Experimente sind nicht durchführbar:

- zu lange Dauer und/oder

- zu hohe Kosten und/oder

- unethisch. ⓘ

Aufgrund ihres Fokus auf den Menschen sind für viele sozialwissenschaftliche und medizinische Fragestellungen nur korrelative Studien, meist aber keine Experimente ethisch zu rechtfertigen. Um Korrelationsergebnisse als kausal interpretieren zu können, sind weitere Untersuchungen erforderlich (dabei können z. B. langzeitige Zusammenhänge hilfreich sein; dazu macht man Längsschnittstudien). Teilweise werden korrelative Studien fälschlicherweise wie Experimente interpretiert. ⓘ

Anwendung bei Kapitalanlagen

Der Korrelationsbegriff ist von erheblicher Bedeutung bei Kapitalanlagen. Es gilt: Das Gesamtrisiko des gesamten Portfolios ist umso geringer, je geringer die einzelnen Anlagen (Assets) miteinander korrelieren. ⓘ

Beispiel für positive Korrelation: Besteht ein Portfolio nur aus vielen einzelnen Aktien, so kann der Kursrückgang von Aktie 1 auch zum Wertverlust von Aktie 2 und auch Aktie 3 in einem bestimmten Verhältnis führen. Besteht das Portfolio jeweils zur Hälfte aus Aktien und Renten, so ist der Verlust geringer, da nur eine geringfügige Korrelation Aktien-Renten besteht. ⓘ

Allerdings gibt es auch negative Korrelationen, wenn auch geringere, z. B. bezüglich Aktie-Rente. Ist der Aktienmarkt schwach, so wird tendenziell in Renten investiert (Kapitalflucht in den sicheren Hafen). Die Rentenkurse steigen. Dies fängt jedoch nicht den Komplettverlust im Aktienbereich auf. Daher ist es sinnvoll, noch in andere Anlagen als Renten und Aktien zu diversifizieren. Die Risikominderung durch Diversifikation oder Investition in negativ korrelierte Assets bezeichnet man als Hedging. Bei einer idealen Diversifikation ist die Korrelation der Renditen negativ (genauer: −1). ⓘ

Reduktion der Korrelation des Gesamtportfolios im Verhältnis zu seinen Einzelanlagen verbessert nach dem Markowitz-Modell das Rendite-Risiko-Verhältnis. Auf langfristiger Basis wird damit prinzipiell eine höhere Rendite bei geringerem Risiko erzielt. ⓘ

Die Korrelation macht in erster Linie Aussagen über die Richtung des Verlaufs, z. B. von Aktienkursen, nicht jedoch über das Ausmaß der jeweiligen Veränderung. Aus der positiven Korrelation etwa einer Aktie von 0,8 lässt sich nicht errechnen, um wie viel der Aktienkurs bei einem 3-%-Anstieg des DAX steigt. Auch besagt die Korrelation nicht, ob der DAX auf die Aktie wirkt oder die Aktie auf den DAX. Für die Analyse von Wertpapieren wurde das Capital Asset Pricing Model entwickelt, dort kommt der Betafaktor als wichtige Kennzahl ins Spiel. ⓘ

![{\displaystyle \rho _{X,Y}=\operatorname {corr} (X,Y)={\operatorname {cov} (X,Y) \over \sigma _{X}\sigma _{Y}}={\operatorname {E} [(X-\mu _{X})(Y-\mu _{Y})] \over \sigma _{X}\sigma _{Y}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/93185aed3047ef42fa0f1b6e389a4e89a5654afa)

![{\displaystyle {\begin{aligned}r_{xy}&={\frac {\sum x_{i}y_{i}-n{\bar {x}}{\bar {y}}}{ns'_{x}s'_{y}}}\\[5pt]&={\frac {n\sum x_{i}y_{i}-\sum x_{i}\sum y_{i}}{{\sqrt {n\sum x_{i}^{2}-(\sum x_{i})^{2}}}~{\sqrt {n\sum y_{i}^{2}-(\sum y_{i})^{2}}}}}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6da33b8144a5e67959969ef2c4830ece1938bbb2)

![{\displaystyle {\begin{aligned}\rho _{X,Y}&={\frac {1}{\sigma _{X}\sigma _{Y}}}\mathrm {E} [(X-\mu _{X})(Y-\mu _{Y})]\\[5pt]&={\frac {1}{\sigma _{X}\sigma _{Y}}}\sum _{x,y}{(x-\mu _{X})(y-\mu _{Y})\mathrm {P} (X=x,Y=y)}\\[5pt]&=\left(1-{\frac {2}{3}}\right)(-1-0){\frac {1}{3}}+\left(0-{\frac {2}{3}}\right)(0-0){\frac {1}{3}}+\left(1-{\frac {2}{3}}\right)(1-0){\frac {1}{3}}=0.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/75bf2b7806338758b4c55d7b4f18a5071b8e919b)

![{\displaystyle [0,+\infty ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f32245981f739c86ea8f68ce89b1ad6807428d35)

![{\displaystyle [-1,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/51e3b7f14a6f70e614728c583409a0b9a8b9de01)