Informationstechnik

| Informationswissenschaft ⓘ |

|---|

| Allgemeine Aspekte |

|

| Verwandte Bereiche und Teilbereiche |

|

Informationstechnologie (IT) ist die Verwendung von Computern zur Erstellung, Verarbeitung, Speicherung, Abfrage und zum Austausch aller Arten von Daten und Informationen. IT wird in der Regel im Rahmen von Geschäftsvorgängen eingesetzt, im Gegensatz zu persönlichen oder Unterhaltungstechnologien. IT ist ein Teil der Informations- und Kommunikationstechnologie (IKT). Ein informationstechnisches System (IT-System) ist im Allgemeinen ein Informationssystem, ein Kommunikationssystem oder, genauer gesagt, ein Computersystem - einschließlich aller Hardware, Software und Peripheriegeräte -, das von einer begrenzten Gruppe von IT-Nutzern betrieben wird. ⓘ

Seit die Sumerer in Mesopotamien um 3000 v. Chr. die Schrift entwickelt haben, speichern, suchen, bearbeiten und kommunizieren die Menschen Informationen. Der Begriff Informationstechnologie im heutigen Sinne tauchte jedoch erstmals 1958 in einem Artikel in der Harvard Business Review auf; die Autoren Harold J. Leavitt und Thomas L. Whisler stellten fest, dass "die neue Technologie noch keinen festen Namen hat. Wir werden sie Informationstechnologie (IT) nennen". Ihre Definition besteht aus drei Kategorien: Verarbeitungstechniken, die Anwendung statistischer und mathematischer Methoden bei der Entscheidungsfindung und die Simulation von Denkprozessen höherer Ordnung durch Computerprogramme. ⓘ

Der Begriff wird im Allgemeinen als Synonym für Computer und Computernetze verwendet, umfasst aber auch andere Technologien zur Informationsverbreitung wie Fernsehen und Telefon. Verschiedene Produkte oder Dienstleistungen innerhalb einer Wirtschaft werden mit der Informationstechnologie in Verbindung gebracht, darunter Computerhardware, Software, Elektronik, Halbleiter, Internet, Telekommunikationsausrüstung und elektronischer Handel. ⓘ

Auf der Grundlage der verwendeten Speicher- und Verarbeitungstechnologien lassen sich vier verschiedene Phasen der IT-Entwicklung unterscheiden: vormechanisch (3000 v. Chr. - 1450 n. Chr.), mechanisch (1450-1840), elektromechanisch (1840-1940) und elektronisch (1940 bis heute). Dieser Artikel konzentriert sich auf die jüngste Periode (Elektronik). ⓘ

Die Informationstechnologie ist auch ein Teilgebiet der Informatik, das sich als die Gesamtheit der Verfahren, der Struktur und der Verarbeitung verschiedener Arten von Daten definieren lässt. Da sich dieser Bereich weltweit immer weiter entwickelt, hat auch die allgemeine Priorität und Bedeutung zugenommen, was zur Einführung von Informatikkursen in der K-12-Bildung geführt hat. Es wurde jedoch die Sorge geäußert, dass es in den meisten Schulen keine Kurse für Fortgeschrittene in diesem Bereich gibt. ⓘ

Informationstechnik (kurz IT) steht für die Technik zur Elektronischen Datenverarbeitung (EDV) und der hierzu verwendeten Hard- und Software-Infrastruktur. In industrialisierten Ländern werden erhebliche Teile der Verwaltung, Organisation, Kommunikation und Unterhaltung mit Mitteln der Informationstechnik realisiert. Bestimmende Grundlagen der Informationstechnik sind die digitale Mikroelektronik, die Softwaretechnik und die EDV-Organisation. Ihre wissenschaftliche Behandlung erfolgt in der Informatik. ⓘ

Eigentlich versteht man unter dem Begriff speziell elektronische Informationstechnik (EIT), zur Informationstechnik gehören auch nicht-elektronische Systeme (wie die anfangs rein elektrische Telefonie und Telegraphie). Der eigentliche Fachbegriff ist aber (elektronische) Informations- und Datenverarbeitung (EID), der die anfangs getrennten Techniken der Kommunikationsmedien (‚Information‘ im ursprünglichen Sinne der Mitteilung) und der Datenverarbeitung im engeren Sinne (EDV-Anwendungen zur programmierten Bearbeitung von Akten, Zahlenreihen, Tabellen usw.) zusammenfasst. Da die beiden Begriffe Information und Daten heute in der Praxis inhaltlich weitgehend verschmolzen sind, wie auch Technik und Verarbeitung nicht zu trennen sind, wird der Ausdruck „IT“ für den gesamten technologischen Sektor verwendet. ⓘ

Die Ausdrücke Informationstechnik und Informationstechnologie können – im nichtwissenschaftlichen Bereich – als synonym angesehen werden: Unter „Technik“ versteht man üblicherweise allenfalls speziell die konkrete praktische Umsetzung (Anwendung), unter „Technologie“ die Forschung und Entwicklung und die theoretischen Grundlagen. In dem hochinnovativen Sektor wie auch bei Software ist das kaum trennbar. ⓘ

Als zeitgemäße Veranschaulichung zur Einordnung der IT in übergeordnete Systeme eignet sich eine Betrachtung im 3-Ebenen-Modell. Sie zeigt verbundene technische Systeme und deren Nutzen für einzelne User oder für Prozesse in Organisationen:

Eine andere Sicht auf die IT, die Sicht der durch die IT angebotenen Dienste, bietet das Konzept SOA (Serviceorientierte Architektur). ⓘ

Geschichte der Computertechnologie

Die Idee der Informatik wurde erstmals in den 1950er Jahren am Massachusetts Institute of Technology (MIT) und an der Harvard University erwähnt, wo man über Computerschaltungen und numerische Berechnungen diskutierte und nachzudenken begann. Im Laufe der Zeit wurde der Bereich der Informationstechnologie und Informatik immer komplexer und konnte immer mehr Daten verarbeiten. Wissenschaftliche Artikel wurden von verschiedenen Organisationen veröffentlicht. ⓘ

Alan Turing, J. Presper Eckert und John Mauchly wurden Mitte des 19. Jahrhunderts als einige der wichtigsten Pioniere der Computertechnologie betrachtet. Die meisten ihrer Bemühungen konzentrierten sich auf die Entwicklung des ersten Digitalcomputers. Parallel dazu kamen Themen wie künstliche Intelligenz auf, als Turing begann, die damalige Technologie in Frage zu stellen. ⓘ

Seit Tausenden von Jahren werden Geräte zur Unterstützung von Berechnungen eingesetzt, wahrscheinlich zunächst in Form eines Rechenstabs. Der Mechanismus von Antikythera, der etwa auf den Beginn des ersten Jahrhunderts v. Chr. datiert wird, gilt allgemein als der früheste bekannte mechanische Analogrechner und als der früheste bekannte Getriebemechanismus. Vergleichbare Geräte mit Getriebe kamen in Europa erst im 16. Jahrhundert auf, und erst 1645 wurde die erste mechanische Rechenmaschine entwickelt, die die vier Grundrechenarten ausführen konnte. ⓘ

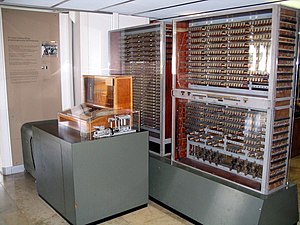

Elektronische Computer, die entweder Relais oder Ventile verwendeten, kamen Anfang der 1940er Jahre auf. Der elektromechanische Zuse Z3, der 1941 fertiggestellt wurde, war der erste programmierbare Computer der Welt und nach modernen Maßstäben eine der ersten Maschinen, die als vollständige Rechenmaschine betrachtet werden konnten. Während des Zweiten Weltkriegs entwickelte Colossus den ersten elektronischen Digitalcomputer zur Entschlüsselung deutscher Nachrichten. Obwohl er programmierbar war, war er nicht universell einsetzbar, da er nur für eine einzige Aufgabe konzipiert war. Außerdem konnte er sein Programm nicht in einem Speicher ablegen; die Programmierung erfolgte über Stecker und Schalter, mit denen die interne Verdrahtung verändert wurde. Der erste erkennbar moderne elektronische Digitalcomputer mit gespeicherten Programmen war das Manchester Baby, das am 21. Juni 1948 sein erstes Programm abspielte. ⓘ

Die Entwicklung von Transistoren in den späten 1940er Jahren in den Bell Laboratories ermöglichte die Entwicklung einer neuen Generation von Computern mit deutlich geringerem Stromverbrauch. Der erste kommerziell erhältliche Computer mit gespeicherten Programmen, der Ferranti Mark I, enthielt 4050 Röhren und hatte einen Stromverbrauch von 25 Kilowatt. Im Vergleich dazu verbrauchte der erste Transistorcomputer, der an der Universität Manchester entwickelt wurde und im November 1953 einsatzbereit war, in seiner Endversion nur 150 Watt. ⓘ

Zu den weiteren Durchbrüchen in der Halbleitertechnologie gehören der integrierte Schaltkreis (IC), der 1959 von Jack Kilby bei Texas Instruments und Robert Noyce bei Fairchild Semiconductor erfunden wurde, der Metall-Oxid-Halbleiter-Feldeffekttransistor (MOSFET), der 1959 von Mohamed Atalla und Dawon Kahng bei den Bell Laboratories erfunden wurde, und der Mikroprozessor, der 1971 von Ted Hoff, Federico Faggin, Masatoshi Shima und Stanley Mazor bei Intel erfunden wurde. Diese wichtigen Erfindungen führten in den 1970er Jahren zur Entwicklung des Personal Computers (PC) und zum Aufkommen der Informations- und Kommunikationstechnologie (IKT). ⓘ

Im Jahr 1984 wurde der Begriff "Informationstechnologie" laut National Westminster Bank Quarterly Review neu definiert: "Die Entwicklung des Kabelfernsehens wurde durch die Konvergenz von Telekommunikations- und Computertechnologie ermöglicht (...in Großbritannien allgemein als Informationstechnologie bekannt)." Ab 1990 taucht der Begriff dann in Dokumenten der Internationalen Organisation für Normung (ISO) auf. ⓘ

Jahrhundert haben Innovationen in der Technologie die Welt bereits revolutioniert, da die Menschen Zugang zu verschiedenen Online-Diensten hatten. Dies hat die Arbeitswelt drastisch verändert, da dreißig Prozent der US-Arbeitnehmer bereits in diesem Beruf tätig sind. 136,9 Millionen Menschen waren persönlich an das Internet angeschlossen, was 51 Millionen Haushalten entsprach. Zusammen mit dem Internet wurden auch neue Arten von Technologie auf der ganzen Welt eingeführt, die die Effizienz verbessert und die Dinge auf der ganzen Welt einfacher gemacht haben. ⓘ

Zusammen mit der Technologie, die die Gesellschaft revolutionierte, konnten Millionen von Prozessen in Sekundenschnelle erledigt werden. Innovationen in der Kommunikation waren ebenfalls von entscheidender Bedeutung, da die Menschen begannen, sich auf den Computer zu verlassen, um über Telefonleitungen und Kabel zu kommunizieren. Die Einführung der E-Mail war eine wirklich große Sache, da "Unternehmen in einem Teil der Welt per E-Mail mit Lieferanten und Käufern in einem anderen Teil der Welt kommunizieren konnten...". ⓘ

Nicht nur persönlich, Computer und Technologie haben auch die Marketingbranche revolutioniert, was zu mehr Käufern ihrer Produkte führte. Im Jahr 2002 haben die Amerikaner allein über das Internet Waren im Wert von 28 Milliarden Dollar eingekauft, während der elektronische Handel ein Jahrzehnt später zu einem Umsatz von 289 Milliarden Dollar führte. Und da die Computer von Tag zu Tag immer ausgefeilter werden, werden sie auch immer mehr genutzt, da die Menschen im einundzwanzigsten Jahrhundert immer mehr auf sie angewiesen sind. ⓘ

Elektronische Datenverarbeitung

Datenspeicherung

Frühe elektronische Computer wie Colossus arbeiteten mit Lochstreifen, einem langen Papierstreifen, auf dem die Daten durch eine Reihe von Löchern dargestellt wurden - eine Technologie, die heute veraltet ist. Die elektronische Datenspeicherung, die in modernen Computern zum Einsatz kommt, geht auf den Zweiten Weltkrieg zurück, als eine Art Verzögerungsleitungsspeicher entwickelt wurde, um die Störungen von Radarsignalen zu beseitigen. Das erste digitale Speichergerät mit wahlfreiem Zugriff war die Williams-Röhre, die auf einer herkömmlichen Kathodenstrahlröhre basierte. Die darin gespeicherten Informationen und der Verzögerungsleitungsspeicher waren jedoch flüchtig, da sie ständig aufgefrischt werden mussten und somit verloren gingen, sobald die Stromversorgung unterbrochen wurde. Die früheste Form der nichtflüchtigen Computerspeicherung war die 1932 erfundene Magnettrommel, die im Ferranti Mark 1, dem weltweit ersten kommerziell erhältlichen elektronischen Allzweckcomputer, eingesetzt wurde. ⓘ

IBM führte 1956 das erste Festplattenlaufwerk als Bestandteil des Computersystems 305 RAMAC ein. Die meisten digitalen Daten werden auch heute noch magnetisch auf Festplatten oder optisch auf Medien wie CD-ROMs gespeichert. Bis 2002 wurden die meisten Informationen auf analogen Geräten gespeichert, aber in diesem Jahr überstieg die digitale Speicherkapazität erstmals die analoge. Im Jahr 2007 wurden fast 94 % der weltweit gespeicherten Daten digital aufbewahrt: 52 % auf Festplatten, 28 % auf optischen Geräten und 11 % auf digitalen Magnetbändern. Schätzungen zufolge wuchs die weltweite Kapazität zur Speicherung von Informationen auf elektronischen Geräten von weniger als 3 Exabyte im Jahr 1986 auf 295 Exabyte im Jahr 2007, was etwa einer Verdoppelung alle drei Jahre entspricht. ⓘ

Datenbanken

Datenbankmanagementsysteme (DMS) entstanden in den 1960er Jahren, um das Problem der genauen und schnellen Speicherung und Abfrage großer Datenmengen zu lösen. Ein frühes solches System war das Information Management System (IMS) von IBM, das auch mehr als 50 Jahre später noch weit verbreitet ist. IMS speichert Daten hierarchisch, aber in den 1970er Jahren schlug Ted Codd ein alternatives relationales Speichermodell vor, das auf der Mengenlehre und Prädikatenlogik und den bekannten Konzepten von Tabellen, Zeilen und Spalten basiert. Im Jahr 1981 wurde das erste kommerziell verfügbare relationale Datenbankmanagementsystem (RDBMS) von Oracle veröffentlicht. ⓘ

Alle DMS bestehen aus Komponenten, die es ermöglichen, dass viele Benutzer gleichzeitig auf die gespeicherten Daten zugreifen können, wobei ihre Integrität gewahrt bleibt. Allen Datenbanken ist gemeinsam, dass die Struktur der in ihnen enthaltenen Daten getrennt von den Daten selbst in einem Datenbankschema definiert und gespeichert wird. ⓘ

In den letzten Jahren hat sich die Extensible Markup Language (XML) zu einem beliebten Format für die Datendarstellung entwickelt. Obwohl XML-Daten in normalen Dateisystemen gespeichert werden können, werden sie in der Regel in relationalen Datenbanken gehalten, um deren "robuste Implementierung, die durch jahrelange theoretische und praktische Bemühungen verifiziert wurde", zu nutzen. Als Weiterentwicklung der Standard Generalized Markup Language (SGML) bietet die textbasierte Struktur von XML den Vorteil, dass sie sowohl maschinen- als auch menschenlesbar ist. ⓘ

Datenabruf

Mit dem relationalen Datenbankmodell wurde eine programmiersprachenunabhängige Structured Query Language (SQL) eingeführt, die auf der relationalen Algebra basiert. ⓘ

Die Begriffe "Daten" und "Informationen" sind keine Synonyme. Alles, was gespeichert wird, sind Daten, aber sie werden erst zu Informationen, wenn sie organisiert und sinnvoll präsentiert werden. Die meisten digitalen Daten der Welt sind unstrukturiert und werden in einer Vielzahl unterschiedlicher physischer Formate gespeichert, selbst innerhalb einer einzigen Organisation. In den 1980er Jahren wurde mit der Entwicklung von Data Warehouses begonnen, um diese unterschiedlichen Speicher zu integrieren. Sie enthalten in der Regel Daten aus verschiedenen Quellen, einschließlich externer Quellen wie dem Internet, die so organisiert sind, dass sie Entscheidungsunterstützungssysteme (DSS) erleichtern. ⓘ

Datenübertragung

Die Datenübertragung hat drei Aspekte: Übertragung, Ausbreitung und Empfang. Sie lässt sich grob in die Kategorien Rundfunk, bei dem Informationen unidirektional nach unten übertragen werden, und Telekommunikation mit bidirektionalen vor- und nachgelagerten Kanälen einteilen. ⓘ

XML wird seit Anfang der 2000er Jahre zunehmend als Mittel für den Datenaustausch eingesetzt, insbesondere für maschinenorientierte Interaktionen, wie sie in weborientierten Protokollen wie SOAP vorkommen, die "data-in-transit rather than... data-at-rest" beschreiben. ⓘ

Datenmanipulation

Hilbert und Lopez stellen das exponentielle Tempo des technologischen Wandels (eine Art Moore'sches Gesetz) fest: Die anwendungsspezifische Rechenkapazität von Maschinen pro Kopf hat sich zwischen 1986 und 2007 etwa alle 14 Monate verdoppelt; die Pro-Kopf-Kapazität von Universalcomputern hat sich in denselben zwei Jahrzehnten alle 18 Monate verdoppelt; die weltweite Telekommunikationskapazität pro Kopf hat sich alle 34 Monate verdoppelt; die weltweite Speicherkapazität pro Kopf brauchte etwa 40 Monate, um sich zu verdoppeln (alle 3 Jahre); und die Pro-Kopf-Informationsübertragung hat sich alle 12,3 Jahre verdoppelt. ⓘ

Jeden Tag werden weltweit riesige Datenmengen gespeichert, aber solange sie nicht effektiv analysiert und präsentiert werden können, verbleiben sie im Wesentlichen in so genannten Datengräbern: "Datenarchive, die nur selten besucht werden". Um dieses Problem anzugehen, entstand in den späten 1980er Jahren der Bereich des Data Mining - "der Prozess der Entdeckung interessanter Muster und Erkenntnisse aus großen Datenmengen". ⓘ

Datenbank-Probleme

Da die Technologie von Tag zu Tag ausgefeilter wird, ergeben sich zunehmend Sicherheitsprobleme, da jeder mehr denn je auf die Speicherung von Informationen in Computern angewiesen ist. Da Daten und Datenbanken in Unternehmen und Organisationen immer wichtiger werden, gelten sie als das "Rückgrat" dieser Unternehmen und Organisationen, was zur Entwicklung verschiedener technologischer Abteilungen wie IT-Abteilungen und Personal führt. ⓘ

Neben den IT-Abteilungen und dem Personal gibt es auch verschiedene Arten von Behörden, die die Belegschaft "verstärken". Das Department of Homeland Security (DHS) ist eines dieser Beispiele, die genau das tun, da sie sicherstellen, dass alle Organisationen über die verschiedenen Notwendigkeiten verfügen, um die Infrastruktur und die Sicherheit zu erhöhen, um sie in Zukunft vor den verschiedenen Herausforderungen zu schützen, die auf sie zukommen können. In Anlehnung an das DHS gibt es auch viele Programme, die das Bewusstsein für Cybersicherheit im gesamten Unternehmen oder in der Belegschaft fördern. ⓘ

- Identifizieren und quantifizieren Sie Ihren Personalbestand im Bereich Cybersicherheit

- Verstehen Sie den Bedarf an Arbeitskräften und Qualifikationslücken

- Stellen Sie die richtigen Mitarbeiter für klar definierte Rollen ein

- Verbessern Sie die Fähigkeiten Ihrer Mitarbeiter durch Schulungen und berufliche Weiterbildung

- Schaffung von Programmen und Erfahrungen zur Bindung von Spitzenkräften ⓘ

Dienstleistungen

Die Technologie und die Dienste, die sie für das Senden und Empfangen elektronischer Nachrichten (Briefe" oder elektronische Briefe" genannt) über ein verteiltes (auch globales) Computernetz bietet. Hinsichtlich der Zusammensetzung der Elemente und des Funktionsprinzips wiederholt die elektronische Post praktisch das System der regulären (Papier-)Post, wobei sowohl die Begriffe (Mail, Brief, Umschlag, Anlage, Box, Zustellung und andere) als auch die charakteristischen Merkmale übernommen werden - einfache Handhabung, Verzögerungen bei der Nachrichtenübermittlung, ausreichende Zuverlässigkeit und gleichzeitig keine Zustellungsgarantie. Die Vorteile der E-Mail sind: leicht wahrnehmbare und von einer Person zu merkende Adressen der Form user_name@domain_name (z.B. somebody@example.com); die Möglichkeit, sowohl reinen Text als auch formatierte sowie beliebige Dateien zu übertragen; Unabhängigkeit von Servern (im allgemeinen adressieren sie sich gegenseitig direkt); ausreichend hohe Zuverlässigkeit der Nachrichtenzustellung; einfache Nutzung durch Menschen und Programme. ⓘ

Nachteile der E-Mail: das Vorhandensein eines Phänomens wie Spam (massive Werbung und virale Mailings); die theoretische Unmöglichkeit der garantierten Zustellung eines bestimmten Briefes; mögliche Verzögerungen bei der Zustellung von Nachrichten (bis zu mehreren Tagen); Beschränkungen der Größe einer Nachricht und der Gesamtgröße der Nachrichten im Postfach (persönlich für die Nutzer). ⓘ

Suchsystem

Ein Software- und Hardwarekomplex mit einer Webschnittstelle, der die Suche nach Informationen im Internet ermöglicht. Unter einer Suchmaschine versteht man in der Regel eine Website, die die Schnittstelle (Front-End) des Systems hostet. Der Softwareteil einer Suchmaschine ist eine Suchmaschine (Search Engine) - ein Satz von Programmen, der die Funktionalität einer Suchmaschine bereitstellt und in der Regel ein Geschäftsgeheimnis der Entwicklerfirma der Suchmaschine ist. Die meisten Suchmaschinen suchen nach Informationen auf World Wide Web-Seiten, aber es gibt auch Systeme, die nach Dateien auf FTP-Servern, Artikeln in Online-Shops und Informationen in Usenet-Newsgroups suchen können. Die Verbesserung der Suche ist eine der Prioritäten des modernen Internets (siehe den Artikel Deep Web über die Hauptprobleme bei der Arbeit von Suchmaschinen). ⓘ

Laut Statista verteilte sich die Nutzung von Suchmaschinen im Oktober 2021 wie folgt:

- Google - 86,64%;

- Bing - 7%;

- Yahoo! - 2,75%.

Laut Statcounter Global Stats für August 2021, in Asien, die chinesische Ressource Baidu gelungen, fast 3% des Internet-Marktes zu nehmen. Im Gegenzug überholte Yandex in der gleichen Region Yahoo und erhielt einen Anteil von fast 2% und den dritten Platz in der Rangliste. ⓘ

Perspektiven

Die Informationstechnik stellt ein Bindeglied zwischen der klassischen Elektrotechnik und der Informatik dar. Das wird z. B. dadurch ersichtlich, dass sich viele elektrotechnische Fakultäten von Hochschulen und Abteilungen höherer Schulen (z. B. Höhere Technische Lehranstalten, HTLs) in „Informationstechnik“ oder zumindest in „Elektrotechnik und Informationstechnik“ bzw. „Informationstechnologie“ umbenennen. ⓘ

Der Informationstechnik nahe ist die Technische Informatik, die sich unter anderem mit Schaltnetzen und -werken sowie dem Aufbau und der Organisation von Computern beschäftigt. Aber auch die (Hardware-)Aspekte der Ausgabe- und Eingabegeräte, also klassische und zukünftige Mensch-Maschine-Schnittstellen (Human-Computer Interfaces), gehören in diesen Bereich. ⓘ

Digitale Signalverarbeitung und Kommunikationstechnik sind wiederum Grundlage für Rechnernetze. Das Zusammenwachsen von Informationstechnik, Telekommunikation und Unterhaltungselektronik wird daher auch oft als Informations- und Kommunikationstechnik (IuK) oder Informations- und Telekommunikationstechnik (ITK) bezeichnet. ⓘ

Entwicklungen der IT haben in den letzten Jahrzehnten viele Bereiche in der Arbeitswelt verändert, so neben der Wirtschaft auch die Wissenschaft. Hierbei ist auch die Erforschung und Entwicklung der Mensch-Computer-Interaktion zunehmend relevant geworden. ⓘ

Durch den verbreiteten Einsatz von IT hat diese durch ihren Ressourcenverbrauch auch einen erheblichen Einfluss auf das Ökosystem der Erde. Nachhaltige und umweltfreundliche IT wird als Grüne IT bezeichnet. ⓘ

Akademische Sichtweise

In einem akademischen Kontext definiert die Association for Computing Machinery Informationstechnologie als "Studiengänge, die Studenten darauf vorbereiten, die computertechnischen Anforderungen von Unternehmen, Behörden, Gesundheitseinrichtungen, Schulen und anderen Organisationen zu erfüllen. IT-Spezialisten übernehmen die Verantwortung für die Auswahl von Hardware- und Softwareprodukten, die für eine Organisation geeignet sind, für die Integration dieser Produkte in die organisatorischen Anforderungen und die Infrastruktur sowie für die Installation, Anpassung und Wartung dieser Anwendungen für die Computerbenutzer der Organisation. ⓘ

Grundständige Abschlüsse im IT-Bereich (B.S., A.S.) ähneln anderen Abschlüssen in der Informatik. Tatsächlich haben sie oft die gleichen Grundkurse. Informatik-Studiengänge konzentrieren sich eher auf Theorie und Design, während Informatik-Studiengänge so strukturiert sind, dass sie den Absolventen Fachkenntnisse in der praktischen Anwendung von Technologielösungen zur Unterstützung moderner Geschäfts- und Benutzeranforderungen vermitteln. ⓘ

Dies trifft jedoch nicht in allen Fällen zu. In Indien beispielsweise ist ein Ingenieurstudium der Informationstechnologie (B.Tech IT) ein vierjähriger berufsbegleitender Studiengang, der als gleichwertig mit einem Abschluss in Informatik und Ingenieurwesen angesehen wird, da die Lehrpläne vieler indischer Universitäten auffallend ähnlich sind. ⓘ

Der B.Tech IT-Abschluss konzentriert sich stark auf die mathematischen Grundlagen der Informatik, da die Studenten in den ersten beiden Jahren Kalkül, lineare Algebra, Graphentheorie und diskrete Mathematik lernen. Das B.Tech. IT-Studiengang umfasst auch Kernfächer der Informatik wie Datenstrukturen, Algorithmusanalyse und -entwurf, Compilerentwurf, Automatentheorie, Computerarchitektur, Betriebssysteme, Computernetzwerke usw. Die Aufnahmeprüfung für die Masterstudiengänge in Indien - GATE - ist sowohl für Studenten der Informatik als auch für Studenten der IT gleich. ⓘ

Wirtschaftliche und beschäftigungspolitische Perspektive

Unternehmen im Bereich der Informationstechnologie werden oft als Gruppe als "Tech-Sektor" oder "Tech-Industrie" bezeichnet. Diese Bezeichnungen können manchmal irreführend sein und sollten nicht mit "Tech-Unternehmen" verwechselt werden, bei denen es sich im Allgemeinen um große, gewinnorientierte Unternehmen handelt, die Technologie und Software für Verbraucher verkaufen. Es ist auch erwähnenswert, dass aus geschäftlicher Sicht die Abteilungen für Informationstechnologie in den meisten Fällen eine "Kostenstelle" sind. Eine Kostenstelle ist eine Abteilung oder ein Mitarbeiter, die bzw. der Ausgaben oder "Kosten" innerhalb eines Unternehmens verursacht, anstatt Gewinne oder Einnahmequellen zu generieren. Moderne Unternehmen stützen sich bei ihren täglichen Abläufen in hohem Maße auf Technologie, so dass die Ausgaben, die zur Deckung der Kosten für Technologien, die den Geschäftsbetrieb effizienter gestalten, verwendet werden, in der Regel als "reine Geschäftskosten" betrachtet werden. Die IT-Abteilungen erhalten von der Unternehmensleitung Mittel zugewiesen und müssen versuchen, die gewünschten Ergebnisse im Rahmen dieses Budgets zu erzielen. Der öffentliche und der private Sektor haben zwar unterschiedliche Finanzierungsmechanismen, aber die Grundsätze sind mehr oder weniger die gleichen. Dies ist ein oft übersehener Grund für das rasche Interesse an Automatisierung und künstlicher Intelligenz, aber der ständige Druck, mit weniger mehr zu erreichen, öffnet der Automatisierung die Tür, um zumindest einige kleinere Vorgänge in großen Unternehmen zu übernehmen. ⓘ

Viele Unternehmen verfügen heute über IT-Abteilungen, die Computer, Netzwerke und andere technische Bereiche ihres Unternehmens verwalten. Die Unternehmen versuchen auch, die IT mit den Geschäftsergebnissen und der Entscheidungsfindung durch eine BizOps- oder Business Operations-Abteilung zu integrieren. ⓘ

In einem geschäftlichen Kontext definiert die Information Technology Association of America Informationstechnologie als "die Untersuchung, das Design, die Entwicklung, die Anwendung, die Implementierung, die Unterstützung oder das Management von computerbasierten Informationssystemen". Zu den Aufgaben der in diesem Bereich Tätigen gehören die Netzwerkadministration, die Softwareentwicklung und -installation sowie die Planung und das Management des Technologie-Lebenszyklus einer Organisation, bei dem Hardware und Software gewartet, aufgerüstet und ersetzt werden. ⓘ

Informationsdienste

Der Begriff "Informationsdienste" bezieht sich auf eine Vielzahl von IT-bezogenen Dienstleistungen, die von kommerziellen Unternehmen sowie von Datenmaklern angeboten werden. ⓘ

Prognostizierte durchschnittliche jährliche prozentuale Veränderung von Produktion und Beschäftigung in ausgewählten Branchen, 2010-2020 ⓘ

Ethische Perspektiven

Der Bereich der Informationsethik wurde in den 1940er Jahren von dem Mathematiker Norbert Wiener begründet. Einige der ethischen Fragen, die mit der Nutzung der Informationstechnologie verbunden sind, sind:

- Verstöße gegen das Urheberrecht durch das Herunterladen von Dateien, die ohne die Erlaubnis der Urheberrechtsinhaber gespeichert wurden

- Arbeitgeber, die die E-Mails und die sonstige Internetnutzung ihrer Mitarbeiter überwachen

- Unerwünschte E-Mails

- Hacker, die auf Online-Datenbanken zugreifen

- Websites, die Cookies oder Spyware installieren, um die Online-Aktivitäten eines Nutzers zu überwachen, was von Datenmaklern genutzt werden kann ⓘ

Die Notwendigkeit von Computersicherheit

Wenn es um Computersicherheit geht, denken die meisten von uns an Computer, die gehackt oder von Cyberkriminellen übernommen wurden. Bei der Computersicherheit geht es jedoch nicht nur um den Schutz der internen Komponenten eines Computers, sondern auch um den Schutz vor Naturkatastrophen wie Tornados, Überschwemmungen, Bränden usw. Computersicherheit ist im Grunde eine Abkürzung für den "Schutz des Computers vor Schaden", d. h. vor Naturkatastrophen, Cyber-Kriminellen oder so ziemlich allem, was dem Computer von innen oder außen schaden kann. ⓘ

Cybersicherheit ist ein großes Thema in der Kategorie Computersicherheit, da es hier im Wesentlichen um den Schutz der Technologie vor unerwünschten Cyberkriminellen oder Trollen geht. Es ist ein sehr wichtiger Aspekt für Unternehmen und Organisationen und ist entscheidend für die allgemeine Gesundheit und das Wohlergehen der Organisationsstruktur. Da die Technologie von Tag zu Tag ausgefeilter wird, nimmt auch die Zahl der Cyberangriffe und Sicherheitsverletzungen zu, was bedeutet, dass die Aufrechterhaltung eines angemessenen Bewusstseins für Cybersicherheit in der Belegschaft sehr wichtig ist. Für die Aufrechterhaltung einer angemessenen Cybersicherheit am Arbeitsplatz müssen bestimmte Personen über besondere Fähigkeiten verfügen, um das Unternehmen oder die Organisation zu "schützen". Es gibt verschiedene Kategorien, in die man dies unterteilen kann, von Netzwerken und Datenbanken bis hin zu Informationssystemen. ⓘ

Im Bereich der Computersicherheit werden Fachleute oder Personen mit einer Ausbildung in den verschiedenen Bereichen dieses Berufs benötigt, um Netzwerke, Datenbanken und Computersysteme vor internen und externen Bedrohungen zu schützen, die potenziell Schaden anrichten könnten. Da die Technologie immer ausgefeilter wird, steigt auch die Gefahr interner Schäden an Computern und Technologien, z. B. durch Ransomware, Malware, Spyware und Phishing-Angriffe. Dies sind nur einige der verschiedenen Probleme, mit denen sich diese Fachleute befassen, denn es gibt eine Vielzahl unterschiedlicher Angriffsarten auf der ganzen Welt. Neben den verschiedenen Problemen und Angriffen gibt es auch eine Vielzahl von Spezialgebieten in diesem Beruf. Diese reichen von der allgemeinen Informatik über Computertechnik, Software-Engineering, Informationssysteme bis hin zu Computersystemen. Da sich die Welt technologisch immer weiter entwickelt, besteht ein dringender Bedarf an Menschen in diesen Berufen, die dabei helfen, diese Upgrades zu entwickeln und auszuführen, um Technologie und Software weltweit sicherer und zuverlässiger zu machen. ⓘ

Gebiete

Vier Teilgebiete werden heute teils unterschieden:

- Business-IT beinhaltet die IT von Handel, Börse, Versicherungen, Banken und Steuerwesen.

- Industrielle IT befasst sich mit der Vernetzung der Maschinen in Herstellungs- und Produktionsprozessen innerhalb eines Werkes, zunehmend aber auch über die Werk- und Firmengrenzen hinweg (Wertschöpfungskette). Neuerdings wird die Industrielle IT direkt an die Geschäftsprozesse angebunden. So entstehen etwa Schnittstellen zwischen den Bussystemen, die die Maschinen steuern, und den Ressourcen-Planungs-Systemen (ERP-Software). ⓘ

„Eine gebräuchliche Bezeichnung im Einsatzgebiet industrieller IT ist der Fachbegriff Operational Technology (OT), der versucht, alle interagierenden Komponenten in komplexen und abhängigen Systemen zu beschreiben. Diese Komponenten werden meist über SCADA-Systeme hochintegriert gesteuert und überwacht.“ ⓘ

- Kommunikations-IT befasst sich mit dem Einsatz der Telekommunikation.

- Unterhaltungs-IT befasst sich mit Spielgeräten und Multimedia-Anwendungen. ⓘ

Sicherheit

Die Informationstechnik wird von Unternehmen, der Verwaltung, Vereinen, privaten und sonstigen Anwendern genutzt. Für einen reibungslosen Ablauf ist die Sicherheit von hoher Bedeutung. Ohne Schutzmechanismen können Hacker, Cracker oder Scriptkiddies die Infrastruktur durch Schadprogramme oder andere Manipulationen wie Überlastung stören oder schädigen. Durch Schutzsoftware und weitere präventive Maßnahmen kann den Attacken vorgebeugt werden. ⓘ

Lehrberuf in Österreich

In Österreich ist Informationstechnologie auch ein anerkannter Lehrberuf im Sinne des Berufsausbildungsgesetzes. Die Ausbildung spaltet sich dabei schon zu Beginn an in die zwei getrennten Bereiche Informatik und Technik, die Lehrzeit bleibt mit 4 Jahren jedoch gleich. Während das Hauptaugenmerk der Informatik-Ausbildung mehr um die Programmierung und Anpassung von Software kreist, ist die Technik-Ausbildung mehrheitlich Hardware-spezifisch. ⓘ