Bildsensor

Ein Bildsensor oder Imager ist ein Sensor, der Informationen zur Erstellung eines Bildes erkennt und überträgt. Dazu wandelt er die unterschiedliche Abschwächung von Lichtwellen (die durch Objekte hindurchgehen oder von ihnen reflektiert werden) in Signale um, kleine Stromstöße, die die Informationen übertragen. Bei den Wellen kann es sich um Licht oder andere elektromagnetische Strahlung handeln. Bildsensoren werden in elektronischen Bildgebungsgeräten sowohl analoger als auch digitaler Art verwendet, z. B. in Digitalkameras, Kameramodulen, Kameratelefonen, optischen Mäusen, medizinischen Bildgebungsgeräten, Nachtsichtgeräten wie Wärmebildgeräten, Radar, Sonar und anderen. Im Zuge des technologischen Wandels wird die chemische und analoge Bildgebung zunehmend durch elektronische und digitale Bildgebung ersetzt. ⓘ

Die beiden Haupttypen elektronischer Bildsensoren sind der ladungsgekoppelte Sensor (CCD) und der Aktivpixelsensor (CMOS-Sensor). Sowohl CCD- als auch CMOS-Sensoren beruhen auf der Metall-Oxid-Halbleiter-Technologie (MOS), wobei CCDs auf MOS-Kondensatoren und CMOS-Sensoren auf MOSFET-Verstärkern (MOS-Feldeffekttransistoren) beruhen. Analoge Sensoren für unsichtbare Strahlung arbeiten in der Regel mit verschiedenen Arten von Vakuumröhren, während digitale Sensoren Flachdetektoren umfassen. ⓘ

Ein Bildsensor ist eine Vorrichtung zur Aufnahme von zweidimensionalen Abbildern aus Licht auf elektrischem oder mechanischem Wege. In den meisten Fällen werden halbleiterbasierte Bildsensoren verwendet, die Licht bis ins mittlere Infrarot aufnehmen können. Es existieren aber auch zweidimensionale Halbleiterdetektoren für die Aufnahme hochenergetischer ionisierender Strahlungsarten wie Röntgen- und Gammastrahlung. ⓘ

Technische Lösungen zur Aufnahme eines Bildes im sichtbaren Bereich bis zum Infrarotbereich beruhen oft auf zweidimensionalen Anordnungen (Arrays), deren Signale elektronisch ausgelesen werden. Insbesondere bei Infrarot bezeichnet man diese auch als Focal Plane Array (FPA). ⓘ

CCD- vs. CMOS-Sensoren

Die beiden Haupttypen digitaler Bildsensoren sind der ladungsgekoppelte Sensor (CCD) und der Aktivpixelsensor (CMOS-Sensor), die in Komplementär-MOS- (CMOS) oder N-Typ-MOS-Technologie (NMOS oder Live-MOS) hergestellt werden. Sowohl CCD- als auch CMOS-Sensoren basieren auf der MOS-Technologie, wobei MOS-Kondensatoren die Bausteine eines CCD-Sensors und MOSFET-Verstärker die Bausteine eines CMOS-Sensors sind. ⓘ

In Kameras, die in kleine Verbraucherprodukte integriert sind, werden in der Regel CMOS-Sensoren verwendet, die in der Regel billiger sind und in batteriebetriebenen Geräten weniger Strom verbrauchen als CCDs. CCD-Sensoren werden für hochwertige Videokameras in Sendequalität verwendet, während CMOS-Sensoren in der Standfotografie und bei Konsumgütern dominieren, wo die Gesamtkosten eine wichtige Rolle spielen. Beide Sensortypen erfüllen die gleiche Aufgabe, nämlich die Aufnahme von Licht und dessen Umwandlung in elektrische Signale. ⓘ

Jede Zelle eines CCD-Bildsensors ist ein analoges Bauteil. Wenn Licht auf den Chip fällt, wird es als kleine elektrische Ladung in jedem Fotosensor gespeichert. Die Ladungen in der Pixelzeile, die den (einem oder mehreren) Ausgangsverstärkern am nächsten liegt, werden verstärkt und ausgegeben, dann verschiebt jede Pixelzeile ihre Ladungen eine Zeile näher zu den Verstärkern und füllt die leere Zeile, die den Verstärkern am nächsten liegt. Dieser Vorgang wird so lange wiederholt, bis alle Pixelzeilen ihre Ladung verstärkt und ausgegeben haben. ⓘ

Ein CMOS-Bildsensor hat einen Verstärker für jedes Pixel im Vergleich zu den wenigen Verstärkern eines CCD. Dieses Problem wurde jedoch durch die Verwendung von Mikrolinsen vor jeder Fotodiode gelöst, die Licht in die Fotodiode fokussieren, das andernfalls den Verstärker getroffen hätte und nicht erkannt worden wäre. Einige CMOS-Bildsensoren verwenden auch eine Rückseitenbeleuchtung, um die Anzahl der Photonen, die auf die Photodiode treffen, zu erhöhen. CMOS-Sensoren können potenziell mit weniger Komponenten implementiert werden, verbrauchen weniger Strom und/oder ermöglichen eine schnellere Auslesung als CCD-Sensoren. Außerdem sind sie weniger anfällig für Entladungen statischer Elektrizität. ⓘ

Ein anderes Design, eine hybride CCD/CMOS-Architektur (die unter dem Namen "sCMOS" verkauft wird), besteht aus integrierten CMOS-Ausleseschaltungen (ROICs), die auf ein CCD-Abbildungssubstrat geklebt werden - eine Technologie, die für Infrarot-Star-Arrays entwickelt und an die siliziumbasierte Detektortechnologie angepasst wurde. Ein anderer Ansatz ist die Nutzung der sehr kleinen Abmessungen, die in der modernen CMOS-Technologie verfügbar sind, um eine CCD-ähnliche Struktur vollständig in CMOS-Technologie zu implementieren: Solche Strukturen können durch die Trennung einzelner Poly-Silizium-Gates durch einen sehr kleinen Spalt erreicht werden; obwohl es sich noch um ein Forschungsprodukt handelt, können hybride Sensoren potenziell die Vorteile sowohl von CCD- als auch von CMOS-Bildgebern nutzen. ⓘ

Leistung

Die Leistung eines Bildsensors lässt sich anhand zahlreicher Parameter bewerten, darunter Dynamikbereich, Signal-Rausch-Verhältnis und Empfindlichkeit bei schwachem Licht. Bei vergleichbaren Sensortypen verbessern sich das Signal-Rausch-Verhältnis und der Dynamikbereich mit zunehmender Größe. ⓘ

Steuerung der Belichtungszeit

Die Belichtungszeit von Bildsensoren wird im Allgemeinen entweder durch einen herkömmlichen mechanischen Verschluss, wie bei Filmkameras, oder durch einen elektronischen Verschluss gesteuert. Elektronische Verschlüsse können "global" sein, d. h. die Anhäufung von Fotoelektronen im gesamten Bildsensorbereich wird gleichzeitig gestartet und gestoppt, oder "rollend", d. h. das Belichtungsintervall jeder Zeile geht der Auslesung dieser Zeile unmittelbar voraus, und zwar in einem Prozess, der über das Bildfeld "rollt" (typischerweise von oben nach unten im Querformat). Elektronische Globalverschlüsse sind weniger gebräuchlich, da sie "Speicher"-Schaltungen benötigen, um die Ladung vom Ende des Belichtungsintervalls bis zum Auslesevorgang zu halten, der in der Regel einige Millisekunden später erfolgt. ⓘ

Farbtrennung

Es gibt mehrere Haupttypen von Farbbildsensoren, die sich durch die Art des Farbseparationsmechanismus unterscheiden:

- Bayer-Filter-Sensor, kostengünstig und am weitesten verbreitet, mit einer Farbfilteranordnung, die rotes, grünes und blaues Licht an ausgewählte Pixelsensoren weiterleitet. Jedes einzelne Sensorelement wird mit Hilfe eines Farbgels aus chemischen Farbstoffen, die auf die Elemente aufgebracht werden, für Rot, Grün oder Blau empfindlich gemacht. Die gebräuchlichste Filtermatrix, das Bayer-Muster, verwendet zwei grüne Pixel für jedes Rot und Blau. Dies führt zu einer geringeren Auflösung für rote und blaue Farben. Die fehlenden Farbmuster können mit einem Demosaicing-Algorithmus interpoliert oder durch verlustbehaftete Komprimierung ganz ignoriert werden. Um die Farbinformationen zu verbessern, verwenden Techniken wie das Color-Co-Site-Sampling einen Piezo-Mechanismus, der den Farbsensor in Pixelschritten verschiebt.

- Der Foveon X3-Sensor verwendet eine Anordnung von geschichteten Pixelsensoren, die das Licht über die wellenlängenabhängige Absorptionseigenschaft von Silizium trennen, so dass an jeder Stelle alle drei Farbkanäle erfasst werden. Diese Methode ähnelt der Funktionsweise von Farbfilmen für die Fotografie.

- 3CCD, bei dem drei diskrete Bildsensoren verwendet werden, wobei die Farbtrennung durch ein dichroitisches Prisma erfolgt. Die dichroitischen Elemente sorgen für eine schärfere Farbtrennung und verbessern so die Farbqualität. Da jeder Sensor innerhalb seines Durchlassbereichs und bei voller Auflösung gleich empfindlich ist, bieten 3-CCD-Sensoren eine bessere Farbqualität und eine bessere Leistung bei schlechten Lichtverhältnissen. 3-CCD-Sensoren erzeugen ein vollständiges 4:4:4-Signal, das bei Fernsehübertragungen, Videobearbeitung und visuellen Chroma-Key-Effekten bevorzugt wird. ⓘ

Spezialsensoren

Spezialsensoren werden in verschiedenen Anwendungen eingesetzt, z. B. in der Thermografie, bei der Erstellung von Multispektralbildern, bei Video-Laryngoskopen, Gammakameras, Sensorarrays für Röntgenstrahlen und anderen hochempfindlichen Arrays für die Astronomie. ⓘ

Während Digitalkameras in der Regel einen flachen Sensor verwenden, hat Sony 2014 einen Prototyp eines gekrümmten Sensors entwickelt, um die bei einem flachen Sensor auftretende Petzval-Feldkrümmung zu verringern bzw. zu beseitigen. Die Verwendung eines gekrümmten Sensors ermöglicht einen kürzeren und kleineren Durchmesser des Objektivs mit weniger Elementen und Komponenten mit größerer Blende und geringerem Lichtabfall am Rand des Fotos. ⓘ

Geschichte

Die ersten analogen Sensoren für sichtbares Licht waren Videokameraröhren. Sie gehen auf die 1930er Jahre zurück, und bis in die 1980er Jahre wurden verschiedene Typen entwickelt. Anfang der 1990er Jahre wurden sie durch moderne Festkörper-CCD-Bildsensoren ersetzt. ⓘ

Die Grundlage für moderne Festkörper-Bildsensoren ist die MOS-Technologie, die auf die Erfindung des MOSFET durch Mohamed M. Atalla und Dawon Kahng in den Bell Labs im Jahr 1959 zurückgeht. Spätere Forschungen auf dem Gebiet der MOS-Technologie führten zur Entwicklung von Halbleiter-Bildsensoren, darunter der ladungsgekoppelte Sensor (CCD) und später der Aktiv-Pixel-Sensor (CMOS-Sensor). ⓘ

Der Passiv-Pixel-Sensor (PPS) war der Vorläufer des Aktiv-Pixel-Sensors (APS). Ein PPS besteht aus passiven Pixeln, die ohne Verstärkung ausgelesen werden, wobei jedes Pixel aus einer Fotodiode und einem MOSFET-Schalter besteht. Es handelt sich um eine Art Fotodioden-Array, wobei die Pixel einen p-n-Übergang, einen integrierten Kondensator und MOSFETs als Auswahltransistoren enthalten. Ein Fotodioden-Array wurde 1968 von G. Weckler vorgeschlagen. Dies war die Grundlage für das PPS. Diese frühen Fotodioden-Arrays waren komplex und unpraktisch, da in jedem Pixel Auswahltransistoren und On-Chip-Multiplexer-Schaltungen erforderlich waren. Das Rauschen von Fotodioden-Arrays war ebenfalls eine Leistungseinschränkung, da die Kapazität des Fotodioden-Auslesebusses zu einem erhöhten Rauschpegel führte. Auch die korrelierte Doppelabtastung (Correlated Double Sampling, CDS) konnte mit einem Fotodioden-Array ohne externen Speicher nicht verwendet werden. ⓘ

Im Juni 2022 gab Samsung Electronics bekannt, dass das Unternehmen einen Bildsensor mit 200 Millionen Pixeln entwickelt hat. Der 200MP ISOCELL HP3 hat 0,56 Mikrometer-Pixel, wobei Samsung angibt, dass frühere Sensoren 064 Mikrometer-Pixel hatten, was einem Rückgang von 12 % gegenüber 2019 entspricht. Der neue Sensor enthält 200 Millionen Pixel in einem 2 x 1,4 Zoll großen Objektiv. ⓘ

Ladungsgekoppeltes Bauelement

Das ladungsgekoppelte Bauelement (CCD) wurde 1969 von Willard S. Boyle und George E. Smith in den Bell Labs erfunden. Bei der Erforschung der MOS-Technologie erkannten sie, dass eine elektrische Ladung die Analogie zur magnetischen Blase ist und dass sie in einem winzigen MOS-Kondensator gespeichert werden kann. Da es relativ einfach war, eine Reihe von MOS-Kondensatoren hintereinander zu schalten, legten sie eine geeignete Spannung an, so dass die Ladung stufenweise von einem zum nächsten weitergegeben werden konnte. Der CCD ist ein Halbleiterschaltkreis, der später in den ersten digitalen Videokameras für Fernsehübertragungen verwendet wurde. ⓘ

Frühe CCD-Sensoren litten unter einer Auslöseverzögerung. Dies wurde mit der Erfindung der Pinned Photodiode (PPD) weitgehend behoben. Sie wurde 1980 von Nobukazu Teranishi, Hiromitsu Shiraki und Yasuo Ishihara bei NEC erfunden. Es handelte sich um eine Photodetektorstruktur mit geringer Verzögerung, geringem Rauschen, hoher Quanteneffizienz und niedrigem Dunkelstrom. Ab 1987 wurde der PPD in die meisten CCD-Bauteile eingebaut und hielt Einzug in elektronische Videokameras und später in digitale Fotokameras. Seitdem wurde der PPD in fast allen CCD-Sensoren und später in CMOS-Sensoren verwendet. ⓘ

Aktiv-Pixel-Sensor

Der NMOS-Aktivpixelsensor (APS) wurde Mitte der 1980er Jahre von Olympus in Japan erfunden. Ermöglicht wurde dies durch Fortschritte bei der Herstellung von MOS-Halbleiterbauelementen, wobei die Skalierung von MOSFETs auf kleinere Mikrometer- und später Submikrometer-Ebenen erfolgte. Der erste NMOS-APS wurde 1985 von Tsutomu Nakamuras Team bei Olympus hergestellt. Der CMOS-Aktiv-Pixel-Sensor (CMOS-Sensor) wurde 1993 vom Team um Eric Fossum am Jet Propulsion Laboratory der NASA entwickelt. Bis 2007 übertraf der Absatz von CMOS-Sensoren den von CCD-Sensoren. In den 2010er Jahren verdrängten die CMOS-Sensoren die CCD-Sensoren bei allen neuen Anwendungen weitgehend. ⓘ

Andere Bildsensoren

Die erste kommerzielle Digitalkamera, die Cromemco Cyclops von 1975, verwendete einen 32×32 MOS-Bildsensor. Es handelte sich um einen modifizierten dynamischen MOS-RAM-Speicherchip (DRAM). ⓘ

MOS-Bildsensoren sind in der optischen Maustechnologie weit verbreitet. Die erste optische Maus, die 1980 von Richard F. Lyon bei Xerox erfunden wurde, verwendete einen 5 µm NMOS-Sensorchip mit integrierter Schaltung. Seit der ersten kommerziellen optischen Maus, der 1999 eingeführten IntelliMouse, verwenden die meisten optischen Mausgeräte CMOS-Sensoren. ⓘ

Im Februar 2018 kündigten Forscher am Dartmouth College eine neue Bildsensortechnologie an, die die Forscher QIS (Quanta Image Sensor) nennen. Anstelle von Pixeln haben QIS-Chips das, was die Forscher "Jots" nennen. Jedes Jot kann ein einzelnes Lichtteilchen, ein sogenanntes Photon, erkennen. ⓘ

Bauformen

Beispiele für Bildsensoren im sichtbaren Bereich und im nahen Infrarotbereich:

- Siliziumsensoren weisen relativ geringes Bildrauschen auf, was möglicherweise durch die Verwendung von schwarzem Silizium weiter reduziert werden könnte.

- CCD-Sensor, mit Filterrad oder farbempfindlichen Sensoren (Interferenzfilter pro Pixel, siehe Bayer-Sensor) auch für Farbbilder

- Active Pixel Sensor (APS), basierend auf der CMOS-Technik, mit nebeneinander oder übereinander liegenden farbempfindlichen Sensoren (siehe Foveon X3) auch für Farbbilder

- Vidiconröhre

- Ikonoskop ⓘ

Beispiele für Bildsensoren für andere Spektralbereiche:

- Nipkowscheibe (historisch für Licht, jedoch auch für andere Strahlungsarten verwendbar)

- Mikrobolometerarray (mittleres bis fernes Infrarot, in der Astronomie, in Wärmebildkameras und Zielsuchsystemen)

- Pyroelektrisches Array (mittleres bis fernes Infrarot)

- Focal Plane Arrays auf Basis von Fotodioden aus Quecksilber-Cadmium-Tellurid, für Wärmebildkameras und Zielsuchsysteme im mittleren Infrarotbereich (Wellenlänge: 3,5–5 µm) ⓘ

Bildaufnahmeröhren und Restlichtverstärker, auch die Mikrokanalplatte dienen der Verstärkung eines Bildsignales oder dessen Umwandlung in sichtbares Licht. Sie werden nicht als Bildsensor bezeichnet, obwohl sie oft wesentliche Merkmale eines solchen haben. ⓘ

Siliziumsensoren

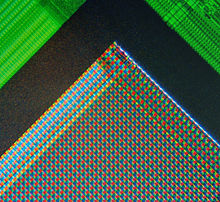

Bayer-Sensor

Als Bayer-Sensor bezeichnet man einen Fotosensor, der – ähnlich einem Schachbrett – mit einem Farbfilter überzogen ist, welcher meist zu 50 % aus Grün und je 25 % aus Rot und Blau besteht. Grün ist in der Flächenzuweisung und somit in der Auflösungsfähigkeit privilegiert, weil der Grün-Anteil in Grautönen beim menschlichen Auge den größten Beitrag zur Helligkeitswahrnehmung und somit auch zur Kontrast-Wahrnehmung und Schärfe-Wahrnehmung leistet: 72 % der Helligkeits- und Kontrastwahrnehmung von Grautönen wird durch deren Grünanteil verursacht, dagegen leistet Rot nur 21 % und Blau nur 7 %. Zudem ist Grün, als die mittlere Farbe im Farbspektrum, diejenige, für die Objektive in der Regel die höchste Schärfe und Auflösung liefern. Nach diesem Konzept der Bayer-Matrix arbeiten fast alle gebräuchlichen Bildsensoren in digitalen Fotokameras und Filmkameras. ⓘ

Nanosensoren

Hierbei handelt es sich um spezielle, sehr kleine Sensoren, um kleine Abbildungen mit hoher Auflösung zu scannen (abzutasten), wie bei elektronischen Lichtmikroskopen oder Refraktiometern mit folgenden Eigenschaften:

- Sehr geringe Pixelgröße

- Hohe optische Auflösung

- Geringe Empfindlichkeit

- Geringe Dynamik ⓘ

Röntgensensoren

Hierbei handelt es sich um mit einer strahlungsempfindlichen Schicht versehene Detektoren für digitales Röntgen (TFA-Sensor) mit folgenden Eigenschaften:

- Hohe Pixelgröße

- Geringe optische Auflösung

- Hohe Empfindlichkeit

- Mittlere Dynamik ⓘ

Digitale Fotografie

Sensorgrößen und -formate

In nebenstehender Grafik sind gängige Sensorgrößen dargestellt, die in digitalen Video- und Fotokameras zum Einsatz kommen. Lässt man die Mittelformatsensoren außer Betracht, ist zwischen dem kleinsten und dem größten Sensor, die in Kompakt- und Spiegelreflexkameras verwendet werden, ein 56-facher Größenunterschied bezogen auf die Sensorfläche erkennbar. Dieser Unterschied ist einer von mehreren Faktoren, welche die Bildqualität und Lichtempfindlichkeit beeinflussen. Der größte im Jahr 2010 gebaute Bildsensor hat eine effektive Größe von 205 mm × 202 mm. Der Preis für die Sensorchips steigt üblicherweise überproportional zur Sensorfläche. ⓘ

| Format | Bilddiagonale |

|---|---|

| Micro-Four-Thirds und Four-Thirds | 21,633 mm |

| APS-C und DX | 27–28 mm |

| FX (Vollformat) | 43,267 mm |

Die Zoll-Bezeichnungen in nebenstehender Grafik haben keinen direkten Bezug zum Zoll-Maß mehr. Die Maßangaben beruhen auf den Eigenschaften der Vidiconröhre. ⓘ

Bildauflösung und Pixelanordnung

In der Digitalfotografie wird die gerundete Gesamtzahl der Bildpunkte in Megapixeln als Anhaltspunkt für die theoretisch erreichbare Auflösung angegeben. Die tatsächliche Auflösung hängt aber von vielerlei Faktoren ab – die Pixelanzahl allein lässt keine Qualitätsaussage zu. Gab es anfangs fast nur das Seitenverhältnis 4:3, gibt es nun zunehmend auch das 3:2-Format des klassischen Kleinbilds sowie Kameramodelle mit 16:9-Format. ⓘ