Bestätigungsfehler

Bestätigungsvoreingenommenheit ist die Tendenz, Informationen so zu suchen, zu interpretieren, zu bevorzugen und abzurufen, dass sie die eigenen früheren Überzeugungen oder Werte bestätigen oder unterstützen. Menschen zeigen diese Voreingenommenheit, wenn sie Informationen auswählen, die ihre Ansichten unterstützen, und gegenteilige Informationen ignorieren, oder wenn sie mehrdeutige Beweise so interpretieren, dass sie ihre bestehenden Einstellungen bestätigen. Am stärksten ist dieser Effekt bei gewünschten Ergebnissen, bei emotional aufgeladenen Themen und bei tief verwurzelten Überzeugungen. Bestätigungsfehler können nicht beseitigt werden, aber man kann sie in den Griff bekommen, z. B. durch Schulung und Training in kritischem Denken. ⓘ

Die voreingenommene Suche nach Informationen, die voreingenommene Interpretation dieser Informationen und der voreingenommene Abruf von Erinnerungen wurden zur Erklärung von vier spezifischen Effekten herangezogen:

- Einstellungspolarisierung (wenn eine Meinungsverschiedenheit extremer wird, obwohl die verschiedenen Parteien denselben Beweisen ausgesetzt sind)

- Perseveranz von Überzeugungen (wenn Überzeugungen fortbestehen, nachdem sich die Beweise für sie als falsch erwiesen haben)

- der irrationale Primacy-Effekt (ein größeres Vertrauen in Informationen, die zu Beginn einer Serie auftauchen)

- die illusorische Korrelation (wenn Menschen fälschlicherweise einen Zusammenhang zwischen zwei Ereignissen oder Situationen wahrnehmen). ⓘ

Eine Reihe von psychologischen Experimenten in den 1960er Jahren legte nahe, dass Menschen dazu neigen, ihre bestehenden Überzeugungen zu bestätigen. Spätere Arbeiten interpretierten diese Ergebnisse als eine Tendenz, Ideen einseitig zu testen, sich auf eine Möglichkeit zu konzentrieren und Alternativen zu ignorieren. Im Allgemeinen zeigen die aktuellen Erklärungen für die beobachteten Verzerrungen, dass der Mensch nur begrenzt in der Lage ist, alle verfügbaren Informationen zu verarbeiten, was dazu führt, dass er nicht in neutraler, wissenschaftlicher Weise untersuchen kann. ⓘ

Fehlerhafte Entscheidungen aufgrund von Bestätigungsfehlern wurden in politischen, organisatorischen, finanziellen und wissenschaftlichen Zusammenhängen festgestellt. Diese Voreingenommenheit trägt zu übermäßigem Vertrauen in persönliche Überzeugungen bei und kann Überzeugungen angesichts gegenteiliger Beweise aufrechterhalten oder verstärken. Bestätigungsfehler führen beispielsweise zu systematischen Fehlern in der wissenschaftlichen Forschung, die auf induktivem Denken (der allmählichen Anhäufung von unterstützenden Beweisen) beruht. In ähnlicher Weise kann ein Polizeibeamter einen Verdächtigen früh in einer Untersuchung identifizieren, dann aber nur nach bestätigenden statt nach widerlegenden Beweisen suchen. Ein Mediziner kann sich zu Beginn einer diagnostischen Sitzung vorschnell auf eine bestimmte Störung konzentrieren und dann nur nach bestätigenden Beweisen suchen. In den sozialen Medien wird der Confirmation Bias durch die Verwendung von Filterblasen oder "algorithmischer Bearbeitung" verstärkt, die dem Einzelnen nur Informationen anzeigen, denen er wahrscheinlich zustimmt, während gegenteilige Ansichten ausgeschlossen werden. ⓘ

Ein Bestätigungsfehler (auch Bestätigungstendenz oder Bestätigungsverzerrung, engl. confirmation bias) ist ein Begriff der Kognitionspsychologie, der die Neigung bezeichnet, Informationen so auszuwählen, zu ermitteln und zu interpretieren, dass diese die eigenen Erwartungen erfüllen (bestätigen). Die erste Theorie zu dieser kognitiven Verzerrung stammt von Peter Wason (1960, 1968). ⓘ

Definition und Kontext

Der vom englischen Psychologen Peter Wason geprägte Begriff Confirmation Bias bezeichnet die Tendenz von Menschen, Informationen zu bevorzugen, die ihre Überzeugungen oder Wertvorstellungen bestätigen oder verstärken, und die, einmal bestätigt, nur schwer wieder verworfen werden können. Confirmation bias ist ein Beispiel für eine kognitive Verzerrung. ⓘ

Confirmation bias (oder confirmatory bias) wird auch als myside bias bezeichnet. Auch der Begriff "Congeniality bias" wurde bereits verwendet. ⓘ

Bestätigungsvoreingenommenheit ist ein Effekt bei der Informationsverarbeitung. Sie unterscheiden sich von dem so genannten Bestätigungseffekt, der allgemein als selbsterfüllende Prophezeiung bekannt ist und bei dem die Erwartungen einer Person ihr eigenes Verhalten beeinflussen und das erwartete Ergebnis herbeiführen. ⓘ

Einige Psychologen beschränken den Begriff "Bestätigungsvoreingenommenheit" auf das selektive Sammeln von Beweisen, die das unterstützen, was man bereits glaubt, während Beweise, die eine andere Schlussfolgerung unterstützen, ignoriert oder zurückgewiesen werden. Andere verwenden den Begriff im weiteren Sinne für die Tendenz, bestehende Überzeugungen beizubehalten, wenn man nach Beweisen sucht, sie interpretiert oder sie aus dem Gedächtnis abruft. ⓘ

Confirmation Bias ist eher das Ergebnis automatischer, unbeabsichtigter Strategien als einer absichtlichen Täuschung. Bestätigungsfehler lassen sich nicht vermeiden oder beseitigen, sondern nur durch Verbesserung der Bildung und der Fähigkeiten zum kritischen Denken in den Griff bekommen. ⓘ

Bestätigungsvoreingenommenheit ist ein weit gefasstes Konstrukt, für das es eine Reihe möglicher Erklärungen gibt, nämlich: Hypothesenprüfung durch Falsifikation, Hypothesenprüfung durch positive Teststrategie und Erklärungen für die Informationsverarbeitung. ⓘ

Arten von Bestätigungsfehlern

Voreingenommene Suche nach Informationen

In Experimenten wurde wiederholt festgestellt, dass Menschen dazu neigen, Hypothesen einseitig zu prüfen, indem sie nach Beweisen suchen, die mit ihrer aktuellen Hypothese übereinstimmen. Anstatt alle relevanten Beweise zu durchforsten, formulieren sie Fragen, um eine positive Antwort zu erhalten, die ihre Theorie unterstützt. Sie suchen nach den Konsequenzen, die sie erwarten würden, wenn ihre Hypothese wahr wäre, und nicht danach, was passieren würde, wenn sie falsch wäre. Ein Beispiel: Jemand, der Ja/Nein-Fragen verwendet, um eine Zahl zu finden, von der er annimmt, dass sie die Zahl 3 ist, könnte fragen: "Ist es eine ungerade Zahl?" Menschen bevorzugen diese Art von Frage, die als "positiver Test" bezeichnet wird, selbst wenn ein negativer Test wie "Ist es eine gerade Zahl?" genau die gleiche Information liefern würde. Das bedeutet jedoch nicht, dass die Menschen nach Tests suchen, die eine positive Antwort garantieren. In Studien, in denen die Probanden zwischen solchen Pseudotests und echten Diagnosetests wählen konnten, bevorzugten sie die echten Diagnosetests. ⓘ

Die Vorliebe für positive Tests an sich ist keine Verzerrung, da positive Tests sehr informativ sein können. In Kombination mit anderen Effekten kann diese Strategie jedoch bestehende Überzeugungen oder Annahmen bestätigen, unabhängig davon, ob sie wahr sind. In der realen Welt ist die Beweislage oft komplex und uneinheitlich. So können beispielsweise verschiedene widersprüchliche Vorstellungen über eine Person durch die Konzentration auf einen Aspekt ihres Verhaltens gestützt werden. Die Suche nach Beweisen, die für eine Hypothese sprechen, ist daher wahrscheinlich erfolgreich. Ein Beispiel dafür ist die Art und Weise, wie die Formulierung einer Frage die Antwort erheblich verändern kann. So geben beispielsweise Personen, die gefragt werden: "Sind Sie mit Ihrem Sozialleben zufrieden?", eine größere Zufriedenheit an als Personen, die gefragt werden: "Sind Sie mit Ihrem Sozialleben unglücklich?" ⓘ

Selbst eine kleine Änderung in der Formulierung einer Frage kann die Art und Weise beeinflussen, wie Menschen die verfügbaren Informationen durchsuchen, und damit auch die Schlussfolgerungen, zu denen sie gelangen. Dies wurde anhand eines fiktiven Sorgerechtsfalls gezeigt. Die Teilnehmer lasen, dass Elternteil A in mehrfacher Hinsicht mäßig geeignet war, der Vormund zu sein. Elternteil B verfügte über eine Mischung aus hervorstechenden positiven und negativen Eigenschaften: eine enge Beziehung zu dem Kind, aber eine Arbeit, die ihn für längere Zeit von dem Kind fernhält. Auf die Frage "Welcher Elternteil sollte das Sorgerecht für das Kind haben?" entschied sich die Mehrheit der Teilnehmer für Elternteil B, wobei sie vor allem auf die positiven Eigenschaften achteten. Auf die Frage "Welchem Elternteil sollte das Sorgerecht für das Kind verweigert werden?" suchten sie jedoch nach negativen Eigenschaften und die Mehrheit antwortete, dass Elternteil B das Sorgerecht verweigert werden sollte, was bedeutet, dass Elternteil A das Sorgerecht haben sollte. ⓘ

Ähnliche Studien haben gezeigt, wie Menschen voreingenommen nach Informationen suchen, aber auch, dass dieses Phänomen durch eine Vorliebe für echte diagnostische Tests eingeschränkt sein kann. In einem ersten Experiment bewerteten die Teilnehmer eine andere Person auf der Persönlichkeitsdimension Introversion-Extroversion auf der Grundlage eines Interviews. Sie wählten die Interviewfragen aus einer vorgegebenen Liste aus. Wenn die befragte Person als introvertiert vorgestellt wurde, wählten die Teilnehmer Fragen, die Introvertiertheit voraussetzten, wie z. B. "Was finden Sie an lauten Partys unangenehm?" Wenn die befragte Person als extrovertiert beschrieben wurde, gingen fast alle Fragen von Extrovertiertheit aus, z. B. "Was würden Sie tun, um eine langweilige Party zu beleben?" Diese belasteten Fragen gaben den Befragten wenig oder gar keine Gelegenheit, die Hypothese über sie zu falsifizieren. In einer späteren Version des Experiments wurden den Teilnehmern weniger anmaßende Fragen gestellt, wie z. B. "Scheuen Sie sich vor sozialen Interaktionen?" Die Teilnehmer zogen es vor, diese eher diagnostischen Fragen zu stellen und zeigten nur eine schwache Tendenz zu positiven Tests. Dieses Muster, d. h. eine Hauptpräferenz für diagnostische Tests und eine schwächere Präferenz für positive Tests, wurde auch in anderen Studien beobachtet. ⓘ

Persönlichkeitsmerkmale beeinflussen und interagieren mit voreingenommenen Suchprozessen. Menschen sind unterschiedlich gut in der Lage, ihre Einstellungen gegen Angriffe von außen zu verteidigen, wenn es um selektive Exposition geht. Selektive Exposition liegt vor, wenn Personen nach Informationen suchen, die mit ihren persönlichen Überzeugungen übereinstimmen, anstatt ihnen zu widersprechen. In einem Experiment wurde untersucht, inwieweit Personen Argumente widerlegen können, die ihren persönlichen Überzeugungen widersprechen. Menschen mit hohem Selbstvertrauen suchen eher nach Informationen, die ihrer persönlichen Position widersprechen, um ein Argument zu bilden. Dies kann in Form von oppositionellem Nachrichtenkonsum geschehen, bei dem Personen gegensätzliche parteiische Nachrichten suchen, um Gegenargumente zu finden. Personen mit geringem Selbstvertrauen suchen nicht nach widersprüchlichen Informationen und bevorzugen Informationen, die ihre persönliche Position unterstützen. Menschen generieren und bewerten Beweise in Argumenten, die auf ihre eigenen Überzeugungen und Meinungen ausgerichtet sind. Ein höheres Maß an Selbstvertrauen verringert die Präferenz für Informationen, die die persönlichen Überzeugungen der Teilnehmer unterstützen. ⓘ

In einem anderen Experiment erhielten die Teilnehmer eine komplexe Aufgabe zur Entdeckung von Regeln, bei der sie Objekte bewegen mussten, die von einem Computer simuliert wurden. Die Objekte auf dem Computerbildschirm folgten bestimmten Gesetzen, die die Teilnehmer herausfinden mussten. So konnten die Teilnehmer Objekte über den Bildschirm "feuern", um ihre Hypothesen zu testen. Trotz zahlreicher Versuche während einer zehnstündigen Sitzung gelang es keinem der Teilnehmer, die Regeln des Systems zu verstehen. Sie versuchten in der Regel, ihre Hypothesen zu bestätigen, anstatt sie zu widerlegen, und zögerten, Alternativen in Betracht zu ziehen. Selbst wenn sie objektive Beweise sahen, die ihre Arbeitshypothesen widerlegten, führten sie häufig dieselben Tests weiter durch. Einigen Teilnehmern wurde zwar beigebracht, wie man Hypothesen richtig testet, aber diese Anweisungen hatten fast keine Wirkung. ⓘ

Verzerrte Interpretation von Informationen

Kluge Menschen glauben seltsame Dinge, weil sie geschickt darin sind, Überzeugungen zu verteidigen, zu denen sie aus nicht-klugen Gründen gekommen sind.

-Michael Shermer ⓘ

Bestätigungsfehler sind nicht auf die Sammlung von Beweisen beschränkt. Selbst wenn zwei Personen über die gleichen Informationen verfügen, kann die Art und Weise, wie sie diese interpretieren, verzerrt sein. ⓘ

Ein Team der Stanford University führte ein Experiment mit Teilnehmern durch, die die Todesstrafe befürworteten, wobei die eine Hälfte dafür und die andere dagegen war. Jeder Teilnehmer las Beschreibungen von zwei Studien: einen Vergleich von US-Bundesstaaten mit und ohne Todesstrafe und einen Vergleich der Mordraten in einem Bundesstaat vor und nach der Einführung der Todesstrafe. Nach dem Lesen einer kurzen Beschreibung jeder Studie wurden die Teilnehmer gefragt, ob sich ihre Meinung geändert habe. Dann lasen sie eine detailliertere Beschreibung des Ablaufs der jeweiligen Studie und mussten bewerten, ob die Untersuchung gut durchgeführt und überzeugend war. In Wirklichkeit waren die Studien fiktiv. Der Hälfte der Teilnehmer wurde gesagt, dass die eine Art von Studie die abschreckende Wirkung unterstützt und die andere sie untergräbt, während bei den anderen Teilnehmern die Schlussfolgerungen vertauscht wurden. ⓘ

Die Teilnehmer, ob Befürworter oder Gegner, berichteten, dass sie ihre Einstellung leicht in Richtung der ersten gelesenen Studie änderten. Sobald sie die detaillierteren Beschreibungen der beiden Studien gelesen hatten, kehrten sie fast alle zu ihrer ursprünglichen Überzeugung zurück, unabhängig von den vorgelegten Beweisen, indem sie auf Details hinwiesen, die ihren Standpunkt unterstützten, und alles, was dagegen sprach, ignorierten. Die Teilnehmer beschrieben Studien, die ihre bereits bestehende Meinung unterstützten, als besser als solche, die ihr widersprachen, und zwar auf detaillierte und spezifische Weise. Zu einer Studie, die den Abschreckungseffekt zu untergraben schien, schrieb ein Befürworter der Todesstrafe: "Die Untersuchungen erstreckten sich nicht über einen ausreichend langen Zeitraum", während der Kommentar eines Gegners zu derselben Studie lautete: "Es wurden keine stichhaltigen Beweise vorgelegt, die den Forschern widersprechen." Die Ergebnisse zeigen, dass die Menschen höhere Anforderungen an die Beweise für Hypothesen stellen, die ihren derzeitigen Erwartungen widersprechen. Dieser als "disconfirmation bias" bezeichnete Effekt wurde durch andere Experimente bestätigt. ⓘ

Eine weitere Studie über voreingenommene Interpretationen fand während der Präsidentschaftswahlen in den USA im Jahr 2004 statt und betraf Teilnehmer, die angaben, starke Gefühle gegenüber den Kandidaten zu haben. Ihnen wurden scheinbar widersprüchliche Aussagenpaare gezeigt, entweder vom republikanischen Kandidaten George W. Bush, vom demokratischen Kandidaten John Kerry oder von einer politisch neutralen öffentlichen Person. Außerdem wurden ihnen weitere Aussagen vorgelegt, die den scheinbaren Widerspruch plausibel erscheinen ließen. Anhand dieser drei Informationen mussten sie entscheiden, ob die Aussagen der einzelnen Personen widersprüchlich waren. Es gab starke Unterschiede in diesen Bewertungen, wobei die Teilnehmer die Aussagen des Kandidaten, den sie ablehnten, viel eher als widersprüchlich interpretierten. ⓘ

In diesem Experiment gaben die Teilnehmer ihre Urteile ab, während sie sich in einem Magnetresonanztomographen (MRT) befanden, der ihre Gehirnaktivität überwachte. Als die Teilnehmer widersprüchliche Aussagen des von ihnen favorisierten Kandidaten bewerteten, wurden die emotionalen Zentren ihres Gehirns erregt. Dies geschah nicht bei den Aussagen der anderen Figuren. Die Experimentatoren schlossen daraus, dass die unterschiedlichen Reaktionen auf die Aussagen nicht auf passive Denkfehler zurückzuführen waren. Vielmehr verringerten die Teilnehmer aktiv die kognitive Dissonanz, die durch die Lektüre des irrationalen oder heuchlerischen Verhaltens des von ihnen favorisierten Kandidaten hervorgerufen wurde. ⓘ

Verzerrungen bei der Interpretation von Überzeugungen halten sich hartnäckig, unabhängig vom Intelligenzniveau. Die Teilnehmer eines Experiments absolvierten den SAT-Test (ein in den Vereinigten Staaten verwendeter College-Zulassungstest), um ihr Intelligenzniveau zu ermitteln. Anschließend lasen sie Informationen über Sicherheitsbedenken bei Fahrzeugen, wobei die Experimentatoren die nationale Herkunft des Fahrzeugs manipulierten. Die amerikanischen Teilnehmer gaben auf einer sechsstufigen Skala ihre Meinung dazu ab, ob das Auto verboten werden sollte, wobei eine Eins für "definitiv ja" und eine Sechs für "definitiv nein" stand. Die Teilnehmer bewerteten zunächst, ob sie ein gefährliches deutsches Auto auf amerikanischen Straßen und ein gefährliches amerikanisches Auto auf deutschen Straßen zulassen würden. Die Teilnehmer waren der Meinung, dass das gefährliche deutsche Auto auf amerikanischen Straßen schneller verboten werden sollte als das gefährliche amerikanische Auto auf deutschen Straßen. Es gab keinen Unterschied zwischen den Intelligenzniveaus, was die Geschwindigkeit betrifft, mit der die Teilnehmer ein Auto verbieten würden. ⓘ

Verzerrte Interpretationen sind nicht auf emotional bedeutsame Themen beschränkt. In einem anderen Experiment wurde den Teilnehmern eine Geschichte über einen Diebstahl erzählt. Sie sollten die Beweiskraft von Aussagen bewerten, die entweder für oder gegen eine bestimmte Figur als Täter sprechen. Wenn sie die Schuld dieser Figur vermuteten, bewerteten sie Aussagen, die diese Hypothese stützten, als wichtiger als gegenteilige Aussagen. ⓘ

Verzerrter Abruf von Informationen

Menschen können sich selektiv an Beweise erinnern, um ihre Erwartungen zu verstärken, selbst wenn sie Beweise auf neutrale Weise sammeln und interpretieren. Dieser Effekt wird als "selektiver Abruf", "bestätigendes Gedächtnis" oder "zugriffsbasiertes Gedächtnis" bezeichnet. Die psychologischen Theorien unterscheiden sich in ihren Vorhersagen zum selektiven Abruf. Die Schematheorie sagt voraus, dass Informationen, die mit früheren Erwartungen übereinstimmen, leichter gespeichert und abgerufen werden als Informationen, die nicht dazu passen. Einige alternative Ansätze besagen, dass überraschende Informationen hervorstechen und daher besser im Gedächtnis haften bleiben. Die Vorhersagen beider Theorien wurden in verschiedenen experimentellen Kontexten bestätigt, wobei sich keine Theorie durchsetzen konnte. ⓘ

In einer Studie lasen die Teilnehmer ein Profil einer Frau, das eine Mischung aus introvertierten und extrovertierten Verhaltensweisen beschrieb. Später sollten sie sich an Beispiele für ihre Introvertiertheit und Extrovertiertheit erinnern. Einer Gruppe wurde gesagt, dass dies dazu diente, die Frau für eine Stelle als Bibliothekarin einzuschätzen, während einer zweiten Gruppe gesagt wurde, dass es um eine Stelle im Immobilienverkauf ging. Es zeigte sich ein signifikanter Unterschied zwischen dem, woran sich diese beiden Gruppen erinnerten, wobei die "Bibliothekar"-Gruppe mehr Beispiele für introvertiertes und die "Verkaufs"-Gruppe mehr für extrovertiertes Verhalten erinnerte. Ein selektiver Gedächtniseffekt wurde auch in Experimenten nachgewiesen, bei denen die Erwünschtheit von Persönlichkeitstypen manipuliert wurde. In einem dieser Experimente wurden einer Gruppe von Teilnehmern Beweise dafür vorgelegt, dass extrovertierte Menschen erfolgreicher sind als introvertierte. Einer anderen Gruppe wurde das Gegenteil gesagt. In einer weiteren, scheinbar nicht damit zusammenhängenden Studie wurden die Teilnehmer gebeten, sich an Ereignisse aus ihrem Leben zu erinnern, bei denen sie entweder introvertiert oder extrovertiert gewesen waren. Jede Gruppe von Teilnehmern gab mehr Erinnerungen an, die sie mit dem wünschenswerteren Persönlichkeitstyp in Verbindung brachten, und erinnerte sich schneller an diese Erinnerungen. ⓘ

Auch Veränderungen des emotionalen Zustands können den Erinnerungsabruf beeinflussen. Die Teilnehmer bewerteten, wie sie sich fühlten, als sie zum ersten Mal erfuhren, dass O. J. Simpson vom Vorwurf des Mordes freigesprochen worden war. Sie beschrieben ihre emotionalen Reaktionen und ihre Zuversicht bezüglich des Urteils eine Woche, zwei Monate und ein Jahr nach dem Prozess. Die Ergebnisse zeigten, dass sich die Einschätzungen der Teilnehmer zu Simpsons Schuld im Laufe der Zeit veränderten. Je mehr sich die Meinung der Teilnehmer über das Urteil geändert hatte, desto weniger stabil waren die Erinnerungen der Teilnehmer an ihre anfänglichen emotionalen Reaktionen. Als sich die Teilnehmer zwei Monate und ein Jahr später an ihre anfänglichen emotionalen Reaktionen erinnerten, stimmten die früheren Einschätzungen weitgehend mit den aktuellen Gefühlsbeurteilungen überein. Menschen zeigen eine beträchtliche Voreingenommenheit, wenn sie ihre Meinung zu kontroversen Themen diskutieren. Die Erinnerung an und die Konstruktion von Erfahrungen werden in Abhängigkeit von den entsprechenden emotionalen Zuständen überarbeitet. ⓘ

Es hat sich gezeigt, dass die Voreingenommenheit die Genauigkeit des Gedächtnisabrufs beeinflusst. In einem Experiment bewerteten Witwen und Witwer die Intensität ihrer erlebten Trauer sechs Monate und fünf Jahre nach dem Tod ihrer Ehegatten. Die Teilnehmer gaben an, sechs Monate nach dem Tod ihres Ehepartners stärker zu trauern als fünf Jahre danach. Als die Teilnehmer jedoch nach fünf Jahren gefragt wurden, wie sie sich sechs Monate nach dem Tod ihres Partners gefühlt hatten, korrelierte die Intensität der Trauer, an die sich die Teilnehmer erinnerten, in hohem Maße mit ihrem aktuellen Trauergrad. Der Einzelne scheint seinen aktuellen emotionalen Zustand zu nutzen, um zu analysieren, wie er sich gefühlt haben muss, als er vergangene Ereignisse erlebte. Emotionale Erinnerungen werden durch aktuelle emotionale Zustände rekonstruiert. ⓘ

Eine Studie zeigte, wie selektives Gedächtnis den Glauben an außersinnliche Wahrnehmung (ESP) aufrechterhalten kann. Gläubigen und Ungläubigen wurden jeweils Beschreibungen von ESP-Experimenten gezeigt. Der einen Hälfte jeder Gruppe wurde gesagt, dass die Versuchsergebnisse die Existenz von ESP bestätigten, der anderen Gruppe wurde gesagt, dass dies nicht der Fall sei. In einem anschließenden Test erinnerten sich die Teilnehmer genau an das Material, mit Ausnahme der Gläubigen, die die nicht unterstützenden Beweise gelesen hatten. Diese Gruppe erinnerte sich an deutlich weniger Informationen, und einige von ihnen hielten die Ergebnisse fälschlicherweise für eine Bestätigung der ESP. ⓘ

Individuelle Unterschiede

Früher glaubte man, dass die Mysidalneigung mit der Intelligenz zusammenhängt; Studien haben jedoch gezeigt, dass die Mysidalneigung eher von der Fähigkeit zum rationalen Denken als vom Intelligenzniveau beeinflusst werden kann. Myside Voreingenommenheit kann dazu führen, dass man nicht in der Lage ist, die andere Seite eines Arguments effektiv und logisch zu bewerten. In Studien wurde festgestellt, dass myside bias ein Mangel an "aktiver Aufgeschlossenheit" ist, d. h. die aktive Suche nach Gründen, warum eine ursprüngliche Idee falsch sein könnte. In empirischen Studien wird Myside Bias in der Regel als die Menge an Beweisen operationalisiert, die zur Unterstützung der eigenen Seite im Vergleich zur Gegenseite verwendet wird. ⓘ

Eine Studie hat individuelle Unterschiede in der Voreingenommenheit festgestellt. In dieser Studie werden individuelle Unterschiede untersucht, die durch Lernen in einem kulturellen Kontext erworben werden und veränderbar sind. Der Forscher fand wichtige individuelle Unterschiede in der Argumentation. Studien haben gezeigt, dass individuelle Unterschiede wie die Fähigkeit zum deduktiven Denken, die Fähigkeit zur Überwindung von Glaubensvorurteilen, das epistemologische Verständnis und die Denkdisposition wichtige Prädiktoren für die Argumentation und die Erzeugung von Argumenten, Gegenargumenten und Widerlegungen sind. ⓘ

Eine Studie von Christopher Wolfe und Anne Britt untersuchte auch, wie die Ansichten der Teilnehmer über die Frage "Was macht ein gutes Argument aus?" eine Quelle der Voreingenommenheit sein kann, die die Art und Weise beeinflusst, wie eine Person ihre eigenen Argumente formuliert. Die Studie untersuchte individuelle Unterschiede im Argumentationsschema und bat die Teilnehmer, Aufsätze zu schreiben. Die Teilnehmer wurden nach dem Zufallsprinzip angewiesen, Aufsätze entweder für oder gegen die von ihnen bevorzugte Seite eines Arguments zu schreiben, und sie erhielten Forschungsanweisungen, die entweder einen ausgewogenen oder einen uneingeschränkten Ansatz verfolgten. Die Anweisungen für eine ausgewogene Recherche wiesen die Teilnehmer an, ein "ausgewogenes" Argument zu verfassen, d. h. ein Argument, das sowohl Pro- als auch Contra-Argumente enthielt; die Anweisungen für eine uneingeschränkte Recherche enthielten keine Hinweise zur Erstellung des Arguments. ⓘ

Insgesamt ergaben die Ergebnisse, dass die Anweisungen zur ausgewogenen Forschung die Häufigkeit der gegensätzlichen Informationen in den Argumenten deutlich erhöhten. Diese Daten zeigen auch, dass die persönliche Überzeugung keine Quelle für eine Voreingenommenheit meinerseits ist, dass jedoch die Teilnehmer, die glauben, dass ein gutes Argument auf Fakten beruht, eher eine Voreingenommenheit meinerseits aufweisen als andere Teilnehmer. Dieser Nachweis stimmt mit den Behauptungen in Barons Artikel überein - dass die Meinungen der Menschen darüber, was gutes Denken ausmacht, Einfluss darauf haben kann, wie Argumente generiert werden. ⓘ

Wer bereits eine feste Meinung zu einem Thema hat, erinnert sich nach einer Diskussion darüber sowohl an die Argumente für die eigene Position als auch an die Argumente für die gegnerische Position. Es gibt keine eindeutigen Hinweise, dass man sich an Informationen, die die eigenen Annahmen bestätigen, besser erinnert als an Informationen, die die eigenen Annahmen widerlegen. ⓘ

Entdeckung

Informelle Beobachtungen

Schon vor der psychologischen Forschung über Bestätigungsvoreingenommenheit wurde dieses Phänomen in der Geschichte beobachtet. Angefangen bei dem griechischen Historiker Thukydides (ca. 460 v. Chr. - ca. 395 v. Chr.), der im Peloponnesischen Krieg über die fehlgeleitete Vernunft schrieb: "... denn es ist eine Gewohnheit der Menschen, das, was sie ersehnen, einer sorglosen Hoffnung anzuvertrauen und das, was ihnen nicht gefällt, mit souveräner Vernunft zu verdrängen". Der italienische Dichter Dante Alighieri (1265-1321) bemerkte dies in der Göttlichen Komödie, in der der heilige Thomas von Aquin Dante bei der Begegnung im Paradies ermahnt: "Die Meinung - voreilig - kann sich oft auf die falsche Seite neigen, und dann bindet die Zuneigung zu der eigenen Meinung den Geist und schränkt ihn ein". Ibn Khaldun stellte in seiner Muqaddimah den gleichen Effekt fest:

Die Unwahrheit befällt natürlich die historischen Informationen. Es gibt verschiedene Gründe, die dies unvermeidlich machen. Einer von ihnen ist die Parteilichkeit für Meinungen und Schulen. ... wenn die Seele mit der Parteinahme für eine bestimmte Meinung oder Sekte infiziert ist, nimmt sie ohne zu zögern die Informationen an, die ihr genehm sind. Vorurteile und Parteilichkeit vernebeln das kritische Vermögen und schließen eine kritische Untersuchung aus. Das Ergebnis ist, dass Unwahrheiten akzeptiert und weitergegeben werden.

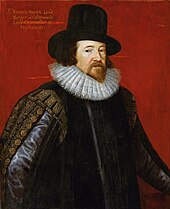

Im Novum Organum stellte der englische Philosoph und Wissenschaftler Francis Bacon (1561-1626) fest, dass die voreingenommene Bewertung von Beweisen die Ursache für "allen Aberglauben ist, sei es in der Astrologie, in Träumen, Omen, göttlichen Urteilen oder dergleichen". Er schrieb:

Der menschliche Verstand, wenn er sich einmal eine Meinung zu eigen gemacht hat ... zieht alle anderen Dinge heran, um sie zu unterstützen und ihr zuzustimmen. Und wenn auch auf der anderen Seite eine größere Zahl und ein größeres Gewicht von Beispielen zu finden ist, so werden diese doch entweder vernachlässigt oder verachtet oder aber durch irgendeine Unterscheidung beiseite geschoben oder verworfen[.]

Im zweiten Band seines Buches Die Welt als Wille und Vorstellung (1844) bemerkte der deutsche Philosoph Arthur Schopenhauer, dass "eine angenommene Hypothese uns Luchsaugen für alles gibt, was sie bestätigt, und uns blind macht für alles, was ihr widerspricht". ⓘ

Der russische Schriftsteller Leo Tolstoi schrieb in seinem Essay "Was ist Kunst?" (1897):

Ich weiß, dass die meisten Menschen - nicht nur die, die man für klug hält, sondern sogar die, die sehr klug sind und die schwierigsten wissenschaftlichen, mathematischen oder philosophischen Probleme verstehen - sehr selten auch nur die einfachste und offensichtlichste Wahrheit erkennen können, wenn sie sie zwingt, die Falschheit von Schlussfolgerungen zuzugeben, die sie, vielleicht unter großen Schwierigkeiten, gebildet haben - Schlussfolgerungen, auf die sie stolz sind, die sie anderen beigebracht haben und auf die sie ihr Leben aufgebaut haben.

In seinem Essay (1894) "Das Reich Gottes ist in dir" hatte der russische Schriftsteller Leo Tolstoi bereits geschrieben:

Die schwierigsten Themen können dem langsamsten Menschen erklärt werden, wenn er sich nicht schon eine Vorstellung davon gemacht hat; aber die einfachste Sache kann dem intelligentesten Menschen nicht klar gemacht werden, wenn er fest davon überzeugt ist, dass er bereits ohne den Schatten eines Zweifels weiß, was ihm vorgelegt wird. ⓘ

Hypothesenüberprüfende (falsifizierende) Erklärung (Wason)

In Peter Wasons ursprünglichem Experiment, das 1960 veröffentlicht wurde (in dem der Begriff "Confirmation Bias" nicht vorkommt), forderte er die Teilnehmer wiederholt auf, eine Regel für Zahlendreier zu finden. Es wurde ihnen gesagt, dass (2,4,6) die Regel erfüllt. Sie bildeten Dreiergruppen, und der Versuchsleiter teilte ihnen mit, ob jede Dreiergruppe der Regel entsprach. ⓘ

Die eigentliche Regel lautete einfach "jede aufsteigende Folge", aber die Teilnehmer hatten große Schwierigkeiten, sie zu finden, und gaben oft Regeln an, die viel spezifischer waren, wie "die mittlere Zahl ist der Durchschnitt der ersten und letzten". Die Teilnehmer schienen nur positive Beispiele zu testen - Dreiergruppen, die ihrer angenommenen Regel gehorchten. Wenn sie zum Beispiel dachten, die Regel laute: "Jede Zahl ist um zwei größer als ihre Vorgängerin", würden sie eher ein Tripel anbieten, das diese Regel erfüllt (bestätigt), wie (11,13,15), als ein Tripel, das sie verletzt (falsifiziert), wie (11,12,19). ⓘ

Wason interpretierte seine Ergebnisse so, dass er die Bestätigung gegenüber der Falsifikation bevorzugte und prägte daher den Begriff "confirmation bias". Wason nutzte den Confirmation Bias auch zur Erklärung der Ergebnisse seines Experiments mit Selektionsaufgaben. Die Teilnehmer schnitten bei verschiedenen Formen dieses Tests wiederholt schlecht ab und ignorierten in den meisten Fällen Informationen, die die angegebene Regel möglicherweise widerlegen (falsifizieren) könnten. ⓘ

Erklärung des Hypothesentests (positive Teststrategie) (Klayman und Ha)

In einem Aufsatz von Klayman und Ha aus dem Jahr 1987 wird argumentiert, dass die Experimente von Wason eigentlich keine Voreingenommenheit in Richtung Bestätigung zeigen, sondern vielmehr eine Tendenz, Tests in Übereinstimmung mit der Arbeitshypothese durchzuführen. Sie nannten dies die "positive Teststrategie". Diese Strategie ist ein Beispiel für eine Heuristik: eine unvollkommene, aber leicht zu berechnende Abkürzung des Denkens. Klayman und Ha verwendeten die Bayes'sche Wahrscheinlichkeits- und Informationstheorie als Maßstab für die Hypothesenprüfung und nicht den von Wason verwendeten Falsifikationismus. Nach diesen Vorstellungen liefert jede Antwort auf eine Frage eine andere Menge an Informationen, die von den vorherigen Überzeugungen der Person abhängen. Daher ist ein wissenschaftlicher Test einer Hypothese derjenige, von dem man erwartet, dass er die meisten Informationen liefert. Da der Informationsgehalt von den anfänglichen Wahrscheinlichkeiten abhängt, kann ein positiver Test entweder sehr informativ oder uninformativ sein. Klayman und Ha argumentierten, dass Menschen, die über realistische Probleme nachdenken, nach einer bestimmten Antwort mit einer geringen Anfangswahrscheinlichkeit suchen. In diesem Fall sind positive Tests in der Regel informativer als negative Tests. Bei der Regelentdeckungsaufgabe von Wason ist die Antwort - drei Zahlen in aufsteigender Reihenfolge - jedoch sehr breit gefächert, so dass positive Tests wahrscheinlich keine informativen Antworten liefern werden. Klayman und Ha stützen ihre Analyse auf ein Experiment, bei dem die Bezeichnungen "DAX" und "MED" anstelle von "entspricht der Regel" und "entspricht nicht der Regel" verwendet wurden. Damit wurde vermieden, dass der Eindruck entsteht, das Ziel sei es, eine Regel mit geringer Wahrscheinlichkeit zu finden. Die Teilnehmer hatten mit dieser Version des Experiments viel mehr Erfolg.

Wenn die Arbeitshypothese (H) die wahre Regel (T) einschließt, sind positive Tests die einzige Möglichkeit, H zu falsifizieren. ⓘ |

Angesichts dieser und anderer Kritikpunkte verlagerte sich der Schwerpunkt der Forschung von der Bestätigung bzw. Falsifizierung einer Hypothese auf die Frage, ob Menschen Hypothesen auf informative oder auf nicht-informative, aber positive Weise testen. Die Suche nach dem "wahren" Confirmation Bias führte die Psychologen dazu, ein breiteres Spektrum von Effekten bei der Informationsverarbeitung zu untersuchen. ⓘ

Joshua Klayman und Young-Won Ha (1987) haben die allgemeine Definition eines Bestätigungsfehlers von der sogenannten positiven Teststrategie (PTS) unterschieden. Sie ist eine allgemeine Strategie zum Testen von Hypothesen. Dabei werden nur Werte oder Ereignisse überprüft, die schon in der Vergangenheit aufgetreten sind oder die erwartet werden. Einige Autoren reduzieren die Beschreibung einer positiven Teststrategie auf die Aussage: „Menschen haben die Tendenz, nur nach Hinweisen zu suchen, die ihre Meinung bestätigen.“ Es hat sich in Forschungen aber gezeigt, dass diese einfache Aussage nicht haltbar ist und eine PTS nur in Ausnahmefällen zu einem Bestätigungsfehler führt. ⓘ

So ist eine positive Teststrategie eine heuristische Methode, um die Menge aller möglichen Untersuchungsparameter auf eine plausible und praktikabel überprüfbare Auswahl zu begrenzen. Deshalb kann sie sehr effektiv und ihre Anwendung rational sein. Zudem ermöglicht die PTS auch die Falsifikation der geprüften Hypothese. Deshalb führt ihre Anwendung auch nicht zu einem systematischen Bestätigungsfehler. Dieser stellt sich nur ein, wenn die nach der PTS gewählten Daten eine Teilmenge der „korrekten“ Daten, die zur „korrekten“ Hypothese gehören, sind. In diesem Fall wird durch PTS immer wieder eine nicht korrekte Hypothese bestätigt. Es hat sich zudem gezeigt, dass Probanden eher dazu neigen, zustimmende Antworten zu geben. Die treffendere Aussage ist demnach: „Menschen neigen dazu, Prüfungsfragen so zu formulieren, dass ihre Annahmen bestätigt werden, falls die Antworten zustimmend sind.“ ⓘ

Erklärungen zur Informationsverarbeitung

Derzeit gibt es drei Haupterklärungen für die Informationsverarbeitung von Bestätigungsvoreingenommenheit sowie eine neuere Erklärung. ⓘ

Kognitiv versus motivational

Nach Robert MacCoun erfolgt die voreingenommene Verarbeitung von Beweisen meist durch eine Kombination aus "kalten" (kognitiven) und "heißen" (motivierten) Mechanismen. ⓘ

Kognitive Erklärungen für Bestätigungsfehler beruhen auf der begrenzten Fähigkeit des Menschen, komplexe Aufgaben zu bewältigen, und auf den von ihm verwendeten Abkürzungen, den so genannten Heuristiken. So können Menschen beispielsweise die Zuverlässigkeit von Beweisen anhand der Verfügbarkeitsheuristik beurteilen, d. h. danach, wie schnell ihnen eine bestimmte Idee in den Sinn kommt. Es ist auch möglich, dass Menschen sich nur auf einen Gedanken zur gleichen Zeit konzentrieren können und es daher schwierig finden, alternative Hypothesen parallel zu prüfen. Eine weitere Heuristik ist die von Klayman und Ha identifizierte positive Teststrategie, bei der Menschen eine Hypothese testen, indem sie Fälle untersuchen, in denen sie das Auftreten einer Eigenschaft oder eines Ereignisses erwarten. Diese Heuristik vermeidet die schwierige oder gar unmögliche Aufgabe, für jede mögliche Frage herauszufinden, wie diagnostisch sie sein wird. Sie ist jedoch nicht durchgängig zuverlässig, so dass Menschen Herausforderungen für ihre bestehenden Überzeugungen übersehen können. ⓘ

Motivationale Erklärungen beinhalten eine Auswirkung des Wunsches auf den Glauben. Es ist bekannt, dass Menschen in vielerlei Hinsicht positive Gedanken gegenüber negativen bevorzugen: Dies wird als "Pollyanna-Prinzip" bezeichnet. Auf Argumente oder Beweisquellen angewandt, könnte dies erklären, warum erwünschte Schlussfolgerungen mit größerer Wahrscheinlichkeit für wahr gehalten werden. Experimenten zufolge, bei denen die Erwünschtheit der Schlussfolgerung manipuliert wird, stellen die Menschen hohe Anforderungen an die Beweise für unangenehme Ideen und niedrige Anforderungen für erwünschte Ideen. Mit anderen Worten, sie fragen: "Kann ich das glauben?" für einige Vorschläge und "Muss ich das glauben?" für andere. Obwohl Konsistenz ein wünschenswertes Merkmal von Einstellungen ist, ist ein übermäßiges Streben nach Konsistenz eine weitere potenzielle Quelle für Voreingenommenheit, weil es Menschen daran hindern kann, neue, überraschende Informationen neutral zu bewerten. Die Sozialpsychologin Ziva Kunda kombiniert die kognitiven und motivationalen Theorien und argumentiert, dass die Motivation die Voreingenommenheit hervorruft, aber kognitive Faktoren das Ausmaß des Effekts bestimmen. ⓘ

Kosten-Nutzen-Verhältnis

Erklärungen im Sinne einer Kosten-Nutzen-Analyse gehen davon aus, dass Menschen Hypothesen nicht einfach nur uneigennützig testen, sondern die Kosten verschiedener Fehler abwägen. Unter Verwendung von Ideen aus der Evolutionspsychologie schlägt James Friedrich vor, dass Menschen beim Testen von Hypothesen nicht in erster Linie die Wahrheit anstreben, sondern versuchen, die teuersten Fehler zu vermeiden. Beispielsweise könnten Arbeitgeber in Vorstellungsgesprächen einseitige Fragen stellen, weil sie darauf bedacht sind, ungeeignete Kandidaten auszusortieren. Die Verfeinerung dieser Theorie durch Yaacov Trope und Akiva Liberman geht davon aus, dass Menschen zwei verschiedene Arten von Fehlern miteinander vergleichen: die Annahme einer falschen Hypothese oder die Ablehnung einer wahren Hypothese. Wer zum Beispiel die Ehrlichkeit eines Freundes unterschätzt, könnte ihm oder ihr gegenüber misstrauisch sein und so die Freundschaft untergraben. Die Ehrlichkeit des Freundes zu überschätzen, kann ebenfalls kostspielig sein, aber weniger kostspielig. In diesem Fall wäre es vernünftig, Beweise für die Ehrlichkeit des Freundes zu suchen, zu bewerten oder sich an sie zu erinnern, und zwar auf eine voreingenommene Weise. Wenn jemand zunächst den Eindruck erweckt, introvertiert oder extrovertiert zu sein, wirken Fragen, die diesem Eindruck entsprechen, einfühlsamer. Dies legt nahe, dass es ein Zeichen besserer sozialer Kompetenz ist, jemanden, der introvertiert zu sein scheint, zu fragen: "Fühlen Sie sich in sozialen Situationen unbehaglich?" und nicht: "Mögen Sie laute Partys?" Der Zusammenhang zwischen Bestätigungsvoreingenommenheit und sozialer Kompetenz wurde durch eine Studie darüber bestätigt, wie Studenten andere Menschen kennen lernen. Hochgradig selbstüberwachende Studenten, die sensibler für ihre Umgebung und soziale Normen sind, stellten beim Gespräch mit einem hochrangigen Mitarbeiter mehr passende Fragen als beim Kennenlernen von Kommilitonen. ⓘ

Explorativ versus bestätigend

Die Psychologen Jennifer Lerner und Philip Tetlock unterscheiden zwei verschiedene Arten von Denkprozessen. Das explorative Denken erwägt neutral mehrere Standpunkte und versucht, alle möglichen Einwände gegen eine bestimmte Position zu antizipieren, während das bestätigende Denken versucht, einen bestimmten Standpunkt zu rechtfertigen. Lerner und Tetlock zufolge neigen Menschen, die erwarten, dass sie ihren Standpunkt gegenüber anderen, deren Ansichten sie bereits kennen, rechtfertigen müssen, dazu, einen ähnlichen Standpunkt wie diese Personen einzunehmen, und verwenden dann bestätigende Gedanken, um ihre eigene Glaubwürdigkeit zu stärken. Wenn die externen Parteien jedoch übermäßig aggressiv oder kritisch sind, ziehen sich die Menschen ganz aus dem Denken zurück und behaupten einfach ihre persönliche Meinung, ohne sie zu rechtfertigen. Lerner und Tetlock sind der Meinung, dass Menschen sich nur dann zu kritischem und logischem Denken zwingen, wenn sie im Voraus wissen, dass sie sich gegenüber anderen erklären müssen, die gut informiert und wirklich an der Wahrheit interessiert sind und deren Ansichten sie noch nicht kennen. Da diese Bedingungen nur selten gegeben sind, argumentieren sie, dass die meisten Menschen die meiste Zeit bestätigendes Denken anwenden. ⓘ

Fantasiewelt

Die Entwicklungspsychologin Eve Whitmore hat argumentiert, dass die Überzeugungen und Voreingenommenheiten, die mit dem Bestätigungsdenken einhergehen, ihre Wurzeln in der Bewältigung von Problemen in der Kindheit durch Vorspiegelung falscher Tatsachen haben, was "die Grundlage für komplexere Formen der Selbsttäuschung und Illusion im Erwachsenenalter" bildet. Die Reibung, die das Hinterfragen als Jugendlicher mit der Entwicklung des kritischen Denkens mit sich bringt, kann zur Rationalisierung falscher Überzeugungen führen, und die Gewohnheit einer solchen Rationalisierung kann im Laufe der Jahre unbewusst werden. ⓘ

Auswirkungen in der realen Welt

Soziale Medien

In den sozialen Medien wird der Confirmation Bias durch die Verwendung von Filterblasen oder "algorithmischer Bearbeitung" verstärkt, die dem Einzelnen nur Informationen anzeigt, denen er wahrscheinlich zustimmt, während gegenteilige Ansichten ausgeschlossen werden. Einige haben argumentiert, dass die Gesellschaft der Filterblase nicht entkommen kann, weil der Einzelne psychologisch so veranlagt ist, dass er nach Informationen sucht, die mit seinen bereits vorhandenen Werten und Überzeugungen übereinstimmen. Andere argumentieren, dass die Mischung aus beidem die Demokratie beeinträchtigt - sie behaupten, dass dieses "algorithmische Editieren" unterschiedliche Standpunkte und Informationen ausblendet - und dass die Wähler nicht in der Lage sein werden, vollständig informierte politische Entscheidungen zu treffen, wenn die Filterblasen-Algorithmen nicht abgeschafft werden. ⓘ

Der Aufstieg der sozialen Medien hat wesentlich zur raschen Verbreitung von Fake News beigetragen, d. h. von falschen und irreführenden Informationen, die als glaubwürdige Nachrichten aus einer scheinbar zuverlässigen Quelle präsentiert werden. Confirmation Bias (die Auswahl oder Umdeutung von Beweisen zur Unterstützung der eigenen Überzeugungen) ist eines der drei Haupthindernisse, die dafür verantwortlich gemacht werden, dass kritisches Denken unter diesen Umständen in die Irre geht. Die anderen beiden sind heuristische Abkürzungen (wenn man überfordert ist oder wenig Zeit hat, verlässt man sich auf einfache Regeln wie den Gruppenkonsens oder das Vertrauen in einen Experten oder ein Vorbild) und soziale Ziele (soziale Motivation oder Gruppenzwang können die objektive Analyse der vorliegenden Fakten beeinträchtigen). ⓘ

Um die Verbreitung von Fake News zu bekämpfen, haben soziale Medienseiten erwogen, sich dem "digitalen Nudging" zuzuwenden. Dies kann derzeit in zwei verschiedenen Formen von Nudging geschehen. Dazu gehören das "Nudging" von Informationen und das "Nudging" von Darstellungen. Beim "Nudging" von Informationen wird auf Social-Media-Websites ein Haftungsausschluss oder eine Kennzeichnung angebracht, die die Gültigkeit der Quelle in Frage stellt oder die Nutzer warnt, während beim "Nudging" der Präsentation die Nutzer neuen Informationen ausgesetzt werden, die sie vielleicht nicht gesucht haben, die ihnen aber Standpunkte vermitteln könnten, die ihre eigenen Bestätigungsvoreingenommenheiten bekämpfen könnten. ⓘ

Wissenschaft und wissenschaftliche Forschung

Ein charakteristisches Merkmal des wissenschaftlichen Denkens ist die Suche nach bestätigenden oder unterstützenden Beweisen (induktives Denken) sowie nach falsifizierenden Beweisen (deduktives Denken). Insbesondere bei der induktiven Forschung kann es zu einem ernsthaften Problem mit Bestätigungsfehlern kommen. ⓘ

In der Geschichte der Wissenschaft haben sich Wissenschaftler immer wieder gegen neue Entdeckungen gewehrt, indem sie ungünstige Daten selektiv interpretierten oder ignorierten. Die Bewertung der Qualität wissenschaftlicher Studien scheint besonders anfällig für Bestätigungsfehler zu sein. Mehrere Studien haben gezeigt, dass Wissenschaftler Studien, deren Ergebnisse mit ihren bisherigen Überzeugungen übereinstimmen, positiver bewerten als Studien, deren Ergebnisse nicht mit ihren bisherigen Überzeugungen übereinstimmen. ⓘ

Unter der Voraussetzung, dass die Forschungsfrage relevant ist, der Versuchsplan angemessen ist und die Daten klar und umfassend beschrieben werden, sollten die gewonnenen empirischen Daten für die wissenschaftliche Gemeinschaft von Bedeutung sein und nicht voreingenommen betrachtet werden, unabhängig davon, ob sie den aktuellen theoretischen Vorhersagen entsprechen. In der Praxis kann es vorkommen, dass Forscher Studien, die ihren Vorurteilen widersprechen, missverstehen, falsch interpretieren oder gar nicht erst lesen, oder sie trotzdem fälschlicherweise so zitieren, als ob sie ihre Behauptungen tatsächlich stützten. ⓘ

Darüber hinaus können Bestätigungsvorurteile wissenschaftliche Theorien oder Forschungsprogramme angesichts unzureichender oder sogar widersprüchlicher Beweise aufrechterhalten. Die Parapsychologie wird oft als Beispiel für die Frage angeführt, ob es sich um eine Protowissenschaft oder eine Pseudowissenschaft handelt. ⓘ

Die Voreingenommenheit eines Experimentators kann sich möglicherweise darauf auswirken, welche Daten berichtet werden. Daten, die den Erwartungen des Experimentators widersprechen, werden eher als unzuverlässig verworfen, was zu dem so genannten Schubladeneffekt führt. Um dieser Tendenz entgegenzuwirken, werden in der wissenschaftlichen Ausbildung Möglichkeiten zur Vermeidung von Verzerrungen vermittelt. So zielt beispielsweise die Versuchsplanung randomisierter kontrollierter Studien (in Verbindung mit ihrer systematischen Überprüfung) darauf ab, Quellen der Verzerrung zu minimieren. ⓘ

Der soziale Prozess der Peer-Review zielt darauf ab, die Auswirkungen der Voreingenommenheit einzelner Wissenschaftler abzuschwächen, auch wenn das Peer-Review-Verfahren selbst für solche Voreingenommenheiten anfällig sein kann Bestätigungsvoreingenommenheit kann daher besonders schädlich für objektive Bewertungen von nicht konformen Ergebnissen sein, da voreingenommene Personen gegenteilige Beweise als prinzipiell schwach ansehen und kaum ernsthaft darüber nachdenken, ihre Überzeugungen zu revidieren. Wissenschaftliche Innovatoren stoßen in der wissenschaftlichen Gemeinschaft oft auf Widerstand, und Forschungsarbeiten mit kontroversen Ergebnissen werden häufig einer strengen Prüfung durch Fachkollegen unterzogen. ⓘ

Finanzen

Confirmation Bias kann dazu führen, dass Anleger zu zuversichtlich sind und Hinweise darauf ignorieren, dass ihre Strategien Geld verlieren werden. In Studien über politische Aktienmärkte erzielten die Anleger mehr Gewinn, wenn sie sich der Voreingenommenheit widersetzten. So profitierten beispielsweise Teilnehmer, die die Leistung eines Kandidaten in einer Debatte neutral und nicht parteiisch interpretierten, mit größerer Wahrscheinlichkeit. Um den Effekt der Voreingenommenheit zu bekämpfen, können Anleger versuchen, "um des Arguments willen" einen konträren Standpunkt einzunehmen. Bei einer Technik stellen sie sich vor, dass ihre Investitionen zusammengebrochen sind, und fragen sich, warum dies geschehen konnte. ⓘ

Medizin und Gesundheit

Kognitive Verzerrungen sind wichtige Variablen bei der klinischen Entscheidungsfindung von Allgemeinmedizinern und Fachärzten. Zwei wichtige davon sind der Bestätigungsfehler und der überlappende Verfügbarkeitsfehler. Ein Allgemeinmediziner kann während einer Untersuchung eine Diagnose zu einem frühen Zeitpunkt stellen und dann eher nach bestätigenden als nach falsifizierenden Beweisen suchen. Dieser kognitive Fehler wird zum Teil durch die Verfügbarkeit von Beweisen für die vermeintliche Störung, die diagnostiziert wird, verursacht. Beispielsweise kann der Patient die Störung erwähnt haben, oder der Hausarzt hat kürzlich eine viel diskutierte Abhandlung über die Störung gelesen. Die Grundlage dieser kognitiven Abkürzung oder Heuristik (die als Verankerung bezeichnet wird) besteht darin, dass der Arzt nicht mehrere Möglichkeiten auf der Grundlage von Beweisen in Betracht zieht, sondern sich vorschnell auf eine einzige Ursache festlegt (oder verankert). In der Notfallmedizin herrscht aufgrund des Zeitdrucks eine hohe Entscheidungsdichte, und es werden häufig Abkürzungen verwendet. Die potenzielle Fehlerquote dieser kognitiven Entscheidungen muss durch Aufklärung über die 30 oder mehr kognitiven Verzerrungen, die auftreten können, in den Griff bekommen werden, um geeignete Entlastungsstrategien zu entwickeln. Bestätigungsfehler können auch dazu führen, dass Ärzte unnötige medizinische Eingriffe vornehmen, weil sie von unnachgiebigen Patienten unter Druck gesetzt werden. ⓘ

Der Psychologe Raymond Nickerson macht den Bestätigungseffekt für die unwirksamen medizinischen Verfahren verantwortlich, die jahrhundertelang vor dem Aufkommen der wissenschaftlichen Medizin angewandt wurden. Wenn ein Patient wieder gesund wurde, werteten die medizinischen Autoritäten die Behandlung als erfolgreich, anstatt nach alternativen Erklärungen zu suchen, etwa dass die Krankheit ihren natürlichen Verlauf genommen hatte. Die voreingenommene Assimilation ist ein Faktor für die moderne Anziehungskraft der alternativen Medizin, deren Befürworter sich von positiven anekdotischen Beweisen leiten lassen, wissenschaftlichen Beweisen aber überkritisch gegenüberstehen. ⓘ

Die kognitive Therapie wurde von Aaron T. Beck in den frühen 1960er Jahren entwickelt und hat sich zu einem beliebten Ansatz entwickelt. Nach Becks Ansicht ist eine verzerrte Informationsverarbeitung ein Faktor bei Depressionen. Sein Ansatz lehrt die Menschen, Beweise unvoreingenommen zu behandeln, anstatt selektiv negative Ansichten zu verstärken. Auch bei Phobien und Hypochondrie hat sich gezeigt, dass die Bestätigung bedrohlicher Informationen eine Rolle spielt. ⓘ

Politik, Recht und Polizeiarbeit

Nickerson argumentiert, dass die Argumentation in juristischen und politischen Kontexten manchmal unbewusst voreingenommen ist und Schlussfolgerungen bevorzugt, auf die sich Richter, Geschworene oder Regierungen bereits festgelegt haben. Da die Beweise in einem Geschworenenprozess komplex sein können und die Geschworenen oft schon früh über das Urteil entscheiden, ist ein Polarisierungseffekt zu erwarten. Die Vorhersage, dass die Geschworenen in ihren Ansichten extremer werden, je mehr Beweise sie sehen, hat sich in Experimenten mit Scheinprozessen bestätigt. Sowohl inquisitorische als auch kontradiktorische Strafrechtssysteme sind von der Bestätigungsverzerrung betroffen. ⓘ

Confirmation Bias kann ein Faktor sein, der Konflikte hervorruft oder ausweitet, von emotional aufgeladenen Debatten bis hin zu Kriegen: Durch die Interpretation der Beweise zu ihren Gunsten kann jede gegnerische Partei zu sehr davon überzeugt sein, dass sie in der stärkeren Position ist. Auf der anderen Seite kann der Bestätigungsfehler dazu führen, dass Menschen die Anzeichen eines bevorstehenden oder beginnenden Konflikts ignorieren oder falsch interpretieren. Die Psychologen Stuart Sutherland und Thomas Kida haben beispielsweise argumentiert, dass der US-Marineadmiral Husband E. Kimmel einen Bestätigungsfehler zeigte, als er die ersten Anzeichen des japanischen Angriffs auf Pearl Harbor herunterspielte. ⓘ

Eine zwei Jahrzehnte dauernde Studie von Philip E. Tetlock über politische Experten ergab, dass ihre Vorhersagen im Großen und Ganzen nicht viel besser als der Zufall waren. Tetlock unterteilte die Experten in "Füchse", die mehrere Hypothesen vertraten, und "Igel", die eher dogmatisch waren. Im Allgemeinen waren die Igel viel weniger genau. Tetlock machte für ihr Scheitern den Bestätigungsfehler verantwortlich, insbesondere ihre Unfähigkeit, neue Informationen, die ihren bestehenden Theorien widersprechen, zu nutzen. ⓘ

Bei polizeilichen Ermittlungen kann es vorkommen, dass ein Ermittler einen Verdächtigen schon früh im Verlauf der Ermittlungen identifiziert, sich dann aber weitgehend auf die Suche nach unterstützenden oder bestätigenden Beweisen begibt und falsifizierende Beweise ignoriert oder herunterspielt. ⓘ

Sozialpsychologie

Sozialpsychologen haben zwei Tendenzen in der Art und Weise festgestellt, wie Menschen Informationen über sich selbst suchen oder interpretieren. Selbstbestätigung ist das Bestreben, das bestehende Selbstbild zu bestätigen, und Selbstverbesserung ist das Bestreben, positives Feedback zu erhalten. Beide werden durch Bestätigungsfehler unterstützt. In Experimenten, in denen Menschen Feedback erhalten, das ihrem Selbstbild widerspricht, achten sie weniger darauf oder erinnern sich weniger daran, als wenn sie selbstbestätigendes Feedback erhalten. Sie reduzieren die Wirkung solcher Informationen, indem sie sie als unzuverlässig interpretieren. In ähnlichen Experimenten wurde festgestellt, dass positive Rückmeldungen und die Personen, die sie geben, gegenüber negativen Rückmeldungen bevorzugt werden. ⓘ

Massenhafte Wahnvorstellungen

Der Bestätigungsfehler kann eine Schlüsselrolle bei der Verbreitung von Massenwahn spielen. Hexenprozesse werden häufig als Beispiel angeführt. ⓘ

Ein anderes Beispiel ist die Windschutzscheibenepidemie in Seattle, bei der es scheinbar eine "Lochfraß-Epidemie" gab, bei der Windschutzscheiben aufgrund einer unbekannten Ursache beschädigt wurden. Als sich die Nachricht von der offensichtlichen Welle von Schäden verbreitete, überprüften immer mehr Menschen ihre Windschutzscheiben und stellten fest, dass auch ihre Windschutzscheiben beschädigt waren, was den Glauben an die angebliche Epidemie bestätigte. Tatsächlich waren die Windschutzscheiben bereits zuvor beschädigt worden, aber der Schaden blieb unbemerkt, bis die Menschen ihre Windschutzscheiben überprüften, als sich der Wahn verbreitete. ⓘ

Paranormaler Glaube

Ein Faktor für die Anziehungskraft von angeblichen Hellsehern ist, dass die Zuhörer die Aussagen des Hellsehers mit ihrem eigenen Leben in Einklang bringen. Indem der Hellseher in jeder Sitzung eine große Anzahl zweideutiger Aussagen macht, gibt er dem Klienten mehr Möglichkeiten, eine Übereinstimmung zu finden. Dies ist eine der Techniken des Cold Reading, mit der ein Hellseher ohne vorherige Informationen über den Klienten eine subjektiv beeindruckende Deutung liefern kann. Der Forscher James Randi verglich die Niederschrift einer Lesung mit dem Bericht des Klienten über das, was das Medium gesagt hatte, und stellte fest, dass der Klient eine starke selektive Erinnerung an die "Treffer" zeigte. ⓘ

Als eindrucksvolle Veranschaulichung des Bestätigungsfehlers in der realen Welt führt Nickerson die numerologische Pyramidologie an: die Praxis, in den Proportionen der ägyptischen Pyramiden eine Bedeutung zu finden. Es gibt viele verschiedene Längenmaße, die z. B. an der Großen Pyramide von Gizeh vorgenommen werden können, und viele Möglichkeiten, sie zu kombinieren oder zu manipulieren. Daher ist es fast unvermeidlich, dass Menschen, die diese Zahlen selektiv betrachten, oberflächlich gesehen beeindruckende Entsprechungen finden, zum Beispiel mit den Abmessungen der Erde. ⓘ

Rekrutierung und Auswahl

Unbewusste kognitive Voreingenommenheit (einschließlich Bestätigungsvoreingenommenheit) bei der Stellenbesetzung wirkt sich auf Einstellungsentscheidungen aus und kann möglicherweise einen vielfältigen und integrativen Arbeitsplatz verhindern. Es gibt eine Vielzahl unbewusster Voreingenommenheiten, die sich auf Einstellungsentscheidungen auswirken, aber die Bestätigungsvoreingenommenheit ist eine der wichtigsten, insbesondere in der Phase des Vorstellungsgesprächs. Der Interviewer wählt oft einen Kandidaten aus, der seine eigenen Überzeugungen bestätigt, auch wenn andere Kandidaten genauso oder besser qualifiziert sind. ⓘ

Damit verbundene Auswirkungen und Ergebnisse

Polarisierung der Meinung

Wenn Menschen mit gegensätzlichen Ansichten neue Informationen auf voreingenommene Weise interpretieren, können sich ihre Ansichten noch weiter voneinander entfernen. Dies wird als "Einstellungspolarisierung" bezeichnet. Der Effekt wurde in einem Experiment nachgewiesen, bei dem eine Reihe von roten und schwarzen Kugeln aus einem von zwei verdeckten "Bingokörben" gezogen wurden. Die Teilnehmer wussten, dass ein Korb 60 Prozent schwarze und 40 Prozent rote Kugeln enthielt, der andere 40 Prozent schwarze und 60 Prozent rote. Die Experimentatoren untersuchten, was passierte, wenn abwechselnd Kugeln mit unterschiedlichen Farben gezogen wurden, eine Reihenfolge, die keinen der beiden Körbe bevorzugt. Nach dem Ziehen jeder Kugel wurden die Teilnehmer der einen Gruppe gebeten, laut ihre Einschätzung der Wahrscheinlichkeit zu äußern, dass die Kugeln aus dem einen oder dem anderen Korb gezogen wurden. Diese Teilnehmer wurden mit jeder weiteren Ziehung zuversichtlicher - egal, ob sie anfangs glaubten, dass der Korb mit 60 Prozent schwarzen Kugeln oder der mit 60 Prozent roten Kugeln die wahrscheinlichere Quelle war, ihre Einschätzung der Wahrscheinlichkeit nahm zu. Eine andere Gruppe von Teilnehmern wurde gebeten, Wahrscheinlichkeitsschätzungen nur am Ende einer Folge von gezogenen Kugeln abzugeben, anstatt nach jeder Kugel. Bei ihnen trat der Polarisierungseffekt nicht auf, was darauf hindeutet, dass er nicht unbedingt auftritt, wenn Menschen einfach nur gegensätzliche Positionen vertreten, sondern eher, wenn sie sich offen dazu bekennen. ⓘ

Eine weniger abstrakte Studie war das Stanford-Bias-Interpretationsexperiment, bei dem Teilnehmer mit starken Meinungen über die Todesstrafe über gemischte experimentelle Beweise lasen. Dreiundzwanzig Prozent der Teilnehmer gaben an, dass ihre Ansichten extremer geworden waren, und diese selbstberichtete Veränderung korrelierte stark mit ihrer ursprünglichen Einstellung. In späteren Experimenten berichteten die Teilnehmer auch, dass ihre Ansichten als Reaktion auf mehrdeutige Informationen extremer geworden waren. Vergleiche ihrer Einstellungen vor und nach den neuen Erkenntnissen zeigten jedoch keine signifikante Veränderung, was darauf schließen lässt, dass die selbstberichteten Veränderungen möglicherweise nicht real sind. Auf der Grundlage dieser Experimente kamen Deanna Kuhn und Joseph Lao zu dem Schluss, dass Polarisierung ein reales Phänomen ist, das jedoch keineswegs unvermeidlich ist und nur in einer kleinen Minderheit der Fälle auftritt. ⓘ

Charles Taber und Milton Lodge argumentierten, dass das Ergebnis des Stanford-Teams schwer zu wiederholen war, weil die in späteren Experimenten verwendeten Argumente zu abstrakt oder verwirrend waren, um eine emotionale Reaktion hervorzurufen. In der Studie von Taber und Lodge wurden die emotional aufgeladenen Themen Waffenkontrolle und positive Maßnahmen verwendet. Sie maßen die Einstellung ihrer Teilnehmer zu diesen Themen, bevor und nachdem sie die Argumente beider Seiten der Debatte gelesen hatten. Zwei Gruppen von Teilnehmern zeigten eine Polarisierung der Einstellungen: diejenigen mit einer starken Vormeinung und diejenigen, die politisch gut informiert waren. In einem Teil dieser Studie wählten die Teilnehmer aus einer von den Experimentatoren vorbereiteten Liste aus, welche Informationsquellen sie lesen wollten. Sie konnten zum Beispiel die Argumente der National Rifle Association und der Brady Anti-Handgun Coalition zur Waffenkontrolle lesen. Selbst wenn die Teilnehmer angewiesen wurden, unvoreingenommen zu sein, lasen sie eher Argumente, die ihre bestehenden Einstellungen unterstützten, als Argumente, die dies nicht taten. Diese voreingenommene Suche nach Informationen korrelierte gut mit dem Polarisierungseffekt. ⓘ

Der Backfire-Effekt beschreibt die Feststellung, dass Menschen, die Beweise gegen ihre Überzeugungen erhalten, diese zurückweisen und ihre Überzeugungen sogar noch verstärken können. Der Begriff wurde von Brendan Nyhan und Jason Reifler im Jahr 2010 geprägt. In späteren Forschungsarbeiten konnten die Ergebnisse, die den Backfire-Effekt belegen, jedoch nicht wiederholt werden. Eine von der Ohio State University und der George Washington University durchgeführte Studie untersuchte 10 100 Teilnehmer mit 52 verschiedenen Themen, von denen erwartet wurde, dass sie einen Backfire-Effekt auslösen. Die Ergebnisse zeigten zwar, dass Menschen Fakten, die ihrer bereits bestehenden Ideologie widersprechen, nur widerwillig aufnehmen, aber es wurden keine Fälle von Backfire-Effekt festgestellt. Seitdem wurde festgestellt, dass der Backfire-Effekt ein seltenes Phänomen ist und nicht häufig auftritt (vgl. Bumerang-Effekt). ⓘ

Persistenz diskreditierter Überzeugungen

Überzeugungen können starken logischen oder empirischen Herausforderungen standhalten. Sie können überleben und sogar durch Beweise gestärkt werden, von denen die meisten unvoreingenommenen Beobachter annehmen würden, dass sie logischerweise eine gewisse Abschwächung dieser Überzeugungen erfordern. Sie können sogar die völlige Zerstörung ihrer ursprünglichen Beweisgrundlagen überstehen.

-Lee Ross und Craig Anderson

Bestätigungsfehler bieten eine plausible Erklärung für das Fortbestehen von Überzeugungen, wenn die ursprünglichen Beweise für sie weggefallen sind oder wenn sie scharf widerlegt wurden. Dieser Effekt der Beharrlichkeit von Überzeugungen wurde erstmals von Festinger, Riecken und Schachter experimentell nachgewiesen. Diese Psychologen verbrachten einige Zeit mit einer Sekte, deren Mitglieder überzeugt waren, dass die Welt am 21. Dezember 1954 untergehen würde. Nachdem die Vorhersage gescheitert war, hielten die meisten Gläubigen immer noch an ihrem Glauben fest. Ihr Buch, das diese Forschung beschreibt, trägt den treffenden Titel When Prophecy Fails. ⓘ

Der Begriff Glaubensausdauer wurde jedoch in einer Reihe von Experimenten geprägt, bei denen das so genannte "Debriefing-Paradigma" angewandt wurde: Die Teilnehmer lesen gefälschte Beweise für eine Hypothese, ihre Einstellungsänderung wird gemessen, dann wird die Fälschung im Detail aufgedeckt. Anschließend wird die Einstellung der Teilnehmer erneut gemessen, um zu sehen, ob ihre Überzeugung auf das vorherige Niveau zurückkehrt. ⓘ

Ein häufiges Ergebnis ist, dass zumindest ein Teil der ursprünglichen Überzeugung auch nach einer vollständigen Nachbesprechung bestehen bleibt. In einem Experiment mussten die Teilnehmer zwischen echten und gefälschten Selbstmordnachrichten unterscheiden. Die Rückmeldungen waren willkürlich: Einigen wurde gesagt, sie hätten sich gut geschlagen, während anderen gesagt wurde, sie hätten sich schlecht geschlagen. Selbst nach der vollständigen Nachbesprechung ließen sich die Teilnehmer noch von der Rückmeldung beeinflussen. Sie hielten sich immer noch für besser oder schlechter als der Durchschnitt bei dieser Art von Aufgabe, je nachdem, was ihnen ursprünglich gesagt worden war. ⓘ

In einer anderen Studie lasen die Teilnehmer die Bewertungen der Arbeitsleistung von zwei Feuerwehrleuten zusammen mit ihren Antworten auf einen Risikoaversionstest. Diese fiktiven Daten wurden so arrangiert, dass sie entweder einen negativen oder einen positiven Zusammenhang aufzeigten: Einigen Teilnehmern wurde gesagt, dass ein risikofreudiger Feuerwehrmann besser abschnitt, während anderen gesagt wurde, dass sie weniger gut abschnitten als ein risikoscheuer Kollege. Selbst wenn diese beiden Fallbeispiele zutreffen würden, wären sie wissenschaftlich gesehen ein schlechter Beweis für eine Schlussfolgerung über Feuerwehrleute im Allgemeinen. Die Teilnehmer fanden sie jedoch subjektiv überzeugend. Als sich herausstellte, dass die Fallstudien fiktiv waren, nahm der Glaube der Teilnehmer an einen Zusammenhang ab, aber etwa die Hälfte des ursprünglichen Effekts blieb erhalten. Nachbefragungen ergaben, dass die Teilnehmer die Nachbesprechung verstanden und ernst genommen hatten. Die Teilnehmer schienen der Nachbesprechung zu vertrauen, betrachteten aber die diskreditierten Informationen als irrelevant für ihre persönliche Überzeugung. ⓘ

Der Effekt der fortgesetzten Beeinflussung ist die Tendenz, dass Fehlinformationen die Erinnerung und das Denken über ein Ereignis weiterhin beeinflussen, obwohl die Fehlinformationen zurückgezogen oder korrigiert wurden. Dies ist selbst dann der Fall, wenn die Person die Korrektur glaubt. ⓘ

Vorliebe für frühe Informationen

Experimente haben gezeigt, dass Informationen stärker gewichtet werden, wenn sie am Anfang einer Reihe stehen, selbst wenn die Reihenfolge unwichtig ist. So machen Menschen beispielsweise einen positiveren Eindruck von jemandem, der als "intelligent, fleißig, impulsiv, kritisch, stur, neidisch" beschrieben wird, als wenn ihnen die gleichen Wörter in umgekehrter Reihenfolge genannt werden. Dieser irrationale Primacy-Effekt ist unabhängig vom Primacy-Effekt im Gedächtnis, bei dem die früheren Elemente einer Reihe eine stärkere Erinnerungsspur hinterlassen. Eine Erklärung für diesen Effekt bietet die voreingenommene Interpretation: Beim Anblick des ersten Hinweises bilden die Menschen eine Arbeitshypothese, die ihre Interpretation der restlichen Informationen beeinflusst. ⓘ

Bei einer Demonstration des irrationalen Vorrangs wurden farbige Chips verwendet, die angeblich aus zwei Urnen gezogen wurden. Den Teilnehmern wurden die Farbverteilungen der Urnen mitgeteilt, und sie mussten die Wahrscheinlichkeit schätzen, dass ein Chip aus einer der beiden Urnen gezogen wurde. In Wirklichkeit erschienen die Farben in einer vorher festgelegten Reihenfolge. Bei den ersten dreißig Ziehungen wurde eine Urne bevorzugt, bei den nächsten dreißig die andere. Die gesamte Serie war neutral, so dass die beiden Urnen rational gesehen gleich wahrscheinlich waren. Nach sechzig Ziehungen bevorzugten die Teilnehmer jedoch die Urne, die von den ersten dreißig Ziehungen vorgeschlagen wurde. ⓘ

In einem anderen Experiment wurde eine Diashow eines einzelnen Objekts gezeigt, das zunächst nur verschwommen zu sehen war und mit jedem weiteren Dia etwas besser fokussiert wurde. Nach jedem Dia mussten die Teilnehmer angeben, was sie am ehesten erraten konnten, um welches Objekt es sich handelte. Teilnehmer, deren erste Vermutungen falsch waren, blieben bei ihren Vermutungen, selbst wenn das Bild so scharf war, dass das Objekt für andere Personen leicht zu erkennen war. ⓘ

Illusorische Assoziation zwischen Ereignissen

Illusorische Korrelation ist die Tendenz, nicht vorhandene Korrelationen in einem Datensatz zu sehen. Diese Tendenz wurde erstmals in einer Reihe von Experimenten in den späten 1960er Jahren nachgewiesen. In einem Experiment lasen die Teilnehmer eine Reihe von psychiatrischen Fallstudien, darunter auch Antworten auf den Rorschach-Tintenklecks-Test. Die Teilnehmer berichteten, dass die homosexuellen Männer in der Reihe eher berichteten, Gesäß, Anus oder sexuell zweideutige Figuren in den Tintenklecksen zu sehen. Tatsächlich waren die fiktiven Fallstudien so konstruiert, dass die homosexuellen Männer diese Bilder nicht häufiger oder - in einer Version des Experiments - seltener meldeten als heterosexuelle Männer. In einer Umfrage meldete eine Gruppe erfahrener Psychoanalytiker die gleiche Reihe von Scheinassoziationen mit Homosexualität. ⓘ

In einer anderen Studie wurden die Symptome von Arthritis-Patienten zusammen mit den Wetterbedingungen über einen Zeitraum von 15 Monaten aufgezeichnet. Nahezu alle Patienten gaben an, dass ihre Schmerzen mit den Wetterbedingungen korrelierten, obwohl die tatsächliche Korrelation gleich Null war. ⓘ

| Tage | Regen | Kein Regen |

|---|---|---|

| Arthritis | 14 | 6 |

| Keine Arthritis | 7 | 2 |

Bei diesem Effekt handelt es sich um eine Art voreingenommene Interpretation, bei der objektiv neutrale oder ungünstige Beweise so interpretiert werden, dass sie bestehende Überzeugungen unterstützen. Er hängt auch mit Verzerrungen im Verhalten bei der Hypothesenüberprüfung zusammen. Bei der Beurteilung, ob zwei Ereignisse, z. B. Krankheit und schlechtes Wetter, miteinander korrelieren, stützen sich die Menschen in hohem Maße auf die Anzahl der positiv-positiven Fälle, d. h. in diesem Beispiel auf die Fälle, in denen sowohl Schmerzen als auch schlechtes Wetter auftraten. Den anderen Arten von Beobachtungen (keine Schmerzen und/oder gutes Wetter) schenken sie relativ wenig Aufmerksamkeit. Dies ist vergleichbar mit der Konzentration auf positive Tests bei Hypothesentests. Möglicherweise spiegelt es auch die selektive Erinnerung wider, da die Menschen ein Gefühl dafür haben, dass zwei Ereignisse korreliert sind, weil es einfacher ist, sich an Zeiten zu erinnern, in denen sie zusammen auftraten. ⓘ