Lagrange-Multiplikator

In der mathematischen Optimierung ist die Methode der Lagrange-Multiplikatoren eine Strategie zum Auffinden der lokalen Maxima und Minima einer Funktion unter Gleichheitsbedingungen (d. h. unter der Bedingung, dass eine oder mehrere Gleichungen durch die gewählten Werte der Variablen genau erfüllt werden müssen). Benannt ist es nach dem Mathematiker Joseph-Louis Lagrange. Die Grundidee besteht darin, ein eingeschränktes Problem in eine Form umzuwandeln, bei der der Ableitungstest eines nicht eingeschränkten Problems weiterhin angewendet werden kann. Die Beziehung zwischen dem Gradienten der Funktion und den Gradienten der Nebenbedingungen führt ganz natürlich zu einer Neuformulierung des ursprünglichen Problems, die als Lagrangesche Funktion bezeichnet wird. ⓘ

Die Methode lässt sich wie folgt zusammenfassen: Um das Maximum oder Minimum einer Funktion zu finden zu finden, die der Gleichheitsbeschränkung zu finden, bilden Sie die Lagrangesche Funktion

und finden Sie die stationären Punkte von als eine Funktion von und dem Lagrange-Multiplikator Dies bedeutet, dass alle partiellen Ableitungen gleich Null sein sollten, einschließlich der partiellen Ableitung in Bezug auf . Die Lösung, die der ursprünglichen eingeschränkten Optimierung entspricht, ist immer ein Sattelpunkt der Lagrangeschen Funktion, der unter den stationären Punkten aufgrund der Definitheit der begrenzten hessischen Matrix identifiziert werden kann. ⓘ

Der große Vorteil dieser Methode besteht darin, dass sie es ermöglicht, die Optimierung ohne explizite Parametrisierung in Bezug auf die Nebenbedingungen zu lösen. Infolgedessen wird die Methode der Lagrange-Multiplikatoren häufig zur Lösung anspruchsvoller Optimierungsprobleme mit Nebenbedingungen eingesetzt. Darüber hinaus wird die Methode der Lagrange-Multiplikatoren durch die Karush-Kuhn-Tucker-Bedingungen verallgemeinert, die auch Ungleichheitsbedingungen der folgenden Form berücksichtigen können für eine gegebene Konstante . ⓘ

Aussage

Der folgende Satz ist als Lagrange-Multiplikator-Theorem bekannt. ⓘ

Sei sei die Zielfunktion, sei die Nebenbedingungsfunktion, beide gehören zu (d.h. mit stetigen ersten Ableitungen). Sei sei eine optimale Lösung des folgenden Optimierungsproblems, so dass (hier die Matrix der partiellen Ableitungen bezeichnet, ):

Dann gibt es einen einzigen Lagrange-Multiplikator derart, dass . ⓘ

Der Satz vom Lagrange-Multiplikator besagt, dass bei jedem lokalen Maximum (oder Minimum) der Funktion, die unter den Gleichheitsbedingungen ausgewertet wird, der Gradient der Funktion (an diesem Punkt) als Linearkombination der Gradienten der Bedingungen (an diesem Punkt) ausgedrückt werden kann, wobei die Lagrange-Multiplikatoren als Koeffizienten fungieren, wenn die Bedingungsqualifikation gilt (siehe unten). Dies ist gleichbedeutend mit der Aussage, dass jede Richtung, die senkrecht zu allen Steigungen der Nebenbedingungen steht, auch senkrecht zur Steigung der Funktion steht. Oder auch, dass die Richtungsableitung der Funktion in jeder machbaren Richtung 0 ist. ⓘ

Einzelne Nebenbedingung

Für den Fall, dass es nur eine Zwangsbedingung und nur zwei Auswahlvariablen gibt (wie in Abbildung 1 dargestellt), betrachten wir das Optimierungsproblem ⓘ

(Manchmal wird eine additive Konstante gesondert dargestellt, anstatt sie in enthalten ist. In diesem Fall wird die Nebenbedingung wie folgt geschrieben geschrieben, wie in Abbildung 1.) Wir nehmen an, dass sowohl und kontinuierliche erste partielle Ableitungen haben. Wir führen eine neue Variable () ein, die als Lagrange-Multiplikator (oder unbestimmter Lagrange-Multiplikator) bezeichnet wird, und untersuchen die Lagrange-Funktion (oder Lagrangesche Funktion oder Lagrangescher Ausdruck), die durch ⓘ

wobei der Term entweder addiert oder subtrahiert werden kann. Wenn ein Maximum von für das ursprüngliche eingeschränkte Problem und ist, dann gibt es derart, dass () ein stationärer Punkt für die Lagrange-Funktion ist (stationäre Punkte sind die Punkte, in denen die ersten partiellen Ableitungen von Null sind). Die Annahme wird Constraint-Qualifikation genannt. Allerdings führen nicht alle stationären Punkte zu einer Lösung des ursprünglichen Problems, da die Methode der Lagrange-Multiplikatoren nur eine notwendige Bedingung für die Optimalität bei Problemen mit Nebenbedingungen liefert. Es gibt auch hinreichende Bedingungen für ein Minimum oder Maximum, aber wenn ein bestimmter Lösungskandidat die hinreichenden Bedingungen erfüllt, ist nur gewährleistet, dass diese Lösung lokal die beste ist, d. h. besser als alle zulässigen Punkte in der Nähe. Das globale Optimum kann durch den Vergleich der Werte der ursprünglichen Zielfunktion an den Punkten gefunden werden, die die notwendigen und lokal ausreichenden Bedingungen erfüllen. ⓘ

Die Methode der Lagrange-Multiplikatoren beruht auf der Intuition, dass f(x, y) bei einem Maximum nicht in Richtung eines solchen Nachbarpunktes ansteigen kann, der ebenfalls g = 0 hat. Wenn dies der Fall wäre, könnte man entlang g = 0 gehen, um höher zu kommen, was bedeutet, dass der Ausgangspunkt nicht wirklich das Maximum war. So gesehen ist es ein exaktes Analogon zur Prüfung, ob die Ableitung einer unbeschränkten Funktion 0 ist, d. h. wir prüfen, ob die Richtungsableitung in jeder relevanten (brauchbaren) Richtung 0 ist. ⓘ

Wir können uns die Konturen von f, gegeben durch f(x, y) = d für verschiedene Werte von d, und die Kontur von g, gegeben durch g(x, y) = c, vorstellen. ⓘ

Angenommen, wir gehen entlang der Konturlinie mit g = c. Wir sind daran interessiert, Punkte zu finden, an denen sich f beim Gehen fast nicht ändert, da diese Punkte Maxima sein könnten. ⓘ

Es gibt zwei Möglichkeiten, wie dies geschehen kann:

- Wir könnten eine Konturlinie von f berühren, da sich f per Definition nicht ändert, wenn wir entlang seiner Konturlinien gehen. Das würde bedeuten, dass die Tangenten an die Umrisslinien von f und g hier parallel sind.

- Wir haben einen "ebenen" Teil von f erreicht, was bedeutet, dass sich f in keiner Richtung ändert. ⓘ

Um die erste Möglichkeit zu prüfen (wir berühren eine Höhenlinie von f), ist zu beachten, dass die Tangenten an die Höhenlinien von f und g nur dann parallel sind, wenn die Steigungen von f und g parallel sind, da die Steigung einer Funktion senkrecht zu den Höhenlinien steht. Gesucht sind also Punkte (x, y), in denen g(x, y) = c und ⓘ

für einige ⓘ

wobei ⓘ

die jeweiligen Steigungen sind. Die Konstante ist erforderlich, weil die beiden Gradientenvektoren zwar parallel sind, aber im Allgemeinen nicht gleich groß sind. Diese Konstante wird als Lagrange-Multiplikator bezeichnet. (In manchen Konventionen wird wird ein Minuszeichen vorangestellt). ⓘ

Beachten Sie, dass diese Methode auch die zweite Möglichkeit, dass f gleich ist, löst: Wenn f gleich ist, dann ist sein Gradient gleich Null, und die Einstellung ist eine Lösung unabhängig von . ⓘ

Um diese Bedingungen in eine Gleichung einzubeziehen, führen wir eine Hilfsfunktion ⓘ

und lösen ⓘ

Man beachte, dass dies auf die Lösung von drei Gleichungen mit drei Unbekannten hinausläuft. Dies ist die Methode der Lagrange-Multiplikatoren. ⓘ

Beachten Sie, dass impliziert als die partielle Ableitung von in Bezug auf ist. ist, die eindeutig Null ist, wenn und nur wenn . ⓘ

Zusammenfassend

Die Methode lässt sich ohne weiteres auf Funktionen nach Variablen ⓘ

was auf die Lösung von n + 1 Gleichungen in n + 1 Unbekannten hinausläuft. ⓘ

Die eingeschränkten Extrema von f sind kritische Punkte der Lagrange , aber sie sind nicht unbedingt lokale Extrema von (siehe Beispiel 2 unten). ⓘ

Man kann die Lagrange als einen Hamiltonian umformulieren, in diesem Fall sind die Lösungen lokale Minima für den Hamiltonian. Dies wird in der Theorie der optimalen Steuerung in Form des Pontryaginschen Minimalprinzips getan. ⓘ

Die Tatsache, dass die Lösungen der Lagrange nicht notwendigerweise Extrema sind, bringt auch Schwierigkeiten für die numerische Optimierung mit sich. Dies kann durch die Berechnung des Betrags des Gradienten gelöst werden, da die Nullstellen des Betrags notwendigerweise lokale Minima sind, wie im Beispiel der numerischen Optimierung dargestellt. ⓘ

Mehrere Nebenbedingungen

Die Methode der Lagrange-Multiplikatoren kann mit einer ähnlichen Argumentation auf die Lösung von Problemen mit mehreren Nebenbedingungen erweitert werden. Betrachten wir ein Paraboloid, das zwei Linienzwängen unterliegt, die sich in einem einzigen Punkt schneiden. Da dieser Punkt die einzige machbare Lösung ist, handelt es sich offensichtlich um ein eingeschränktes Extremum. Allerdings ist die Ebenenmenge von ist jedoch eindeutig nicht parallel zu einer der beiden Nebenbedingungen im Schnittpunkt (siehe Abbildung 3); stattdessen ist sie eine lineare Kombination der Gradienten der beiden Nebenbedingungen. Im Falle mehrerer Nebenbedingungen ist dies das, was wir im Allgemeinen suchen: Die Lagrange-Methode sucht nach Punkten, an denen die Steigung von nicht notwendigerweise ein Vielfaches der Steigung einer einzelnen Nebenbedingung ist, sondern eine Linearkombination der Steigungen aller Nebenbedingungen darstellt. ⓘ

Konkret: Angenommen, wir haben Nebenbedingungen und wandern entlang der Menge der Punkte, die folgende Bedingungen erfüllen . Jeder Punkt auf der Kontur einer gegebenen Nebenbedingungsfunktion hat einen Raum zulässiger Richtungen: den Raum der Vektoren, die senkrecht zu . Die Menge der Richtungen, die für alle Nebenbedingungen zulässig sind, ist somit der Raum der Richtungen, die senkrecht zu allen Gradienten der Nebenbedingungen stehen. Bezeichnen Sie diesen Raum der zulässigen Bewegungen mit und bezeichne die Spanne der Gradienten der Nebenbedingungen mit . Dann der Raum der Vektoren, die senkrecht zu jedem Element von . ⓘ

Wir sind immer noch daran interessiert, Punkte zu finden, bei denen sich beim Gehen nicht ändert, da es sich bei diesen Punkten um (eingeschränkte) Extrema handeln könnte. Wir suchen daher so, dass jede zulässige Bewegungsrichtung weg von senkrecht ist zu (andernfalls könnten wir durch Bewegung entlang dieser zulässigen Richtung). Mit anderen Worten, . Es gibt also Skalare derart, dass ⓘ

Diese Skalare sind die Lagrange-Multiplikatoren. Wir haben nun von ihnen, einen für jede Nebenbedingung. ⓘ

Wie zuvor führen wir eine Hilfsfunktion ⓘ

und lösen ⓘ

die darauf hinausläuft, dass wir die Gleichungen in Unbekannten. ⓘ

Bei mehreren Nebenbedingungen wird angenommen, dass die Gradienten der Nebenbedingungen an dem betreffenden Punkt linear unabhängig sind. ⓘ

Moderne Formulierung über differenzierbare Mannigfaltigkeiten

Das Problem der Suche nach lokalen Maxima und Minima unter Nebenbedingungen kann verallgemeinert werden auf die Suche nach lokalen Maxima und Minima auf einer differenzierbaren Mannigfaltigkeit . Im Folgenden ist es nicht notwendig, dass ein euklidischer Raum oder sogar eine Riemannsche Mannigfaltigkeit sein. Alle Erscheinungen des Gradienten (die von der Wahl der riemannschen Metrik abhängt) kann durch die äußere Ableitung ersetzt werden . ⓘ

Einzelne Nebenbedingung

Sei sei eine glatte Mannigfaltigkeit der Dimension . Angenommen, wir wollen die stationären Punkte finden einer glatten Funktion bei Beschränkung auf die Unterverzweigung definiert durch wobei ist eine glatte Funktion, für die 0 ein regulärer Wert ist. ⓘ

Sei und seien die äußeren Ableitungen. Stationarität für die Einschränkung auf bedeutet Äquivalent dazu enthält der Kernel enthält Mit anderen Worten, und sind proportionale 1-Formen. Dazu ist es notwendig und hinreichend, dass das folgende System von Gleichungen gilt:

wobei bezeichnet das äußere Produkt. Die stationären Punkte sind die Lösungen des obigen Gleichungssystems plus der Nebenbedingung Man beachte, dass die Gleichungen nicht unabhängig sind, da die linke Seite der Gleichung zu der Untermenge von gehört, die aus zersetzbaren Elementen besteht. ⓘ

Bei dieser Formulierung ist es nicht notwendig, den Lagrange-Multiplikator explizit zu bestimmen, eine Zahl derart, dass ⓘ

Mehrere Nebenbedingungen

Sei und zu finden, wie im obigen Abschnitt für den Fall einer einzigen Zwangsbedingung. Anstelle der dort beschriebenen Funktion betrachten wir nun eine glatte Funktion mit Komponentenfunktionen für die ein regulärer Wert ist. Sei sei die Untermannigfaltigkeit von definiert durch ⓘ

ist ein stationärer Punkt von wenn und nur wenn enthält . Der Einfachheit halber sei und wobei die Tangentenkarte oder die Jacobikarte Der Unterraum hat eine kleinere Dimension als die von , nämlich und gehört zu wenn und nur wenn gehört zu dem Bild von Rechnerisch gesehen ist die Bedingung, dass zum Zeilenraum der Matrix von oder äquivalent dazu dem Spaltenraum der Matrix von (die Transponierte). Wenn das äußere Produkt der Spalten der Matrix von bezeichnet, ist die stationäre Bedingung für auf zu ⓘ

Auch bei dieser Formulierung ist es nicht notwendig, die Lagrange-Multiplikatoren explizit zu bestimmen, da die Zahlen derart, dass ⓘ

Interpretation der Lagrange-Multiplikatoren

Oftmals werden die Lagrange-Multiplikatoren als eine interessierende Größe interpretiert. Zum Beispiel durch Parametrisierung der Konturlinie der Zwangsbedingung, das heißt, wenn der Lagrange-Ausdruck ⓘ

dann ⓘ

λk ist also die Änderungsrate der zu optimierenden Größe in Abhängigkeit vom Parameter der Nebenbedingung. In der Lagrangeschen Mechanik werden die Bewegungsgleichungen beispielsweise durch die Suche nach stationären Punkten der Aktion, dem Zeitintegral der Differenz zwischen kinetischer und potentieller Energie, abgeleitet. So kann die Kraft, die auf ein Teilchen aufgrund eines skalaren Potenzials wirkt, F = -∇V, als Lagrange-Multiplikator interpretiert werden, der die Änderung der Wirkung (Übertragung von potenzieller in kinetische Energie) infolge einer Änderung der eingeschränkten Flugbahn des Teilchens bestimmt. In der Steuerungstheorie wird dies stattdessen als Kostengleichungen formuliert. ⓘ

Darüber hinaus lässt sich der optimale Wert eines Lagrange-Multiplikators nach dem Hüllkurvensatz als die marginale Auswirkung der entsprechenden Randbedingungskonstante auf den optimal erreichbaren Wert der ursprünglichen Zielfunktion interpretieren: Wenn wir die Werte am Optimum mit einem Sternchen kennzeichnen, dann lässt sich zeigen, dass ⓘ

In den Wirtschaftswissenschaften wird beispielsweise der optimale Gewinn eines Spielers unter Berücksichtigung eines beschränkten Handlungsraums berechnet, wobei ein Lagrange-Multiplikator die Änderung des optimalen Werts der Zielfunktion (Gewinn) aufgrund der Lockerung einer bestimmten Beschränkung (z. B. durch eine Änderung des Einkommens) ist; in einem solchen Zusammenhang ist λk* die Grenzkosten der Beschränkung und wird als Schattenpreis bezeichnet. ⓘ

Hinreichende Bedingungen

Dieses Verfahren liefert nur eine notwendige Bedingung für Extremstellen. Um die Extremstellen nachzuweisen und ihre Art zu bestimmen, gibt es verschiedene Kriterien. Generell wird die geränderte Hesse-Matrix gebildet und deren Determinante bzw. bestimmte Unterdeterminanten berechnet. Dieser Ansatz führt aber nicht immer zu einer Aussage. Alternativ kann man auch auf eine Visualisierung bzw. geometrische Überlegungen zurückgreifen, um die Art der Extremstelle festzustellen. ⓘ

Hinreichende Bedingungen für ein beschränktes lokales Maximum oder Minimum können in Form einer Folge von Hauptminoren (Determinanten von links oben justierten Teilmatrizen) der begrenzten Hess'schen Matrix der zweiten Ableitungen des Lagrange-Ausdrucks angegeben werden. ⓘ

Beispiele

Beispiel 1

Beispiel 1a

Angenommen, wir wollen maximieren unter Berücksichtigung der Nebenbedingung . Die machbare Menge ist der Einheitskreis, und die Ebenenmengen von f sind diagonale Linien (mit der Steigung -1), so dass wir grafisch sehen können, dass das Maximum bei und das Minimum bei . ⓘ

Bei der Methode der Lagrange-Multiplikatoren ist die Nebenbedingung ⓘ

also die Lagrangesche Funktion, ⓘ

ist eine Funktion, die äquivalent ist zu wenn gesetzt wird zu . ⓘ

Jetzt können wir den Gradienten berechnen:

und daher:

Beachten Sie, dass die letzte Gleichung die ursprüngliche Zwangsbedingung ist. ⓘ

Die ersten beiden Gleichungen ergeben ⓘ

Durch Einsetzen in die letzte Gleichung erhalten wir:

also ⓘ

was bedeutet, dass die stationären Punkte von sind. ⓘ

Die Auswertung der Zielfunktion f an diesen Punkten ergibt ⓘ

Das eingeschränkte Maximum ist also und das eingeschränkte Minimum ist . ⓘ

Beispiel 1b

Nun modifizieren wir die Zielfunktion von Beispiel 1a so, dass wir minimieren anstelle von wieder entlang des Kreises . Nun sind die Ebenenmengen von sind immer noch Geraden mit der Steigung -1, und die Punkte auf dem Kreis, die diese Ebenen tangieren, sind wieder und . Diese Berührungspunkte sind Maxima von . ⓘ

Andererseits treten die Minima auf der Ebenenmenge für = 0 (da aufgrund seiner Konstruktion keine negativen Werte annehmen kann), bei und , wo die Niveaukurven von nicht tangential zur Nebenbedingung sind. Die Bedingung, die identifiziert alle vier Punkte korrekt als Extrema; die Minima sind in gekennzeichnet durch und die Maxima durch . ⓘ

Beispiel 2

In diesem Beispiel geht es um anspruchsvollere Berechnungen, aber es handelt sich immer noch um ein Problem mit einer einzigen Nebenbedingung. ⓘ

Angenommen, man möchte die Maximalwerte von ⓘ

mit der Bedingung, dass die - und -Koordinaten auf einem Kreis um den Ursprung mit dem Radius . Das heißt, es gilt die Bedingung ⓘ

Da es nur eine einzige Nebenbedingung gibt, gibt es auch nur einen einzigen Multiplikator, nämlich . ⓘ

Die Nebenbedingung ist identisch Null auf dem Kreis mit Radius . Jedes Vielfache von kann addiert werden zu wobei in der interessierenden Region (auf dem Kreis, auf dem unsere ursprüngliche Bedingung erfüllt ist) unverändert bleibt. ⓘ

Die Anwendung der gewöhnlichen Lagrange-Multiplikator-Methode ergibt ⓘ

woraus der Gradient berechnet werden kann:

Und deshalb:

(iii) ist nur die ursprüngliche Randbedingung. (i) impliziert oder . Wenn dann durch (iii) und folglich aus (ii). Wenn in (ii) eingesetzt wird, ergibt sich . Setzt man dies in (iii) ein und löst für ergibt . Es gibt also sechs kritische Punkte von :

Bewertet man die Zielfunktion an diesen Punkten, so erhält man ⓘ

Daher erreicht die Zielfunktion das globale Maximum (unter Berücksichtigung der Nebenbedingungen) bei und das globale Minimum bei Der Punkt ist ein lokales Minimum von und ist ein lokales Maximum von wie durch Betrachtung der Hessischen Matrix von . ⓘ

Man beachte, dass, während ein kritischer Punkt von ist, ist es kein lokales Extremum von Wir haben ⓘ

Bei einer beliebigen Nachbarschaft von kann man ein kleines positives und ein kleines mit beliebigem Vorzeichen wählen, um Werte sowohl größer als auch kleiner als . Dies lässt sich auch aus der Hessischen Matrix von die an diesem Punkt (oder an jedem der kritischen Punkte) ausgewertet wird, die eine unbestimmte Matrix ist. Jeder der kritischen Punkte von ist ein Sattelpunkt von . ⓘ

Beispiel 3: Entropie

Angenommen, wir wollen die diskrete Wahrscheinlichkeitsverteilung in den Punkten mit maximaler Informationsentropie finden. Dies ist dasselbe wie die Suche nach der am wenigsten strukturierten Wahrscheinlichkeitsverteilung in den Punkten . Mit anderen Worten, wir wollen die Shannon-Entropie-Gleichung maximieren:

Damit dies eine Wahrscheinlichkeitsverteilung ist, muss die Summe der Wahrscheinlichkeiten an jedem Punkt gleich 1 sein, also lautet unsere Bedingung:

Wir verwenden Lagrange-Multiplikatoren, um den Punkt der maximalen Entropie zu finden, über alle diskreten Wahrscheinlichkeitsverteilungen auf . Wir verlangen, dass:

was ein System von n Gleichungen ergibt, , so dass:

Wenn wir die Differenzierung dieser n Gleichungen durchführen, erhalten wir ⓘ

Dies zeigt, dass alle gleich sind (weil sie nur von λ abhängen). Durch die Anwendung der Nebenbedingung ⓘ

finden wir ⓘ

Die Gleichverteilung ist also die Verteilung mit der größten Entropie unter den Verteilungen auf n Punkten. ⓘ

Beispiel 4: Numerische Optimierung

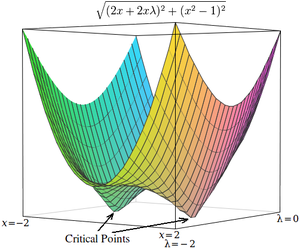

Die kritischen Punkte von Lagrangeschen Multiplikatoren treten an Sattelpunkten auf, nicht an lokalen Maxima (oder Minima). Leider sind viele numerische Optimierungsverfahren wie Hill Climbing, Gradientenabstieg, einige der Quasi-Newton-Methoden und andere darauf ausgelegt, lokale Maxima (oder Minima) und keine Sattelpunkte zu finden. Aus diesem Grund muss man entweder die Formulierung ändern, um sicherzustellen, dass es sich um ein Minimierungsproblem handelt (z. B. durch Extremisierung des Quadrats des Gradienten der Lagrange wie unten), oder eine Optimierungstechnik verwenden, die stationäre Punkte (wie die Newton-Methode ohne extremumssuchende Liniensuche) und nicht unbedingt Extrema findet. ⓘ

Als einfaches Beispiel betrachten wir das Problem, den Wert von x zu finden, der minimiert , mit der Einschränkung, dass . (Dieses Problem ist etwas pathologisch, weil es nur zwei Werte gibt, die diese Bedingung erfüllen, aber es ist zur Veranschaulichung nützlich, weil die entsprechende Funktion ohne Bedingung in drei Dimensionen dargestellt werden kann). ⓘ

Mit Hilfe von Lagrange-Multiplikatoren kann dieses Problem in ein ungebundenes Optimierungsproblem umgewandelt werden:

Die beiden kritischen Punkte liegen in den Sattelpunkten x = 1 und x = -1. ⓘ

Um dieses Problem mit einem numerischen Optimierungsverfahren zu lösen, müssen wir das Problem zunächst so umformen, dass die kritischen Punkte in lokalen Minima auftreten. Dies geschieht durch die Berechnung der Größe des Gradienten des unbeschränkten Optimierungsproblems. ⓘ

Zunächst berechnen wir die partielle Ableitung des uneingeschränkten Problems nach jeder Variablen:

Wenn die Zielfunktion nicht leicht differenzierbar ist, kann die Ableitung nach jeder Variablen näherungsweise wie folgt berechnet werden ⓘ

wobei ein kleiner Wert ist. ⓘ

Als nächstes berechnen wir den Betrag des Gradienten, der die Quadratwurzel aus der Summe der Quadrate der partiellen Ableitungen ist:

(Da der Betrag immer nicht-negativ ist, ist die Optimierung über den quadrierten Betrag gleichbedeutend mit der Optimierung über den Betrag. Die "Quadratwurzel" kann also in diesen Gleichungen weggelassen werden, ohne dass dies einen Unterschied in den Optimierungsergebnissen zur Folge hätte). ⓘ

Die kritischen Punkte von h treten bei x = 1 und x = -1 auf, genau wie in . Anders als die kritischen Punkte in treten die kritischen Punkte in h jedoch bei lokalen Minima auf, so dass numerische Optimierungstechniken zu ihrer Ermittlung eingesetzt werden können. ⓘ

Anwendungen

Steuerungstheorie

In der Theorie der optimalen Steuerung werden die Lagrange-Multiplikatoren als Kostenvariablen interpretiert, und die Lagrange-Multiplikatoren werden im Pontryagin'schen Minimalprinzip als Minimierung des Hamiltonianers umformuliert. ⓘ

Nichtlineare Programmierung

Die Karush-Kuhn-Tucker-Bedingungen und die Fritz-John-Bedingungen sind eine Verallgemeinerung der Lagrange-Multiplikatoren für Nebenbedingungen, die auch durch Ungleichungen beschrieben werden. Beide spielen eine wichtige Rolle in der nichtlinearen Optimierung. Für konvexe Optimierungsprobleme, bei denen die Funktionen nicht stetig differenzierbar sind, gibt es außerdem die Sattelpunktkriterien der Lagrange-Funktion. ⓘ

Die Methode der Lagrange-Multiplikatoren hat mehrere Verallgemeinerungen. In der nichtlinearen Programmierung gibt es mehrere Multiplikatorregeln, z. B. die Carathéodory-John-Multiplikatorregel und die konvexe Multiplikatorregel für Ungleichheitsrestriktionen. ⓘ

Leistungssysteme

Methoden auf der Grundlage von Lagrange-Multiplikatoren finden Anwendung in Stromversorgungssystemen, z. B. bei der Platzierung verteilter Energieressourcen (DER) und beim Lastabwurf. ⓘ

![{\textstyle \left[{\partial g_{j}}/{\partial x_{k}}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2083d0e46b87a22f2f8ae14471c45c28b53e1960)

![{\displaystyle {\begin{aligned}&{\mathcal {L}}(x_{1},x_{2},\ldots ;\lambda _{1},\lambda _{2},\ldots ;c_{1},c_{2},\ldots )\\[4pt]={}&f(x_{1},x_{2},\ldots )+\lambda _{1}(c_{1}-g_{1}(x_{1},x_{2},\ldots ))+\lambda _{2}(c_{2}-g_{2}(x_{1},x_{2},\dots ))+\cdots \end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1867ddf9118c757c322a3d5c0c94965c64a65d0a)

![{\displaystyle {\begin{aligned}{\mathcal {L}}(x,y,\lambda )&=f(x,y)+\lambda \cdot g(x,y)\\[4pt]&=x+y+\lambda (x^{2}+y^{2}-1),\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/124282455d629340fb0209fa998a3508f97eaefd)

![{\displaystyle {\begin{aligned}\nabla _{x,y,\lambda }{\mathcal {L}}(x,y,\lambda )&=\left({\frac {\partial {\mathcal {L}}}{\partial x}},{\frac {\partial {\mathcal {L}}}{\partial y}},{\frac {\partial {\mathcal {L}}}{\partial \lambda }}\right)\\[4pt]&=\left(1+2\lambda x,1+2\lambda y,x^{2}+y^{2}-1\right)\,\color {gray}{,}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/946a1f65c398f3269264a8fc6ce6695b5c557450)

![{\displaystyle {\begin{aligned}&{\frac {\partial {\mathcal {L}}}{\partial x}}=2x+2x\lambda \\[5pt]&{\frac {\partial {\mathcal {L}}}{\partial \lambda }}=x^{2}-1.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/18ffd18cd56c9ffbb13b2d3706b5e3d276e19074)

![{\displaystyle {\begin{aligned}{\frac {\partial {\mathcal {L}}}{\partial x}}\approx {\frac {{\mathcal {L}}(x+\varepsilon ,\lambda )-{\mathcal {L}}(x,\lambda )}{\varepsilon }},\\[5pt]{\frac {\partial {\mathcal {L}}}{\partial \lambda }}\approx {\frac {{\mathcal {L}}(x,\lambda +\varepsilon )-{\mathcal {L}}(x,\lambda )}{\varepsilon }},\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2dfbb40c72ae16d7c71c96218b034acc6c6b8b6f)

![{\displaystyle {\begin{aligned}h(x,\lambda )&={\sqrt {(2x+2x\lambda )^{2}+(x^{2}-1)^{2}}}\\[4pt]&\approx {\sqrt {\left({\frac {{\mathcal {L}}(x+\varepsilon ,\lambda )-{\mathcal {L}}(x,\lambda )}{\varepsilon }}\right)^{2}+\left({\frac {{\mathcal {L}}(x,\lambda +\varepsilon )-{\mathcal {L}}(x,\lambda )}{\varepsilon }}\right)^{2}}}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/731605ce60d5b54247b31df6b0e38e1e8c0a6e8a)